简介:cuDNN v2是一个高性能的深度学习库,专为NVIDIA GPU设计,提供多种神经网络层的实现和优化。它适用于64位Linux系统,通过优化卷积运算、增加对RNNs和CNNs的支持以及改进内存管理,显著提高了深度学习应用的效率。本库还扩展了API,以支持更多的深度学习操作,如批量归一化和Leaky ReLU,并与CUDA 6.5兼容。包含的主要文件为cudnn-6.5-linux-x64-v2.tgz及其相关文档。

1. cuDNN库概述

1.1 cuDNN的定义和作用

cuDNN(CUDA Deep Neural Network library)是由NVIDIA提供的一个用于深度神经网络的加速库,它作为CUDA平台的一部分,为深度学习提供了一组高性能的API。cuDNN通过提供底层算法的高效实现,极大地加速了深度学习工作流。这些底层算法包括反向传播、前向传播、池化、激活等多种核心计算操作。开发人员和研究人员可以利用cuDNN库来加速深度学习框架(例如TensorFlow和PyTorch)中的网络运算,从而实现快速而高效的深度学习应用。

1.2 cuDNN的优势和应用领域

相较于纯软件实现,cuDNN利用GPU的并行计算能力,能够将运算速度提升数倍,显著缩短了训练时间。因此,cuDNN成为了深度学习领域的一项关键技术,被广泛应用于各种应用,如图像和视频识别、自然语言处理和语音识别等。借助cuDNN,研究人员能够更快地训练和部署复杂模型,加快了AI技术的落地进程。

1.3 如何获取和安装cuDNN

cuDNN库可以从NVIDIA官方网站免费下载获取。在安装cuDNN之前,用户必须确保其计算环境已经安装了与之兼容的CUDA Toolkit。下载完成后,通常需要解压缩库文件并将其放置在合适的系统路径中。安装的步骤包括环境变量的配置和运行示例程序以验证安装是否成功。接下来的章节将会详细讨论cuDNN v2版本特性以及如何在Linux平台下安装并使用cuDNN。

2. cuDNN v2版本特性与GPU加速

2.1 cuDNN v2版本的新特性

2.1.1 新增功能概述

cuDNN v2版本作为NVIDIA深度神经网络库(cuDNN)的一个重大更新,引入了若干创新性的功能。首先,cuDNN v2提供了更高效的数据格式转换功能,这使得在不同卷积算法之间转换数据时,能够保持高效的内存利用率和快速的转换速度。其次,深度可分离卷积(Depthwise Separable Convolution)的引入,大幅提升了计算性能,这对于轻量级神经网络架构如MobileNets尤其有用。再者,cuDNN v2还增加了对新版本NVIDIA GPU架构的支持,例如对Volta架构的优化,从而实现了更好的硬件利用率和训练速度。

2.1.2 与前代版本的对比分析

cuDNN v2在架构和性能上与前代版本有着显著的差异。一方面,v2版本在算法上做了重大优化,如上所述的深度可分离卷积的改进,使得使用cuDNN进行深度学习模型训练的速度和效率得到明显提升。另一方面,对于内存管理和错误处理方面也做了改进,加强了库的稳定性。例如,新的内存管理策略能够减少内存碎片化问题,使得在长时间运行大规模模型时更加可靠。而在错误处理方面,v2版本对API错误返回更加详尽的诊断信息,使得开发者更容易定位和解决问题。这些改进让cuDNN v2在易用性、性能和稳定性方面都达到了新的高度。

2.2 GPU加速深度学习的重要性

2.2.1 GPU加速的基本原理

GPU加速深度学习的原理主要是利用GPU(图形处理单元)强大的并行处理能力。传统的CPU由少量的核心组成,每个核心拥有较高的时钟频率和复杂的控制逻辑,适合处理复杂但数量较少的计算任务。相比之下,GPU由成百上千个较小的核心组成,虽然每个核心的时钟频率较低,但它们能够同时处理大量的数据,适合执行高度并行化的计算任务,如深度学习中的矩阵和向量运算。

2.2.2 深度学习中GPU加速的优势

在深度学习领域,神经网络的训练和推理过程涉及到大量的矩阵运算,这些运算天然适合并行处理。使用GPU进行加速可以显著缩短模型的训练时间,这对于机器学习研究者和工程师来说意义重大。更快的训练周期意味着可以更快地进行模型的迭代开发,更快地验证想法,更快地将模型部署到生产环境中。此外,GPU加速还可以处理更大的数据集和更复杂的模型,进一步提升深度学习模型的性能和应用范围。例如,使用GPU加速,研究人员可以在数小时而不是数周内完成一个复杂的神经网络训练,这在数据科学和人工智能领域是一个巨大的进步。

. . . 硬件加速

为了加速GPU计算,专门的硬件设备如GPU加速器被广泛应用于深度学习。GPU加速器可以并行处理成千上万个数据点,大幅度提升了数学运算的速度,特别是对于浮点计算密集型任务。

. . . 并行计算框架

并行计算框架如CUDA(Compute Unified Device Architecture)和OpenCL(Open Computing Language)允许开发者直接在GPU上执行代码。CUDA是NVIDIA专用的并行计算平台和编程模型,而OpenCL是一个开放标准,可以跨多种平台使用。这些框架提供了丰富的API来实现并行计算,并且在深度学习领域中特别受到欢迎。

. . . 高级库的优化

cuDNN作为专门为深度神经网络设计的高性能库,它在底层对CUDA进行了封装和优化,提供了针对深度学习操作的高效实现。它不仅抽象了底层硬件的复杂性,还大大简化了深度学习算法的实现过程。cuDNN的这些优化使得开发者能够快速部署高性能的深度学习模型。

. . . 显存管理

在GPU加速中,显存的管理对于保持高效率至关重要。开发者需要优化数据的传输和存储,减少数据在主内存和显存之间的不必要拷贝,以避免造成显存的瓶颈。cuDNN提供了多种机制来优化显存使用,比如在不同算法之间快速转换数据格式,以及在不增加额外显存开销的情况下实现数据重用。

. . . 性能优化

为了充分利用GPU的并行处理能力,需要对深度学习模型进行特定的优化。这可能包括调整网络结构、减少不必要的计算、并行化算法等。cuDNN提供了这些优化功能,例如提供了多种卷积算法和激活函数的高效实现,通过这些功能,开发者可以充分利用GPU的计算能力来加速他们的深度学习应用。

. . . 易于使用

最后,GPU加速的普及也归功于其易用性。由于有了像cuDNN这样的库,开发者可以不必深入了解底层硬件和并行编程,就可以轻松地将GPU加速集成到他们的深度学习项目中。这大大降低了进入门槛,并促进了深度学习技术的快速发展。

3. Linux平台的cuDNN兼容性分析

随着深度学习框架的普及,cuDNN作为NVIDIA提供的深度神经网络加速库,其在Linux平台上的兼容性变得至关重要。cuDNN不仅仅优化了GPU运算的效率,而且提供了开发者在各种主流Linux发行版上的支持。本章将深入探讨cuDNN在Linux平台的支持情况以及如何正确部署和验证cuDNN库。

3.1 Linux平台对cuDNN的支持

3.1.1 安装cuDNN的系统要求

cuDNN库对系统的要求并不是很高,但仍然有一定的前提条件,以确保其可以在目标系统上高效运行。这些要求包括:

- 支持的GPU架构 :cuDNN库仅支持特定的GPU架构,例如Volta、Turing、Ampere等。这意味着只有配备这些GPU的系统才能利用cuDNN的优势。

- CUDA兼容的驱动 :为了使cuDNN与GPU正常通信,需要安装与CUDA版本兼容的NVIDIA驱动。

- CUDA Toolkit :cuDNN需要与CUDA Toolkit一起使用,这意味着系统必须安装了正确版本的CUDA Toolkit。

3.1.2 Linux发行版兼容性测试

Linux的多样性要求cuDNN必须确保其在主流发行版上的兼容性。这些主流Linux发行版包括但不限于:

- Ubuntu LTS版本(如18.04和20.04)

- Red Hat Enterprise Linux(RHEL)

- CentOS

- Fedora

- Debian

在这些发行版上进行测试,确保cuDNN库能够无缝安装并且正常工作。测试结果通常在NVIDIA的官方文档中有详细记录。

3.2 cuDNN在Linux下的部署流程

3.2.1 下载与安装步骤

cuDNN库并不是独立存在的,它需要与CUDA Toolkit配合使用。因此,安装cuDNN的第一步是安装CUDA Toolkit。在安装CUDA后,可以按照以下步骤安装cuDNN:

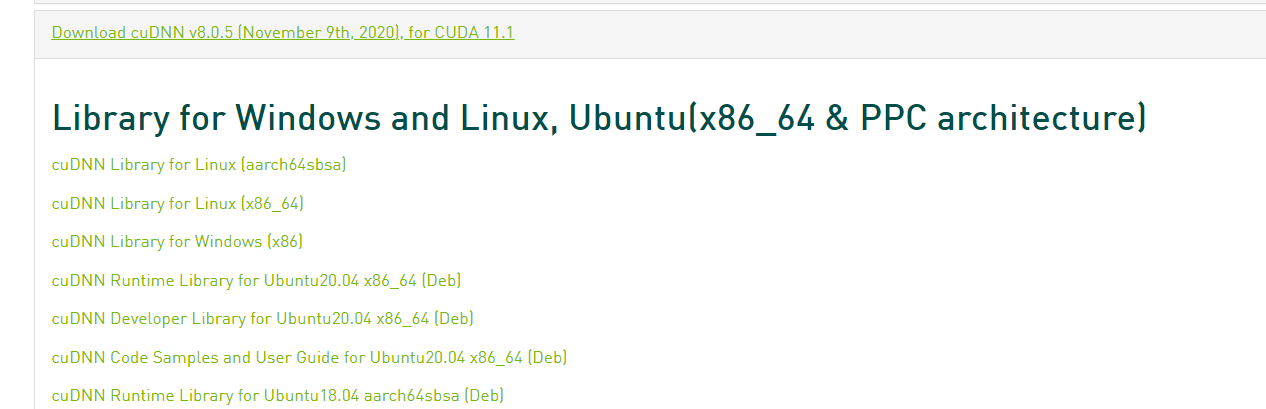

- 登录NVIDIA官方网站 :首先访问NVIDIA官方网站的cuDNN下载页面,注册用户并同意相关的许可协议。

- 选择合适的版本下载 :根据自己的CUDA版本,下载对应的cuDNN版本。NVIDIA会提供不同版本的cuDNN文件供用户选择,包括压缩包(tar)以及运行时、开发和调试包。

- 解压缩文件 :在Linux终端中使用tar命令解压缩下载的cuDNN文件。

bash tar -xzvf cudnn-<version>-linux-x64-v<sub-version>.tgz - 复制文件到CUDA目录 :将解压缩后的文件复制到CUDA的安装目录中。通常文件需要复制到

/usr/local/cuda目录下。bash sudo cp cuda/include/cudnn.h /usr/local/cuda/include sudo cp cuda/lib64/libcudnn* /usr/local/cuda/lib64 sudo chmod a+r /usr/local/cuda/include/cudnn.h /usr/local/cuda/lib64/libcudnn*

3.2.2 验证安装正确性

在安装之后,需要验证cuDNN是否安装成功并且可以被系统识别。这可以通过运行CUDA自带的样例程序或者使用命令行工具进行验证。例如:

cat /usr/local/cuda/include/cudnn.h | grep CUDNN_MAJOR -A 2

这个命令将会在输出中显示cuDNN的主版本号,如果显示正确,说明cuDNN已经正确安装。

graph LR

A[开始安装cuDNN] --> B[登录NVIDIA官网并下载]

B --> C[解压缩文件]

C --> D[复制文件到CUDA目录]

D --> E[验证安装]

E --> |通过验证| F[安装成功]

E --> |未通过验证| G[检查安装步骤]

3.3 Linux下cuDNN环境变量配置

对于某些应用或者深度学习框架,可能需要手动设置环境变量以便正确使用cuDNN。通常需要设置的环境变量包括 LD_LIBRARY_PATH ,它用于指定动态链接器可以查找共享库的路径。可以通过以下命令设置:

export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH

export CUDA_HOME=/usr/local/cuda

设置环境变量后,确保重新登录或者新开一个终端会话,使得更改生效。这时,cuDNN就已经完全集成到系统中,可以被各种深度学习框架所使用了。

4. cuDNN v2的API扩展与优化

cuDNN v2作为深度学习领域的一个重要库,不仅在功能上有所扩展,还在API层面上进行了优化,以便提供更加灵活和高效的深度学习计算支持。接下来的章节将详细介绍cuDNN v2 API的扩展内容和卷积运算优化技术。

4.1 cuDNN v2 API的扩展

4.1.1 新增API功能概览

cuDNN v2引入了若干新API,旨在为用户提供更多的性能选择和更精细的控制。新增功能主要集中在深度学习网络构建、数据格式转换和优化算法选择等方面。例如,cuDNN v2引入了多样的算法用于不同场景下的卷积运算,提供更高效的数据格式转换功能,以及更细致的配置选项来优化计算。

4.1.2 如何在现有项目中使用新API

要在现有的深度学习项目中使用cuDNN v2的新API,首先要确保项目依赖的深度学习框架已经升级到兼容的版本。然后,根据框架提供的指南,更新相关的API调用代码。在很多情况下,框架会为新API提供封装函数,这样可以减少直接使用底层cuDNN API的复杂性。具体步骤包括:

- 检查项目依赖的深度学习框架的版本是否支持cuDNN v2。

- 升级框架至最新版本以确保兼容性。

- 依据框架文档,找到对应cuDNN v2新功能的抽象层API,并替换原有代码。

- 调整项目中的代码结构以适应新API的调用方式。

- 运行测试用例,确保新API能够正确执行并提高性能。

4.2 卷积运算优化技术

4.2.1 卷积运算优化的原理

在深度神经网络中,卷积运算是最为重要的运算之一。卷积运算的优化原理主要围绕减少计算量和存储需求,以及提升计算效率。这通常通过算法优化实现,例如权值共享、稀疏运算和空间复用技术。这些技术能够减少计算量,加速数据流,提高运算效率。cuDNN v2在卷积运算上实施了多种优化算法,它们利用GPU架构的特定优势,达到提升性能的目的。

4.2.2 cuDNN v2中卷积优化的实现

cuDNN v2中,针对卷积运算的优化主要体现在算法选择器的引入。cuDNN提供了一个智能算法选择器,它能够根据网络模型和计算硬件的特性,自动选择最优的卷积实现算法。例如,算法选择器会根据输入数据的大小、维度、步长等因素,选择最适合当前情况的算法。

在代码层面,以下是一个简单的例子,展示了如何使用cuDNN API来执行一个简单的卷积操作:

// 假设所有数据已经预先准备好了

cudnnTensorDescriptor_t inputDesc, outputDesc, biasDesc;

cudnnConvolutionDescriptor_t convDesc;

cudnnConvolutionFwdAlgo_t algo;

// 创建并设置输入和输出的tensor descriptor

cudnnCreateTensorDescriptor(&inputDesc);

cudnnCreateTensorDescriptor(&outputDesc);

cudnnSetTensor4dDescriptor(inputDesc, CUDNN_TENSOR_NCHW, CUDNN_DATA_FLOAT, n, c, h, w);

cudnnSetTensor4dDescriptor(outputDesc, CUDNN_TENSOR_NCHW, CUDNN_DATA_FLOAT, n, c_out, h_out, w_out);

// 创建并设置卷积 descriptor

cudnnCreateConvolutionDescriptor(&convDesc);

cudnnSetConvolution2dDescriptor(convDesc, pad_h, pad_w, stride_h, stride_w, dilation_h, dilation_w, CUDNN_CROSS_CORRELATION, CUDNN_DATA_FLOAT);

// 确定卷积算法

cudnnGetConvolutionForwardAlgorithm(cudnnHandle, inputDesc, filterDesc, convDesc, outputDesc, CUDNN_CONVOLUTION_FWD_PREFER_FASTEST, 0, &algo);

// 执行卷积操作

float alpha = 1.0f, beta = 0.0f;

cudnnConvolutionForward(cudnnHandle, &alpha, inputDesc, input_data, filterDesc, filter_data, convDesc, algo, workspace, workspaceSize, &beta, outputDesc, output_data);

在这个例子中,我们首先创建和设置了输入、输出张量的描述符,然后创建并设置了卷积描述符。接着,我们通过API调用获取了最适合当前数据和硬件的卷积算法。最后,使用该算法执行了卷积操作。需要注意的是,这里的代码片段仅用于示例,实际使用时需要根据具体情况进行适当调整。

通过这样的优化,cuDNN v2不仅能够加速卷积计算,还能提供更好的扩展性和灵活性,以适应不同网络架构和硬件设备的需求。

5. cuDNN v2支持的神经网络架构与内存管理

5.1 支持的多种神经网络架构

神经网络架构的发展自20世纪80年代以来一直遵循着加速创新的趋势。现代深度学习框架支持多种类型的神经网络,包括卷积神经网络(CNN)、循环神经网络(RNN)、长短期记忆网络(LSTM)、生成对抗网络(GAN)等。cuDNN作为一个高性能深度神经网络加速库,其与cuDNN v2的更新保证了其对当前主流架构的支持性。

5.1.1 神经网络架构的发展趋势

随着计算能力的提升和算法研究的深入,神经网络架构变得越来越复杂。从传统的全连接网络到具有特定功能的网络如自动编码器、卷积网络和深度残差网络,再到最近的Transformer模型和BERT,都显示出了对高效计算能力的依赖性。

5.1.2 cuDNN v2对主流架构的支持情况

cuDNN v2库通过提供了一系列的优化操作和算法,能够高效支持各类主流的神经网络架构。例如,为了支持深度残差网络,cuDNN v2提供了分组卷积等操作;而对于Transformer架构,它优化了矩阵乘法相关的操作来提升计算效率。这些优化确保了深度学习模型在GPU上的训练和推理能够达到较高的性能。

5.2 内存管理策略的改进

内存管理在深度学习中是一个关键的组成部分,尤其是在GPU这种高吞吐量的环境中。高效的内存管理能够减少内存碎片,提高内存利用率,并通过减少内存带宽的需求来加速计算过程。

5.2.1 内存管理在深度学习中的作用

在深度学习模型的训练和推理过程中,模型的参数、中间结果和激活函数的输出都需要在内存中存储。合理地管理这些数据能够确保GPU拥有足够的空间来执行并行计算任务,从而提高整体性能。

5.2.2 cuDNN v2内存管理策略的具体改进

cuDNN v2针对内存管理进行了一系列的改进,包括引入了动态内存分配和复用机制,减少不必要的内存拷贝操作。此外,cuDNN v2还提供了更加灵活的内存预分配策略,允许开发者根据具体需求优化内存使用。以下是具体的一些改进措施:

- 内存池化技术 :通过创建内存池,cuDNN v2能够快速地分配和释放内存,这不仅减少了内存分配的开销,也降低了内存碎片的问题。

- 内存优先级控制 :赋予开发者更多的控制权,让他们能够根据操作的优先级决定内存的使用,从而优化内存的使用率。

- 内存访问模式优化 :分析内存访问模式,使得数据在设备内存中被重用,减少了从全局内存到共享内存的拷贝。

cuDNN v2中的改进使得内存管理更贴合实际应用场景,减少了计算过程中的延迟,提高了处理速度。通过精确的内存操作和管理,cuDNN v2使得大型神经网络的训练和推理更加高效。

graph LR

A[开始] --> B[识别神经网络架构]

B --> C[检查当前内存状态]

C --> D[分配/复用内存]

D --> E[执行计算任务]

E --> F[释放不再使用的内存]

F --> G[结束]

在实际使用cuDNN v2时,开发者应根据其应用的具体场景来选择合适的内存管理策略。例如,对于需要大量内存的大型模型,可以考虑使用静态内存分配来避免内存碎片;而对于内存需求较小的任务,则可以灵活使用动态内存管理来获取更好的性能。

以上就是本章节的核心内容。在下一章节中,我们将继续深入探讨cuDNN v2与CUDA版本之间的兼容性问题及其解决方案。

6. cuDNN v2与CUDA版本兼容性深入探讨

6.1 CUDA版本兼容性的重要性

6.1.1 CUDA版本对深度学习的影响

CUDA(Compute Unified Device Architecture)是由NVIDIA推出的一种并行计算平台和编程模型,它使得开发者可以利用NVIDIA的GPU进行通用计算。cuDNN作为CUDA生态系统中的一部分,其版本的更新与CUDA的版本紧密相关。由于cuDNN是专门为深度神经网络计算设计的库,所以CUDA版本的兼容性直接关系到深度学习模型的性能和稳定性。随着CUDA版本的更新,可能引入新的API或者优化算法,这会直接影响到cuDNN的性能表现和特性支持。

6.1.2 兼容性问题带来的挑战

当开发者在进行深度学习开发时,不同版本的cuDNN和CUDA可能会存在不兼容问题,这可能会导致程序崩溃、性能下降,甚至是计算错误。这些问题主要体现在API调用的不一致、功能支持的缺失以及性能优化的差异上。对于在生产环境中部署深度学习应用的企业而言,版本兼容性的问题可能会导致高昂的维护成本和开发时间的延误。

6.2 解决CUDA版本兼容性的策略

6.2.1 如何确保cuDNN与CUDA的兼容

为确保cuDNN与CUDA的兼容性,开发者应当:

- 使用官方支持的组合 :始终使用NVIDIA官方文档中指定的CUDA和cuDNN版本组合,这些组合通常经过严格测试,保证兼容性。

- 定期更新与测试 :定期更新到CUDA和cuDNN的最新版本,并在升级前后进行严格的测试,以确保没有因为版本不兼容而导致的性能损失或功能缺失。

- 利用NVIDIA Container Toolkit :使用NVIDIA提供的Docker容器工具包来隔离开发和运行环境,这样可以确保运行时环境的一致性。

6.2.2 针对不同CUDA版本的优化建议

对于不同的CUDA版本,建议采取以下优化策略:

- CUDA 10.x系列 :在CUDA 10.x系列中,cuDNN 7.6版本及以上提供了对新API的支持和性能优化。确保使用最新的cuDNN版本,并检查是否有针对特定硬件架构的优化。

- CUDA 11.x系列 :CUDA 11.x引入了新的计算能力支持,cuDNN 8.x版本对这些新特性有充分的支持。建议开发者查看官方文档,了解新版本的特性和最佳实践。

- 跨代支持 :如果需要支持跨多个CUDA版本,可以考虑使用条件编译或者动态链接的方式,在运行时根据不同版本加载不同的cuDNN库文件。

通过以上的分析和策略,开发者可以在保证应用稳定运行的同时,充分利用cuDNN的最新特性和性能优化,从而提升深度学习应用的运行效率和开发体验。

简介:cuDNN v2是一个高性能的深度学习库,专为NVIDIA GPU设计,提供多种神经网络层的实现和优化。它适用于64位Linux系统,通过优化卷积运算、增加对RNNs和CNNs的支持以及改进内存管理,显著提高了深度学习应用的效率。本库还扩展了API,以支持更多的深度学习操作,如批量归一化和Leaky ReLU,并与CUDA 6.5兼容。包含的主要文件为cudnn-6.5-linux-x64-v2.tgz及其相关文档。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?