ECCV2020,由Google Research提出。

看标题是基于样本回放的方法。如何在网络变化之后,将旧特征映射到新特征。

类似的方法例如SDC,Semantic Drift Composition。

SDC: SDC论文详解Semantic Drift Compensation for Class-Incremental Learning. CVPR 2020

目录

2.4 feature adaptation network

1.贡献点

模型不存储样本,只存储样本提取出的feature. 本文通过多层感知机实现feature的新适应。

1.1 基于rehearsal方法的分类

基于rehearsal的方法分为如下几类:

- Non-rehearsal: 即不需要rehearsal, 例如LwF直接用新旧网络之间进行知识蒸馏,不需要存储旧样本。

- Exemplars: 直接存储原始图片,例如iCARL(Incremental Classifier and Representation Learning),直接将原始图片存储为exemplars.

- Generated images: 利用GANs生成fake images

- Feature based methods: 基于特征存储的方法,直接利用memory存储网络特征。

1.2 贡献点

- 如何在特征提取网络变化之后,对应的存储的旧特征也应该发生变化,本文用多层感知机模拟这种映射。

- 本文方法存储负担对比同类方法极小

- 性能达到SOTA

2.框架

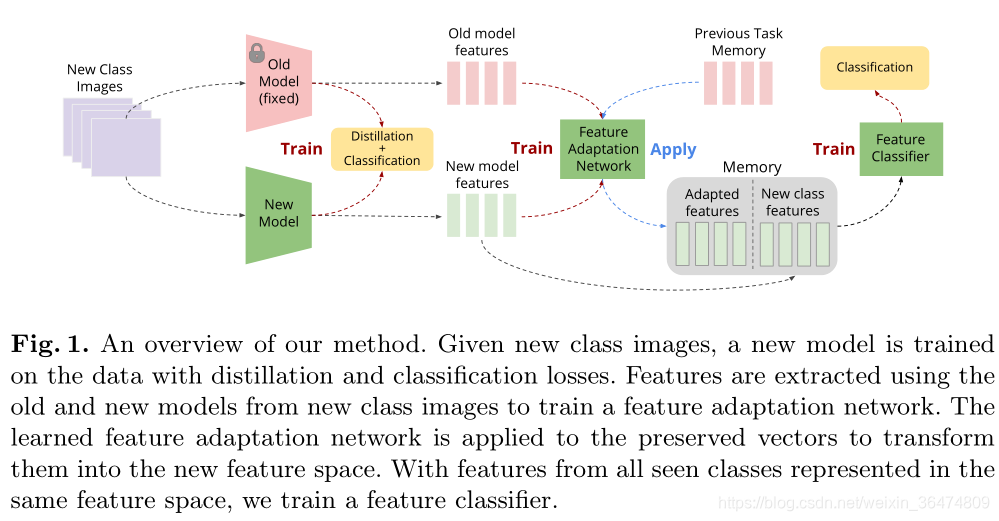

如图所示,模型根据新图片提取出特征,同时需要对旧特征进行适应。因为相应的增量模型发生了变化,旧存储的特征也会发生变化。

2.1 特征提取+分类器

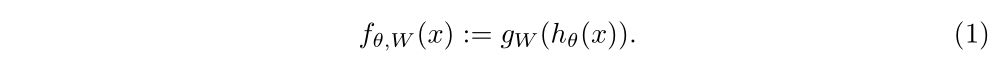

依然是非常常见的,特征提取模块加上分类器模块。假定特征提取模块是hΘ(), 分类器模块是gW(), 非常常见的结构就是:

对应的loss,比如交叉熵Loss:

这个模型结构太常见了,特征提取模块加上分类器

本文探讨了一种新的基于样本回放的增量学习方法,主要关注在网络架构变化后如何将旧特征映射到新特征。通过引入特征适应网络,模型能够在不存储原始样本的情况下,仅存储特征并进行适应,降低了存储负担。实验表明,这种方法在保持高准确率的同时,相比于其他基于rehearsal的方法,如iCARL和SDC,具有更高的存储效率。特征适应网络通过多层感知机模拟特征映射,结合蒸馏损失和分类损失,实现了旧知识的保留。尽管存在额外的训练开销,但性能优于同类方法。

本文探讨了一种新的基于样本回放的增量学习方法,主要关注在网络架构变化后如何将旧特征映射到新特征。通过引入特征适应网络,模型能够在不存储原始样本的情况下,仅存储特征并进行适应,降低了存储负担。实验表明,这种方法在保持高准确率的同时,相比于其他基于rehearsal的方法,如iCARL和SDC,具有更高的存储效率。特征适应网络通过多层感知机模拟特征映射,结合蒸馏损失和分类损失,实现了旧知识的保留。尽管存在额外的训练开销,但性能优于同类方法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?