今天来聊聊Meta最新发布的Llama 3.1系列模型中的新功能 —— 工具调用能力。这个功能不仅仅是Llama3.1独有,最近发布的Mistral NeMo和Mistral Lager2也都已经支持了工具调用能力。我觉得其本质还是为了减少LLM的”幻觉“现象。

一、Llama3.1工具调用

简单来说,工具调用允许大语言模型(LLM)在对话过程中直接使用预定义的工具,就像我们使用各种App一样。这大大扩展了AI的能力范围,使它能够更好地解决实际问题。

- Llama 3.1内置了三种特定工具:Brave Search、Wolfram Alpha和Code Interpreter。

- 这些工具直接集成在模型中,很重要一点,搜索引擎的API还是需要的。

- 工具调用是模型训练的一部分,模型知道如何和何时使用这些工具。

二、Llama 3.1的内置工具

Llama 3.1内置了三种强大的工具:

- Brave Search: 用于网络搜索,让AI能获取最新信息,这里指的网络搜索并不是直接在网上搜索信息,而是需要通过搜索引擎的API接口才能进行网络搜索。

- Wolfram Alpha: 用于复杂数学计算,提升AI的数学能力。

- Code Interpreter: 允许AI直接输出和执行Python代码。

这些工具使Llama 3.1能够执行从信息查询到数学计算,再到编程任务的广泛操作。

三、Llama 3.1的工具调用的工作原理

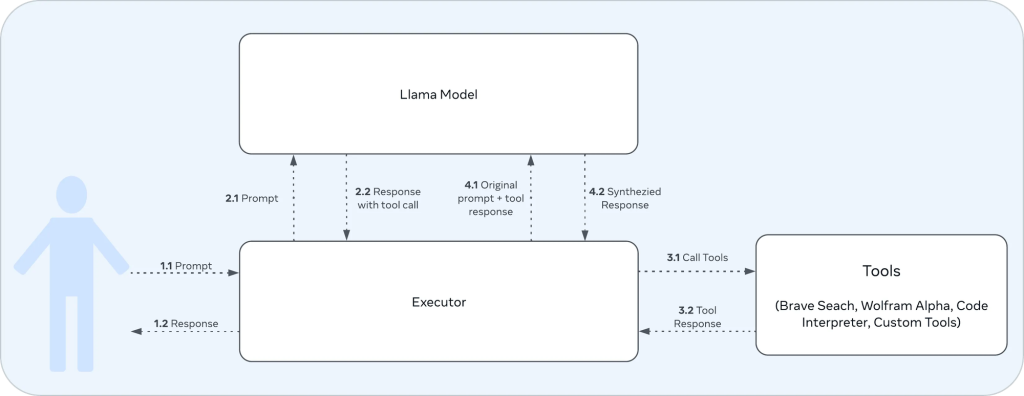

工具调用的工作流程大致如下:

1. 用户交互:

- 1.1: 用户向执行器(Executor)发送提示(Prompt)。

- 1.2: 执行器最终将响应(Response)返回给用户。

2. 执行器与Llama模型的交互:

- 2.1: 执行器将用户的提示传递给Llama模型。

- 2.2: Llama模型生成包含工具调用的响应。

3. 执行器与工具的交互:

- 3.1: 执行器根据Llama模型的响应调用相应的工具。

- 3.2: 工具执行后返回结果给执行器。

7. 执行器再次与Llama模型交互:

- 4.1: 执行器将原始提示和工具调用结果一起发送给Llama模型。

- 4.2: Llama模型生成最终的综合响应。

这张图就是一个完整的工具调用循环,从用户输入到最终输出,包括了Llama3.1模型的决策过程、工具的调用,以及如何将工具的结果整合到最终响应中。这种设计允许Llama3.1模型利用其内置的工具来增强能力,能够快速、精准地回答用户的问题,减少”幻觉“现象。

举一个例子:

我们先拟人化三个角色,你(用户),你的天才朋友(Llama3.1),你的小助手(Executor)

所以,通过这种方式,大语言模型给到用户得回答即高效又精准。

四、参数说明

我们结合Meta的官方文档(建议刚开始玩llama系列模型的小伙伴还是先去看一下原文档),提取一些比较重要的内容和参数拎出来讲一讲。

这次的提示词格式有所变动,尤其是角色方面分别是:

- system :设置与 AI 模型交互的上下文。它通常包括帮助模型有效响应的规则、准则或必要信息。

- user : 表示与模型交互的人类。它包括模型的输入、命令和问题。

- ipython : Llama 3.1 中引入的新角色。从语义上讲,这个角色的意思是“工具”。此角色用于在从执行器发送回模型时,使用工具调用的输出标记消息。

- assistant : 表示 AI 模型根据 ‘system’、’ipython’ 和 ‘user’ 提示中提供的上下文生成的响应。

Python示例如下:

Environment 这里的环境定义为:

- ipython:我理解就是代码解释器

Tools 这里的工具定义为:

- brave_search:网络搜索

- wolfram_alpha:数学计算器

示例说明

我们用下面这段脚本来试试最新的Llama3.1的网络搜索能力,以下是一些前置条件:

- 安装Python语言

- Ollama框架已安装;

- Llama3.1系列模型已下载;

- Python的requests库已安装;

- 搜索引擎的API已开通;

以下示例在Windows环境下运行:

1. 导入必要的库:

- json: 用于处理JSON数据

- requests: 用于发送HTTP请求

- re: 用于正则表达式操作

2. Bing API 设置:这里不一定要使用bing,各大搜索引擎都可以,只要是开放API的

这里设置了Bing搜索API的密钥和接口地址。

3. call_ollama 函数:

这个函数用于调用Llama 3.1模型。它向本地运行的Ollama服务发送请求,获取AI的回应。

4. brave_search 函数:

这个函数实际上使用Bing API进行搜索。它发送搜索请求并处理结果,返回前三个搜索结果的摘要。

5. process_model_output 函数:

这个函数用正则表达式从AI的回应中提取搜索查询,它能处理不同格式的函数调用,经过验证效果并不好,同时我也没太多时间在这里做优化,有兴趣的小伙伴可以尝试不同函数。

6. main 函数:

7. 系统提示:

这里的system_prompt还是蛮重要的,在使用8B尺寸的模型时尽量简单些,70B以上可以复杂一些。

8. 主循环:

- 接受用户输入

- 调用AI获取回应

- 如果AI要搜索,就执行搜索

- 将搜索结果给AI,获取最终回答

9. 脚本入口:

使用示例

1. 首先,我们得创建一个空的文件夹(随便命名),在该文件夹内创建一个空的文件,把以上这段示例代码复制到一个空的文件里,txt文件也是可以的,但是文件保存要把文件格式改成*.py;

2. 接着,我们在该文件夹下“右击”再“点击”在终端中打开;

3. 在保证前置条件都已安装完成的情况下,输入

这条命令开始执行该脚本;

4. 输入问题,比如:请总结下kunpuai.com这个网站;

5. 这是Llama3.1 8B总结的效果,由于在brave_search 变量里设置了3,所以会有3条结果。

好了,以上便是这次网络搜索工具的示例,8b的模型推理非常流畅,但是推理结果却显得很一般,可以尝试更大尺寸的模型。

文章最后

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?