左侧:具有恒定正、零和负黎曲率的空间形式(球面、平面和双曲面)及其相应的图形类比(团、网格和树),以及相应的离散Forman曲率。中间:乘积流形(圆柱体可以看作是圆和直线的乘积)。右侧:具有变化曲率的异质流形及其图形类比。

位置编码可以被视为域的一部分

将图形视为连续流形的离散化,可以将节点的位置编码和特征坐标视为同一空间的不同维度。在这种情况下,图形可以用来表示由此嵌入引起的黎曼度量的离散类比,而与嵌入相关的谐振能量是黎曼度量的非欧几里德扩展,也被称为弦理论中(string theory)的Polyakov泛函。该能量的梯度流是一种扩散型方程,它同时演化位置编码和特征坐标。基于节点位置构建图形是一种特定任务的图形重连形式,它在扩散的迭代(层)中也会发生变化。

领域的演化取代了图的重连

扩散方程也可以应用于图的连接性,作为预处理步骤旨在改善信息传递并避免过度挤压。Klicpera等人提出了一种基于个性化页面排名(Personalised Page Rank)的算法,即图扩散嵌入的一种形式。在我们的研究中,我们分析了这个过程,指出在异质环境中它的问题行为,并提出了一种受黎曼流启发的替代图重连方案。这种重连过程通过减少负曲率边缘的影响来减少导致图瓶颈的效应。黎曼流是用于流形的几何演化方程,粗略地类似于应用于黎曼度量的扩散方程,并且是微分几何中流行的且强大的技术,其中包括对庞加莱猜想的著名证明。更一般地,可以考虑一个耦合的演化过程系统,而不是将图重连作为预处理步骤,其中一个过程演化特征,另一个过程演化领域(图)。

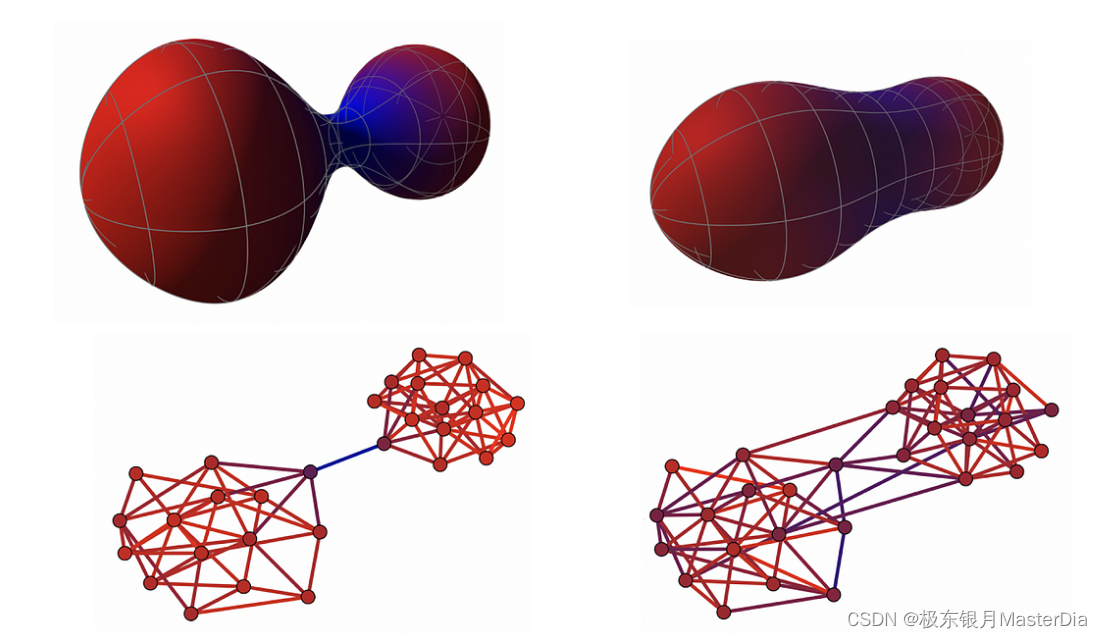

顶部:一个呈哑铃形状的黎曼流形,具有一个带有负曲率的瓶颈(由冷色编码的负曲率),在基于曲率的度量演化中变得“更加圆润”和少了“瓶颈”。底部:类似的基于曲率的图重连过程,减少了瓶颈,使得图对于信息传递更友好。

总结

很高兴你可以看到这里。

这真的是新的吗?我们必须避免的陷阱之一是仅仅在名义上基于花哨的数学形式主义构建新模型,而底层模型仍然基本上与之前一代的GNNs相同。例如,人们可以认为在(C. Bodnar, F. Di Giovanni, et al., Neural Sheaf Diffusion: A Topological Perspective on Heterophily and Oversmoothing in GNNs (2022))中研究的sheaf diffusion是消息传递的特例。通过使用微分几何和代数拓扑学等工具得出的有深刻洞察力的理论结果使我相信这已经不太可能。然而,新的理论框架能够带我们走多远,以及它能否解决目前领域中尚未回答的问题,仍然是一个未解之谜。

这些方法是否会在实践中真正被使用?

对于从业者来说,一个关键问题是这些方法是否会导致新的更好的架构,或者它们是否会保持理论装置的状态,与实际应用脱节,仅仅用于证明定理。我相信这个领域将会是务实的,通过使用拓扑学和几何学工具获得的理论洞察将有助于为现有的GNN架构做出更好的选择,例如如何限制消息传递函数以及何时使用特定的选择。这将使得这些方法能够更加贴近实际应用,并产生实际的影响。

我们是否已经超越了消息传递?

最后,一个略带语义性质的问题是,描述的方法是否仍然可以被标为“消息传递”。观点可能各有不同,有些人将每种形式的GNN都视为消息传递,而有些人则宣称需要超越这种范式,我对使用这个术语有些犹豫。广义上讲,任何数字计算机上的计算都是一种消息传递的形式。然而,在GNN的严格意义上,消息传递是一种通过从一个节点向另一个节点发送信息来实现的计算概念,这是一种固有的离散过程。另一方面,所描述的物理模型以连续的方式在节点之间共享信息(例如,在图耦合振荡器系统中,一个节点的动态性质在任何时间点都取决于其邻居的动态性质)。当描述这种系统的微分方程被离散化并通过数值方法求解时,相应的迭代方案确实是通过消息传递实现的。

然而,人们可以假设使用实际的物理系统或其他计算范例,如模拟电子学或光子学。从数学上讲,底层微分方程的解有时可以以封闭形式给出:例如,各向同性扩散方程的解是与高斯核进行卷积。在这种情况下,“邻居”的影响被吸收在核函数的结构中,实际上没有发生真正的“消息传递”。因此,这种模型的连续性质需要一个更合适的术语,例如,“空间耦合”或“信息传播”,在目前还没有更好的想法的情况下使用。作为一种计算原语,消息传递在与这里介绍的其他角度协同应用时是有用的,并且可能会继续保持其实用性。

通过真实物理系统进行反向传播的深度学习。

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?