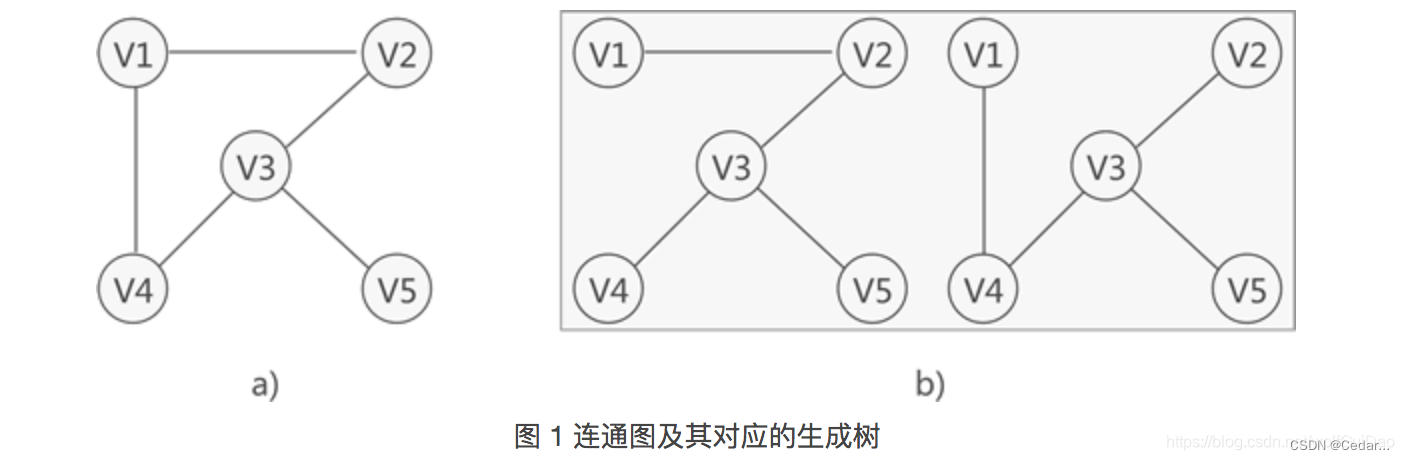

一、连通图&连通分量

- 在无向图G中,若任意两个不同的顶点和都连通(即有路径),则称G为连通图。

-

任何连通图的连通分量都只有一个,即使是其本身,那么非连通的无向图有多个连通分量。例如下面两张图,其中(a)属于一个连通图,其只有一个连通分量,就是这个连通图本身;(b)属于非连通的无向图,即有两个连通分量。

二、什么是过度光滑问题?

在图神经网络的训练过程中,随着网络层数的增加和迭代次数的增加,每个节点的隐层表征会趋向于收敛到同一个值(即相似的特征)。

不是每个节点的表征都趋向于收敛到同一个值,更准确的说,是同一连通分量内的节点的表征会趋向于收敛到同一个值。这对表征图中不通簇的特征、表征图的特征都有好处。但是,有很多任务的图是连通图,只有一个连通分量,或较少的连通分量,这就导致了节点的表征会趋向于收敛到一个值或几个值的问题。

所以over-smooth的现象就是多次卷积后,同一连通分量内所有节点的特征都趋于一致了。

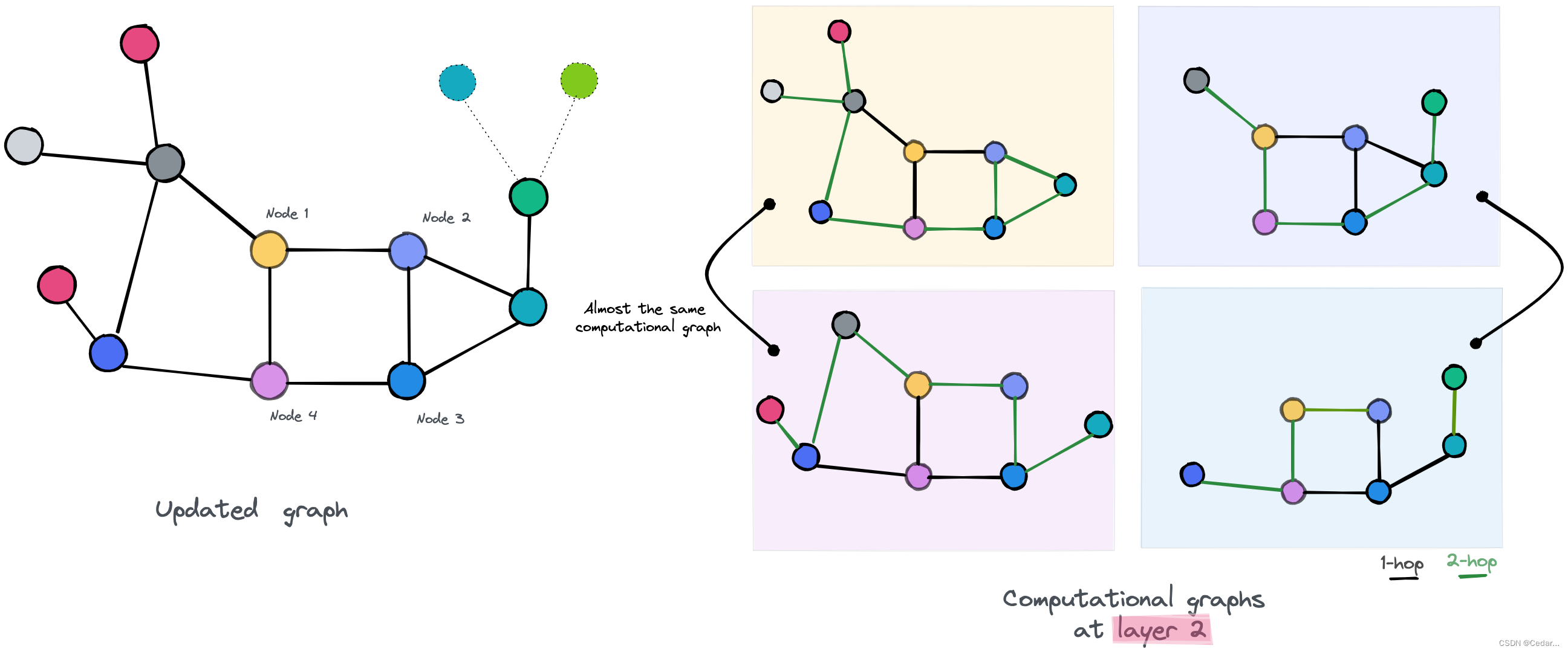

如下图所示:节点可以访问单跳邻居,可以观察到:

(1)节点2和节点3几乎可以访问相同的信息,因为它们相互链接并具有共同的邻居,唯一的区别是它们的最后一个邻居(紫色和黄色),因此可以预测它们的嵌入会略有相似。

(2)节点1和节点4,它们彼此交互但具有不同的邻居,因此可以预测它们的新嵌入会有所不同。

我们通过为每个节点分配新的嵌入来更新我们的图,然后移动到第二层并执行相同的过程。如下图所示:节点 1,4 和 2,3 的计算图分别几乎相同,因此猜测这些节点更新的新嵌入将更加相似。即使对于以第一层的方式“幸存”的节点 1 和节点 4 现在也将具有相似的嵌入,因为额外的层使他们可以访问更多图的部分,增加了访问相同节点的可能性。

这个简化的例子展示了过度平滑是 GNN 深度上的拓展所导致的问题,即随着GNN网络层次的加深,过平滑问题越来越明显。(以上只是一个简单的例子,与真实案例可能有所差别)

三、什么是过度挤压问题?

GNN和传统的CNN之间有一个重要且略微微妙的区别,那就是图既是输入的一部分,也是计算结构的一部分。传统的GNN使用输入图(Graph)来传播信息。然而,由于某些结构特性("信息瓶颈")的存在,有些图对信息传播不太友好,导致来自过多节点的信息被"挤压"到单个节点的表示中——这种现象被称为"过度压缩" 。

换句话说,信息瓶颈的存在会将信息从指数级数量的邻域“过度挤压”到大小固定的向量中,如下图所示:

同时,过度挤压问题 经常与 长距离的节点特征 联系到一起,具体用下面的例子来说明:

例如,社交网络的预测只依赖本地领域节点的短程信息,无法添加远程信息进行改善,因此多运用浅层GNN进行预测。另一方面,分子图往往需要用到远程信息,因为分子的化学性质可能由其相斥的原子组合决定。深度GNN可能会被应用于处理远程信息,但如果图结构导致感受野呈指数增长,信息瓶颈现象则会阻止远程信息的有效传播。这也是为什么深度模型的性能无法提高。

四、参考文献及博客:

[1]图论:连通分量和强连通分量 - 知乎 (zhihu.com)

[2]图神经网络(GCN)中的过度平滑(over-smooth)问题以及 multi-hops解决思路-CSDN博客

[3]图神经网络中的过平滑问题 - 知乎 (zhihu.com)

[4]深入理解图(Graph)与图神经网络 (GNN)(其二)_gnn中的图瓶颈是指什么-CSDN博客

[5]《On the Trade-off between Over-smoothing and Over-squashing in Deep Graph Neural Networks》Jhony H. Giraldo、Konstantinos Skianis、Thierry Bouwmans、Fragkiskos D. Malliaros

本文探讨了图神经网络中遇到的过度光滑问题,即随着网络深度增加,连通分量内的节点特征趋同。同时介绍了过度挤压问题,源于信息瓶颈导致远程信息传播受限。作者通过实例分析了这些问题,并引用相关文献提供了解决思路。

本文探讨了图神经网络中遇到的过度光滑问题,即随着网络深度增加,连通分量内的节点特征趋同。同时介绍了过度挤压问题,源于信息瓶颈导致远程信息传播受限。作者通过实例分析了这些问题,并引用相关文献提供了解决思路。

629

629

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?