1、MISF - Multi-sensor Information Fusion 基础解析

1.1 基本概念

利用计算机技术将多传感器或多源的信息和数据,在一定的准则下加以自动分析和综合,以完成所需的决策和估计而进行的信息处理过程;多传感器信息融合是用于包含处于不同位置的多个或者多种传感器的信息处理技术;

1.2 融合层次(级别)

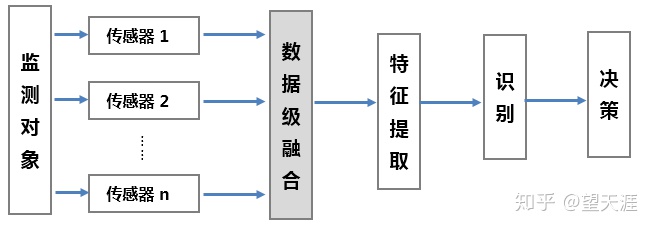

在多传感器信息融合中,按其在融合系统中信息处理的抽象程度可分为三个层次:数据级融合、特征级融合和决策级融合;

1)数据级融合:

—— 也称为像素级融合,属于底层数据融合;将多个传感器的原始观测数据(raw data)直接进行融合,然后再从融合数据中提取特征向量进行判断识别;

—— 数据级融合要求多个传感器是同质的(传感器观测的是同一物理量),否则需要进行尺度校准。

—— 数据级融合不存在数据丢失的问题,得到的结果也作为准确;但是计算量大,对系统通信带宽要求较高;

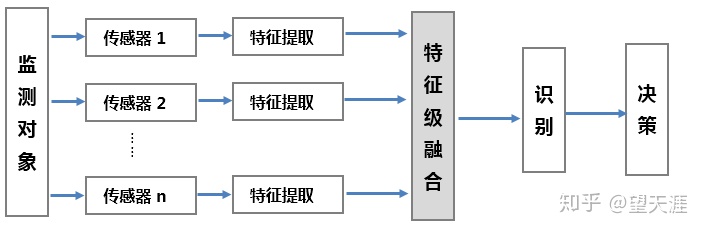

2)特征级融合

属于中间层次级融合,先从每个传感器提供的原始观测数据中提取代表性的特征,再把这些特征融合成单一的特征向量;其中选择合适的特征进行融合是关键;特征信息包括边缘、方向、速度、形状等。

特征层融合可划分为两大类:目标状态融合、目标特性融合。

目标状态融合:主要应用于多传感器的目标跟踪领域;融合系统首先对传感器数据进行预处理以完成数据配准,在数据配准之后,融合处理主要实现参数关联和状态估计。

目标特性融合:就是特征层联合识别,它的实质就是模式识别问题;在融合前必须先对特征进行关联处理,再对特征矢量分类成有意义的组合;

在融合的三个层次中,特征层融合技术发展较为完善,并且由于在特征层已建立了一整套的行之有效的特征关联技术,可以保证融合信息的一致性;此级别融合对计算量和通信带宽要求相对降低,但由于部分数据的舍弃使其准确性也有所下降。

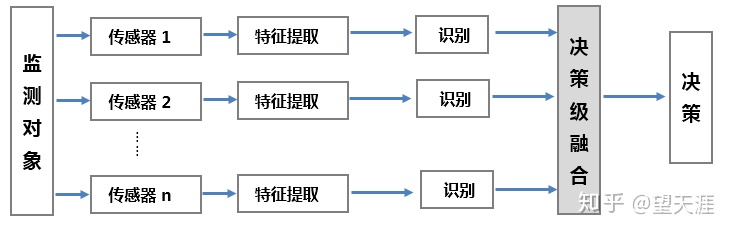

3)决策级融合

—— 属于高层次级融合,是对数据高层次级的抽象,输出是一个联合决策结果,在理论上这个联合决策应比任何单传感器决策更精确或更明确;

—— 决策层融合在信息处理方面具有很高的灵活性,系统对信息传输带宽要求很低,能有效地融合反映环境或目标各个侧面的不同类型信息,而且可以处理非同步信息;

—— 由于环境和目标的时变动态特性、先验知识获取的困难、知识库的巨量特性、面向对象的系统设计要求等,决策层融合理论与技术的发展仍受到一定的限制;

1.3 体系结构

根据对原始数据处理方法的不同,多传感器信息融合系统的体系结构可分为三种:集中式、分布式和混合式。

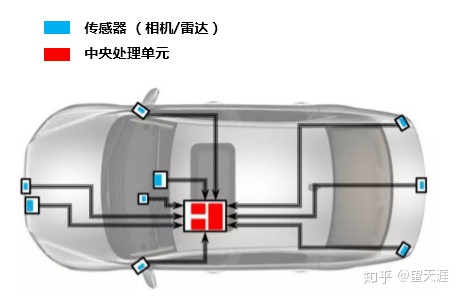

1)集中式 — 将各传感器获得的原始数据直接送到中央处理器进行融合处理,可以实现实时融合;

优点:

a、结构简单,其数据处理的精度高,算法灵活,融合速度快;

缺点:

a、各传感器的流向是由低层向融合中心单向流动,各传感器之间缺乏必要的联系;

b、中央处理器计算和通信负担过重,系统容错性差,系统可靠性较低;

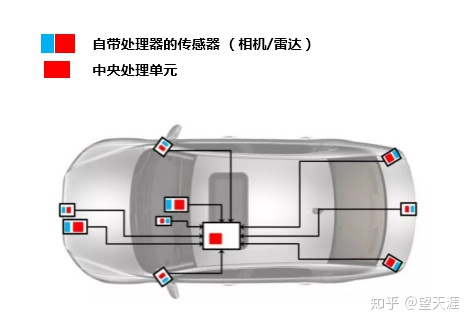

2)分布式 — 先对各个独立传感器所获得的原始数据进行局部处理,然后再将结果送入中央处理器进行融合处理来获得最终的结果;

优点:

a、每个传感器都具有估计全局信息的能力,任何一种传感器失效都不会导致系统崩溃,系统可靠性和容错性高;

b、对通信带宽要求低,计算速度快,可靠性和延续性好;

缺点:

a、传感器模块需要具备应用处理器,这样的话自身的体积将更大,功耗也就更高;

b、中央处理器只能获取各个传感器经过处理后的对象数据,而无法访问原始数据;因此,想要“放大”感兴趣的区域将很难实现;

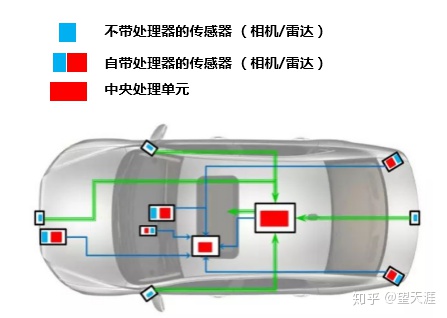

3)混合式 — 集中式和分布式的混合应用,即部分传感器采用集中式融合方式,剩余的传感器采用分布式融合方式;

特点:

a、兼顾了集中式融合和分布式的优点,稳定性强,且具有较强的使用能力;

b、对通信带宽和计算能力要求较高;

2、自动驾驶感知模块多传感器数据融合

2.1 融合的先决条件

1)运动补偿

a、ego motion 自身运动补偿

即考虑传感器在采集过程中的某一时间戳内,由于车辆自身的运动,采集的对象会在该时间戳内发生相对位移变化;

例如:以激光雷达为例,采集一圈需要0.1s,在这0.1s内,车身本身会发生一定的位移,如果不考虑车辆本身位移的情况,检测出来的目标位置就会产生较大误差;

b、motion from others 来自于其他目标的运动补偿

即考虑传感器在采集过程中的某一时间戳内,运动物体由于自身运动会产生相对位移变化;

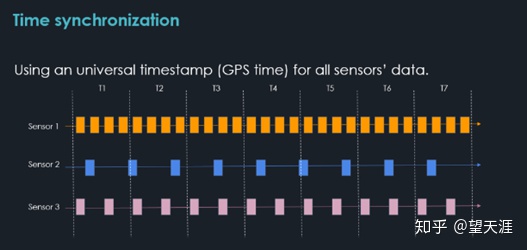

2)时间同步

通过统一的主机给各个传感器提供基准时间,各传感器根据已经校准后的各自时间为各自独立采集的数据加上时间戳信息,以做到所有传感器时间戳同步;但由于各个传感器各自采集周期相互独立,无法保证同一时刻采集相同的信息。

在很多自动驾驶车辆的传感器中,大部分支持GPS时间戳的时间同步方法;

3)空间同步 - 将不同传感器坐标系的测量值转换到同一个坐标系中;

—— 传感器标定是自动驾驶的基本需求,良好的标定是多传感器融合的基础, 自动驾驶车辆上的多个/多种传感器之间的坐标关系是需要确定的。

—— 外参是决定传感器和外部某个坐标系的转换关系,比如姿态参数。

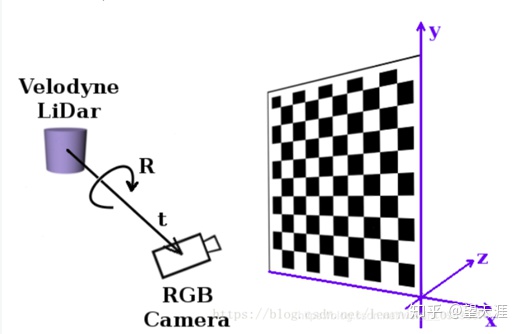

例如:摄像机和雷达的融合, 需要建立精确的雷达坐标系、三维世界坐标系、摄像机坐标系、图像坐标系和像素坐标系之间的坐标转换关系;

2.2 多传感器融合基本思路示例

1)毫米波雷达和摄像头数据融合基本思路

—— 这两种传感器相融合,多数情况下都是以摄像头数据为主,毫米波雷达作为辅助;

—— 将毫米波雷达返回的目标点投影到图像上,围绕该点并结合先验知识,生成一个矩形的感兴趣区域,然后我们只对该区域内进行目标检测。

—— 他们融合的优点是可以迅速地排除大量不会有目标的区域,极大地提高识别速度。

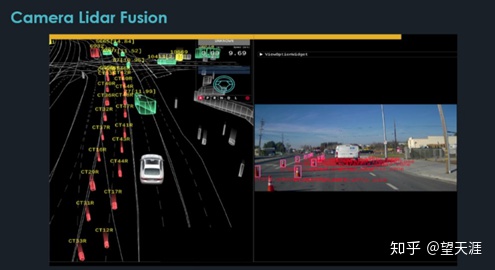

2)摄像头和激光雷达数据融合基本思路

—— 障碍物的检测可以使用激光雷达进行物体聚类,但是对于较远物体过于稀疏的激光线数聚类的效果较差,因此利用视觉图像信息进行目标检测,进而获取障碍物的位置,同时视觉还可以给出障碍物类别信息;

—— 融合的关键是需要将摄像头和激光雷达进行联合标定,获取两者坐标系的空间转换关系;可以通过标定的方式,把激光雷达投射到图像的坐标系中,建立图像的像素点,和激光雷达投影后的点之间做匹配,然后通过某种优化方程,来解决匹配问题;

—— 激光雷达可以得到目标的3D 数据(x, y , z),通过标定参数,以及相机本身的内参,可以把激光雷达的3D点投射到图像上,图像上的某些像素就会获得激光雷达的深度信息,然后便可以做基于图像的分割或者深度学习模型;

—— 融合过程中的时候,因为两者视场角的不同,可能会造成噪点或者漏点;

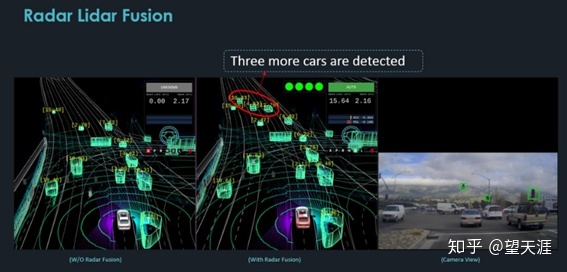

3)激光雷达和毫米波雷达融合的基本思路(待完善)

4)相机、毫米波雷达和激光雷达三者融合的基本思路(待完善)

2890

2890

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?