一、前言

1. 介绍

常来说,深度学习的关键在于实践。从图像处理到语音识别,每一个细分领域都有着独特的细微差别和解决方法。

然而,你可以从哪里获得这些数据呢?现在大家所看到的大部分研究论文都用的是专有数据集,这些专有数据集又通常不会公开。那么,想实践那些最新的理论方法往往就成了难题。

如果你也遇到了这样的问题,接下来我们会提供了一系列可用的公开数据集给大家。

在本文中,我们列出了一系列高质量的数据集,每个深度学习爱好者都可以使用这些数据集来提高自己的能力。应用这些数据集将使您成为一名更好的数据科学家,并且您从中获得的东西将在您的职业生涯中具有无可估量的价值。我们还收录了具有当前最好结果(SOTA)的论文,供您浏览并改进您的模型。

2. 如何使用这些数据集?

首先要做的事:这些数据集的规模很大!所以请确保你的网络够快,确保下载没有任何限制。

有很多种方式可以使用这些数据集。比如:你可以使用它们来锻炼你的各种深度学习方法技巧;你可以使用它们来磨练你的技能,了解如何识别和构建每个问题,思考独特的使用案例和公布你的新发现!

数据集分为三类:图像处理相关数据集,自然语言处理相关数据集和语音处理相关数据集。如下:

二、图像处理相关数据集

1. MNIST:

-

官网:http://yann.lecun.com/exdb/mnist/

-

MNIST是最受欢迎的深度学习数据集之一。它是一个手写数字数据集,包含一个60,000个样本的训练集和一个10,000个样本的测试集。这是一个很不错的数据集,它可用于在实际数据中尝试学习技术和深度识别模式,并且它花费极少的时间和精力在数据预处理上。

-

大小: 约50 MB

-

数量: 10个类别,70,000张图片

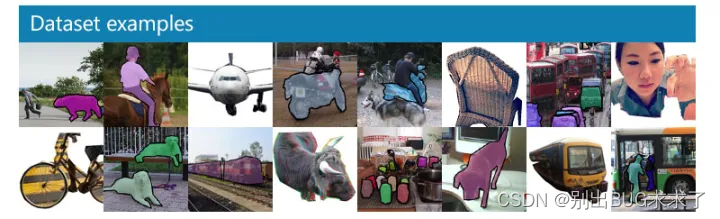

2. MS-COCO

-

COCO是一个可用于object detection, segmentation and caption的大型数据集。有以下特点:

- 目标分割

- 上下文关系识别

- 超像素分割

- 330K图像(> 200K已标记)

- 150万个目标

- 80个分类

- 91种目标

- 每张图片5个字幕

- 包含250,000个人(已标记)

-

大小:约25 GB(压缩包)

-

数量: 330K张图像,80个对象类别,每个图像5个描述,25万个人(已标记)

-

SOTA: Mask R-CNN

3. ImageNet

-

ImageNet是基于WordNet层次结构组织的图像数据集。WordNet包含约100,000个短语,ImageNet平均提供了约1000个图像来说明每个短语。

-

大小:约150GB

-

数量:图像总数约1,500,000; 每个都有多个边界框和相应的类标签。

-

SOTA: Aggregated Residual Transformations for Deep Neural Networks

4.Open Images Dataset

-

Open Images Dataset是一个包含超过900万个链接图像的数据集。其中包含9,011,219张图像的训练集,41,260张图像的验证集以及125,436张图像的测试集。它的图像种类跨越数千个类别,且有图像层级的标注框进行注释。

-

大小: 500 GB(压缩包)

-

数量: 9,011,219张超过5k标签的图像

-

SOTA: Resnet 101 image classification model (trained on V2 data):Model checkpoint, Checkpoint readme, Inference code.

5.VisualQA

-

VQA是一个包含有关图像的开放式问题的数据集。这些问题需要理解视野和语言。有以下有意思的特点:

- 265,016张图片(COCO和抽象场景)

- 每张图片至少有3个问题(平均5.4个问题)

- 每个问题10个基本事实

- 每个问题3个似乎合理(但可能不正确)的答案

- 指标自动评估

-

大小: 25 GB(压缩包)

-

数量: 265,016张图片,每张图片至少3个问题,每个问题10个基本事实

-

SOTA: Tips and Tricks for Visual Question Answering: Learnings from the 2017 Challenge

6.The Street View House Numbers (SVHN)

-

这是一个为训练目标检测算法而“真实”存在的一个图像数据集–来自于谷歌街景中的房屋号码。它对图像预处理和格式要求较低。与上边提到的MNIST数据集类似,但SVHN包含更多的标记数据(超过600,000个图像)。

-

大小: 2.5 GB

-

数量: 10个类别,共6,30,420张图片

-

SOTA:Distributional Smoothing With Virtual Adversarial Training

7.CIFAR-10

-

这个数据集是图像分类的另一个神级入门数据集。它由10个类别60,000个图像组成(每个类在上图中表示为一行)。总共有50,000个训练图像和10,000个测试图像。数据集分为6个部分 - 5个训练批次(training batches)和1个测试批次(test batches)。每个批次(batch)有10,000个图像。

-

大小:170 MB

-

数量:10个类别,共60,000张图片

8.Fashion-MNIST

-

Fashion-MNIST包含60,000个训练图像和10,000个测试图像。它是一个类似MNIST的时尚产品数据库。开发人员认为MNIST已被过度使用,因此他们将其作为该数据集的直接替代品。每张图片都以灰度显示,并与10个类别的标签相关联。

-

大小:30 MB

-

数量:10个类,70,000张图片

三、自然语言处理相关数据集

1.IMDB Reviews

-

这对电影爱好者来说是一个极棒的数据集。它可用于着二元情感分类,并具有比此领域以前的任何数据集更多的数据。除了用于训练和测试评论数据外,还有更多未标记的数据可供使用。同时该数据集还包含原始文本和预处理单词格式包。

-

大小:80 MB

-

数量:25,000条高质量影评用于训练,25,000条用于测试

2.Twenty Newsgroups

-

顾名思义,该数据集包含着新闻组相关的文本数据信息。这二十个新闻组数据集合收集了大约20,000新闻组文档,均匀的分布在20个不同的集合。这些文档具有新闻的典型特征:主题,作者和引述。

-

官网:https://archive.ics.uci.edu/ml/datasets/Twenty+Newsgroups

-

大小:20 MB

-

数量:来自20个新闻组的20,000条消息

-

SOTA:Very Deep Convolutional Networks for Text Classification

3.Sentiment140

-

Sentiment140是一个可用于情感分析的数据集。使用这个流行数据集来开启你的NLP旅程是完美的。情绪信息已经从数据中预先删除。最终的数据集具有以下6个特征:

- 推文的感情色彩(polarity)

- 推文的ID

- 推文的日期

- 查看记录

- 推特(tweeter)的用户名

- 推文的文本内容

- 大小:80 MB(压缩包)

-

数量:160,000条推文

-

SOTA:Assessing State-of-the-Art Sentiment Models on State-of-the-Art Sentiment Datasets

4.WordNet

-

在上面的ImageNet数据集中提到,WordNet是一个包含英文synsets的大型数据库。 Synsets是指同义词组,每个描述不同的概念。 WordNet的结构使其成为NLP非常有用的工具。

-

大小:10 MB

-

数量:通过少量“概念联系”将117,000个同义词集与其他同义词集相关联。

5.Yelp Reviews

-

这是Yelp(美国最大的点评网站)为了学习目的而发布的一个公开数据集。它由数百万用户评论、商业类型和来自多个大型城市的超过20万张照片组成。这在全球都是一个非常常用的NLP挑战级数据集。

-

大小:2.66 GB JSON,2.9 GB SQL and 7.5 GB Photos(全部已压缩)

-

数量:5,200,000条评论,174,000条商业类型,20万张图片和11个大型城市

6.The Wikipedia Corpus

-

该数据集是维基百科全文的集合。它包含来自400多万篇文章的将近19亿单词。这是个强大的NLP数据集–你可以通过单词,短语或段落来进行检索。

-

大小:20 MB

-

数量:4,400,000篇文章,19亿单词

-

SOTA:Breaking The Softmax Bottelneck: A High-Rank RNN language Model

7.The Blog Authorship Corpus

-

此数据集包含来自数千名博主的博文(收集自http://blogger.com)。每篇博客都作为一个单独的文件提供。每篇博客至少有着200个常用英语单词。

-

大小:300 MB

-

数量:681,288博文,超过1.4亿单词

8.Machine Translation of Various Languages

-

该数据集包含四种欧洲语言的训练数据。可用于改进当前的翻译方法。有以下语言互译可供参考:

- 英汉和汉英

- 英语 - 捷克语和捷克语 - 英语

- 英语 - 爱沙尼亚语和爱沙尼亚语 - 英语

- 英语 - 芬兰语和芬兰语 - 英语

- 英语 - 德语和德语 - 英语

- 英语 - 哈萨克语和哈萨克语 - 英语

- 英文 - 俄文和俄文 - 英文

- 英语 - 土耳其语和土耳其语 - 英语

-

大小:约15 GB

-

数量:约30,000,000个句子及其翻译

四、语音处理相关数据集

1.Free Spoken Digit Dataset

-

此列表中的另一个与MNIST数据集相似的数据集!为了解决自然语言处理中的数字识别任务而创建。这是一个公开的数据集,并且希望随着人们贡献更多样本来获得持续增长。目前,它包含以下特点:

- 3个录音者

- 1500条录音(每个人每个数字50遍)

- 英式发音

-

大小:10 MB

-

数量:1500条音频

-

SOTA:Raw Waveform-based Audio Classification Using Sample-level CNN Architectures

2.Free Music Archive (FMA)

-

FMA是一个音乐分析数据集。数据集由音频(full-length and HQ),预先计算的特征( pre-computed features)以及音轨和用户级元数据(metadata)组成。它是一个公开数据集,用来评估MIR中的多项任务。以下是其包含的csv文件列表:

-

tracks.csv:包含所有(106,574首)曲目的基本信息–ID,标题,艺术家,流派,标签和播放次数。

-

genres.csv:163种流派的ID(包含名称和之间的关系)

-

features.csv:基本特征(使用librosa提取)。

-

echonest.csv:由Echonest(现在的Spotify)为13129首曲目提供的音频特征。

-

-

大小:约1000 GB

-

数量:约100,000曲目(tracks)

3.Ballroom

-

该数据集由来自舞厅的音频数据组成。以实际音频格式提供了许多舞蹈风格的一些音频片段。有以下特点:

- 总数:698

- 单个时长:约30秒

- 总时长:约20940秒

-

大小:14GB(压缩)

-

官网:http://mtg.upf.edu/ismir2004/contest/tempoContest/node5.html

-

数量:约700个音频样本

-

SOTA: A Multi-Model Approach To Beat Tracking Considering Heterogeneous Music Styles

4.Million Song Dataset

-

百万歌曲数据集是由一百万首当代流行音乐曲目的音频特征和元数据组成。其目的是:

- 鼓励对扩展到商业规模的算法进行研究

- 为评估研究提供参考数据集

- 作为使用API创建大型数据集的替代方法(e.g. The Echo Nest)

- 帮助新研究人员在MIR领域开始工作

- 数据集的核心是一百万首歌曲的特征分析和元数据。该数据集不包含任何音频,只包含派生的特征。样本音频可以通过使用哥伦比亚大学提供的代码从7digital等服务器上获取。

-

大小:280 GB

-

代码:https://github.com/tb2332/MSongsDB/tree/master/Tasks_Demos/Preview7digital

-

数量:一百万首歌曲哦!

-

SOTA: Preliminary Study on a Recommender System for the Million Songs Dataset Challenge

5.LibriSpeech

-

该数据集是包含约1000小时英语音频的大型语料库。这些数据来自LibriVox项目的有声读物(audiobooks),且已经过分割、对齐处理。如果您恰好想入门这个领域,请查看已准备好的声学模型(已在kaldi-asr.org和语言模型上进行了训练且适合评估),网址为http://www.openslr.org/11/ 。

-

大小:约60 GB

-

数量:1000小时音频

-

SOTA: Letter-Based Speech Recognition with Gated ConvNets

6.VoxCeleb

-

VoxCeleb是一个大型的语音识别数据集。它由来自YouTube视频中的1,251名明星所讲的约10万句话组成。这些数据性别分布均衡(男性占55%),名人跨越不同的口音、职业和年龄,训练集和测试集之间没有重叠。通过这个数据集可以实现一个有趣的应用–区分和识别超级巨星。

-

大小:150 MB

-

数量:1,251位名人的100,000条话语

五、Supplement

为了帮助练习,我们还提供了来自DataHack平台,三个更贴近生活的题目(包含问题+数据集)供练手。当然,肯定是深度学习相关,如下:

1.Twitter Sentiment Analysis

-

含有种族主义和性别歧视言论的推文的处理已成为twitter的难题,那么区分识别这些推文就成了twitter的重要任务。在这个实际问题中,我们提供正常推文与非正常推文两种Twitter数据。你的任务是正确区分这些推文。

-

官网:https://datahack.analyticsvidhya.com/contest/practice-problem-twitter-sentiment-analysis/

-

大小:3 MB

-

数量:31,962条推文

2.Age Detection of Indian Actors

-

对于任何深度学习爱好者来说,这都是一个令人着迷的挑战。该数据集由数千个印度演员的图片组成,你的任务是确定他们的年龄。所有图像都是从视频帧中人工剪切的,这致使尺度,姿态,表情,亮度(illumination),年龄,分辨率,遮挡和妆容具有高度可变性。

-

官网:https://datahack.analyticsvidhya.com/contest/practice-problem-age-detection/

-

大小:48 MB(压缩包)

-

数量:训练集19,906幅图像和测试集6636幅图像

-

SOTA: Hands on with Deep Learning – Solution for Age Detection Practice Problem

3.Urban Sound Classification

-

这个数据集包含超过8000个来自10个类别的城市声音片段。这个实际问题旨在向你介绍对常用分类场景的音频处理。

-

官网:https://datahack.analyticsvidhya.com/contest/practice-problem-urban-sound-classification/

-

大小:训练集 - 3 GB(压缩),测试集 - 2 GB(压缩)

-

数量:10个类别,8732个城市声音片段(单个片段时长<= 4s,已标注)

结束语

如果您知道其他公开数据集,可以告诉我们(说明推荐原因、详细用途等等)。

如果理由充分,我会把它们列入清单。来评论里讨论你们的使用感受吧。深度学习万岁!

1244

1244

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?