说明:这是一个机器学习实战项目(附带数据+代码+文档+视频讲解),如需数据+代码+文档+视频讲解可以直接到文章最后获取。

1.项目背景

Optuna是一个开源的超参数优化(HPO)框架,用于自动执行超参数的搜索空间。 为了找到最佳的超参数集,Optuna使用贝叶斯方法。

LigthGBM算法是Boosting算法的新成员,由微软公司开发,采用损失函数的负梯度作为当前决策树的残差近似值,去拟合新的决策树。

本项目使用基于Optuna超参数自动优化的LGBMRegressor算法来解决回归问题。

2.数据获取

本次建模数据来源于网络(本项目撰写人整理而成),数据项统计如下:

数据详情如下(部分展示):

3.数据预处理

3.1 用Pandas工具查看数据

使用Pandas工具的head()方法查看前五行数据:

从上图可以看到,总共有9个字段。

关键代码:

3.2 缺失值统计

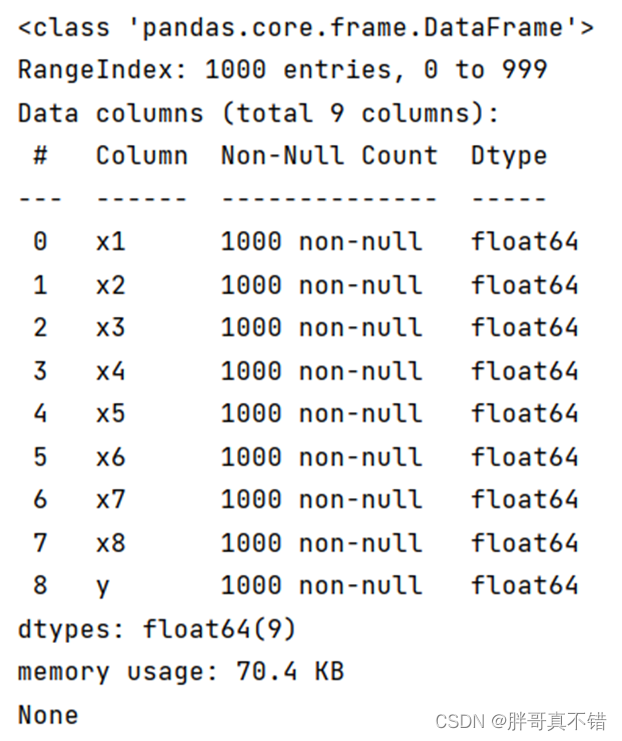

使用Pandas工具的info()方法统计每个特征缺失情况:

从上图可以看到,数据不存在缺失值,总数据量为1000条。

关键代码:

3.3 变量描述性统计分析

通过Pandas工具的describe()方法来来统计变量的平均值、标准差、最大值、最小值、分位数等信息:

关键代码如下:

4.探索性数据分析

4.1 y变量分布直方图

通过Matpltlib工具的hist()方法绘制直方图:

从上图可以看出,y主要集中在-200到200之间。

4.2 相关性分析

通过Pandas工具的corr()方法和seaborn工具的heatmap()方法绘制相关性热力图:

从图中可以看到,正数为正相关,负数为负相关,绝对值越大相关性越强。

5.特征工程

5.1 建立特征数据和标签数据

y为标签数据,除 y之外的为特征数据。关键代码如下:

5.2 数据集拆分

数据集集拆分,分为训练集和测试集,80%训练集和20%测试集。关键代码如下:

6.构建Optuna超参数自动化的LightGBM回归模型

主要使用基于Optuna超参数自动化调优的LGBMRegressor算法,用于目标回归。

6.1 Optuna超参数自动化调优框架介绍

Optuna是一个开源的超参数优化(HPO)框架,用于自动执行超参数的搜索空间。 为了找到最佳的超参数集,Optuna使用贝叶斯方法。 它支持下面列出的各种类型的采样器:

- GridSampler (使用网格搜索)

- RandomSampler (使用随机采样)

- TPESampler (使用树结构的Parzen估计器算法)

- CmaEsSampler (使用CMA-ES算法)

一个极简的 Optuna 的优化程序中只有三个最核心的概念,目标函数(objective),单次试验(trial),和研究(study):

- objective 负责定义待优化函数并指定参/超参数数范围

- trial 对应着 objective 的单次执行

- study 则负责管理优化,决定优化的方式,总试验的次数、试验结果的记录等功能。

6.2 构建调优模型

关键代码如下:

6.3 最优参数展示

最优参数结果展示:

关键代码如下:

7.模型评估

7.1评估指标及结果

评估指标主要包括R方、均方误差、解释性方差、绝对误差等等。

从上表可以看出,R方分值为0.9352,说明模型效果较好。

关键代码如下:

7.2 真实值与预测值对比图

从上图可以看出真实值和预测值波动基本一致,模型效果较好。

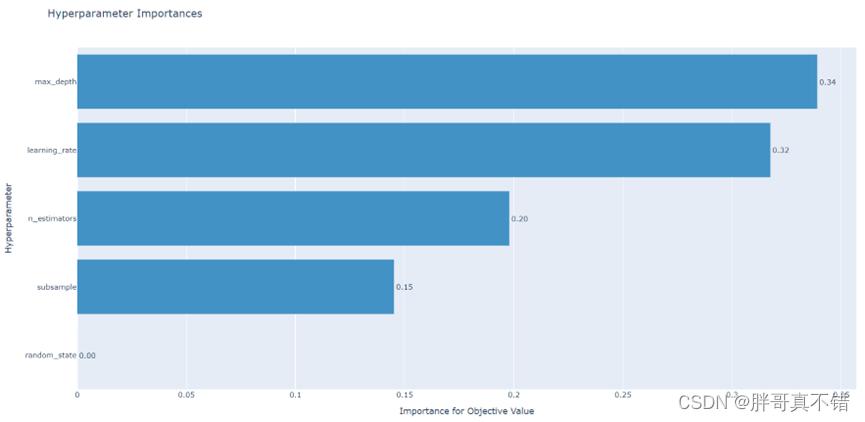

7.3 超参数重要性可视化图

通过上图可以看出,超参数的重要性依次为:max_depth、learning_rate、n_estimators、subsample、random_state。

8.结论与展望

综上所述,本项目采用了基于Optuna超参数自动调优的LightGBM回归模型,最终证明了我们提出的模型效果良好。

# 本次机器学习项目实战所需的资料,项目资源如下: # 项目说明: # 链接:https://pan.baidu.com/s/1478dyFu8BTbAwqPeNKI5Sw # 提取码:dy29 # 用Pandas工具查看数据 print(data.head()) # 数据缺失值统计 print('****************************************') print(data.info()) print('****************************************') print(data.describe().round(4)) # 保留4位小数点 # y变量分布直方图 fig = plt.figure(figsize=(8, 5)) # 设置画布大小 plt.rcParams['font.sans-serif'] = 'SimHei' # 设置中文显示 plt.rcParams['axes.unicode_minus'] = False # 解决保存图像是负号'-'显示为方块的问题 data_tmp = data['y'] # 过滤出y变量的样本 # 绘制直方图 bins:控制直方图中的区间个数 auto为自动填充个数 color:指定柱子的填充色 plt.hist(data_tmp, bins='auto', color='g') plt.xlabel('y') plt.ylabel('数量') plt.title('y变量分布直方图')

3064

3064

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?