参考:https://kexue.fm/archives/8069

https://kexue.fm/archives/9079

https://zhuanlan.zhihu.com/p/531476789

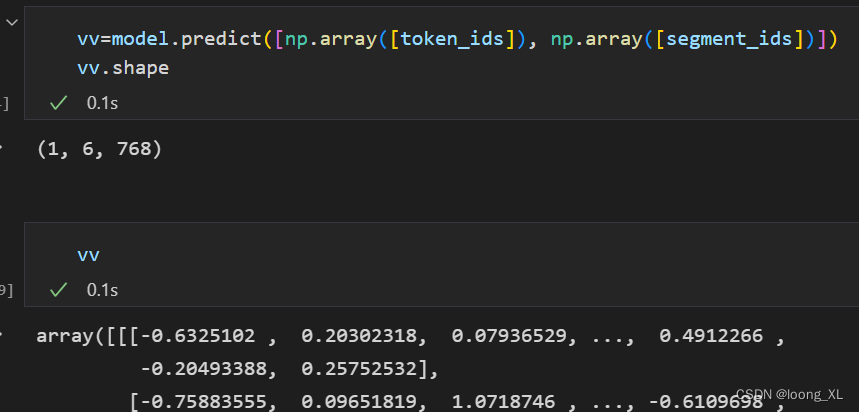

输入:vv是多个向量组成的三维矩阵

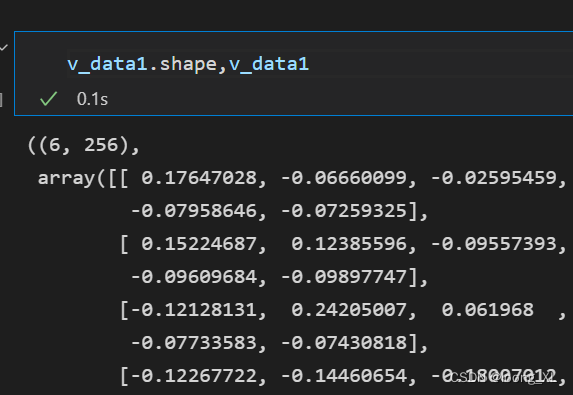

结果:v_data1 256维度

def compute_kernel_bias(vecs, n_components=256):

"""计算kernel和bias

vecs.shape = [num_samples, embedding_size],

最后的变换:y = (x + bias).dot(kernel)

"""

mu = vecs.mean(axis=0, keepdims=True)

cov = np.cov(vecs.T)

# print(cov)

u, s, vh = np.linalg.svd(cov)

print(np.diag(1 / np.sqrt(s) ))

W = np.dot(u, np.diag(1 / np.sqrt(s)))

return W[:, :n_components], -mu

def transform_and_normalize(vecs, kernel=None, bias=None):

""" 最终向量标准化

"""

订阅专栏 解锁全文

订阅专栏 解锁全文

3347

3347

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?