原文链接:http://shichuan.org/doc/86.pdf

代码链接:https://github.com/zhumeiqiBUPT/AM-GCN

一、问题描述:现有的GCN方法自适应融合拓扑结构和节点特征的能力有限,以致于性能甚至还低于只利用拓扑信息或是特征信息的多层感知器,因此,文章尝试从本质上提升GCN的融合这两种信息的性能。

二、方法概述:

为了充分利用特征空间中的信息,我们推导出由节点特征生成的k近邻图作为特征结构图。通过特征图和拓扑图,我们在拓扑空间和特征空间上传播节点特征,从而在这两个空间中通过两个特定的图卷积模块提取出两个特定的嵌入(embedding)。考虑到两个空间之间的共同特性,我们设计了一个带有参数共享策略的公共图卷积模块来提取它们共享的公共嵌入。我们进一步利用注意力机制自动学习上述三种不同嵌入的重要性权重,从而自适应融合它们。这样,节点标签能够监督学习过程,自适应调整权重,提取最相关的信息。此外,我们设计了一致性和视差 (the consistency and disparity) 约束,以确保学习嵌入的一致性和视差。

三、实验描述:

1. 探究最先进的GCNs是否能够自适应地学习图中的节点特征和拓扑结构,并充分融合它们用于分类任务。

(1)GCN和MLP(不考虑拓扑结构)处理随机拓扑但节点特征与标签高度相关的数据,结果GCN<MLP

(2)GCN和DeepWalk(不考虑节点特征)处理随机节点特征但拓扑结构与聚类群落(即标签)高度相关的数据,结果GCN<DeepWalk

四、AM-GCN网络搭建

1.整体框架

AM-GCN的总体框架如图1所示。其核心思想是,AM-GCN不仅允许节点特征在拓扑空间传播,还允许节点特征在特征空间传播,同时从这两个空间中提取与节点标签最相关的信息。为此,我们基于节点特征X构造一个特征图,然后通过两个特定的卷积模块,X可以在特征图和拓扑图上传播,分别学习两个特定的嵌入ZF和ZT。进一步,考虑到这两个空间中的信息具有共同特征,我们设计了具有参数共享策略的共同卷积模块来学习共同嵌入的ZCF和ZCT,并使用一致性约束Lc来增强ZCF和ZCT的“共同”特性。此外,视差约束Ld是为了保证ZF和ZCF、ZT和ZCT之间的独立性。考虑到节点标签可能与拓扑或特征相关,也可能与特征相关,也可能两者都有,AM-GCN利用注意机制自适应地将这些嵌入内容与学习到的权值融合,从而提取出最相关的信息Z,用于最终的分类任务。

2.从两个角度构建图,利用特点卷积模块生成特定的嵌入

(1)利用KNN(cosine value)计算节点特征的相似性,并将对应节点与k个最相似的领点构建边连接,从而得到特征空间下的邻接矩阵Af,再结合多层GCN的前向传播公式得到特征空间下的特定节点嵌入:

![]()

![]()

(2)利用物理信息构建的拓扑图,得到拓扑空间下的邻接矩阵At,再结合多层GCN的前向传播公式得到类似上式拓扑空间下的特定节点嵌入。

3.结合两个空间的节点嵌入,利用共有的卷积模块生成共有嵌入

在现实中,特征空间和拓扑空间并非完全不相干。基本上,节点分类任务可能与特征空间或拓扑空间的信息相关,也可能与两者都相关,这是很难事先知道的。因此,我们不仅需要提取这两个空间中特定节点的嵌入,还需要提取两个空间共享的公共信息。 通过这种方式,任务将变得更加灵活,以确定哪个部分的信息是最相关的。为了解决这个问题,我们设计了一个带有参数共享策略的Common-GCN,使嵌入在两个空间共享。通过这种方式,任务将变得更加灵活,以确定哪个部分的信息是最相关的。

4.共享机制

现在我们有两个特定的嵌入ZT和ZF,和一个共有的嵌入ZC。考虑到节点标签可能与它们中的一个或它们的组合相关,我们利用注意机制att(ZT, ZC, ZF)来了解它们对应的重要性(αt,αc,αf)如下:

![]()

![]() 分别表示嵌入ZT、ZC、ZF的n个节点的注意力值。

分别表示嵌入ZT、ZC、ZF的n个节点的注意力值。

关注节点i,其在ZT的嵌入是![]()

![]() .首先通过非线性转换上述嵌入,然后使用一个共享参数向量

.首先通过非线性转换上述嵌入,然后使用一个共享参数向量![]() 得到如下共享值(1*1)

得到如下共享值(1*1)

![]()

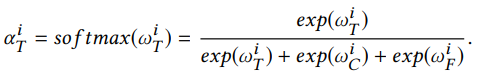

同理得到节点i在ZC、ZF下的共享值![]() 。并利用softmax函数正则化节点i的三个共享值

。并利用softmax函数正则化节点i的三个共享值![]() 得到最后的权重:

得到最后的权重:

同样地,![]() 。α 越大,对应的嵌入越重要。对于所有的n个节点,得到

。α 越大,对应的嵌入越重要。对于所有的n个节点,得到![]()

![]() ,

,![]()

![]() 。然后我们通过对这三个嵌入加权求和来获得最终的嵌入Z:

。然后我们通过对这三个嵌入加权求和来获得最终的嵌入Z:

![]()

5.约束说明

(1)一致性约束:尽管Common-GCN得到的两个嵌入ZCT和ZCF有共享权矩阵,但我们在这里设计了一个一致性约束来进一步增强它们的共同性:

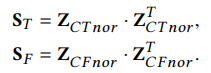

首先,我们使用L2正则去正则化这两个嵌入为ZCTnor和ZCFnor。然后这两个归一化矩阵能够用于获取n个节点的相似性,如下面的ST和SF所示:

一致性意味着两个相似矩阵应该是相似的,这就产生了以下约束:

![]()

(2)视差约束:在这里,由于嵌入ZT和ZCT是从同一个拓扑图学习的,为了确保它们能够捕获不同的信息,我们采用Hilbert-Schmidt独立准则(HSIC)[24],一种简单而有效的独立性措施,来增强这两个嵌入的差异。由于其简单、简洁的理论性质,HSIC已被应用于多个机器学习任务[10,19]。形式上,ZT和ZCT的HSIC约束定义为( HSIC(X,Y)的值越大,表明X和Y的依赖性越强;值越小,则X和Y的独立性越强):

![]()

然后我们将视差约束设为Ld,其中:

![]()

6.优化目标

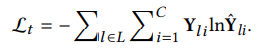

我们使用Eq.(10)中的输出嵌入Z进行半监督多类分类,并使用线性变换和softmax函数。表示n个节点的类预测为:

![]()

假设真实标签是![]() ,预测标签是

,预测标签是![]() ,则训练集的节点分类交叉熵函数为:

,则训练集的节点分类交叉熵函数为:

结合节点分类任务和约束条件,我们有如下总体目标函数(目标就是最小化总体目标函数):

![]()

其中γ和β是一致性和视差约束项的参数。在标签数据的引导下,我们可以通过反向传播来优化模型,并学习节点的嵌入来进行分类。

五、实验

1.与现有算法对比

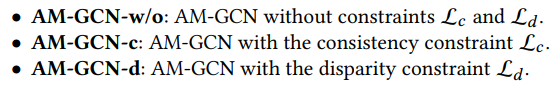

2.约束作用效果分析

3.聚类效果可视化(使用在AM-GCN(或GCN, GAT)的最后一层(softmax层之前)上的输出嵌入Z,使用t-SNE可视化)

4.注意力机制分析

为了研究我们所提出的模型所学习到的注意值是否有意义,我们分别分析了注意力分布和注意力学习趋势。

(1)注意力分布分析

实验表明,我们提出的AM-GCN能够自适应地为更重要的信息(拓扑信息或者节点特征信息或是共享信息)赋予更大的注意值

(2)注意力学习趋势分析

主要分析了训练过程中注意值的变化趋势。开始时,Topology、Feature和Common的平均注意值基本相同,但随着训练时间的增加,注意值发生了变化。例如,在BlogCatalog中,拓扑的关注值逐渐减少,而特性的关注值不断增加

5.目标函数约束项参数γ和β以及KNN图的邻域范围k研究

在本节中,我们研究参数γ,β和k的灵敏度。

(1)一致性系数γ的分析

检验一致性约束权值γ的效果,并将其从0到10000进行变化。结果如图6所示。随着一致性系数的增加,性能先上升后缓慢下降。当γ在1e-4 ~ 1e+4范围内时,AM-GCN基本稳定。我们还可以看到,20,40,60标签率曲线的变化趋势相似。

(2)视差约束系数β的分析。

然后我们测试Eq.(18)中的视差约束权值β的效果,并将其从0变化到1e-5。结果如图7所示。同样,随着β的增加,性能也先提高,但图7(a)中,对于Citeseer来说,当β大于1e-6时,性能会迅速下降,而对于BlogCatalog来说,性能则相对稳定。

(3)KNN图的邻域范围k分析

为了检验kNN图中排名前k个邻域的影响,我们研究了 k 2-10 取值范围内的AM-GCN性能

。对于Citeseer和BlogCatalog,准确性先增加,然后开始下降。这可能是因为如果图变得更密集,特征更容易被平滑,而且k越大,可能会引入更多的噪声边。

1417

1417

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?