小白学Pytorch系列–Torch.nn API Padding Layers(4)

| 方法 | 注释 |

|---|---|

| nn.ReflectionPad1d | 使用输入边界的反射来填充输入张量。 |

| nn.ReflectionPad2d | 使用输入边界的反射来填充输入张量。 |

| nn.ReflectionPad3d | 使用输入边界的反射来填充输入张量。 |

| nn.ReplicationPad1d | 使用输入边界的复制来填充输入张量。 |

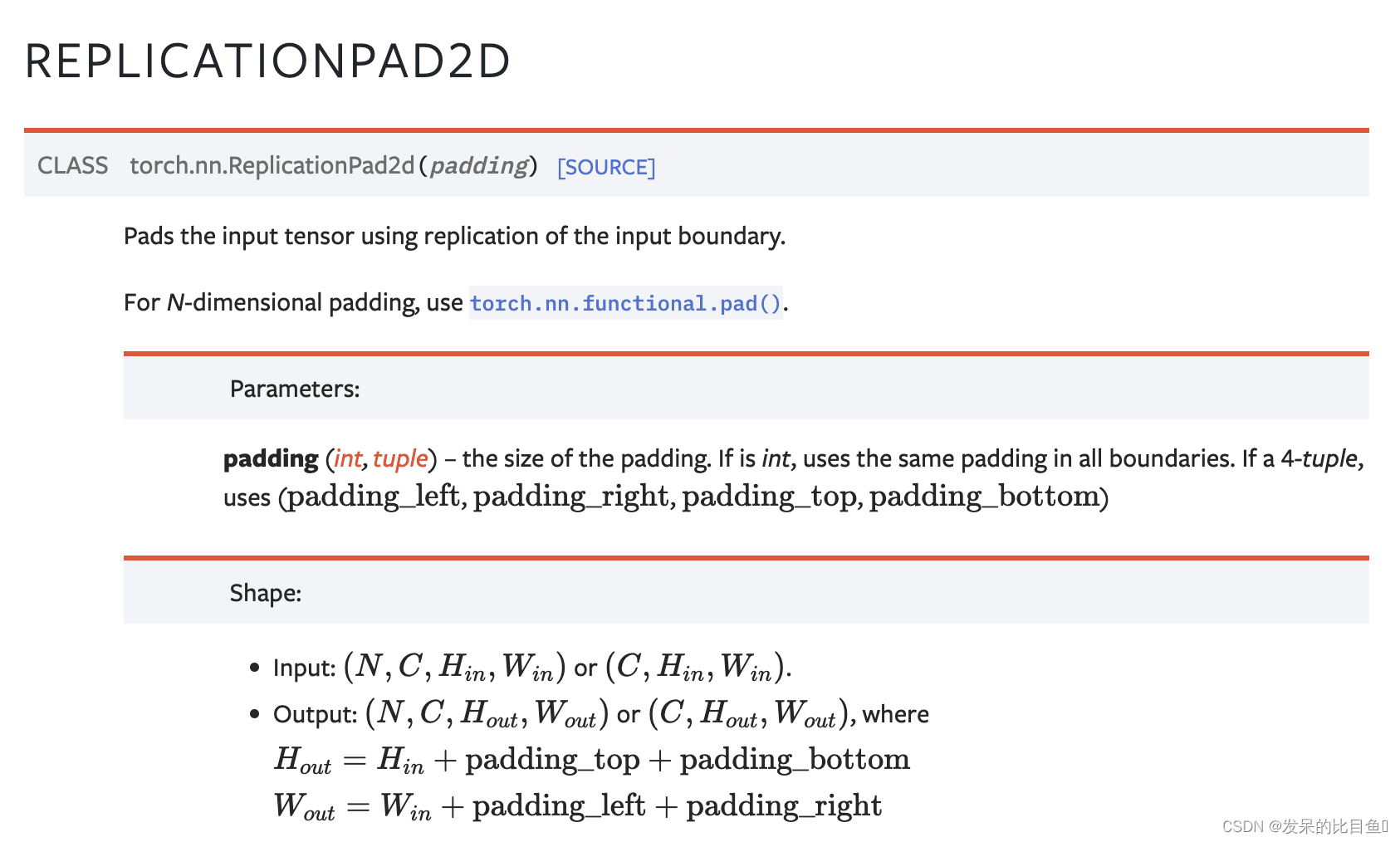

| nn.ReplicationPad2d | 使用输入边界的复制来填充输入张量。 |

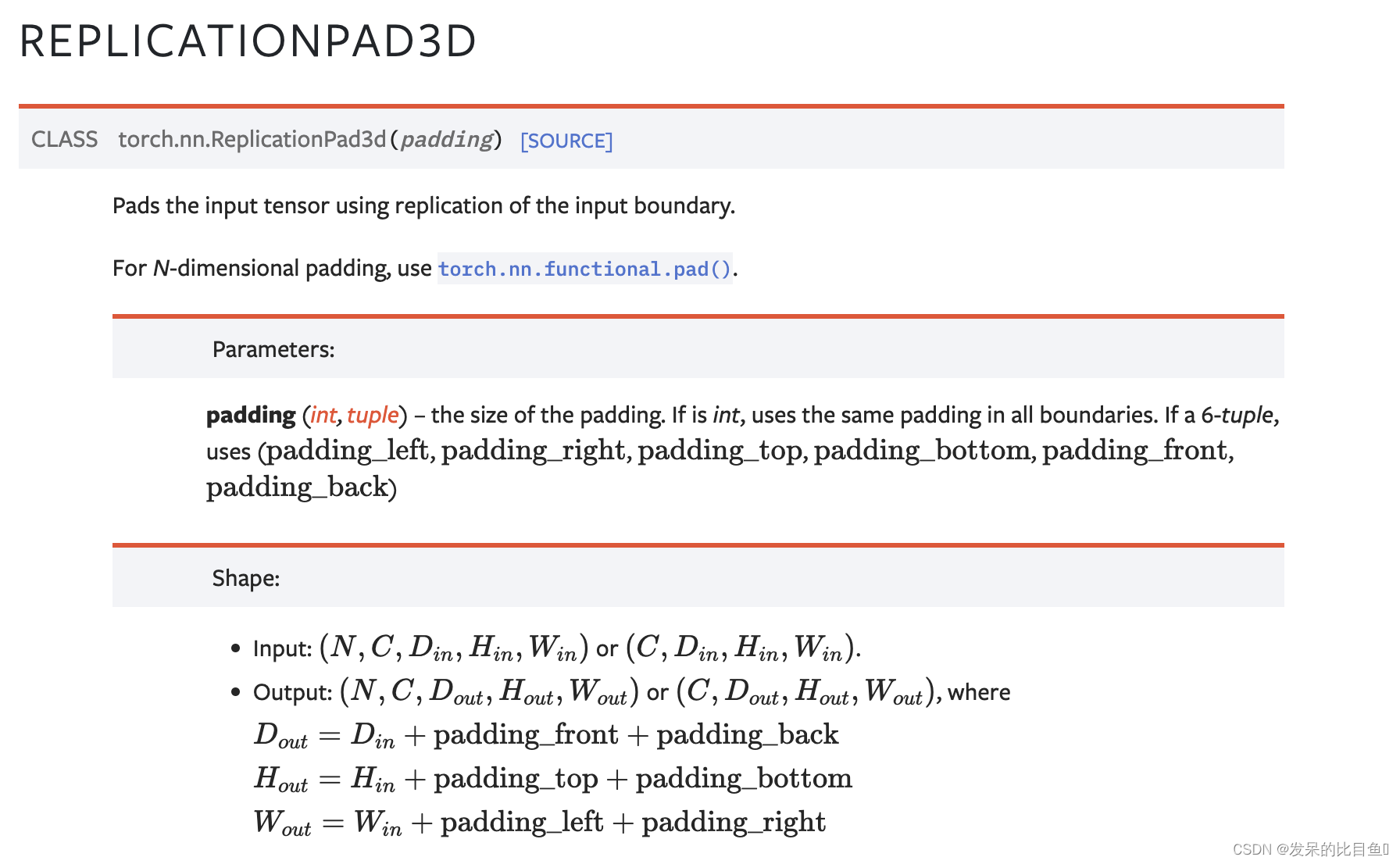

| nn.ReplicationPad3d | 使用输入边界的复制来填充输入张量。 |

| nn.ZeroPad2d | 用零填充输入张量边界。 |

| nn.ConstantPad1d | 用常值填充输入张量边界 |

| nn.ConstantPad2d | 用常值填充输入张量边界。 |

| nn.ConstantPad3d | 用常值填充输入张量边界。 |

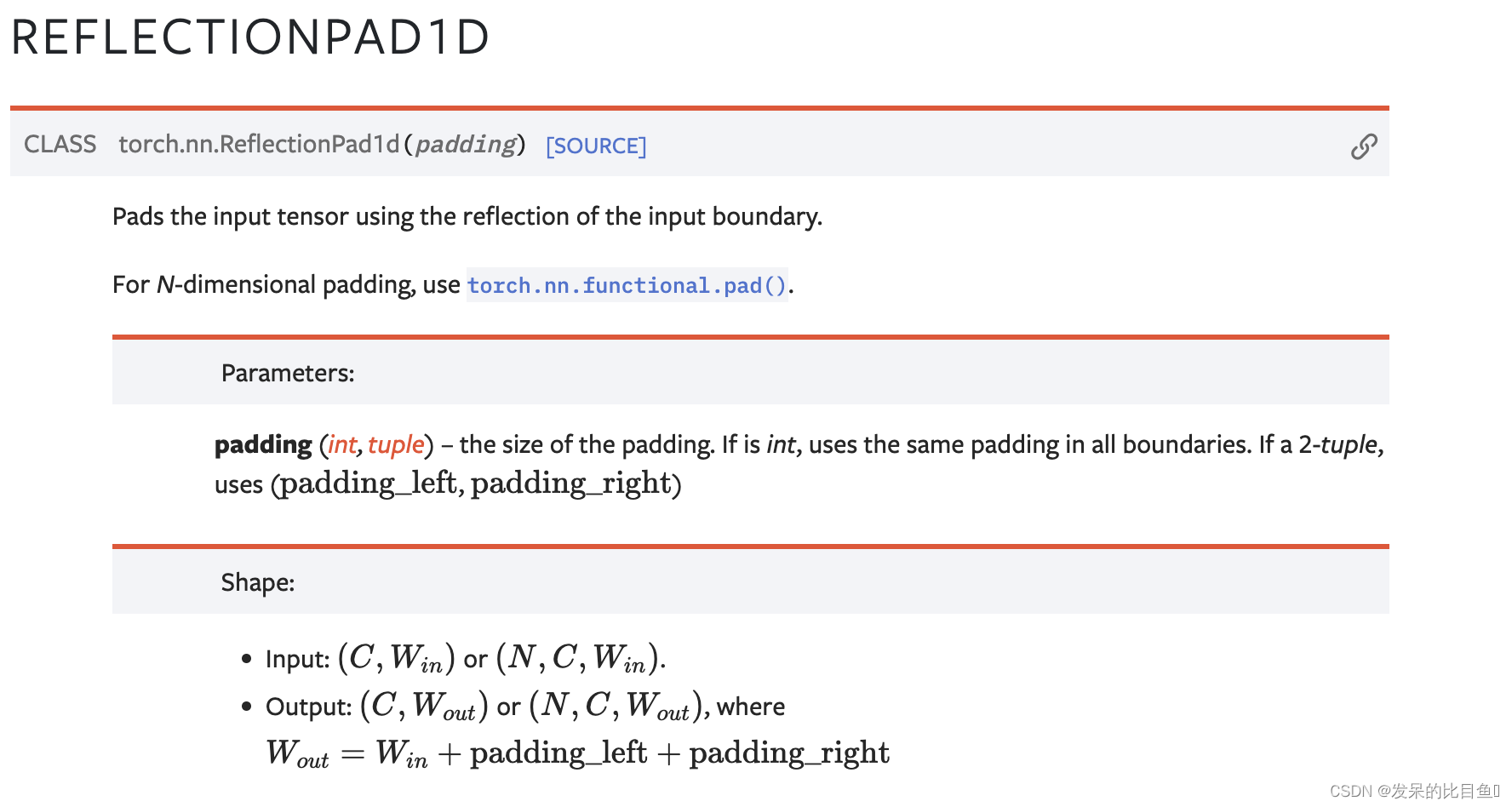

nn.ReflectionPad1d

>>> m = nn.ReflectionPad1d(2)

>>> input = torch.arange(8, dtype=torch.float).reshape(1, 2, 4)

>>> input

tensor([[[0., 1., 2., 3.],

[4., 5., 6., 7.]]])

>>> m(input)

tensor([[[2., 1., 0., 1., 2., 3., 2., 1.],

[6., 5., 4., 5., 6., 7., 6., 5.]]])

>>> # using different paddings for different sides

>>> m = nn.ReflectionPad1d((3, 1))

>>> m(input)

tensor([[[3., 2., 1., 0., 1., 2., 3., 2.],

[7., 6., 5., 4., 5., 6., 7., 6.]]])

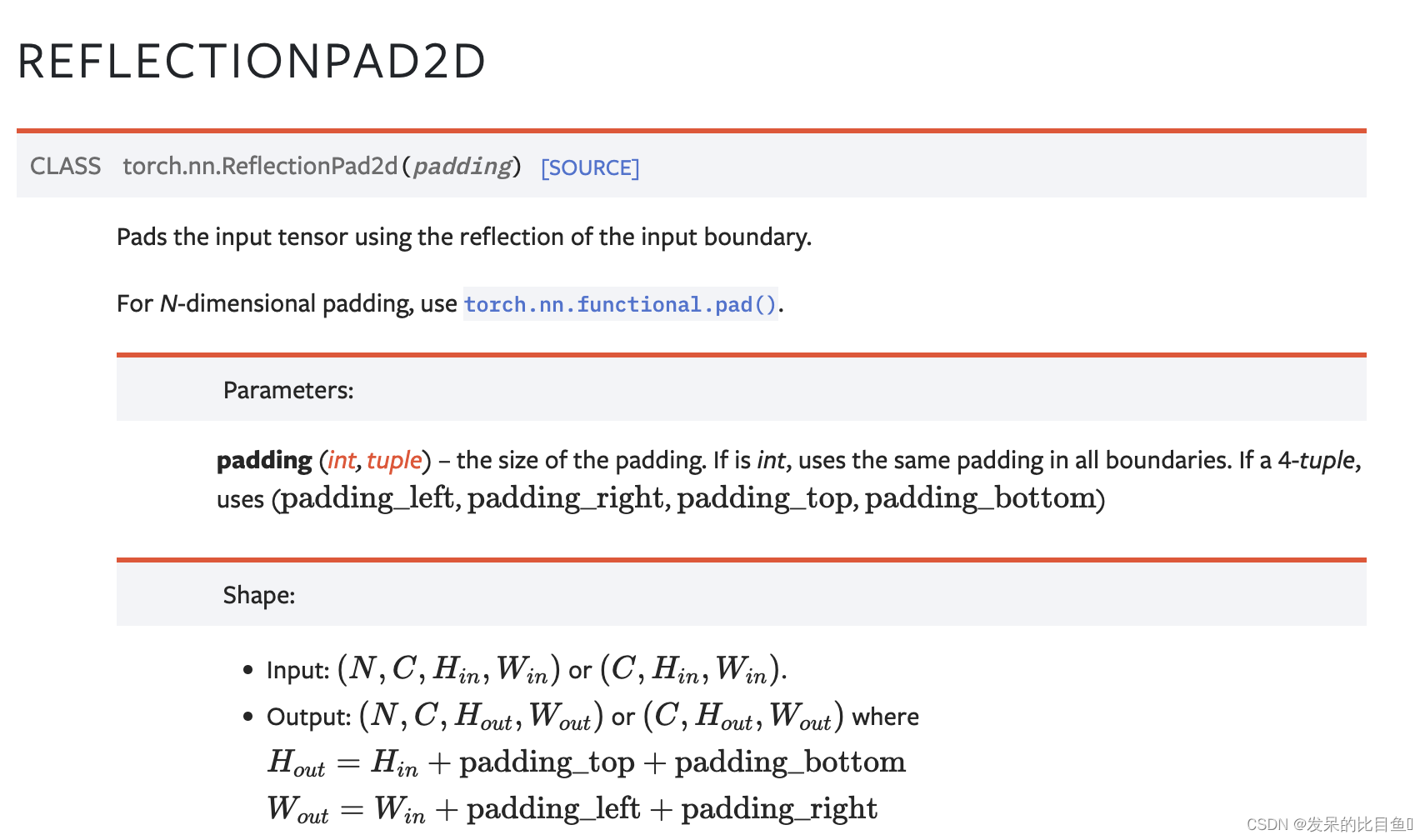

nn.ReflectionPad2d

>>> m = nn.ReflectionPad2d(2)

>>> input = torch.arange(9, dtype=torch.float).reshape(1, 1, 3, 3)

>>> input

tensor([[[[0., 1., 2.],

[3., 4., 5.],

[6., 7., 8.]]]])

>>> m(input)

tensor([[[[8., 7., 6., 7., 8., 7., 6.],

[5., 4., 3., 4., 5., 4., 3.],

[2., 1., 0., 1., 2., 1., 0.],

[5., 4., 3., 4., 5., 4., 3.],

[8., 7., 6., 7., 8., 7., 6.],

[5., 4., 3., 4., 5., 4., 3.],

[2., 1., 0., 1., 2., 1., 0.]]]])

>>> # using different paddings for different sides

>>> m = nn.ReflectionPad2d((1, 1, 2, 0))

>>> m(input)

tensor([[[[7., 6., 7., 8., 7.],

[4., 3., 4., 5., 4.],

[1., 0., 1., 2., 1.],

[4., 3., 4., 5., 4.],

[7., 6., 7., 8., 7.]]]])

nn.ReflectionPad3d

>>> m = nn.ReflectionPad3d(1)

>>> input = torch.arange(8, dtype=torch.float).reshape(1, 1, 2, 2, 2)

>>> m(input)

tensor([[[[[7., 6., 7., 6.],

[5., 4., 5., 4.],

[7., 6., 7., 6.],

[5., 4., 5., 4.]],

[[3., 2., 3., 2.],

[1., 0., 1., 0.],

[3., 2., 3., 2.],

[1., 0., 1., 0.]],

[[7., 6., 7., 6.],

[5., 4., 5., 4.],

[7., 6., 7., 6.],

[5., 4., 5., 4.]],

[[3., 2., 3., 2.],

[1., 0., 1., 0.],

[3., 2., 3., 2.],

[1., 0., 1., 0.]]]]])

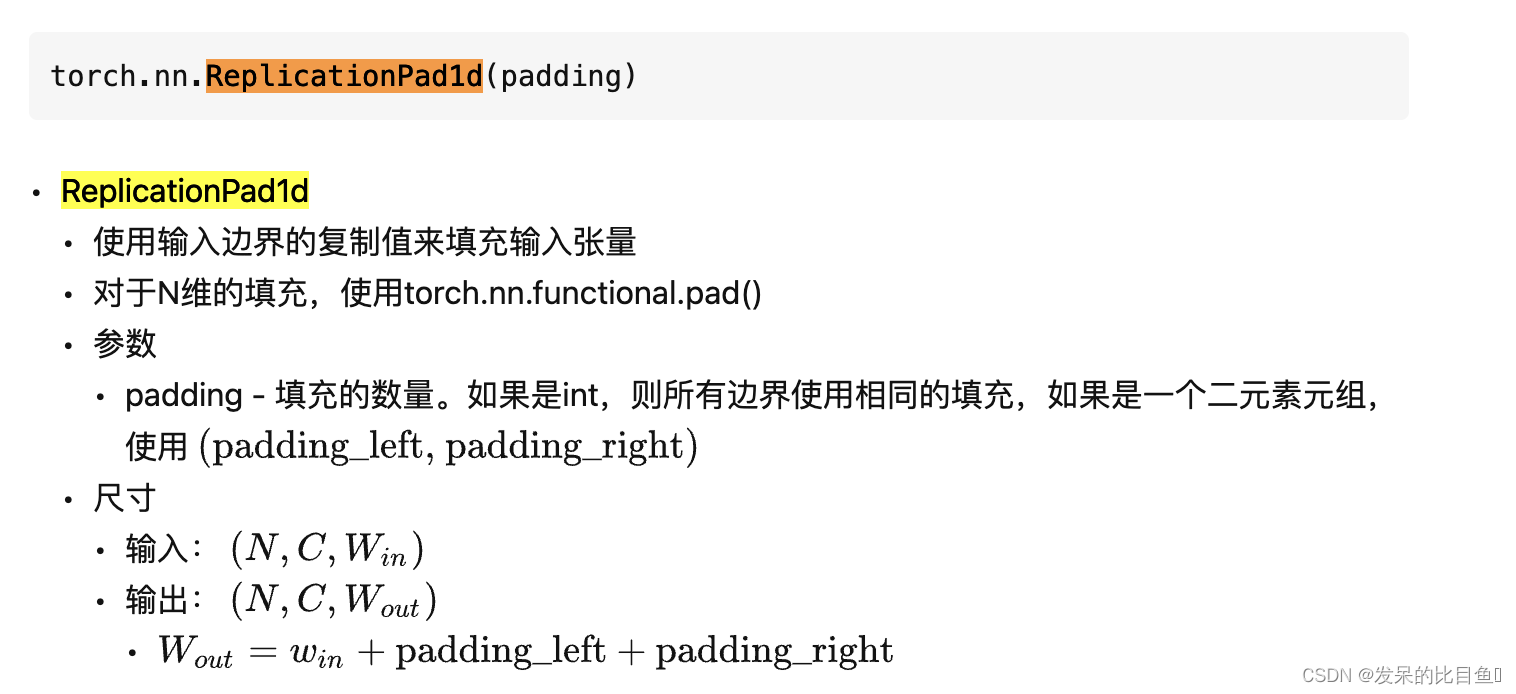

nn.ReplicationPad1d

>>> m = nn.ReplicationPad1d(2)

>>> input = torch.arange(8, dtype=torch.float).reshape(1, 2, 4)

>>> input

tensor([[[0., 1., 2., 3.],

[4., 5., 6., 7.]]])

>>> m(input)

tensor([[[0., 0., 0., 1., 2., 3., 3., 3.],

[4., 4., 4., 5., 6., 7., 7., 7.]]])

>>> # using different paddings for different sides

>>> m = nn.ReplicationPad1d((3, 1))

>>> m(input)

tensor([[[0., 0., 0., 0., 1., 2., 3., 3.],

[4., 4., 4., 4., 5., 6., 7., 7.]]])

nn.ReplicationPad2d

>>> m = nn.ReplicationPad2d(2)

>>> input = torch.arange(9, dtype=torch.float).reshape(1, 1, 3, 3)

>>> input

tensor([[[[0., 1., 2.],

[3., 4., 5.],

[6., 7., 8.]]]])

>>> m(input)

tensor([[[[0., 0., 0., 1., 2., 2., 2.],

[0., 0., 0., 1., 2., 2., 2.],

[0., 0., 0., 1., 2., 2., 2.],

[3., 3., 3., 4., 5., 5., 5.],

[6., 6., 6., 7., 8., 8., 8.],

[6., 6., 6., 7., 8., 8., 8.],

[6., 6., 6., 7., 8., 8., 8.]]]])

>>> # using different paddings for different sides

>>> m = nn.ReplicationPad2d((1, 1, 2, 0))

>>> m(input)

tensor([[[[0., 0., 1., 2., 2.],

[0., 0., 1., 2., 2.],

[0., 0., 1., 2., 2.],

[3., 3., 4., 5., 5.],

[6., 6., 7., 8., 8.]]]])

nn.ReplicationPad3d

>>> m = nn.ReplicationPad3d(3)

>>> input = torch.randn(16, 3, 8, 320, 480)

>>> output = m(input)

>>> # using different paddings for different sides

>>> m = nn.ReplicationPad3d((3, 3, 6, 6, 1, 1))

>>> output = m(input)

nn.ZeroPad2d

>>> m = nn.ZeroPad2d(2)

>>> input = torch.randn(1, 1, 3, 3)

>>> input

tensor([[[[-0.1678, -0.4418, 1.9466],

[ 0.9604, -0.4219, -0.5241],

[-0.9162, -0.5436, -0.6446]]]])

>>> m(input)

tensor([[[[ 0.0000, 0.0000, 0.0000, 0.0000, 0.0000, 0.0000, 0.0000],

[ 0.0000, 0.0000, 0.0000, 0.0000, 0.0000, 0.0000, 0.0000],

[ 0.0000, 0.0000, -0.1678, -0.4418, 1.9466, 0.0000, 0.0000],

[ 0.0000, 0.0000, 0.9604, -0.4219, -0.5241, 0.0000, 0.0000],

[ 0.0000, 0.0000, -0.9162, -0.5436, -0.6446, 0.0000, 0.0000],

[ 0.0000, 0.0000, 0.0000, 0.0000, 0.0000, 0.0000, 0.0000],

[ 0.0000, 0.0000, 0.0000, 0.0000, 0.0000, 0.0000, 0.0000]]]])

>>> # using different paddings for different sides

>>> m = nn.ZeroPad2d((1, 1, 2, 0))

>>> m(input)

tensor([[[[ 0.0000, 0.0000, 0.0000, 0.0000, 0.0000],

[ 0.0000, 0.0000, 0.0000, 0.0000, 0.0000],

[ 0.0000, -0.1678, -0.4418, 1.9466, 0.0000],

[ 0.0000, 0.9604, -0.4219, -0.5241, 0.0000],

[ 0.0000, -0.9162, -0.5436, -0.6446, 0.0000]]]])

nn.ConstantPad1d

>>> m = nn.ConstantPad1d(2, 3.5)

>>> input = torch.randn(1, 2, 4)

>>> input

tensor([[[-1.0491, -0.7152, -0.0749, 0.8530],

[-1.3287, 1.8966, 0.1466, -0.2771]]])

>>> m(input)

tensor([[[ 3.5000, 3.5000, -1.0491, -0.7152, -0.0749, 0.8530, 3.5000,

3.5000],

[ 3.5000, 3.5000, -1.3287, 1.8966, 0.1466, -0.2771, 3.5000,

3.5000]]])

>>> m = nn.ConstantPad1d(2, 3.5)

>>> input = torch.randn(1, 2, 3)

>>> input

tensor([[[ 1.6616, 1.4523, -1.1255],

[-3.6372, 0.1182, -1.8652]]])

>>> m(input)

tensor([[[ 3.5000, 3.5000, 1.6616, 1.4523, -1.1255, 3.5000, 3.5000],

[ 3.5000, 3.5000, -3.6372, 0.1182, -1.8652, 3.5000, 3.5000]]])

>>> # using different paddings for different sides

>>> m = nn.ConstantPad1d((3, 1), 3.5)

>>> m(input)

tensor([[[ 3.5000, 3.5000, 3.5000, 1.6616, 1.4523, -1.1255, 3.5000],

[ 3.5000, 3.5000, 3.5000, -3.6372, 0.1182, -1.8652, 3.5000]]])

nn.ConstantPad3d

>>> m = nn.ConstantPad3d(3, 3.5)

>>> input = torch.randn(16, 3, 10, 20, 30)

>>> output = m(input)

>>> # using different paddings for different sides

>>> m = nn.ConstantPad3d((3, 3, 6, 6, 0, 1), 3.5)

>>> output = m(input)

2711

2711

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?