1 注意力机制是什么?

- 注意力模型,最近几年在深度学习各个领域都有应用。

- 注意力机制是深度学习常用的一个小技巧,它有多种多样的实现形式,尽管实现方式多样,但是每一种注意力机制的实现的核心都是类似的,就是注意力。

- **核心:让神经网络关注到我们更需要它关注的地方。**关注更核心的部分,抑制其他无用的信息。

2 多输入怎么处理?

- 对于一个属性的输入,普通神经网络可以解决。

- 但是如果这个输入是多维的数据呢?而且输入的序列长度都不确定呢?

3 self-attention的图示

- 如何根据多个输入,得到多个输出

4 自己整理一下self-attention的算法过程

- 目标:从

α

1

\alpha1

α1、

α

2

\alpha2

α2、

α

3

\alpha3

α3、

α

4

\alpha4

α4(这四个是输入)得到

b

1

b^1

b1、

b

2

b^2

b2、

b

3

b^3

b3、

b

4

b^4

b4(这四个是输出)

- 每一个输入都分出q k v 三个值

- 计算 α 1 , 1 ′ \alpha_{1,1}' α1,1′等等

4.

b

1

b_1

b1是

α

1

,

1

′

\alpha_{1,1}'

α1,1′×

v

′

v'

v′等等四个求和得到的

5. 同理计算

b

2

b_2

b2、

b

3

b_3

b3、

b

4

b_4

b4

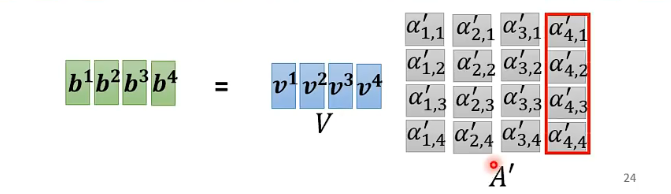

- 下面用矩阵的思想,来并行计算上面的内容。

- 做

softmax不是唯一的,也可以relu

6168

6168

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?