虽然Transformer 论文Attention Is All You Need 为了翻译任务使用了transformer的编码器和解码器部分,但你可以将这些组件拆分开来进行架构的变化。

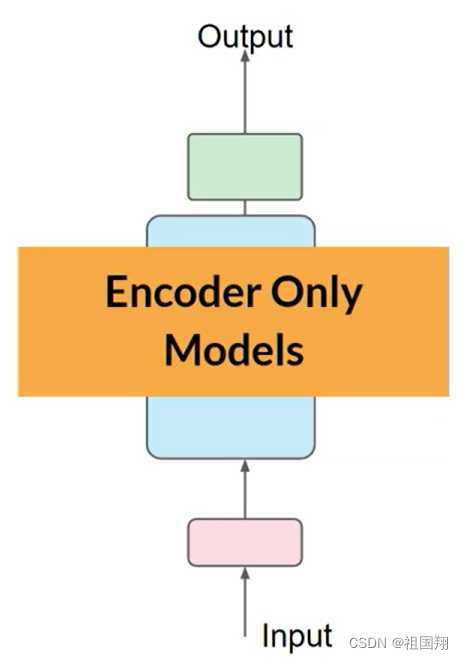

仅有编码器的模型也可以作为序列到序列模型,但如果没有进一步修改,输入序列和输出序列的长度相同。这种用法在今天已经不太常见,但通过向架构添加额外的层,你可以训练仅有编码器的模型来执行情感分析等分类任务,BERT就是一个仅有编码器的模型的例子。下图是仅有编码器的模型的示意图:

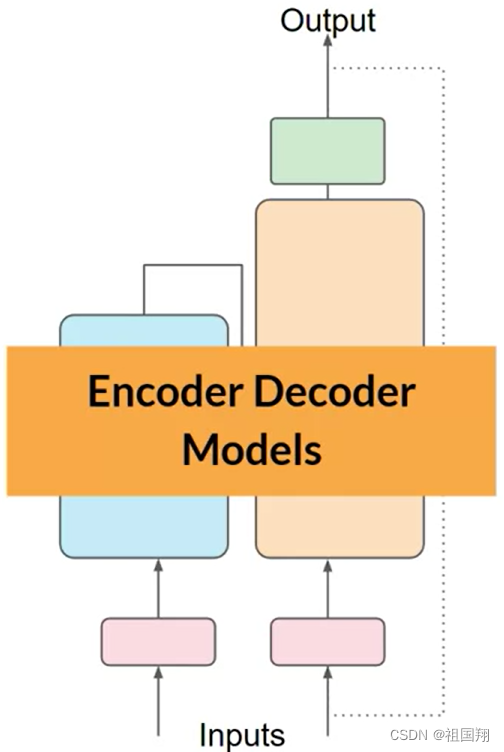

正如你在论文Attention Is All You Need所见,编码器-解码器模型在翻译等序列到序列任务上表现良好,其中输入序列和输出序列的长度可以不同。

你还可以扩展和训练这种类型的模型来执行通用文本生成任务。编码器-解码器模型的例子包括BART和T5。下图是编码器-解码器模型的示意图:

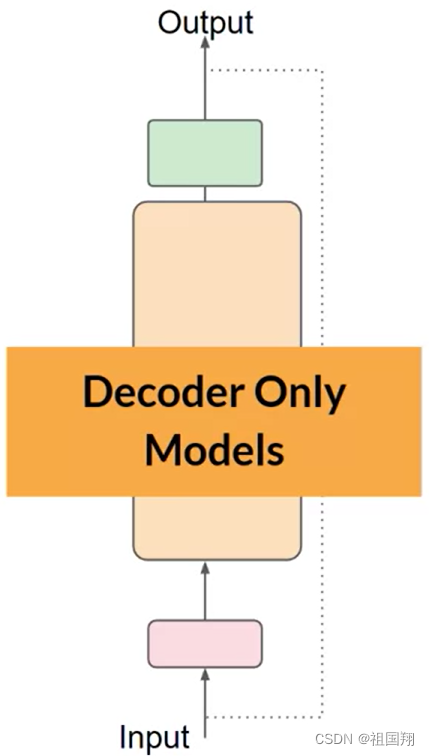

最后,仅有解码器的模型如今是最常用的之一。随着它们的扩展,它们的能力也在不断增强。这些模型现在可以泛化到大多数任务。流行的仅有解码器模型包括GPT系列模型、BLOOM、Jurassic、LLaMA等等。下图是仅有解码器的模型的示意图:

369

369

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?