Jetson nano的使用流程@TOC

Jetson nano的第一次使用

-

Jetson nano介绍

Jetson nano是nvidia自家推出的人工智能嵌入式开发板,它体积小巧、功能强大,性能比树莓派更强,支持英伟达的NVIDIA JetPack组件包,其中包括用于深度学习、计算机视觉、GPU计算、多媒体处理等的板级支持包,CUDA,cuDNN和TensorRT软件库。 支持一系列流行的AI框架和算法,比如TensorFlow,PyTorch,Caffe / Caffe2,Keras,MXNet等,使得开发人员能够简单快速的将AI模型和框架集成到产品中,轻松实现图像识别,目标检测,姿势估计,语义分割,视频增强和智能分析等强大功能。

Jetson nano图示:

-

安装系统

系统下载地址

解压得到的系统安装包,准备进行烧录。

使用windows系统的磁盘管理将SD卡格式化并新建简单卷。

下载烧录工具Win32DiskImager

选择SD卡进行烧录,大概10分钟。

3. 开机设置

参考博客完成简单的系统基本设置。

4. 使用xshell进行连接

开发环境的配置

我们输入

nvcc -V

会发现没有cuda,需要现进行配置。

使用vim打开配置文件

sudo vim ~/.bashrc

在最后加入

export CUDA_HOME=/usr/local/cuda-10.2

export LD_LIBRARY_PATH=/usr/local/cuda-10.2/lib64:$LD_LIBRARY_PATH

export PATH=/usr/local/cuda-10.2/bin:$PATH

然后更新一下

source ~/.bashrc

再输入nvcc -V时会有

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2021 NVIDIA Corporation

Built on Sun_Feb_28_22:34:44_PST_2021

Cuda compilation tools, release 10.2, V10.2.300

Build cuda_10.2_r440.TC440_70.29663091_0

cuda的配置就结束了。

安装pytorch

下载地址

可能因为网络环境问题下载速度很慢。可以去清华源镜像下载地址

使用xftp将下载好的whl文件传输过去,然后按照官网命令进行安装。

在终端依次执行

sudo apt-get install python3-pip libopenblas-base libopenmpi-dev

sudo apt-get install libjpeg-dev zlib1g-dev

pip3 install Cython

sudo pip3 install torch-1.8.0-cp36-cp36m-linux_aarch64.whl

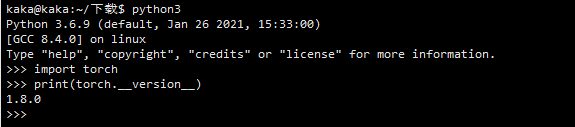

验证

安装torchvision

因为我们的torch是1.8.0的,所以我们需要下0.9.0的torchvision。

git clone -b v0.9.0 https://github.com/pytorch/vision torchvision

# 安装torchvision

cd torchvision

sudo python3 setup.py install

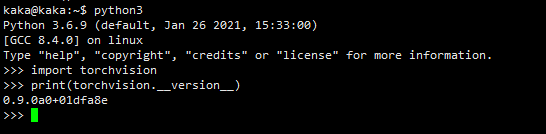

安装过程稍微有点久,最后验证一下

import torchvision

print(torchvision.__version__)

安装jetson-inference

jetson-inference源码在github上,国内环境下载很难成功,去克隆别人gitee上的源码也会卡在

git submodule update --init

这一步,于是我用了一台国外的服务器完成了这一步,然后将整个文件夹下载到本地,再拷贝到板子上进行安装,这里给一下我的百度网盘地址

提取码:8syd

下载这个压缩包并拷贝到板子上,使用

tar -zxvf jetson-inference.tar

完成解压。

然后,

cd jetson-inference/

新建一个build文件夹

mkdir build

进入这个文件夹并cmake(cmake一般自动装好了)

cd build

cmake ../

安装过程中会出现

因为需要国外环境下载,我们将所有带 * 的全部用空格取消掉,这些网络模型可以之后直接去对应网址下载。按确认后会出现

我们已经装好了pytorch,所以这里不用管,直接确认。

cmake完后如下所示

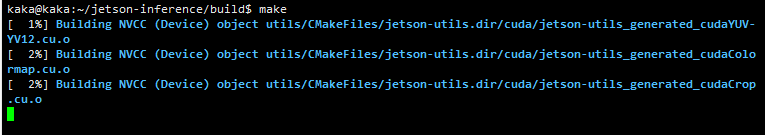

然后输入make,开始编译`

make

过程会比较慢,完成后进行安装

sudo make install

sudo ldconfig

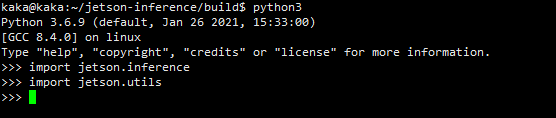

然后测试一下

jetson-inference的安装到这里就结束了,具体的使用说明可以b站和其他博客找资料学习。

参考文献:

【1】https://blog.csdn.net/qianbin3200896/article/details/108949723

【2】https://blog.csdn.net/qianbin3200896/article/details/103760640

【3】https://www.cnblogs.com/vcan123/p/13269218.html

1256

1256

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?