随着OpenAI o1近期的发布,业界讨论o1关联论文最多之一可能是早前这篇斯坦福大学和Notbad AI Inc的研究人员开发的Quiet-STaR,即让AI学会先安静的“思考”再“说话” ,回想自己一年前对于这一领域的思考和探索,当初也将这篇论文进行了引用,现将部分内容以节选回忆的方式再一次分享给大家:

笔记节选自我半年前那篇「融合RL与LLM思想探寻世界模型以迈向AGI」10万字文章,感兴趣完整的小伙伴儿可以访问我的主页置顶或专栏收录

引用原文:↓

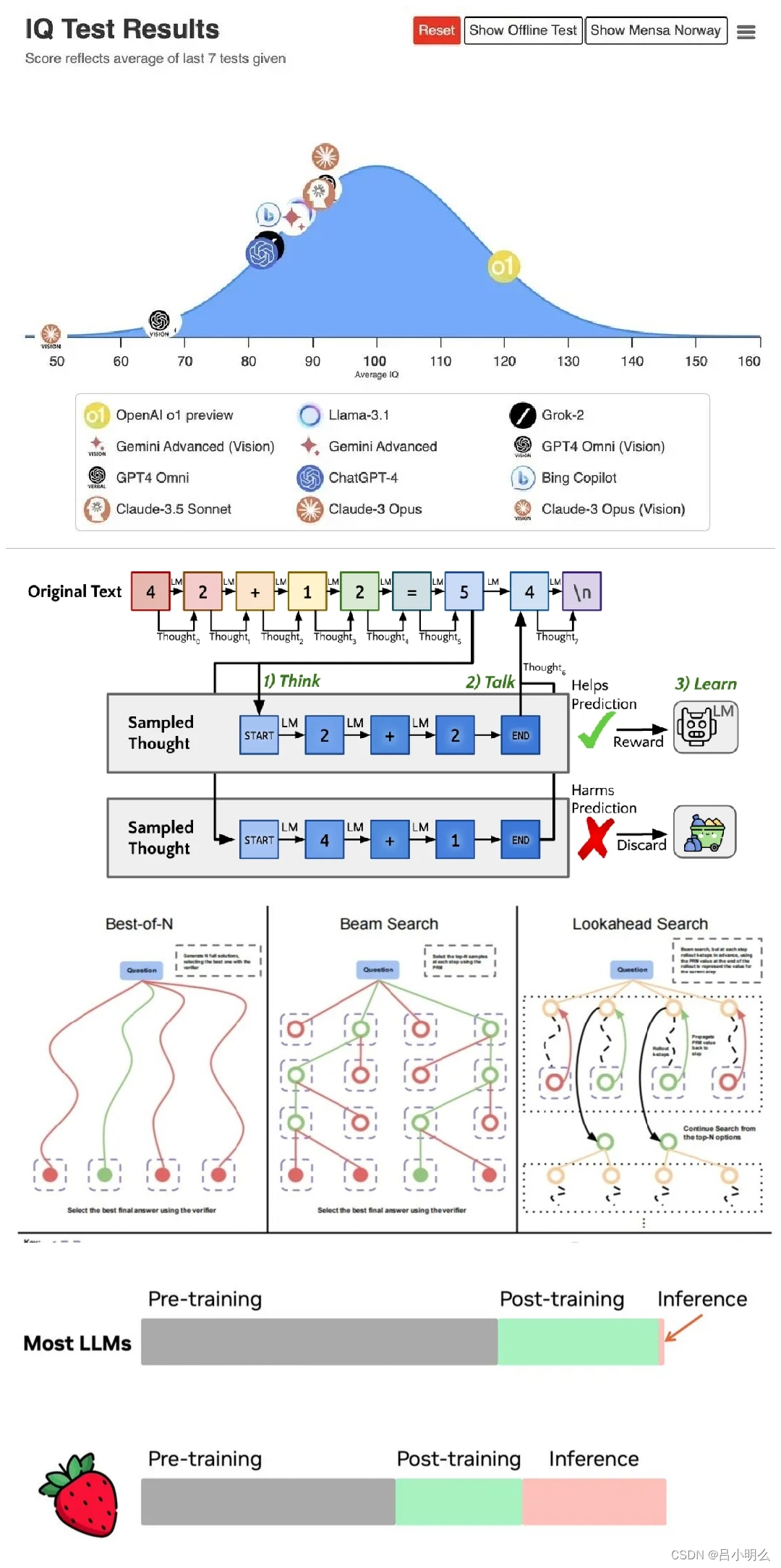

值得注意的是,这篇论文所提出的模型名字非常有意思「Quiet-STaR」,似乎预示着什么..论文中的Quiet-STaR 是以一种通用和可扩展的方式学习推理的语言模型。

与上一篇不同,论文中将更多精力聚焦在推理任务数据上而非E2E模型结构或训练方法上。通过在多样化网络文本中隐含的丰富推理任务的范围上进行训练,而不是狭义地专门为特定数据集进行训练,Quiet-STaR 指引了更健壮和适应性更强的语言模型的方向。论文的结果证明了这种方法的潜力,Quiet-STaR 在提高下游推理性能的同时生成了具有质量意义的理由。论文相信这也开启了许多潜在的未来方向 - 例如,可以尝试对思考进行集成,以进一步提高对未来token的预测。

此外,如果语言模型能够预测何时思考是有用的,例如通过在预测之前放置混合头,那么预测的混合权重可以用于在生成过程中动态分配计算资源。

通常,语言模型可以通过对问答数据集进行采样推理来自行训练其推理能力,即尝试回答问题、在推理导致正确最终答案时对其进行训练,然后重复该过程迭代解决更困难的问题。

然而,从策划的问答数据集进行训练限制了推理的规模和普遍性。问答数据集,尤其是高质量的数据集,需要经过深思熟虑的策划,并且天生只能涵盖一部分推理任务。

从而,论文扩展了STaR - 语言模型不是学习在特定任务(如数学问答)上推理,而是训练语言模型生成推理来帮助它从大型互联网文本语料库推断未来文本。

因此,论文允许语言模型从语言中存在的多样化任务中学习。这建立在当前语言建模范式的一个基本直觉之上,即"语言模型是无监督的多任务学习者"。与STaR一样,论文利用语言模型现有的推理能力来生成理由,并使用基于REINFORCE的奖励对语言模型及其生成的理由进行训练。论文将这种技术称为Quiet-STaR,因为它可以被理解为"悄悄地"应用STaR,训练模型在说话之前思考。

162

162

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?