在上一篇《OpenAI o1:隐含在训练与推理间的动态泛化与流形分布》笔记里尝试剖析OpenAI o1内部机理的过程中我们将目光聚焦在了「模型从训练到推理两个阶段的动态渐进与平衡」之上,并将其等价于对long reasoning chain(长程推理链&步骤)的某种碎片化泛化能力的迭代式探索·explore历程,从而直观上形成了从training from real world data → influence to synthetis data的scaling law的扩展与转移。

在文中结尾处,提出了隐含于long chain reasoning与RL training的两种模型网络信号传播统一视角下的模型泛化动态演进这一内涵。

因此,本篇笔记将试图对这一“内涵”中的模型在训练以及推理传播过程中所体现的“泛化”的特点进行分析与阐释:

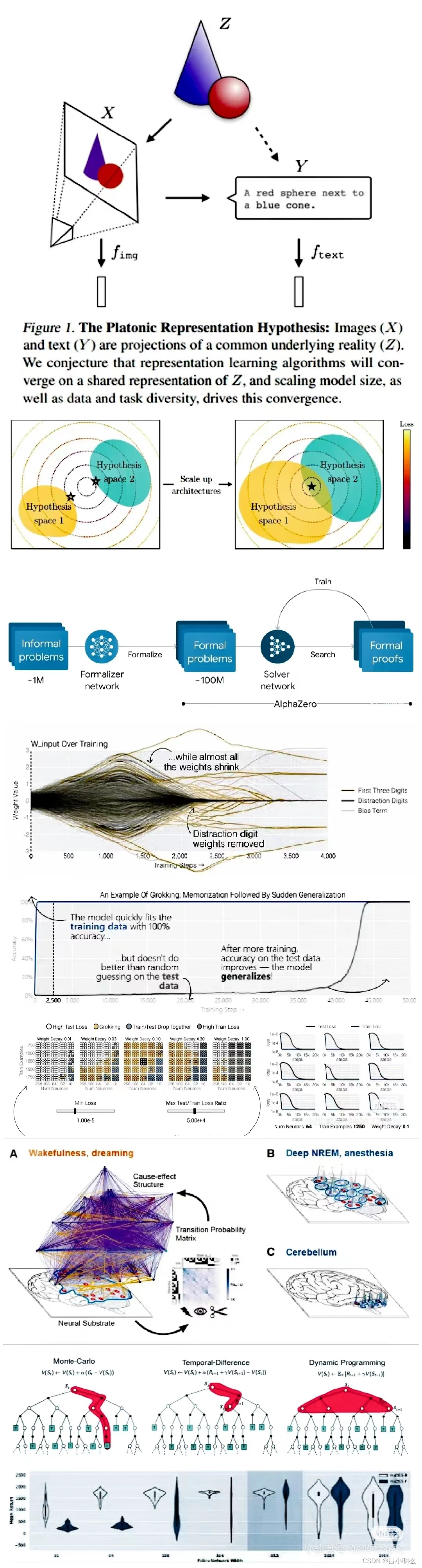

熟悉笔者历史笔记观点或之前读过我于半年前写过的那篇10万字电子书《融合RL与LLM思想,探寻世界模型以迈向AGI·上中下篇》中对于AGI的一种可能的长期技术路径与本质内涵的阐释中,提出构建模型网络隐层e2e信号传播下所实现的system2复杂推理范式,其内涵本质即是需要找到一个完备且通用的e2e训练范式实现对完整long chain reasoning or Cognition流形分布构象的充分泛化与压缩。- 这里的e2e指将全外显性的推理与认知范畴内化为模型隐层中的数学变换(网络传播)。

然而,随着笔者对存在于真实世界与理念世界中各种longchain流形分布的探索下,要实现上述e2e的范式其难度与挑战是极大且多方面的(1-2年内),包含了当前诸如算力与数据下scaling law的局限、真实世界与概念世界下也许趋于无限大的空间尺度及泛化维度、以及self play RL(←终于可以直接这样描述了,半年前还需进一步解释,相信大家也都能深刻理解其思想内涵)范式下对于探索、利用、奖励机制所对应的学习目标在尺度及粒度上的稀疏性和精确性问题与挑战...

这里详细的内容阐释大家可搜索参考我之前的几篇笔记或那篇10万字电子书,对相关内容感兴趣的大伙可参见文章配图或下方目录索引↓

在这样的挑战之下,我想OpenAI有种不得不且直觉上参照拟人类system2思维模式下一种long chain reasoning的“碎片化”泛化探索与利用范式。

这里的泛化性目标聚集在reasoning上;

碎片化粒度则以token或先验定义下的step为标记;

RL过程的采样则涵盖多任务下所对应的多个子探索(推理)步骤…

相关历史文章或笔记参考:

2024.09.09 | 牛津大学:自动发现跨领域高阶抽象泛化框架

2024.09.05 | 大模型→世界模型下的「认知流形」本质·上

2024.09.05 | 大模型×认知科学:多维潜空间洞悉复杂认知

2024.09.04 | RL+LLM下新的Scaling Law与挑战

2024.08.29 | Thinking·快与慢的统一认知框架探索 上篇

2024.08.28 | 慢思考复杂推理下AR与Diffusion的融合统一

2024.08.26 | Meta的Transfusion:自回归与扩散的融合

2024.08.24 | 来自DeepSeek:形式化证明体系的RL框架

2024.08.23 | 微软亚研院&哈佛:同行评议互一致的rStar

2024.08.22 | KAN2.0来了:符号+连接双驱动下的AI4S

2024.08.21 | 全华班LLM战队:图灵完备的RAG堆栈框架

2024.08.19 | 来自Bengio:高级认知下深度学习归纳偏差

2024.08.18 | MIT:LLM对现实语义空间的抽象表征

2024.08.16 | Think | AI探索过程潜在的overfitting

2024.08.13 | Think | AGI的探索(Axplore)与对齐(Align)

2024.08.12 | 关于「认知」Cognition

2024.08.11 | 有关「推理」Reasoning

2024.08.10 | 有关「泛化」Generalization

2024.08.09 | 关于「表征」 Representation

2024.08.06 | 来自Meta:LLM数学隐推理过程验证与阐释

2024.08.05 | 隐藏在复杂信息结构中的泛化性与K氏复杂度

2024.07.31 | 自回归(AR)与扩散(Diffusion)的邂逅

2024.07.27 | 形式化的启示 | 谷歌的AlphaProof

2024.07.26 | OAI的Rule-Based Rewards,RBR

2024.07.25 | Llama3.1浅炼

2024.07.24 | Q*s' AGI

2024.07.16 | GraphRAG → 必然桥梁 or 过渡折中?

2024.07.16 | 唠两句kimi底层推理的全局存算分离调度策略

2024.07.16 | 来自MIT的大脑认知与语言符号表的最新观点

2024.07.16 | 基于语义熵的幻觉检测

797

797

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?