事件相机仿真器模拟事件相机,生成事件数据供不同任务使用。本文简介一款仿真器v2e。

Before v2e

在v2e出现之前,也出现过不少仿真器,从uzh的repo上可以找到:https://github.com/uzh-rpg/event-based_vision_resources#datasets。

比较出名的一个是2017年的Event Camera Dataset[1]附带的仿真器,其根据最基本的事件生成模型进行仿真。

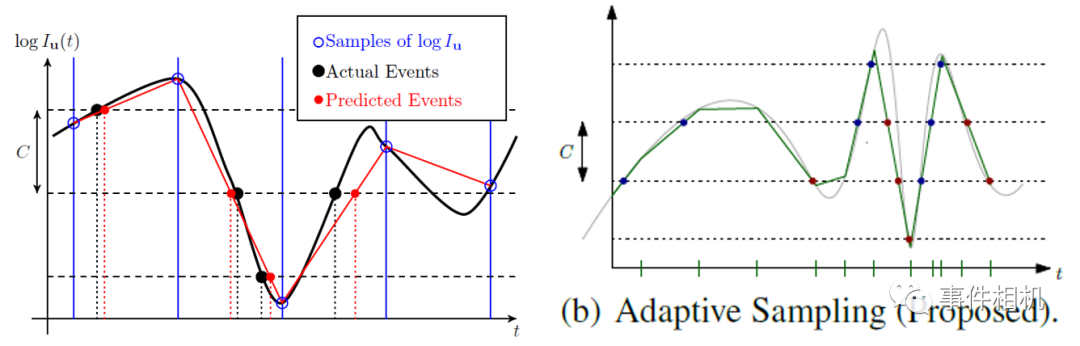

另一个是ESIM[2],相对于之前的仿真能力强大,仿真技术上的一项改进是将均匀采样改变了自适应采样,使光强变化更快的时候时间采样率更高。见下图右。

左图:[1]的采样原理;[2]ESIM的自适应采样

同时,ESIM由于可以自行设置图片或3D场景进行自定义的相机运动,可以获取包括普通图像、深度图等信息在内的数据,广泛的应用于SLAM、光流估计等任务。可以在ROS运行,使用较为方便。

图:ESIM配置后的和运行结果

About v2e

最后出现了本文的重点v2e[3]。在ESIM和vid2e中,生成机制是事件生成模型,考虑了噪声和对比度阈值的影响,但与实际具有较大差距。v2e相比于前者,增加了更多的功能:暗光仿真、运动模糊、时间延迟等。(以下内容来自本人之前的博客,直接进行了搬运。博客连接点击文末“获取原文”)

v2e的安装与使用(windows)

v2e的完整安装可参考github的repo:https://github.com/SensorsINI/v2e/

本人在windows11 RTX3050笔记本上进行了安装测试,进行整理如下:

1. 安装环境

首先需要安装v2e的运行环境,推荐采用conda安装python3.9的虚拟环境。windows下安装anaconda推荐一个教程:https://zhuanlan.zhihu.com/p/61639212;

之后官方说需要有GPU和CUDA加速,我不清楚没有GPU是否可以,但我觉得哪怕可以仿真也会非常慢,不能忍受,所以还是需要有GPU;

最后安装v2e依赖项:下载v2e后采用pip进行安装依赖项。

2. 数据准备

v2e采用SuperSloMo网络首先对原始视频进行慢放,所以需要下载SuperSloMo的模型,并创建一个input路径将模型放在input路径下备用;

之后需要放待仿真的数据,v2e可以对视频进行仿真,也可以对一组图片进行仿真,只需要给定的是视频文件路径或图片文件夹路径即可自动选择。

3. 运行与参数选择

v2e的参数极其多,毕竟仿真的功能很多,包括DVS的参数(时间戳/像素分辨率、噪声水平、对比度阈值、截止频率等)、SuperSloMo的参数、输入输出参数(可以输出视频、文本、hdf5、aedat等多种格式)等,详见v2e的repo。

4. 使用感受:

v2e的内容虽然非常复杂,但是使用起来较为简单,只需要按照文档把参数设置好就可,而且如果遇到错误在运行时给出的报错信息也非常完整,基本可以根据报错信息快速定位问题原因并解决。

后记

我配置过ESIM和v2e,感觉v2e虽然功能复杂,但使用起来更为方便,开发的较为完善,而ESIM配置过程中印象里踩了不少的坑。v2e的另一个好处就是可以windows下使用,对ubuntu和ros不熟悉的朋友更加友好。当然,最重要的是,v2e的仿真更加科学、真实。所以如果有仿真需求的朋友,可以考虑直接用v2e。

参考文献:

1. E. Mueggler, H. Rebecq, G. Gallego, T. Delbruck, D. Scaramuzza, The Event-Camera Dataset and Simulator: Event-based Data for Pose Estimation, Visual Odometry, and SLAM, Int. J. Robotics Research, 36:2, pp. 142-149, 2017.

2. H. Rebecq, D. Gehrig, D. Scaramuzza, ESIM: an Open Event Camera Simulator, Conf. on Robot Learning (CoRL), 2018.

3. Hu, Y., S.-C., Liu, Delbruck, T., v2e: From Video Frames to Realistic DVS Events, IEEE Conf. Computer Vision and Pattern Recognition Workshops (CVPRW), 2021.

v2e是一款强大的事件相机仿真器,相较于之前的工具如EventCameraDataset和ESIM,它提供了更丰富的功能,包括暗光仿真、运动模糊和时间延迟等。该软件能够生成更接近实际的事件数据,适用于多种任务。安装和使用v2e相对简便,支持Windows环境,并且提供了详尽的错误信息以帮助用户解决问题。对于需要进行事件相机数据仿真的研究者而言,v2e是一个理想的选择。

v2e是一款强大的事件相机仿真器,相较于之前的工具如EventCameraDataset和ESIM,它提供了更丰富的功能,包括暗光仿真、运动模糊和时间延迟等。该软件能够生成更接近实际的事件数据,适用于多种任务。安装和使用v2e相对简便,支持Windows环境,并且提供了详尽的错误信息以帮助用户解决问题。对于需要进行事件相机数据仿真的研究者而言,v2e是一个理想的选择。

246

246

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?