大家好,我是微学AI,今天给大家介绍一下方差损失函数的概念:

方差损失函数是指计算模型在训练集上的表现和在测试集上的表现之间的差异。它衡量着模型的拟合能力,也可以用来衡量模型的泛化能力。方差损失函数可以帮助我们找到最优模型,从而提高模型的泛化能力。

方差损失函数也是一种常见的回归损失函数,它的原理是,用算法预测出的值减去真实值,然后计算这些差值的方差,该方差越高,意味着算法的预测准确度越低。因此,当算法优化时,我们可以优化方差损失函数,从而提高预测准确率。

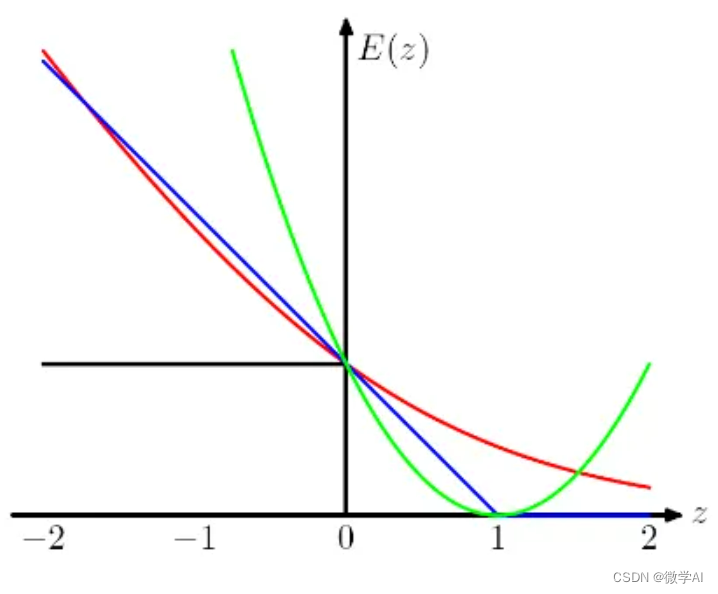

损失函数一般有方差损失函数,绝对值损失函数,交叉熵损失函数,方差损失函数将模型预测值与真实值之间的误差衡量为两者之间的方差,因此可以表示模型预测能力的稳定性,常用于回归问题。 而绝对值损失函数,其实质是将模型预测值与真实值之间的误差衡量为两者之间的绝对值,在计算过程中不方便,交叉熵损失函数一般用于分类问题,对于回归问题我们更倾向于选择方差损失函数。

方差损失函数可以用来描述一个组合的偏离度,从而估计模型的不确定性。比如说,一家公司有三个部门,A、B和C,他们的收入分别是100万、200万和300万。公司的总收入是600万,每个部门平均200万收入,我们可以用方差损失函数来计算各部门收入的偏离度:

可以看出,总收入为600万的情况下,各部门收入的偏离度为200,000。这里,方差损失函数可以用来衡量各部门收入的不确定性,从而帮助我们更好地评估模型的表现。

1.方差损失函数是数学表达:

假设有一个回归问题,其中有三个自变量和一个响应变量

。将此问题表示为均方差损失函数时,可以使用以下函数:

其中,

是待估计的参数,用于表示

与每个自变量之间的关系。要估计这些参数,可以使用最小二乘法,以使最小化均方差损失函数。

2.最小二乘法的数学证明:

最小二乘法是一种数据拟合方法,用于拟合一条直线或多项式曲线到一组数据点。它将曲线拟合到数据点,使得所有点到拟合曲线的距离的平方和最小。

举个例子,假设我们有一组数据点,每个点表示成坐标,如

,我们可以用最小二乘法来拟合一条直线到这些点。直线的方程是

,其中

和

是需要求解的未知参数。根据最小二乘法,我们需要最小化的是所有点到拟合直线的距离的平方和, 即:

其中是数据点的个数,

是第

个数据点的

坐标,

是第

个数据点的

坐标。 对上面的公式求导,得到:

将上面两个式子设置为0,得到:

从上面的两个式子可以得到a和b的值:

可得

根据上面的公式,当时,

,所以最终的直线方程为:

。这个结果正是我们预期的,说明最小二乘法拟合的结果是正确的。

下面是 方差损失函数与 交叉熵损失函数的python代码样例:

# 引入库

import numpy as np

# 定义均方差损失函数

def loss_mse(y_true, y_pred):

mse_loss = np.mean(np.power(y_true - y_pred, 2))

return mse_loss

# 构造 y_true 和 y_pred

y_true = np.array([1,2,3,4,5])

y_pred = np.array([1.5, 2, 3, 4.5, 5])

# 计算和输出均方差损失函数

mse_loss = loss_mse(y_true, y_pred)

print('均方差损失函数:', mse_loss)

# 定义交叉熵损失函数

def loss_ce(y_true, y_pred):

# 计算真实标签与预测标签之间的交叉熵

ce_loss = -np.mean(np.sum(np.multiply(y_true, np.log(y_pred)), axis=1))

return ce_loss

# 构造 y_true 和 y_pred

y_true = np.array([[0, 1, 0], [1, 0, 0], [0, 0, 1]])

y_pred = np.array([[0.6, 0.2, 0.2], [0.2, 0.3, 0.5], [0.3, 0.3, 0.4]])

# 计算和输出交叉熵损失函数

ce_loss = loss_ce(y_true, y_pred)

print('交叉熵损失函数:',ce_loss)更多细节,可私信咨询,获取更多源码教程

往期作品:

一、人工智能基础部分

7.人工智能基础部分7-高维空间的神经网络认识

9.人工智能基础部分9-深度学习深入了解

10.人工智能基础部分10-卷积神经网络初步认识

11.人工智能基础部分11-图像识别实战

12.人工智能基础部分12-循环神经网络初步认识

13.人工智能基础部分13-LSTM网络:自然语言处理实践

1618

1618

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?