学习网址:https://www.bilibili.com/video/BV1We4y1w7Us?p=3&vd_source=11b7b2a48a6540147996012cfff314e8

第一节P1:深度强化学习中用到的基本概念

P2:关于DQN的输入及输出,以及详细的讲了其更新Q的原理及过程。

P3:策略函数π【是一个概率密度函数,所有结果值加和为1】

策略函数与Q都是深度强化学习对未来预测的途径,知道其一即可解决问题。不同点在于,Q*是只与当前S与A有关的,它针对某一时刻的S,对该时刻可以进行的动作A打分,机器选择得分高的动作以继续游戏。而策略函数是对该时刻S可进行的动作A计算出概率,然后机器进行一次随机抽样以继续进行游戏。

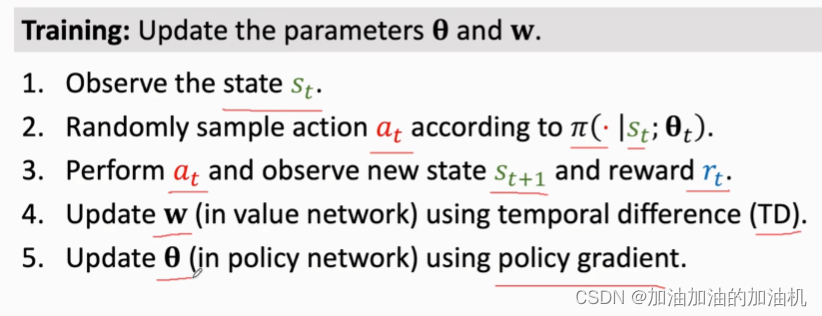

P4:更新过程如下,用TD更新w,以此来改进Qπ(价值网络)。用w来更新θ,以此来改进π(策略网络)。

P5:强化学习有奖励,而模仿学习(如limitation learning)没有奖励,其训练的目的是模仿行为。

Behavior cloning 是一种limitation learning,是一种分类或回归方法,而不是强化学习方法

P6:蒙特卡洛算法-一种近似求解的算法

P7:Sarsa算法-TD算法的一种

P8:Q-learning -也是一种TD算法,Sarsa是用来训练Qπ

Q-learning 是用来训练Q*

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?