背景

据社交媒体研究机构Shareablee统计的数据显示,近期社交媒体已经超过网络搜索,成为人们消遣和了解疫情的首要渠道。

作为数据分析小白,为了初探疫情下的媒体们在社交平台上的报道重心,我从Shareablee.com下载了从2020年1月至3月Facebook上媒体行业的po文记录,并做了一次简单的词云分析。想通过这样一个实际场景,带大家领略一下词云的有趣之处。

词云的定义

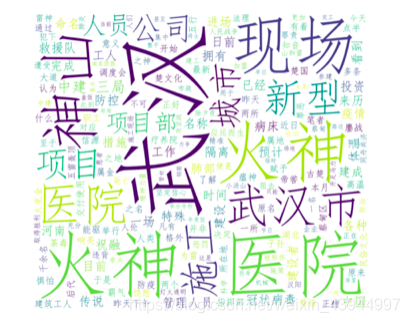

关键词云是对海量文字内容中出现频率较高的“关键词”的视觉突出。对新闻媒体行业而言,关键词字体越大,其被使用的频率越高,越能凸显当前的热点趋势。(示例图如下,摘自icode9.com)

从示例图中,我们不难看出被频繁使用的关键字能迅速内向读者传达人们所讨论的热点话题。

在接下来的实例中,我所用到的数据并非TXT文件,而是Excel文档中的其中一列,所以相较于常规的分词方法有所不同的是,我们需要遍历整个列来进行分词。我会在词云构建的流程中,对该部分进行详细的讲解。

词云的创建

词云构建流程图:

- 获取待分析文件

1.1 导入所需的包

import pandas as pd

import numpy as np

import warnings

from PIL import Image

import matplotlib.pyplot as plt

from wordcloud import WordCloud, ImageColorGenerator #创建词云用到的包

warnings.filterwarnings('ignore'

本文作者利用Python分析2020年1月至3月Facebook上媒体行业的帖子,通过词云展示疫情下媒体的讨论热点。关键词云强调高频率词汇,反映出当时的热点话题。数据来源于Shareablee,涉及数据清洗、分词和词云创建过程,展示了如何从Excel文件中提取内容并创建词云。

本文作者利用Python分析2020年1月至3月Facebook上媒体行业的帖子,通过词云展示疫情下媒体的讨论热点。关键词云强调高频率词汇,反映出当时的热点话题。数据来源于Shareablee,涉及数据清洗、分词和词云创建过程,展示了如何从Excel文件中提取内容并创建词云。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4603

4603

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?