FastText是一个文本分类和词向量训练工具,相比于传统的神经网络(DNN)最大的特点就是模型简单,只有一层隐藏层和输出层;结构上与Word2Vec中的CBOW基本类似;所以如果想要深入理解FastText,那么理解Word2Vec中的CBOW是必须的,具体可以参考我的另外一篇介绍Word2Vec的博客:https://blog.csdn.net/weixin_44305115/article/details/100545538

下面我们来看一下FastText与Word2Vec中的CBOW的主要区别,主要有两点:

1,CBOW中输出的是词的置信度,也就是中心词属于词汇表每个词的概率,而FastText输出的是文章所属的类别(label)。一个是无监督的学习,一个是有监督的学习。

2,CBOW中输入的是当前窗口除中心词外的所有单词(实际上是单词的词嵌入向量,也就是word embedding,下同),而FastText中由于输出的是文章所属的类别,所以输入就必须是整个文章的全部单词。

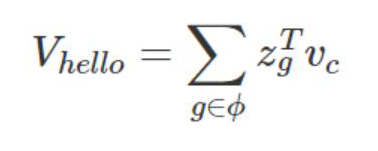

值得注意的是,这里所说的文章全部单词是广义的。什么意思呢,在FastText中,增加了subwords特性,也就是增加了一个词的字符级N-gram。比如单词‘hello’,长度至少为3的字符级N-gram有‘hel’,‘ell’,‘llo’,‘hell’,‘ello’和’hello’,可以认为这几个字符组合在一起表示一个单词。每个n-gram都可以使用一个dense的向量zg表示,故最终一个单词可以表示为:

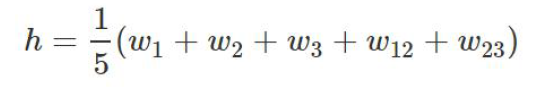

除了字符级的N-gram,FastText孩增加了词级别的N-gram,主要是为了通过增加N-gram的特征信息来保留词序信息,比如:某篇文档有3个词,w1、w2、w3,N-gram取N为2,w1,w2、w3以及bigram w12、w23是新的词嵌入向量,那么文章的隐层表示为:

综上,FastText所谓的文章中的所有单词除了单词本身外,还添加了字符级的N-gram或者词级别的N-gram,其实非常类似于inception结构

FastText与CBOW的联系与区别

最新推荐文章于 2022-11-16 21:30:47 发布

407

407

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?