DocReLM: Mastering Document Retrieval with Language Model

DocReLM:利用语言模型掌握文档检索技术

(本文要做的是一个论文信息检索系统,其实就是自己训练了一个检索器和重排器,在加入了一个额外的参考文献)

paper: https://arxiv.org/pdf/2405.11461

github:

文章目录

1.背景动机

介绍现有论文检索系统的问题-1.理解上下文;2.理解参考文献;3.理解查询意图:

对基于语义的高效文档检索系统的需求日益增长。然而,这样系统面临着巨大的挑战:

- 首先,需要学术论文深入理解上下文才能提取相关信息(专业化的语言和特定领域的知识)。

- 其次,要求系统了解论文中参考文献之间的相互联系。

- 最后,用户可能没有精确的关键词来描述他们的信息需求,这就要求系统理解用户的意图,并据此提供最相关的论文。

引出本文提出的学术论文检索方法:

本研究介绍了 DocReLM,这是一个利用语言模型增强的文档检索系统,在 DocReLM 中,LLM 有两种不同的使用方式:

-

首先,它充当自动数据注释器,生成高质量的训练数据以增强检索模型。

-

随后,LLM 充当搜索代理,根据检索文档中的文本信息和参考文献关系完善论文选择。

DocReLM 基本上可以分为三个部分。前两个部分是检索器和重排器。这两个模型可以根据与用户查询的相关性对文档进行过滤和排序。第三个模型是参考文献提取器,它可以读取检索到的文档,并找到能更好地回答问题的参考文献 ID。然后将提取的参考文献添加到最终文档列表中。

2.Model

整体架构:1.检索器,2.重排器,3.参考文献提取器:

该系统由三个主要组件组成:检索器、重排器和参考文献提取器。

当用户提出查询时,检索器组件利用嵌入技术从语料库中快速检索候选文章。随后,再使用重选器对这些文章进行更精确的分类。最后一个组件会检查重排器提供的前 $k$ 结果的内容,并根据这些文章的内容生成适当的参考文献。

2.1.检索器

密集检索器—词嵌入模型—jina-embedding-v2-base :

密集嵌入模型明确地将句子编码成密集向量,利用余弦相似度来评估查询和段落嵌入之间匹配的可能性。

在 DocReLM 中,利用开源的 jina-embedding-v2-base 作为基础模型,然后利用自定义数据对其进行进一步训练。通过对比学习,密集检索器可以生成强调关键段落细节的嵌入,从而将语义相似的句子连接起来,即使这些句子使用了不同的术语。

密集检索器具体使用方法(缺乏领域知识,也就是query与内容并不是对齐的):

然而,预训练的嵌入模型缺乏针对文档检索任务的特异性,往往与特定领域的论文存在领域知识差距。为了解决这个问题,加入了一个大型语言模型,利用学术论文语料库自动注释伪查询,从而完善嵌入模型。在文档语料库中,将长文档分割成段落,并将其转换为嵌入向量。这些向量存储在向量数据库中。当用户输入查询时,根据文档和查询嵌入之间的余弦距离来选择候选文章。

2.2.重排器

重排器的优缺点:

在快速检索过程之后,会使用重排器来提高结果的精确度。与检索器相比,重排器虽然总体上更精确,但运行速度较慢。

使用的重排器流程—XLM-RoBERTa-large:

在这项任务中,使用交叉编码器来处理由查询字符串和来自检索的候选文章的连接序列组成的输入,并以[SEP]标记为界。重排器采用注意力机制来分析输入,从而为整个输入序列合成一个综合特征。随后,线性层将这一特征转化为标量值,表示给定段落正确回答查询的可能性。

在 DocReLM 中,使用开源模型 XLM-RoBERTa-large作为基础模型,并使用自定义数据作为 LCE 方法对其进行进一步训练。由 Retriever 确定的前 200 个段落随后被输入到 reranker 中,以输出每个连接对的得分。这些候选段落随后会根据各自的得分重新排序。

2.3.参考文献提取器

参考文献提取器**,它读取文章内容并提取文章中引用的最佳参考文献。**由 retriever 和 reranker 选出的论文可能不是回答查询的最佳论文,但参考文献列表有很大可能包含该论文。

基于这一目标,方法是指示大语言模型提取检索结果,并从参考文献中找出更合适的论文。为此,通过在文本中插入参考文献的标识符来处理论文段落。当大语言模型(LLM)处理这个修改过的段落时,它会根据上下文信息提取这些标识符。如果大语言模型确定文段本身就是答案,它就会输出参考文献的标识符。随后,系统会搜索与提供的标识符相关的论文。

(就是每个参考文献对应一个段落,如果相关,就根据段落的父节点,找到文献)

2.4.训练数据集构造

要利用对比学习训练检索器和重排器,需要收集用户查询和文章。

在这项工作中,使用大语言模型(LLM)从文档中生成伪查询。使用 unarXive中的论文创建数据集,处理其原始数据以删除语义无关的文本,并纳入数学 LaTeX 和参考文献标识符。这些标识符的格式为 IDF 的 Ref.X,其中 IDF 是母论文的标识符。将整篇论文分为若干段落,并使用 vicuna-7b-v1.5-16k,通过提供段落、标题和摘要为每个句子生成一个查询。受思维链方法的启发,在生成查询之前,我们首先采用zero-shot法引导 LLM 根据标题、摘要和内容创建大纲。

2.5.对比学习

采用常见的对比学习策略来训练检索器和重排器。有多对查询和段落,其中同一对中的查询 Q Q Q 和段落 P P P 被标记为正面,而不同对中的查询 Q Q Q 和段落 P P P 被标记为负面。对比学习可以看作是对这些对子进行训练的二元分类器。对于每个正对 ( Q i , P i ) (Q_{i},P_{i}) (Qi,Pi),采样 N N N 负对 ( Q i , P i , n ) (Q_{i},P_{i,n}) (Qi,Pi,n),

2.6.针对检索器和重排器的负样本对的生成方式

对于 retriever,这些负数据是随机抽样的。在每个训练批次中,都会抽取 N + 1 N+1 N+1 个正数据对,每个正数据对都有 N N N 个负数据对。使用梯度缓存技术来增加批量大小,以提高对比学习的性能。

对于reranker,用训练好的检索器选择负数据。对于每个查询 Q i Q_{i} Qi,检索器会返回得分最高的 N N N 段落。这些段落与查询高度相关。这意味着除了正确的段落外,还利用了最容易混淆的错误段落。因此,这些错误段落被用作训练reranker的高质量硬负样本。

3.原文阅读

Abstract

已发表的学术论文超过 2 亿篇,而且每年都有数百万篇新论文问世,因此学术研究人员面临着在这一庞大语料库中搜索信息的挑战。然而,现有的检索系统很难理解学术论文中的语义和领域知识。在这项工作中,我们证明了通过利用大型语言模型,文档检索系统可以实现先进的语义理解能力,显著超越现有系统。我们的方法包括:

- 使用大型语言模型生成的特定领域数据来训练检索器和重排器。

- 此外,我们还利用大型语言模型从检索论文的参考文献中识别候选词,以进一步提高性能。

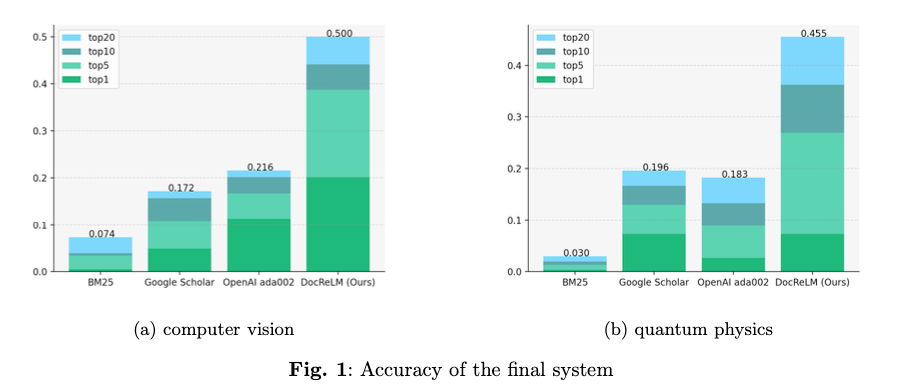

我们使用量子物理和计算机视觉领域的学术研究人员注释的测试集来评估我们系统的性能。结果显示,DocReLM 在计算机视觉领域的准确率达到了 44.12%,而谷歌学术的准确率为 15.69%;在量子物理领域,DocReLM 的准确率提高到了 36.21%,而谷歌学术的准确率为 12.96%。

1 Introduction

介绍现有论文检索系统的问题-1.理解上下文;2.理解参考文献;3.理解查询意图:

根据 Crossref 的数据,学术领域包含超过 1.4 亿篇学术文献,每年发表的新论文数以百万计。这种指数级的增长使研究人员越来越难以跟上各自领域的最新发展。因此,对基于语义的高效文档检索系统的需求日益增长。然而,开发这样的系统面临着巨大的挑战。

- 首先,学术论文是用高度专业化的语言和特定领域的知识撰写的,需要深入理解上下文才能提取相关信息。

- 其次,理解一篇论文不仅要阅读其内容,还要理解参考文献及其关系。这就要求系统了解论文中参考文献之间的相互联系。

- 最后,用户可能没有精确的关键词来描述他们的信息需求,这就要求系统理解用户的意图,并据此提供最相关的论文。

尽管人们已经尝试创建一个具有通用嵌入模型的文档检索系统,但模型的训练任务与实际检索之间仍有差距。因此性能并不理想。

引出本文提出的学术论文检索方法:

在本研究中,我们介绍了 DocReLM,这是一个利用语言模型增强的文档检索系统,旨在解决这些难题。语言模型是目前自然语言处理领域最突出的重点领域之一,在理解复杂语言结构方面表现出强大的能力。它们在各个领域的应用显示出不断的进步。在 DocReLM 中,LLM 有两种不同的使用方式。

-

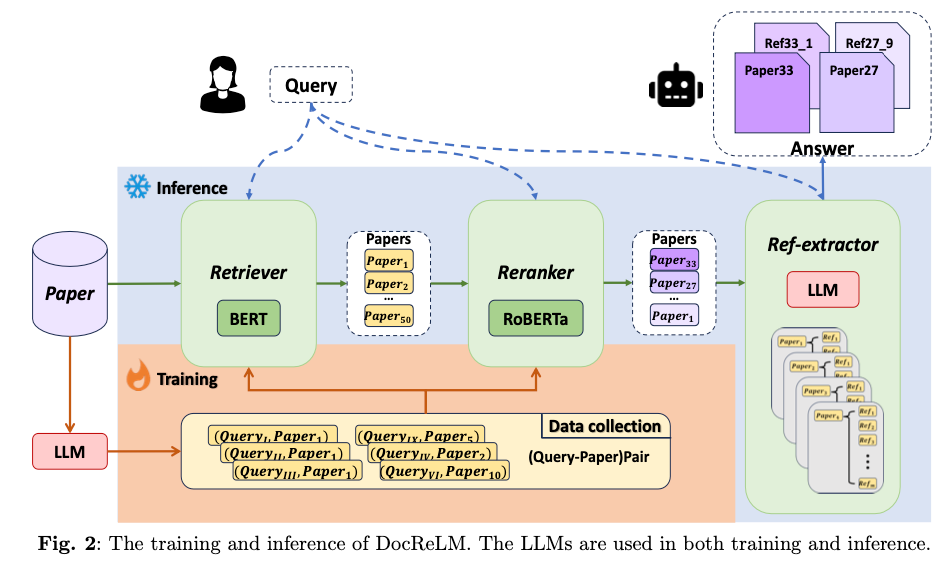

首先,它充当自动数据注释器,生成高质量的训练数据以增强检索模型。如图 2 所示,这使得我们的密集检索器和重排器模型的性能优于其他竞争者。通过使用 LLM 生成的数据进行训练,我们的模型适应了文档检索任务。在这个过程中,领域专业知识也被提炼到了模型中。

-

随后,LLM 充当搜索代理,根据检索文档中的文本信息和参考文献关系完善论文选择。这一过程类似于人类的推理过程,即用户通过阅读论文中的参考文献来找到最相关的参考文献。LLM 能够理解上下文和参考文献之间的关系,因此能够识别出最相关的论文,从而提高系统的性能。我们发现这在自然科学领域尤其有用,因为该领域的论文之间相互关联度很高,而理解参考文献对于识别相关论文至关重要。这也是在检索系统中实现大语言模型的一种新方法。

DocReLM 的整个系统如图 2 所示。DocReLM 基本上可以分为三个部分。前两个部分是检索器和重排器。这两个模型可以根据与用户查询的相关性对文档进行过滤和排序。第三个模型是参考文献提取器,它可以读取检索到的文档,并找到能更好地回答问题的参考文献 ID。然后将提取的参考文献添加到最终文档列表中。

为了评估 DocReLM,我们建立了一个语义文档检索基准,并与几个竞争对手进行了比较。该基准分为两个不同的轨道:量子物理学和计算机视觉。每个轨道都包含一组经过整理的文章和一系列问题,每个问题都有一个由学术研究人员标注的标准答案。在我们的实验中,DocReLM 与其竞争对手相比优势明显,在计算机视觉和量子物理领域的前 5 个结果中,DocReLM 的准确率分别达到了 38.73% 和 26.91%。完整结果如 1 所示。这凸显了该系统彻底改变学术研究中文档检索的潜力。

2 System Architecture

介绍DocReLM的整体的架构:1.检索器,2.重排器,3.参考文献提取器:

训练和推断 DocReLM 的工作流程如图 2 所示。该系统由三个主要组件组成:检索器、重排器和参考文献提取器。当用户提出查询时,检索器组件利用嵌入技术从语料库中快速检索候选文章。随后,再使用重选器对这些文章进行更精确的分类。最后一个组件会检查重排器提供的前 $k$ 结果的内容,并根据这些文章的内容生成适当的参考文献。在下面的小节中,我们将详细介绍模型中每个组件的复杂结构,以及我们如何利用大型语言模型来构建这些组件。

2.1.Retriever

介绍组件—检索器:

检索器的设计目的是从庞大的语料库中有效地提取一组精选文档。它需要快速有效的检索能力。为此,通常采用两种模型:稀疏检索器和密集检索器。

稀疏检索器—词袋模型,tf-idf,bm25等:

稀疏检索器,如著名的 BM25,利用词袋向量来匹配候选词。

密集检索器—词嵌入模型:

相反,密集嵌入模型明确地将句子编码成密集向量,利用余弦相似度来评估查询和段落嵌入之间匹配的可能性。在 DocReLM 中,我们采用了神经密集检索器,并利用开源的 jina-embedding-v2-base 作为基础模型,然后利用我们的自定义数据对其进行进一步训练。该检索器作为编码器模型运行。编码器已被应用于科学领域的各种任务。通过对比学习,密集检索器可以生成强调关键段落细节的嵌入,从而将语义相似的句子连接起来,即使这些句子使用了不同的术语。然而,预训练的嵌入模型缺乏针对文档检索任务的特异性,往往与特定领域的论文存在领域知识差距。

密集检索器具体使用方法:

为了解决这个问题,我们加入了一个大型语言模型,利用学术论文语料库自动注释伪查询,从而完善嵌入模型,使其更符合我们的任务。在使用量身定制的嵌入模型构建检索系统时,我们会处理文档语料库,将长文档分割成段落,并将其转换为嵌入向量。这些向量存储在向量数据库中。当用户输入查询时,DocReLM会采用相同的检索模型来推导查询的语义嵌入,并根据文档和查询嵌入之间的余弦距离来选择候选文章。

2.2.Reranker

重排器:

在快速检索过程之后,会使用重排器来提高结果的精确度。与检索器相比,重排器虽然总体上更精确,但运行速度较慢。这一特点是其典型的检索后使用方式,即检索器通过剔除大部分不相关的文章来有效缩小选择范围。在这项任务中,我们使用交叉编码器来处理由查询字符串和来自检索子系统的候选文章的连接序列组成的输入,并以[SEP]标记为界。重排器采用注意力机制来分析输入,从而为整个输入序列合成一个综合特征。随后,线性层将这一特征转化为标量值,表示给定段落正确回答查询的可能性。通过在输入中整合查询和文章,重排器加强了两者之间的互动,从而增强了其表达能力,在效果上优于检索器。交叉编码器的局限性在于它无法预处理文档语料库,每次新的查询都需要重新推理。因此,它不能作为一个独立的系统使用,而需要检索器提供一小部分相关候选语料。在 DocReLM 中,我们使用开源模型 XLM-RoBERTa-large作为基础模型,并使用我们的自定义数据作为 LCE 方法对其进行进一步训练。由 Retriever 确定的前 200 个段落随后被输入到 reranker 中,以输出每个连接对的得分。这些候选段落随后会根据各自的得分重新排序。

2.4.Reference Extraction

参考文献提取器:

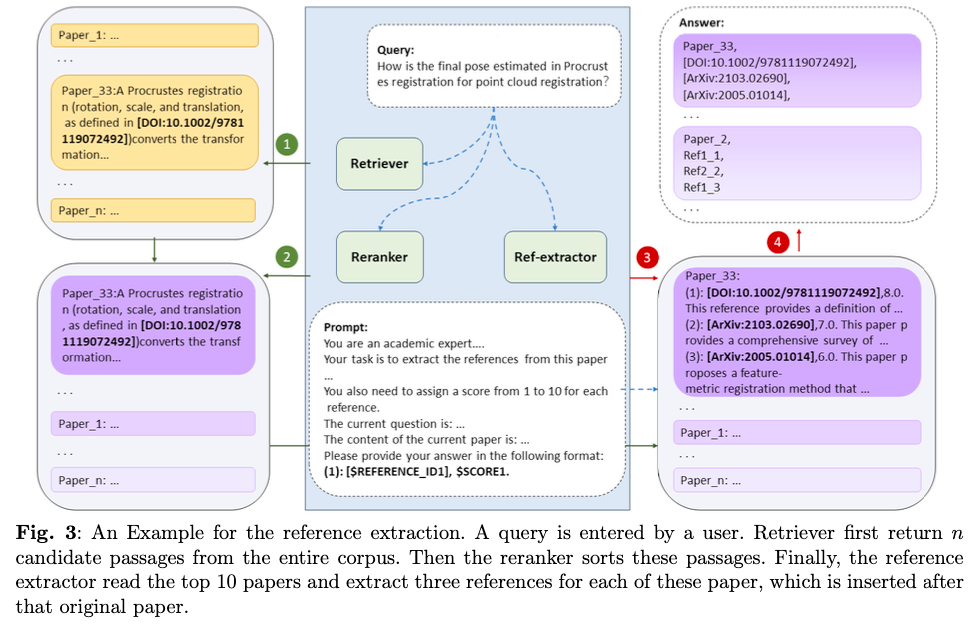

经过密集文章检索和交叉编码器重排后,得到的论文按照与查询的相关性顺序排列。我们发现,一个额外的程序可以显著改善结果。这是 DocReLM 的第三部分,即参考文献提取器,它读取文章内容并提取文章中引用的最佳参考文献。这与实际搜索是一致的。由 retriever 和 reranker 选出的论文可能不是回答查询的最佳论文,但其参考文献列表有很大可能包含该论文。基于这一目标,我们的方法**包括指示大语言模型提取检索结果,并从参考文献中找出更合适的论文。为此,我们通过在文本中插入参考文献的标识符来处理论文段落。**当大语言模型(LLM)处理这个修改过的段落时,它会根据上下文信息提取这些标识符。如果大语言模型确定文段本身就是答案,它就会输出参考文献的标识符。随后,我们的系统会搜索与提供的标识符相关的论文。图 3 展示了这一过程。

3 Model and Training Details

我们采用两阶段训练策略来训练 DocReLM 中的密集文章检索器和重排器。首先,我们在生成的训练数据上通过对比学习训练检索器。然后,我们利用训练好的检索器选择硬负样本,通过对比学习对重排器进行微调。下文将讨论数据生成和训练的细节。

3.1.Generate Training Data with Large Language Model

训练数据集的构造:

要利用对比学习训练检索器和重排器,需要收集用户查询和文章。虽然像 MS MARCO 这样的数据集都有人工标注的标签,但人工标注的费用使得获得适当的特定领域检索数据集具有挑战性。在这项工作中,我们使用大语言模型(LLM)从文档中生成伪查询。我们使用 unarXive中的论文创建数据集,处理其原始数据以删除语义无关的文本,并纳入数学 LaTeX 和参考文献标识符。这些标识符的格式为 IDF 的 Ref.X,其中 IDF 是母论文的标识符。我们将整篇论文分为若干段落,并使用 vicuna-7b-v1.5-16k,通过提供段落、标题和摘要为每个句子生成一个查询。受思维链方法的启发,在生成查询之前,我们首先采用zero-shot法引导 LLM 根据标题、摘要和内容创建大纲。

我们为实验创建了两个子集。一个是量子物理学类别。它有 56927 篇论文,我们收集了 280M的训练数据。另一个是计算机视觉类别。它有 37390 篇论文,我们收集了 110M的训练数据。这些数据都用于训练密集通道检索器和重排器。

3.2.Contrastive learning

对比学习,目标函数:

我们采用常见的对比学习策略来训练检索器和重排器。根据第 3.1 节中生成的数据,我们有多对查询和段落,其中同一对中的查询

Q

Q

Q 和段落

P

P

P 被标记为正面,而不同对中的查询

Q

Q

Q 和段落

P

P

P 被标记为负面。对比学习可以看作是对这些对子进行训练的二元分类器。对于每个正对

(

Q

i

,

P

i

)

(Q_{i},P_{i})

(Qi,Pi),我们采样

N

N

N 负对

(

Q

i

,

P

i

,

n

)

(Q_{i},P_{i,n})

(Qi,Pi,n),并使用公式 1 计算损失。

ℓ

i

=

−

log

e

s

(

Q

i

,

P

i

)

/

τ

e

s

(

Q

i

,

P

i

)

/

τ

+

∑

n

=

1

N

e

s

(

Q

i

,

P

i

,

n

)

/

τ

,

(1)

\ell_{i}=-\log\frac{\mathrm{e}^{s(Q_{i},P_{i})/\tau}}{\mathrm{e}^{s(Q_{i},P_{ i})/\tau}+\sum_{n=1}^{N}\mathrm{e}^{s(Q_{i},P_{i,n})/\tau}}, \tag{1}

ℓi=−loges(Qi,Pi)/τ+∑n=1Nes(Qi,Pi,n)/τes(Qi,Pi)/τ,(1)

其中,

s

(

Q

,

P

)

s(Q,P)

s(Q,P) 表示

(

Q

,

P

)

(Q,P)

(Q,P) 的得分函数。在 retriever 中,

s

(

Q

,

P

)

s(Q,P)

s(Q,P) 由

Q

Q

Q 和

P

P

P 嵌入的余弦相似度给出。在反向编码器中,

s

(

Q

,

P

)

s(Q,P)

s(Q,P) 由交叉编码器直接给出。通过最小化等式 1,可以优化正配对得分,使其明显大于负配对得分。

3.3.Negative Pairs for Retriever and Reranker

针对检索器和重排器的负样本对的生成方式:

对比训练 retriever 和 reranker 中的负对生成方式不同。对于 retriever,这些负数据是随机抽样的。在每个训练批次中,都会抽取 N + 1 N+1 N+1 个正数据对,每个正数据对都有 N N N 个负数据对。Neelakantan 等人发现,较大的批次规模可以提高引入硬负数据的几率,从而提高检索器的性能。我们使用梯度缓存技术来增加批量大小,以提高对比学习的性能。

在训练reranker时,我们按照 Gao 等人的方法(即 LCE),用训练好的检索器选择负数据。对于每个查询 Q i Q_{i} Qi,检索器会返回得分最高的 N N N 段落。这些段落与查询高度相关。这意味着除了正确的段落外,我们还利用了最容易混淆的错误段落。因此,这些错误段落被用作训练reranker的高质量硬负样本。

4 Evaluation and results

在评估我们的文档检索系统时,我们利用实际研究场景中的查询建立了一个基准。我们邀请研究人员在他们的研究领域创建查询,并提供作为注释标签的论文。为了确保这些注释的可靠性,我们要求研究人员提供来自调查的结果。随后,我们创建了 unarXive 的一个子集作为检索语料库。最终的基准包括两个赛道:量子物理赛道和计算机视觉赛道,前者包括 301 次查询和 56927 篇论文,后者包括 204 次查询和 37390 篇论文。我们将检索系统的性能与谷歌学术的性能进行了比较。此外,我们还进行了一项消融研究,以评估我们系统中三个组成部分的各自有效性。我们强调了它们与类似模型相比的优势,并证明了我们的模型与预训练模型相比的优越性。

我们比较了该任务的三种基线检索模型:BM25、OpenAI 的 ada-002 和 jina-base-v2。准确率见表 1。与其他模型相比,稀疏检索模型 BM25 的性能较差。在这项任务中,词频不足以捕捉语义关系。我们的 DocReLM-retriever 在这两个领域的表现都优于所有这些模型。在计算机视觉领域,DocReLM-retriever 的表现明显优于其他模型。它的准确率排名前 1 位,比最佳嵌入模型高出 5.89%,排名前 5 位和前 10 位的准确率分别高出 13.72% 和 19.13%。值得注意的是,这三个模型在计算机视觉领域都表现出色,平均准确率很高。在量子物理领域,嵌入模型的表现类似,前 1 名的结果没有显著差异。然而,当考虑前 5 名的结果时,我们的模型将准确率从 9.97% 提高到 11.96%,是其他模型中最好的。

为了测试我们的检索器的性能,我们选择了三种不同的检索器进行比较:bge-reranker-large(肖等人(2023 年))、Cohere 和 DocReLM-reranker。重新anker 将 DocReLM-retriever 选取的前 200 个段落作为输入数据。结果如表 2 所示。在计算机视觉领域,DocReLM-ranker 的表现优于其他两种模型。它的前 1 名准确率比最佳检索器高 0.49%,前 5 名和前 10 名准确率分别高 1.97% 和 2.94%。在量子物理领域,DocReLM-ranker 和 Cohere 的性能不相上下。我们的模型在前 20 名中表现更好,而 Cohere 模型在前 1 名和前 10 名中表现出色。这些结果表明,DocReLM-ranker 在这两个领域都比其他模型更有效。这凸显了重排器在提高检索系统准确性方面的重要性。

我们的最后一项实验评估了参考提取模型的有效性。我们比较了有参考文献提取和无参考文献提取的 DocReLM-ranker 的性能。结果如表 3 所示。在计算机视觉领域,参考提取模型 internLM 将前 5 名和前 20 名的准确率分别提高了 0.98% 和 2.94%。这些结果表明,参考提取模型能有效提高检索系统的准确性。在量子物理领域,参考提取模型 internLM 将前 5 名和前 10 名的准确率分别提高了 9.63% 和 16.28%。

5 Discussion

本文介绍了 DocReLM,这是一种利用大型语言模型(LLM)进行文档检索的创新方法,与传统检索方法相比有显著改进。我们的系统集成了一个神经密集检索器、一个重新排序机制和一个新颖的参考文献提取组件,所有这些都通过 LLM 的功能进行了微调和增强。在随后的小节中,我们将更详细地讨论 DocReLM 的两个方面。

5.1.Distilling of LLM

神经密集检索器和交叉编码器检索器有效地捕捉了查询和文档之间的语义关系,有助于更准确地检索相关文档。我们注意到,与我们使用的基础模型相比,使用我们生成的数据对模型进行训练后,效果有了明显改善。由于这些数据是用 LLM 生成的,因此 LLM 的理解能力被提炼到了相对较小的模型中,这可以使通用模型适应特定任务。

5.2.combination of LLM and retrieval system

本研究还介绍了一种将 LLM 与检索系统相结合的新方法。随着 LLM 的日益普及,人们一直在努力将 LLM 与搜索引擎结合起来。这些尝试主要遵循两种方法:使用 LLM 扩展搜索查询或总结搜索结果。然而,DocReLM 开创了一个新方向,它使 LLM 能够理解搜索结果,并继续搜索过程,提出更好的候选结果。这一概念还可以进一步扩展。这个过程可以反复进行,使 LLM 能够遍历引文网络中的多个节点,直到识别出最相关的结果。这样的任务需要 LLM 掌握被引用论文之间的逻辑关系,并拥有足够的领域知识来准确提取参考文献。LLM 可以进行多次搜索并分析结果,从而改进搜索结果,通过将 LLM 纳入其中,一般检索系统也能得到显著增强。这种方法是未来检索系统的一个有前途的方向。

6 Conclusion

总之,DocReLM 似乎对学术文献检索领域做出了积极贡献。这项研究通过将大语言模型(LLM)与传统检索系统相结合,试图应对学术文献数量和复杂性不断增加所带来的挑战,并提出了将 LLM 应用于基于语义的检索的新方向。在 DocReLM 中使用 LLM 生成高质量的伪数据、增强检索器和重选器模型,以及从检索到的论文中提取参考文献,是在利用学术文档中的丰富信息方面迈出的充满希望的一步。

我们的研究结果表明,与现有系统相比,检索准确率有了显著提高。这种改进可能归功于 LLM 生成的用于微调模型的检索数据。此外,DocReLM 引入了一种在检索系统中使用 LLM 的创新方法,展示了这些模型通过多个引文网络节点定位相关论文的潜力。这种能力可能标志着从传统的基于关键词的搜索向反映人类推理过程的更细致入微的上下文感知方法的转变。

随着学术研究的不断发展,DocReLM 所采用的方法可以为开发更复杂、更有效、更友好的文档检索系统铺平道路。这项研究令人鼓舞的结果意味着未来有很大的提升潜力,尤其是当 LLM 进一步发展,越来越有能力处理专业领域的复杂任务时。

968

968

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?