最近在看吴恩达系列的深度学习课程,就用CSDN记录一下我的学习笔记吧,供自己后续查阅以及分享给大家。

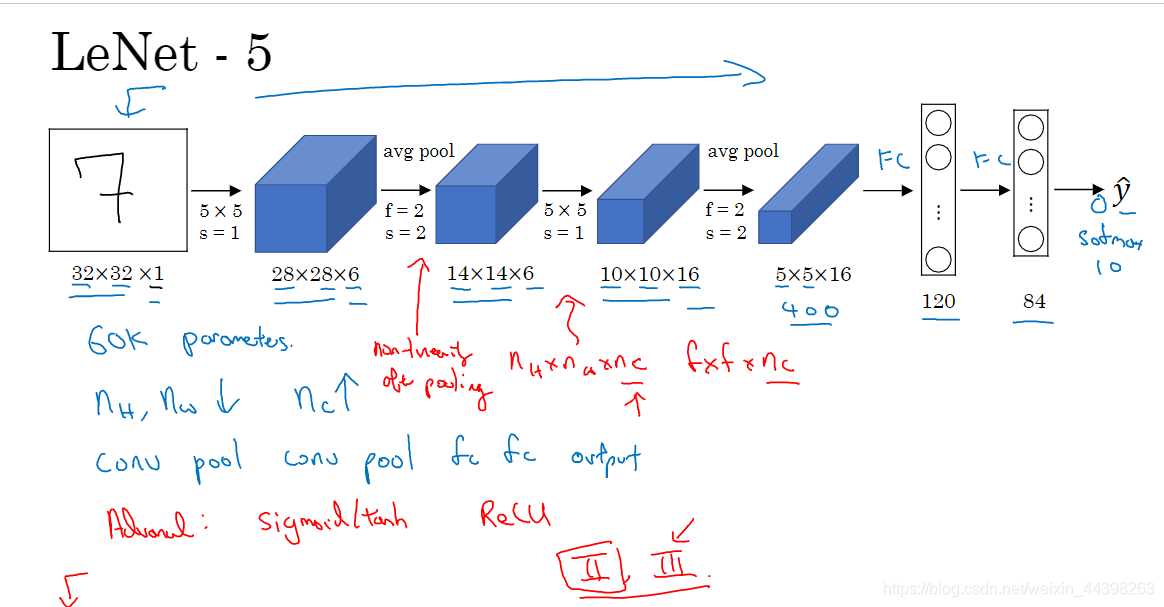

LeNet - 5 网络

网络结构说明

- 输入层:图像的大小为32✖32,只有1个channel,说明是灰度图像。

- 卷积层:卷积核为5✖5,s=1,个数为6个

- 池化层:filter为2✖2,s= 2,采用的是平均池化

- 卷积层:卷积核为5✖5,s=1,卷积个数为16个

- 池化层:filter为2✖2,s= 2,采用的是平均池化

- 全连接层:神经元个数为120个

- 全连接层:神经元个数为84个

- 输出层:一般采用softmax分类器(softmax用于互斥分类,sogmoid用于可能有重合的分类)

补充说明

- 参数个数:大约6w个

- 与最初论文中不同,现在一般使用ReLu作为激活函数,输出层使用softmax

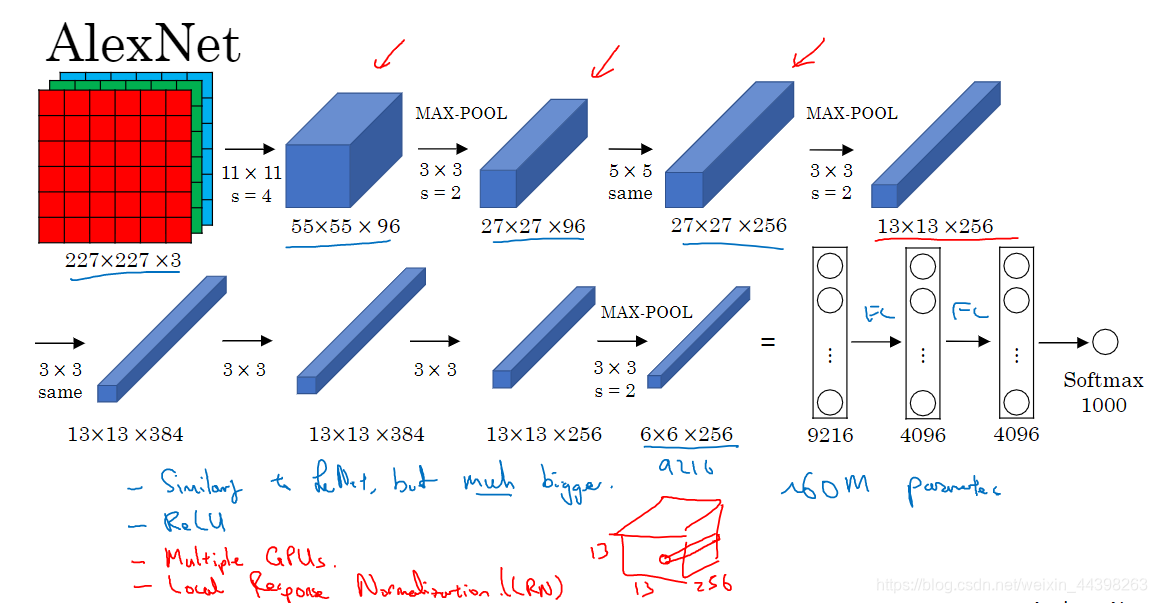

AlexNet网络

网络结构说明

- 输入层:图像大小为 227×227×3,其中 3 表示输入图像的 channel 数(R,G,B)为 3。

- 卷积层:filter大小11✖11✖3,s=4,个数为96个

- 池化层:filter为3✖3,s= 2,采用最大池化

- 卷积层:filter 大小 5×5, 个数 256,步长 s=1,padding 使用

same,使得卷积层输出图像和输入图像在宽和高上保持不变

(另外有valid、full,具体可参考padding的三种模式) - 池化层:max pooling,filter 大小 3×3,步长 s=2

- 卷积层:filter 大小 3×3,filter 个数 384,步长 s=1,padding 使用 same

- 卷积层:filter 大小 3×3,filter 个数 384,步长 s=1,padding 使用 same

- 卷积层:filter 大小 3×3,filter 个数 256,步长 s=1,padding 使用 same

- 池化层:max pooling,filter 大小 3×3,步长 s=2;池化操作结束后,将大小为 6×6×256 的输出矩阵排列成一个9216 维的向量。

- 全连接层:neuron 数量为 4096。

- 全连接层:neuron 数量为 4096。

- 全连接层,输出层:softmax 激活函数,neuron 数量为 1000,代表 1000 个类别。

补充说明

- 参数大约6000w个

- 使用ReLu作为激活函数

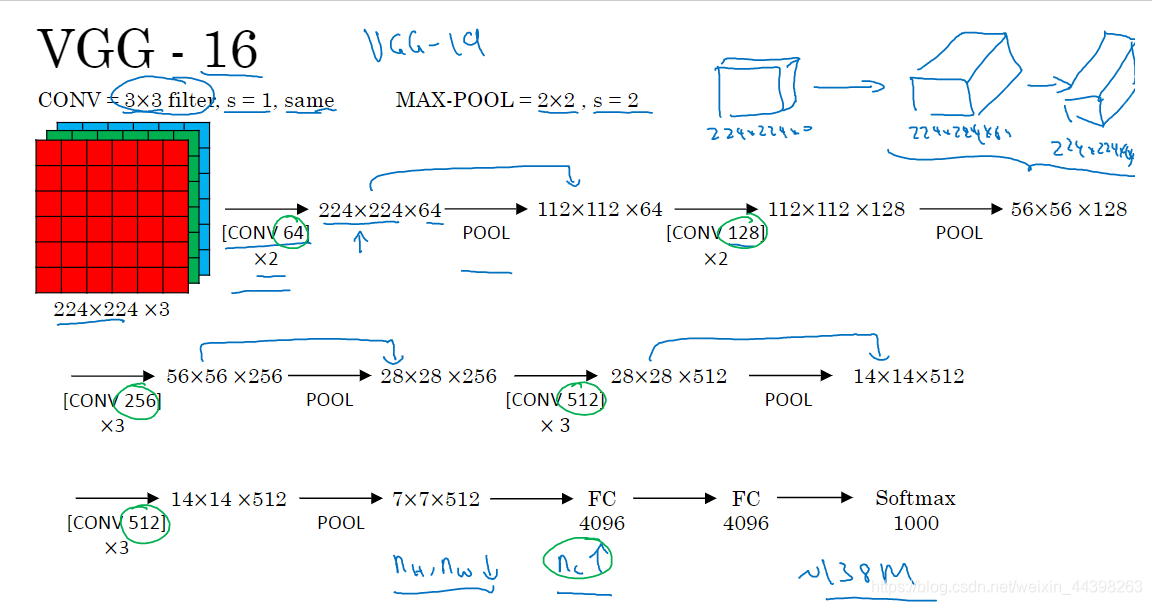

VGG - 16网络

网络结构说明

- 参照图中,就不一一列出

- VGG-16网络结构很规整,没有那么多的超参数,专注于构建简单的网络,都是几个卷积层后面跟一个可以压缩图像大小的池化层。

补充说明

-

VGG-16 大约有 13800w(138M) 个参数。

-

VGG-16 中所有卷积层 filter 宽和高都是 3,步长为 1,padding 都使用 same

,所有池化层的 filter 宽和高都是 2,步长都是 2,采用的都是最大池化

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?