摘要

论文地址: https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=9190761

在本文中,我们提出了一个嵌套的注意力感知分割网络,名为 Attention UNet++。 我们提出的方法具有深度监督的编码器-解码器架构和重新设计的密集跳过连接。 注意 UNet++在嵌套卷积块之间引入注意力机制,以便在不同级别提取的特征可以与任务相关的选择合并。 此外,由于

引入深度监督,预测速度修剪网络的速度以适度的代价加速性能下降。

1.引言

为了解决对医学图像中更准确的分割结果的需求,并受到启发注意力机制,我们提出了注意力 UNet++,一种基于嵌套 U-Net 架构的可靠分割模型和注意力机制。

我们的工作贡献如下:

1) 为肝脏 CT 图像分割引入了注意力 UNet++。

2) 在数据集 LiTS 上进行的实验表明,Attention Gate 可以聚焦整个图像的目标区域。

3)Attention U-Net++具有在抑制与分割任务无关的背景区域的同时增加目标区域权重的能力。

4) 与其他基于 UNet 的模型相比,Attention UNet++ 在肝脏分割任务上具有优越的性能。

5) 由于引入了深度监督,UNet++ 以很少的性能为代价加速了修剪注意力。

2.相关创新

嵌套的 UNet 架构:

自 U-Net提出以来,它已广泛应用于医学图像分割。 过去大多数研究都以它为骨干,并针对不同的分割任务做了一些改变。UNet++ 是最具代表性的基于 UNet 的分割架构之一。UNet++ 与 UNet 的区别在于前者重新设计了不同级别的编码器和解码器之间的密集跳过连接,并使用了嵌套的卷积块。UNet++中的每个嵌套卷积块通过几个卷积层提取语义信息。 并且块中的每个卷积层都通过密集跳过连接进行连接,以便连接层可以融合不同级别的语义信息。

注意力机制:

注意力门(AG):注意力机制最早出现在自然语言处理(NLP)中,并迅速占据主导地位。 最早将注意力机制引入计算机视觉的是何开明团队提出的Non-local。 此后,将共享网络结合到语义分割领域。 用残差和注意力机制来获得深度网络。 为了关注与目标器官相关的位置,我们参考了 PASSRnet 提出的方法,在网络架构中添加了一个简单但有效的注意力门。注意力门的架构如图 1 所示。

图1

注意门的输入是扩展路径中的上采样特征和来自编码器的相应特征。前者作为门控信号,增强对与分割任务相关的目标区域的学习,同时抑制与任务无关的区域。因此Attention Gate可以通过skip connection来提高传播语义信息的效率。 接下来选择S形激活函数sigmoid来训练Gate中参数的收敛性,得到attention系数α。最后,可以通过将编码器特征乘以系数α逐像素获得输出。

3.方法

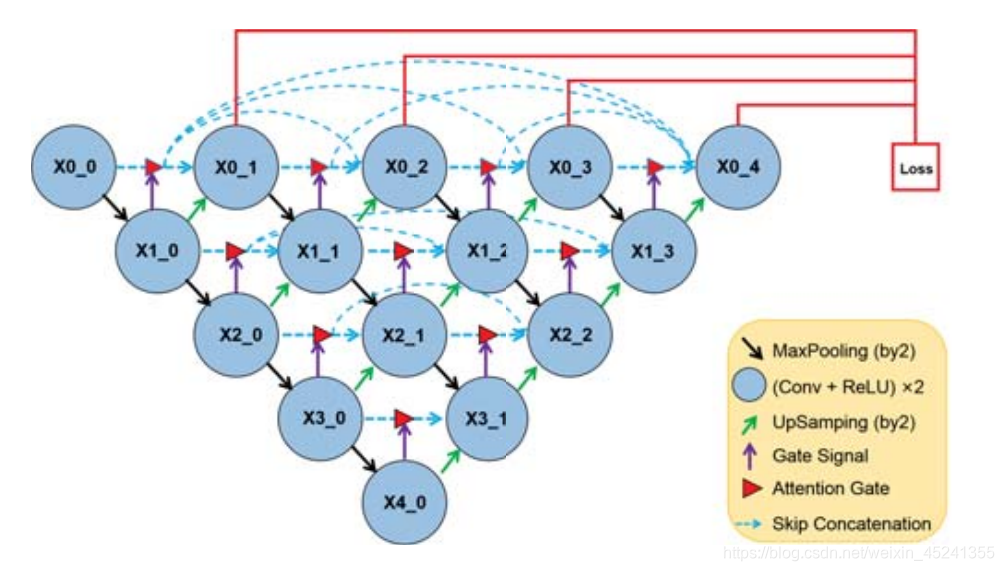

Attention UNet++:我们设计了一个名为 Attention UNet++ 的集成网络,用于医学图像分割。 注意 UNet++ 的高级概述如图 2 所示。

图2

我们可以看到,Attention UNet++ 使用嵌套的 U-Net 作为基本的网络框架。 编码器和解码器对称布置在网络的两侧。编码器提取的上下文信息通过密集跳过连接传播到相应层的解码器,从而可以提取更有效的层次特征。 在接收到每一层的特征后,解码器以自底向上的方式恢复特征。

我们定义特征图如下,让Xi,j代表块的输出,其中i代表编码器中的特征深度,j代表沿着跳过连接的嵌套块中卷积层的深度,所以提取卷积的特征图 层可以定义为:

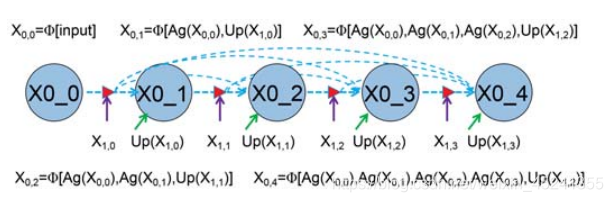

其中 Φ[ ] 表示卷积块后接串联合并,U p() 和 Ag() 分别表示上采样和注意门选择。 Attention UNet++中第一个skip path的详细分析如图3所示。

图3 详解Attention UNet++中一级嵌套块的dense skip connection

Attention UNet++的主要创新之一是:网络从编码器中提取特征,并通过密集跳跃连接将其传输到解码器,以集成分层表示。 此外,嵌套的卷积块之间增加了Attention Gate机制,使得不同层次提取的特征可以与扩展路径中的重点选择合并。 因此,Attention UNet++ 的准确性得到了提高。

深度监督:为了引入深度监督,Attention UNet++在每个输出节点(X0 1,X0 2, X0 3,X0 4)之后添加了1x1卷积层和sig moid激活函数。 图 4 显示了深度监督的示意图。

图4

由于嵌套块中的密集跳过连接,Attention UNet++ 从节点获得不同语义级别的全分辨率特征图。 为了充分融合这些语义信息,我们结合软骰子系数损失和交叉熵损失重新设计了一个混合损失函数,其定义如下:

模型修剪:当经过训练的网络预测分割结果时,深度 d 处的解码器路径独立于更深的解码器路径。 因此,我们完全删除了不相关的解码器路径,并使用较小的训练有素的注意力 UNet++ 在深度 d 处进行分割。 在图 5 中,我们使用 Attention UNet++ L1、L2、L3、L4 来表示在四个不同深度修剪的网络。 修剪注意 UNet++ LN 意味着从 X0_N 获取最终结果。 通过在验证期间评估四个模型的性能和推理时间来权衡选择模型修剪的程度。 例如,如果最终结果来自 X0_1,Attention UNet++ L1 是一个最大剪枝架构。 同样,当最终结果来自 X0_4 时,Attention UNet++ L4 中没修剪。

图5 具有深度监督的训练注意力 UNet++ 使分割结果在不同级别可用。 灰色区域表示这些节点和注意门在预测过程中被移除。

5.实验和结果

6.总结

本文提出了一种嵌套的注意力感知分割网络(Attention UNet++),并将其应用于肝脏分割。 我们在 LiTS 数据集上的实验证明了所提出的 Attention UNet++ 在肝脏 CT 图像分割中的竞争性能。 改进归因于密集跳过连接和注意力机制的结合。 实验也证明了Attention UNet++在抑制与分割任务无关的背景区域的同时,能够增加目标区域的权重。 此外,由于引入了深度监督,修剪后的Attention UNet++的预测速度加快,但性能下降很小

该论文提出了Attention UNet++,一个针对肝脏CT图像分割的深度监督网络,融合嵌套卷积块和注意力机制。通过引入注意力门,网络能够聚焦目标区域并抑制无关背景,提高分割性能。

该论文提出了Attention UNet++,一个针对肝脏CT图像分割的深度监督网络,融合嵌套卷积块和注意力机制。通过引入注意力门,网络能够聚焦目标区域并抑制无关背景,提高分割性能。

832

832

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?