系列文章目录

Tempo:用于时间序列预测的基于提示的生成预训练变压器 ICLR2024

摘要

在过去的十年中,深度学习在时间序列建模方面取得了重大进展。在获得最先进的结果时,最佳性能的体系结构在应用程序和领域之间差异很大。同时,对于自然语言处理,生成预训练转换器(GPT)通过跨各种文本数据集训练一个通用模型,展示了令人印象深刻的性能。探索gpt类型的架构是否对时间序列有效,捕获内在动态属性并导致显着的准确性提高是很有趣的。在本文中,我们提出了一个新的框架,TEMPO,可以有效地学习时间序列表示。我们专注于利用时间序列任务的两个基本归纳偏差来预训练模型:(i)分解趋势、季节和剩余成分之间复杂的相互作用;(ii)引入提示符的设计,以方便不同类型时间序列的分布适应。TEMPO扩展了从不同领域内的数据动态建模真实世界时间现象的能力。我们的实验证明了tempover最先进的方法在许多时间序列基准数据集的零射击设置上的优越性能。这种性能增益不仅在涉及以前未见过的数据集的场景中观察到,而且在具有多模态输入的场景中也可以观察到。这一令人信服的发现突出了TEMPO构成基础模型构建框架的潜力。

一、引言

时间序列预测,即根据历史观察预测未来数据,具有广泛的现实应用,如卫生、交通、金融等领域。在过去十年中,许多深度神经网络架构已被应用于时间序列建模,包括卷积神经网络(CNN) (Bai等人,2018)、循环神经网络(RNN) (Siami-Namini等人,2018)、图神经网络(GNN) (Li等人,2018;Cao et al., 2021)和Transformers (Liu et al., 2021;Zhou et al., 2021;Wu et al., 2023;Zhou et al., 2022;Woo et al., 2022;Kitaev et al., 2020;Nie et al., 2023),导致最先进的结果。在获得强大的预测性能的同时,以前关于时间序列的一些工作主要受益于序列建模的进步(从RNN和GNN到变压器),这些建模捕获了时间依赖性,但没有充分利用时间序列数据中复杂模式的好处,例如季节性、趋势和残差。这些成分是时间序列与经典序列数据的关键区别因素(Fildes et al., 1991)。因此,最近的研究表明,基于深度学习的架构可能不像以前认为的那样健壮,甚至可能在某些基准上被浅神经网络甚至线性模型超越(Zeng et al., 2023;张等,2022b;Wu et al., 2023;Ekambaram et al., 2023;Fan等人,2022)。尽管深度学习预测器取得了显著的成功,但它们中的绝大多数仍然遵循传统的训练机制,使用相同的数据集进行训练和预测。

同时,自然语言处理(NLP)和计算机视觉(CV)领域基础模型的兴起,如LLaMA (Touvron等人,2023)、CLIP (Radford等人,2021)和ChatGPT,标志着有效表征学习的重要里程碑。探索具有大量数据的基础时间序列模型的预训练路径,促进下游任务的性能改进是非常有趣的。最近的一些研究揭示了为时间序列构建通用变压器的可能性(Zhou et al., 2023;Sun et al., 2023;Goswami et al., 2024;Das et al., 2023b;Rasul et al., 2023)。然而,对这些模型的理论和实践理解尚未达到在生成模型得到广泛认可的其他领域所观察到的共识(Garza & Mergenthaler-Canseco, 2023)。此外,法学硕士中的提示技术(如InstructGPT (Ouyang等人,2022))提供了一种在预训练期间利用模型现有表示的方法,而不是要求从头开始学习。然而,语言模型中现有的骨干结构和提示技术并没有像N-BEATS (Oreshkin等人,2019)和AutoFormer (Wu等人,2021)那样完全捕捉到时间模式的演变,而这是时间序列建模的基础。

在本文中,我们试图解决适应时间序列预测任务的大型预训练模型的及时挑战,并开发了一种基于提示的时间序列生成预训练转换器,即TEMPO。TEMPO由两个关键的分析组件组成,用于有效的时间序列表示学习:一个侧重于对特定的时间序列模式(如趋势和季节性)进行建模,另一个侧重于通过基于提示的方法从数据的固有属性中获得更普遍和可转移的见解。具体来说,TEMPO首先通过局部加权散点图平滑将时间序列输入分解为三个可加性成分,即趋势、季节性和残差(Cleveland et al., 1990)。每个时间输入随后被映射到其相应的隐藏空间,以构建生成式预训练变压器(GPT)的时间序列输入嵌入。我们进行了形式化的分析,将时间序列域与频率域连接起来,以强调分解这些分量进行时间序列分析的必要性。此外,我们从理论上揭示了注意机制很难实现自动分解。其次,TEMPO利用软提示有效地调整GPT (Radford等人,2019),通过指导重用一组可学习的连续向量表示,对趋势和季节性的时间知识进行编码,来完成预测任务。此外,我们利用时间序列数据的三个关键相加成分——趋势、季节性和残差——为理解输入成分之间的相互作用提供了一个可解释的框架(Hastie, 2017)。对TEMPO的零点设定和多模态设定的实验结果为建立时间序列的基础模型铺平了道路。此外,我们在两个多模态数据集(包括TETS (Text for Time Series)数据集)上展示了我们的模型对带有文本信息的未见样本的稳定预测能力,这是本工作首次引入TETS (Text for Time Series)数据集,以促进预训练时间序列模型的进一步研究课题。

综上所述,本文的主要贡献包括:(1)我们引入了一种可解释的基于提示的生成转换器TEMPO,用于时间序列表示学习。它进一步推动了时间序列预测的范式转变——从传统的深度学习方法到预训练的基础模型。(2)我们通过关注两个基本的归纳偏差来适应时间序列的预训练模型:首先,我们利用分解的趋势、季节性和残差信息。其次,我们探讨了软提示策略,以适应时间序列数据的动态性。(3)通过在基准数据集和两个多模态数据集上的大量实验,我们的模型显示出优越的性能。值得注意的是,我们的稳健结果突出了基础模型在时间序列预测领域的潜力。

二、 RELATED WORKS

时间序列的预训练大型语言模型。大型语言模型(llm)的最新发展为时间序列建模开辟了新的可能性。llm,如T5 (rafael等人,2020)、GPT (Radford等人,2018)、GPT-2 (Radford等人,2019)、GPT-3 (Brown等人,2020)、GPT-4 (OpenAI, 2023)、LLaMA (Touvron等人,2023),已经显示出理解异构文本数据复杂依赖关系并提供合理代的强大能力。最近,人们对将语言模型应用于时间序列任务越来越感兴趣(Jin et al., 2024a;Gruver et al., 2024)。例如,Xue & Salim天真地将时间序列数据转换为文本序列输入,并取得了令人鼓舞的结果。Sun等人提出了文本原型对齐嵌入,使llm能够处理时间序列数据。此外,Yu等人提出了一种利用法学硕士进行可解释的金融时间序列预测的创新方法。(Zhou et al., 2023)和(Chang et al., 2023)中的工作与我们的工作最相关,因为它们都通过战略性地利用和微调llm引入了时间序列分析的方法。然而,这些研究直接使用时间序列数据来构建嵌入,而没有充分捕捉时间序列数据的固有和独特特征,这对于在llm中解耦此类信息具有挑战性(Shin等人,2020)。此外,对于时间序列多模态数据的LLM研究仍然非常有限。METS (Li et al., 2023)是这一方向的早期研究之一。虽然实验结果令人鼓舞,但由于时间序列和文本之间的嵌入对齐是特定的,因此很难将METS扩展到其他模式。请参考调查论文(Jin et al., 2023;2024b)查阅时间序列会议llm的进一步参考资料。

图1:建议的TEMPO-GPT的体系结构。趋势XT,季节XS和残余XR分量被视为不同的语义归纳偏差,以馈送到预训练的变压器中。

提示调优。快速调优是一种高效、低成本的方法,可以使预训练的基础模型适应新的下游任务,该模型已经适应了各种领域的下游任务。在NLP领域,通过提示调优(Lester et al., 2021)或前缀调优(Li & Liang, 2021)使用具有可训练表征的软提示。提示技术也已扩展到CV任务,如对象检测(Li等人,2022)和图像字幕(Zhang等人,2022a)等,以及其他领域,如错误信息(Zhang等人,2024)。多模式作品,如CLIP (Radford et al., 2021),使用文本提示执行图像分类并实现SOTA性能。此外,L2P (Wang et al., 2022b)展示了存储在共享池中的可学习提示的潜力,可以在没有排练缓冲的情况下实现持续学习,而Dualprompt (Wang et al., 2022a)引入了双空间提示架构,对一般知识和专家信息等保持单独的提示编码。我们的研究建立在这些概念的基础上,探索了指示性偏差提示设计的使用,特别是用于时间序列预测问题的时间推理和知识共享。

三、 METHODOLOGY

在我们的工作中,我们采用了一种混合方法,将统计时间序列分析的鲁棒性与数据驱动方法的适应性相结合。如图1所示,我们提出了一种将STL (Cleveland等人,1990)的季节性和趋势分解整合到预训练变压器中的新方法。这种策略使我们能够利用统计和机器学习方法的独特优势,增强我们的模型有效处理时间序列数据的能力。此外,引入半软提示方法,增强预训练模型处理时间序列数据的适应性。这种创新的方法使模型能够将其广泛的学习知识与时间序列分析固有的独特需求相结合。

3.1 PROBLEM DEFINITION

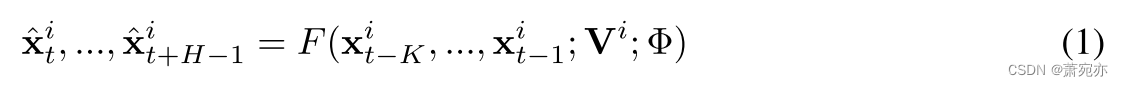

给定前K个时间戳的观测值,多变量时间序列预测的任务旨在预测下H个时间戳的值。也就是说,

其中

x

^

t

i

,

.

.

.

,

x

^

t

+

H

−

1

i

\hat{\mathbf{x}}_t^i,...,\hat{\mathbf{x}}_{t+H-1}^i

x^ti,...,x^t+H−1i为第i个特征对应的信道i从时间戳t开始的H步估计向量。给定历史值

x

t

−

K

i

,

.

.

.

,

x

t

−

1

i

,

\mathbf{x}_{t-K}^i,...,\mathbf{x}_{t-1}^i,

xt−Ki,...,xt−1i,,它可以通过参数Φ和提示符Vi的模型F推断出来。由于预期基础模型在未见过的数据集上具有强大的泛化能力,在没有特定指示的情况下,我们默认使用零次学习配置。这种方法需要模型在训练过程中不知道目标数据集的历史值和水平值。

3.2 TIME SERIES INPUT REPRESENTATION

对于时间序列数据,通过将其分解为有意义的组件(如趋势和季节组件)来表示复杂的输入,可以帮助最佳地提取信息。在本文中,给定输入

X

∈

R

n

×

L

X\in\mathbb{R}^{n\times L}

X∈Rn×L,其中n为特征(通道)大小,L为时间序列的长度,则加性STL分解(Cleveland et al., 1990)可表示为:

这里,i是多变量时间序列输入的通道索引(对应于某个协变量),趋势

X

T

∈

R

n

×

L

=

1

m

∑

j

=

−

k

k

X

t

+

j

X_{T}\in\mathbb R^{n\times L}=\frac{1}{m}\sum_{j=-k}^{k}X_{t+j}

XT∈Rn×L=m1∑j=−kkXt+j捕获了数据中潜在的长期模式,其中m = 2k + 1, k为平均步长。季节分量

X

S

∈

R

n

×

L

X_S\in\mathbb{R}^{n\times L}

XS∈Rn×L封装了重复的短期周期,可以在去掉趋势分量后进行估算。残差分量

X

R

∈

R

n

×

L

X_R\in\mathbb{R}^{n\times L}

XR∈Rn×L表示提取趋势和季节性后数据的剩余部分。请注意,在实践中,建议利用尽可能多的信息来实现更精确的分解。但是,考虑到计算效率,我们选择不对每个实例上最大的数据窗口使用STL分解。相反,我们使用固定的窗口大小在每个实例中执行局部分解。受N-BEATs (Oreshkin et al., 2019)的启发,我们引入了可学习的参数来估计各种局部分解成分。其他人也一样。这个原则也适用于模型的其他组件。在附录G中,我们建立了时间序列预测和频域预测之间的联系,我们的研究结果表明,分解显著简化了预测过程。注意,这种分解在基于电流互感器的方法中更为重要,因为注意机制在理论上可能不会自动解开不正交的趋势和季节信号:

定理3.1假设有时间序列信号 X = X T t + X S t + X R t , t ∈ [ t 1 , t n ] X=X_{Tt}+X_{St}+X_{Rt},t\in[t_{1},t_{n}] X=XTt+XSt+XRt,t∈[t1,tn]。设 E = { e 1 , e 2 , . . . , e n } E=\{e_{1},e_{2},...,e_{n}\} E={e1,e2,...,en}表示一组正交基。设 E S ⊆ E \begin{aligned}E_{S}\subseteq E\end{aligned} ES⊆E表示 X S t X_{St} XSt具有非零特征值的E的子集, E T ⊆ E E_{T}\subseteq E ET⊆E表示 X T t X_{Tt} XTt具有非零特征值的E的子集。如果xst与 X T t X_{Tt} XTt不正交,即 ∑ i = 1 n X T t i X S t i ≠ 0 \sum_{i=1}^{n}X_{Tt}^{i}X_{St}^{{i}}\neq0 ∑i=1nXTtiXSti=0,则 E T ∩ E S ≠ ∅ E_{T}\cap E_{S}\neq\emptyset ET∩ES=∅,即E不能将这两个信号解耦到两个不相交的基集上。

证明见附录g。定理3.1指出,如果一个时间序列的趋势分量和季节分量是非正交的,它们不能被任何一组正交基完全解纠缠和分离。根据(Zhou et al., 2023),自关注层自然地学习正交变换,类似于PCA分解成正交主成分。因此,将注意力直接应用于原始时间序列在分离非正交趋势和季节成分方面是无效的。对于方法论部分的其余部分,我们将使用趋势组件XT作为示例案例。我们首先分别对每个全局组件和局部输入应用反向实例规范化(Kim et al., 2022),以促进知识转移并最大限度地减少分布转移带来的损失。即,对于时间t的XT的第1通道的每个样本 x ^ T t = γ T ( x T t − E t [ x T t ] / V a r [ x T t ] + ϵ T ) + β T , w h e r e E t [ x T t ] a n d V a r [ x T t i ] \hat{x}_{Tt}=\gamma_{T}\left(x_{Tt}-\mathbb{E}_{t}\left[x_{Tt}\right]/\sqrt{\mathrm{Var}\left[x_{Tt}\right]+\epsilon_{T}}\right)+\beta_{T},\mathrm{~where~}\mathbb{E}_{t}\left[x_{Tt}\right]\mathrm{~and~}\mathrm{Var}\left[x_{Tt}^{i}\right] x^Tt=γT(xTt−Et[xTt]/Var[xTt]+ϵT)+βT, where Et[xTt] and Var[xTti]分别为实例的均值和标准差;γT和βT是趋势分量的可训练仿射参数向量。此外,我们实现了均方误差(MSE)重建损失函数,以确保局部分解与训练数据中观察到的全局STL分解一致。分解损失函数,记为 L D e c = f T ( X , θ T ) − X ^ T g L_{Dec}=f_{T}(X,\theta_{T})-\hat{X}_{T}^{g} LDec=fT(X,θT)−X^Tg,其中fT为可学习变量θT的函数,用于映射局部分解与归一化后的全局分解 X ^ T g \hat{X}_T^{g} X^Tg一致。我们将时间序列补丁与时间编码相结合,通过将相邻的时间步长聚合成标记来提取局部语义,显著提高了历史水平,同时减少了冗余。

具体来说,我们得到 f T ( X i , θ T ) f_T(X^i,\theta_T) fT(Xi,θT) P T i ∈ R L P × N P_{T}^{i}\in\mathbb{R}^{L_{P}\times N} PTi∈RLP×N的第i个归一化趋势分量的补丁标记,其中LP为补丁长度, N = ⌊ ( L − L P ) S ⌋ + 2 N=\left\lfloor\frac{(L-L_P)}{S}\right\rfloor+2 N=⌊S(L−LP)⌋+2为补丁数,S为步幅。我们用同样的方法得到S和R。然后,我们将经过修补的时间序列令牌提供给嵌入层f,得到语言模型架构的表示 P T i = f ( P T i ) ∈ R P × L E \mathcal{P}_T^i=f(P_T^i)\in\mathbb{R}^{P\times L_E} PTi=f(PTi)∈RP×LE,从而有效地将其语言能力转移到新的序列模态,其中LE为嵌入大小。

3.3 PROMPT DESIGN

提示技术通过利用在精心设计的提示中编码的特定于任务的知识的力量,已经在广泛的应用程序中证明了显著的有效性。这种成功可以归因于提示提供结构化框架的能力,该框架使模型的输出与期望的目标保持一致,从而提高了生成内容的准确性、一致性和总体质量。以前的工作主要集中在利用固定提示通过微调来提高预训练模型的性能(Brown et al., 2020)。为了利用封装在各种时间序列组件中的丰富语义信息,我们的研究引入了一种半软提示策略。这种方法包括生成不同的提示,对应于每个主要的时间序列成分:趋势、季节性和残差。“根据[趋势、季节、剩余量]预测未来的时间步长”是我们导出组件特定提示的模板。随后将这些数据与相关组件数据连接起来,从而实现更精细的建模方法,该方法承认时间序列数据的多面性。具体来说,将特定趋势的提示翻译成单词嵌入空间,然后进行线性变换,得出可学习的趋势提示向量Vt。因此,这种所谓的“半软”提示设计在“硬”提示的可解释性和初始指导与“软”提示的适应性之间取得了平衡。该提示符与时间序列表示的组合嵌入封装为:

这里,xT表示沿时间轴的嵌入集合。这种连接过程反映了季节性和剩余成分,分别产生xS和xR。该框架允许实例与特定提示相关联,作为归纳偏差,联合编码与预测任务相关的关键信息,例如重复模式、总体趋势和固有的季节性影响。值得注意的是,我们的提示设计保持了高度的适应性,确保与广泛的时间序列分析的兼容性。特别是,与(Wang et al., 2022a)类似,我们在附录D中引入提示池作为软提示设计的扩展,旨在适应现实世界时间序列数据的非平稳性特征和相关的分布变化(Huang et al., 2020;Fan et al., 2023)。这种适应性强调了我们的提示策略与不同时间序列数据集所呈现的复杂性相一致的潜力。

3.4 GENERATIVE PRE-TRAINED TRANSFORMER ARCHITECTURE

我们使用基于解码器的生成预训练转换器(GPT)作为主干来构建时间序列表示的基础。为了有效地利用分解后的语义信息,我们选择将提示符和不同的组件连接在一起,并将它们放入GPT块中。具体来说,我们的时间序列嵌入的输入可以表述为:x = xT⊕xS⊕xR,其中⊕对应于串联操作,x∗可以被视为不同的句子。请注意,另一种替代方法是构建单独的GPT块来处理不同类型的时间序列组件。在GPT块内,我们采用(Zhou et al., 2023)中使用的策略,选择更新位置嵌入层和层归一化层的梯度。此外,我们采用LORA (Low-Rank Adaptation) (Hu et al., 2021)来有效地适应变化的时间序列分布,因为它可以用更少的参数进行适应。

总体预测结果应该是各个分量预测的相加组合。最后,GPT块的n个特征的输出Z根据其在输入顺序中的位置,可以分为 Z T , Z S , Z R ∈ Z_T,Z_S,{Z_R}\in ZT,ZS,ZR∈ R n × P × L E \mathbb{R}^{n\times P\times L_E} Rn×P×LE(对应趋势,季节性,残差的输出)。然后将每个Z分量馈送到完全连接的层中以生成预测 Y ∗ ∈ R n × L H Y_*\in\mathbb{R}^{n\times L_H} Y∗∈Rn×LH,其中LH是预测长度。预测结果可表示为: Y ^ = Y T ^ + Y S ^ + Y R ^ \begin{aligned}\hat{Y}=\hat{Y_T}+\hat{Y_S}+\hat{Y_R}\end{aligned} Y^=YT^+YS^+YR^。之后,我们根据归一化步骤中使用的相应统计量对Y进行反归一化: Y ^ t i = Var [ x t i ] + ϵ ⋅ ( Y t i − β γ ) + E t [ x t i ] \hat{Y}_t^i=\sqrt{\operatorname{Var}\left[x_t^i\right]+\epsilon}\cdot\left(\frac{Y_t^i-\beta}{\gamma}\right)+\mathbb{E}_t\left[x_t^i\right] Y^ti=Var[xti]+ϵ⋅(γYti−β)+Et[xti]。通过重新组合这些附加元素,我们的方法旨在重建最能代表由分解的输入表示捕获的不同时间尺度的潜在动态的完整时间轨迹。为了达到可解释性,我们探讨了趋势、季节和剩余成分对最终输出的贡献之间的线性和非线性相互作用。因此,我们基于GPT的输出构造了一个可解释的广义加性模型(GAM) (Hastie, 2017)来学习这三个分量是如何相互作用的,即: g ( Y ) = F ∅ + ∑ i F i ( x i ) + ∑ t F I t ( x I t ) g(Y)=F_{\emptyset}+\sum_{i}F_{i}(x_{i})+\sum_{t}F_{\mathcal{I}_{t}}(x_{\mathcal{I}_{t}}) g(Y)=F∅+∑iFi(xi)+∑tFIt(xIt),其中F∅为归一化常数,脚注i对应趋势、季节、残差分量。{它}是一组多个相互作用的组件。然后,我们可以计算一阶灵敏度指数(Sobol ', 1990)或SHAP (SHapley Additive exPlanations)值(Lundberg & Lee, 2017)来衡量每个成分的灵敏度。

四、 EXPERIMENTS

我们的实验使用了广泛认可的时间序列基准数据集,例如(Zhou et al., 2021)中详细介绍的数据集,以及GDELT数据集(Jia et al., 2024)和我们提出的TETS数据集。这些综合数据集涵盖了各种领域,包括但不限于电力(ETTh1, ETTh2, ETTm1, ETTm2, electricity),交通(traffic),气候(Weather),新闻(GDELT)和金融(TETS),数据采样频率从分钟,小时到天和季度不等。包括这些不同的数据集,确保我们的实验设置跨多个维度的时间序列数据的全面评估。由于缺乏零射击比较的标准测试分割,我们采用统一的训练方法来确保在模型训练期间未见过的数据集之间进行公平的性能评估。具体来说,为了在迁移学习领域推进基础模型的范式,我们研究了实验的零射击设置,即“多对一”场景:在多个源数据集上进行训练,然后在一个不同的、看不见的目标数据集上进行零射击预测。例如,在评估“天气”数据集的性能时,我们的模型在不同的数据集上进行预训练,包括“ETTm1, ETTm2, ETTh1, ETTh2,电力和交通”,而无需接触目标天气数据。这种“多对一”方法从根本上不同于“一对一”或“一对多”配置(Zhang等人,2022c),它使用了来自不同领域的各种预训练数据集,如交通和天气数据。这种多样性虽然丰富,但也带来了复杂性,因为模型必须在潜在的不一致样本中识别模式,与在分布数据集中训练和测试的模型相比,这使学习变得复杂。

我们使用GPT-2 (Radford et al., 2019)作为构建TEMPO1的主干,如图1所示。为了全面展示我们的模型的性能,我们将TEMPO与以下长期预测和短期预测基线进行了比较:(1)预训练的基于llm的模型,包括Bert (Devlin等人,2019),GPT2 (Radford等人,2019);Zhou等人,2023),T5 (rafael等人,2020)和LLaMA (Touvron等人,2023)。(2)基于变压器的模型,包括PatchTST (Nie等人,2023)、FEDformer (Zhou等人,2022)、ETSformer (Woo等人,2022)和Informer (Zhou等人,2021)。(3)线性模型的变体,DLinear (Zeng et al., 2023)模型。(4)通用二维变分模型,TimesNet (Wu et al., 2023)。继传统预测工作之后,我们在本节中报告了均方误差(MSE)和平均绝对误差(MAE)的结果。详细的实验设置和基线见附录B和F。

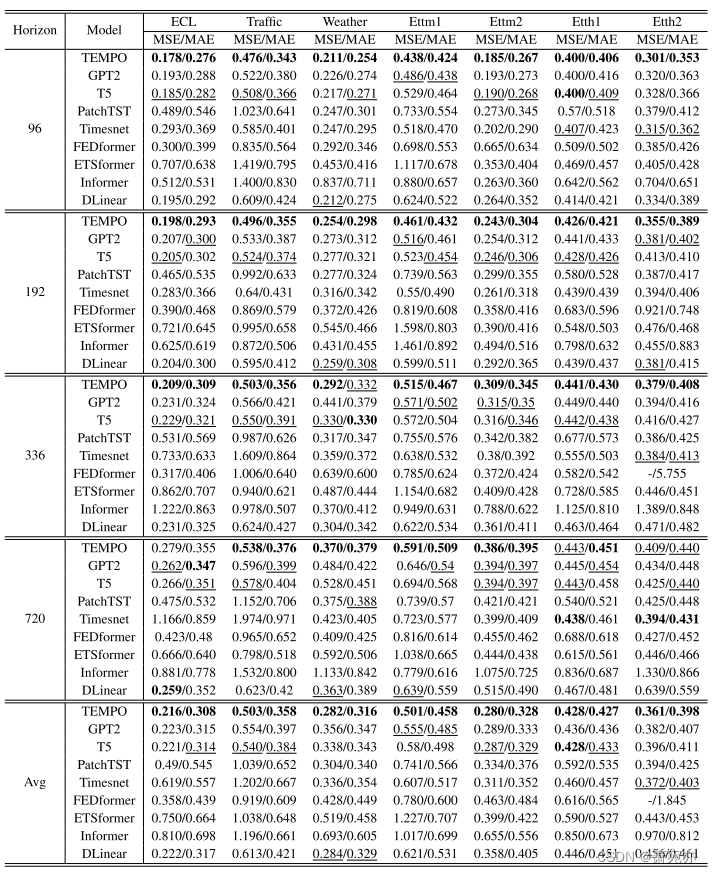

4.1 ZERO SHOT LONG-TERM FORECASTING RESULTS

表1给出了多个时间序列预测模型在“多对一”设置下跨不同预测长度的MSE和MAE指标上的表现,分数越低表示预测越准确。我们提出的TEMPO模型在所有数据集的所有预测范围内平均超过了现有基线,突出了TEMPO的广泛适用性。我们的模型达到了最高的平均性能分数。具体来说,与之前最先进的模型PatchTST相比,它在MAE中的天气和ETTm1数据集分别提高了约6.5%和19.1%。它还确保了在许多单独的数据集预测长度配置中的最低错误率。与其他预训练的预测模型相比,TEMPO在不同的时间序列数据集上始终提供最佳结果。这些结果表明,将LLM与精心设计的提示符相结合,并实施时间序列分解,可以显著提高零点时间序列预测的准确性和稳定性。

表1:时间序列基准数据集上长期预测结果的迁移学习。我们使用预测长度O∈{96,192,336,720}。MSE越低表示性能越好。之后,对于表格,最佳结果用粗体标记,次优结果用下划线标记,分别用MSE/MAE标记。

4.2 SHORT-TERM FORECASTING WITH CONTEXTUAL INFORMATION

数据集和指标。在本节中,我们向社区介绍TETS,这是一个基于标准普尔500数据集结合上下文信息和时间序列建立的新的基准数据集。接下来(Cao et al., 2023),我们选择对称平均绝对百分比误差(SMAPE)作为本节的度量标准。此外,还使用GDELT验证了我们提出的方法的有效性。TETS和GDELT的详细数据集设置请参见附录B.2和附录B.3;

表2:来自TETS和GDELT的EBITDA的SMAPE结果。EBITDA的结果包括SMAPE超过0.8/0.9的异常值。最好的结果用粗体标记,第二个最优的结果用下划线分别标记为0.8和0.9。(行业:CC:消费周期;CD:消费者防御;Ind:工业;RE:房地产;事件:11:不赞成;17:强迫;19:战斗。)

附录H为同时收集时间序列和文本信息的TETS数据集的拟议管道。

上下文信息。为了将上下文信息合并到我们提出的TEMPO中,我们利用生成式预训练转换器的内置标记化功能来派生输入文本的嵌入。然后,我们利用这些对应于每个时间序列实例text的文本嵌入来构造具有可学习参数的软提示,并将它们连接在输入嵌入的开始处,即x = text⊕xT⊕xS⊕xR。其中EBITDA的x *是用半软提示进行的。这种方法并不局限于我们所提出的模型,而是可以在类似的作品中应用,以提高他们处理和受益于上下文信息的能力。附录D.4提供了与其他情境信息设计策略的比较,以供进一步参考。

结果。从迁移学习的角度来看,我们选择报告“多对多”的设置,这意味着我们使用域内扇区数据训练模型,并直接对所有跨域扇区进行零射击测试。表2列出了使用不同基线模型和我们的模型在TETS数据集和GDELT数据集上的SMAPE结果,这也是零射击设置,因为在训练阶段没有看到来自这些部门的数据样本。通过对所有部门的结果进行检验,我们提出的模型将时间序列数据与补充摘要(上下文)数据相结合,优于跨领域部门的所有基线方法。此外,我们观察到,与在语言数据集上预训练的变压器相比,基于变压器的架构从头开始训练,专门为时间序列分析量身定制,如PatchTST、Informer和Reformer (Kitaev et al., 2020),往往表现不佳。这种性能差异表明,从预训练语言模型中获得的参数初始化为模型优化提供了更好的起点。因此,这些预先训练的模型在零射击学习环境中表现出增强的能力和适应性。此外,在时间序列数据与其他模式(如文本信息)有很强相关性的情况下,设计一种有效的策略来合并这些不同的模式可能会提高性能。

五、 ANALYSIS

5.1 ABLATION STUDY

所提供的消融研究(表3)提供了提示和分解组件对我们模型性能的影响的关键见解。在此表中,报告了四种情况下不同数据集上的MSE和MAE:原始模型配置(“TEMPO”);未进行提示设计且未进行分解的模型,即“w/o Dec”设置;没有提示设计的模型(’ w/o Pro ‘)和没有分解损耗对齐的模型(’ w/o Dec loss ')。平均而言,排除提示成分会导致模型的预测精度下降,这表明提示是提高模型整体性能的重要因素。忽略分解损失通常会导致模型性能下降。分解损失有助于使用更丰富的历史数据集,从而提高单个分解组件的质量。构件质量的提高对模型的预测精度具有重要意义。请注意,在没有分解支持的情况下单独使用提示设计,在大多数情况下会对骨干模型的性能产生不利影响。这可能是由于难以有效地从具有有限语义信息的原始形式中提示时间序列数据。这些发现强调了在零采样条件下实现可靠预测能力的提示因素和分解因素的本质。

5.2 INTERPRETING MODEL PREDICTIONS

SHAP (SHapley Additive explanation)值作为特征重要性的综合度量,量化每个特征对所有可能特征组合的预测输出的平均贡献。如图2所示,当应用于我们的季节和趋势分解时,来自广义加性模型(GAM)的SHAP值表明季节成分对模型预测的主要影响,这意味着模型对数据中整体重复模式的显著依赖。而ETTm1数据集贡献的方向变化相对稳定。“误差”列中不断上升的值表示模型预测与基本事实之间的差异,表明随着预测长度的增加,模型的准确性可能会下降,这在大多数实验中确实观察到。在这种情况下,STL分解证明是无价的,因为它使我们能够识别和量化每个组件对总体预测的单独贡献,正如SHAP值所示。这种详细的理解可以产生关于预训练的变压器如何解释和利用分解的预处理步骤的关键见解,从而为模型优化和增强提供健壮的基础。天气数据集的SHAP值见图14。

六、 CONCLUSION

本文提出了一种基于软提示的生成变压器TEMPO,它在零间隔时间序列预测中达到了最先进的性能。我们在预先训练的基于transformer的主干中引入提示和季节性趋势分解的新颖集成,以允许模型专注于适当地利用来自不同时间语义组件的知识。此外,我们证明了TEMPO在多模型输入下的有效性,有效地利用了时间序列预测中的上下文信息。最后,通过大量的实验,我们突出了TEMPO在准确性和泛化性方面的优势。值得进一步研究的一个潜在限制是,具有更好数值推理能力的高级法学硕士可能会产生更好的结果。此外,TEMPO在零射击实验中的令人鼓舞的结果为时间序列的有效基础模型提供了思路。

301

301

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?