系列文章目录

ContiFormer:用于不规则时间序列建模的连续时间变压器 NeurIPS 2023

摘要

对不规则时间序列的连续时间动态进行建模对于解释连续发生的数据演变和相关性至关重要。 包括循环神经网络或 Transformer 模型在内的传统方法通过强大的神经架构利用归纳偏差来捕获复杂的模式。 然而,由于其离散特性,它们在推广到连续时间数据范式方面存在局限性。 尽管神经常微分方程(神经常微分方程)及其变体在处理不规则时间序列方面显示出有希望的结果,但它们通常无法捕获这些序列中复杂的相关性。 同时对输入数据点之间的关系进行建模并捕获连续时间系统的动态变化是具有挑战性和要求的。 为了解决这个问题,我们提出了 ContiFormer,它将普通 Transformer 的关系建模扩展到连续时间域,明确地将神经常微分方程的连续动态建模能力与 Transformer 的注意力机制结合起来。 我们从数学上描述了 ContiFormer 的表达能力,并说明,通过函数假设的精心设计,许多专门用于不规则时间序列建模的 Transformer 变体可以作为 ContiFormer 的特例来涵盖。 对合成数据集和真实数据集进行的广泛实验表明,ContiFormer 对不规则时间序列数据具有卓越的建模能力和预测性能。 项目链接为https://seqml.github.io/contiformer/。

一、引言

不规则时间序列在疾病预防、金融决策和地震预测等现实应用中普遍存在[4,27,64]。 它们独特的属性使它们有别于常规时间序列数据。 首先,不规则时间序列数据的特点是不规则生成或不均匀采样、时间间隔可变的观测值,以及由于技术问题或数据质量问题导致的数据缺失,这对传统时间序列分析技术提出了挑战[6, 55] ]。 其次,即使观察结果是不规则采样的,底层数据生成过程也被假定为连续的[30,42,43]。 第三,观察结果之间的关系可能错综复杂且不断演变。 所有这些特征都需要复杂的建模方法,以便更好地理解这些数据并做出准确的预测。

这些数据样本的连续性和复杂的依赖性给模型设计带来了重大挑战。 简单地将时间线划分为相等大小的间隔可能会严重损害数据的连续性[36]。 最近的工作表明,不规则时间序列建模需要底层的连续时间过程[6,30,39,43],这需要建模过程来捕获系统的连续动态。 此外,由于数据流的连续性,我们认为观察到的数据内的相关性也会随着时间的推移而不断变化。 例如,科技巨头(例如MSFT和GOOG)的股价表现出一致的演变趋势,但它们受到短期事件(例如大型语言模型发布)和长期因素的影响。

为了应对这些挑战,研究人员寻求了两个主要的解决方案。 神经常微分方程(神经 ODE)和状态空间模型(SSM)已经展示了捕获系统随时间动态变化的良好能力 [9,19,28,49]。 然而,这些方法忽视了观测值之间的复杂关系,如果迭代次数很多,它们的递归性质可能会导致累积误差[9]。 另一条研究利用了神经网络强大的归纳偏差,例如各种循环神经网络 [6,39,45] 和 Transformer 模型 [38,48,54,60]。 然而,他们使用固定时间编码或学习某些核函数无法捕获复杂的依赖于输入的动态系统。

基于上述分析,在捕获时间动态的同时对观测之间的关系进行建模是一项具有挑战性的任务。 为了解决这个问题,我们提出了一种连续时间 Transformer,即 ContiFormer,它将神经常微分方程的连续动态建模能力融入到 Transformer 的注意力机制中,打破了 Transformer 模型的离散性质。 具体来说,为了捕获观测的动态,ContiFormer 首先为给定的不规则采样数据点中的每个观测定义潜在轨迹。 接下来,为了捕捉复杂但不断演变的关系,它将《变形金刚》中的离散点积扩展到连续时间域,在连续动态之间计算注意力。 通过提出的注意力机制和 Transformer 架构,ContiFormer 可以有效地模拟复杂的连续时间动态系统。

本文的贡献可总结如下。

• 连续时间变压器。 据我们所知,我们是第一个将连续时间机制纳入 Transformer 的注意力计算中的,这是新颖的,并且捕获了不规则采样的时间序列数据的底层系统的连续性。

• 并行建模。 为了解决 Transformer 模型的连续时间计算和并行计算特性之间的冲突,我们提出了一种新颖的重新参数化方法,使我们能够在不同时间范围内并行执行连续时间注意力。

• 理论分析。 我们在数学上描述了各种 Transformer 变体 [34、38、48、54、60] 可以被视为 ContiFormer 的特殊实例。 因此,我们的方法提供了更广泛的范围,包括 Transformer 变体。

• 实验结果。 我们在各种不规则时间序列设置上检查我们的方法,包括时间序列插值、分类和预测。 大量的实验结果表明我们的方法相对于强基线模型具有优越的性能。

二、 Related Work

时间离散模型。 存在一个基于时间离散假设的模型分支,它将时空转换为离散时空。 循环神经网络(RNN)[14, 24] 和 Transformers [51] 是强大的时间离散序列模型,在自然语言处理 [15, 37, 58]、计算机视觉 [20, 63] 和时间方面取得了巨大成功。 系列预测 [31, 35, 52, 53, 56, 61, 62]。 将它们用于不规则的时间序列数据需要将时间线离散化为时间段或填充缺失值,这可能会导致信息丢失并忽视观察间动态。 [13、36、41]。 另一种方法是构建可以利用这些不同时间间隔的模型 [34, 60]。 此外,最近的几种方法还将时间信息编码到特征中,以对不规则采样的时间序列进行建模,包括时间表示方法 [54, 60] 和基于内核的方法 [38],它们允许学习时间动态。 例如,Mercer [54] 将事件嵌入与时间表示连接起来。 尽管取得了这些进步,这些模型仍然不足以捕获依赖于输入的动态系统。

连续时间模型。 其他工作转向连续时间建模范式。 为了克服 RNN 的离散性质,一种不同的策略涉及观察之间隐藏状态的指数衰减 [6, 39]。 然而,这些技术的适用性仅限于连续观察之间指定的衰减动力学[9]。 神经常微分方程是一类利用常微分方程理论来定义神经网络动力学的模型 [9, 27]。 神经 CDE [30] 和神经 RDE [40] 进一步利用受控微分方程 [2, 29] 和粗糙路径理论 [5] 的明确数学来构建连续时间 RNN。 ODE-RNN [43] 将神经 ODE 与门控循环单元 (GRU) [12] 结合起来,对连续时间动态和输入变化进行建模。 然而这些方法通常无法捕捉观察之间不断变化的关系[45]。 CADN [11] 和 ANCDE [26] 通过结合注意力机制来分别捕获时间关系,从而扩展了 ODE-RNN 和神经 CDE。 另一项研究探索使用状态空间模型 (SSM) 来表示连续时间动态系统 [1,18,19,49]。 然而,这些模型采用递归模式,这降低了其效率并可能导致累积错误[9]。 相比之下,我们提出的模型 ContiFormer 利用 Transformer 架构的并行优势,并采用非自回归范式。 此外,研究人员基本上尚未探索将 Transformer 扩展到连续时间域。 这样的扩展为不规则时间序列数据提供了更灵活、更强大的建模能力。

三、 Method

ContiFormer 是一个 Transformer [51] 模型,用于处理具有不规则时间间隔的时间序列数据。 形式上,不规则时间序列定义为 Γ = [ ( X 1 , t 1 ) , … , ( X N , t N ) ] , \Gamma=[(X_{1},t_{1}),\ldots,(X_{N},t_{N})], Γ=[(X1,t1),…,(XN,tN)],,其中观测可能发生在任意时刻,且观测时间点 ω = ( t 1 , … , t N ) \boldsymbol{\omega}=(t_{1},\ldots,t_{N}) ω=(t1,…,tN)的间隔不规则。 X i X_i Xi 是第 i 个观察的输入特征。 我们表示 X = [ X 1 ; X 2 ; . . . , X N ] ∈ R N × d X=[X_{1};X_{2};...,X_{N}]\in\mathbb{R}^{N\times d} X=[X1;X2;...,XN]∈RN×d。

如上所述,同时对输入数据点之间的关系进行建模并捕获连续时间系统的动态变化具有挑战性但要求很高。 为了应对这一挑战,我们提出了一种连续时间 Transformer 架构,如图 1 所示。ContiFormer 的每一层都将不规则时间序列 X 和采样时间 ω 作为输入,并输出一个潜在的连续轨迹,该轨迹捕获底层的动态变化。 系统。 通过这样的设计,ContiFormer将离散观察序列转换到连续时间域。 在每一层,核心注意力模块都采用连续视角,并将普通 Transformer 中的点积运算扩展到连续时间域,这不仅可以对底层连续动态进行建模,还可以捕获不断演变的输入相关过程。 为了更好地理解,每层的描述将省略层索引,以免造成混乱。

在剩下的部分中,我们采用符号 ω 来表示(参考)时间点序列,而 t 是表示查询时间点的随机变量。 矩阵用大写字母表示,除t以外的小写字母表示连续函数。

3.1 Continuous-Time Attention Mechanism

ContiFormer层的核心是提出的连续时间多头注意力(CT-MHA)模块,如图1所示。在每一层,我们首先将输入的不规则时间序列X转换为 Q = [ Q 1 ; Q 2 ; … ; Q N ] Q=[Q_{1};Q_{2};\ldots;Q_{N}] Q=[Q1;Q2;…;QN]对于查询, K = [ K 1 ; K 2 ; … ; K N ] K=[K_{1};K_{2};\ldots;K_{N}] K=[K1;K2;…;KN] 为键, V = [ V 1 ; V 2 ; … ; V N ] V=[V_{1};V_{2};\ldots;V_{N}] V=[V1;V2;…;VN]的值。 在较高层面上,CT-MHA 模块将不规则时间序列输入转换为潜在轨迹,并输出一个连续动态系统,该系统捕获观测值之间随时间演变的关系。 为了实现这一目标,它利用常微分方程来定义每个观测值的潜在轨迹。 在潜在状态内,它假设潜在的动力学遵循线性 ODE 演化。 随后,它通过近似输入的底层样本过程构造连续查询函数。 最终,它产生一个连续时间函数,捕获不断变化的关系并代表复杂的动态系统。

Continuous Dynamics from Observations Transformer 计算查询、键和值的缩放点积注意力 [51]。 在连续形式中,我们首先使用常微分方程来定义每个观测值的潜在轨迹。 具体来说,假设第一个观察值和最后一个观察值分别出现在时间点 t1 和 tN,我们定义连续键和值,其中 t ∈ [ t 1 , t N ] , k i ( ⋅ ) , v i ( ⋅ ) ∈ R d t\in[t_{1},t_{N}],\mathbf{k}_{i}(\cdot),\mathbf{v}_{i}(\cdot)\in\mathbb{R}^{d} t∈[t1,tN],ki(⋅),vi(⋅)∈Rd表示常微分 第 i 个观测的方程,参数为 θ k a n d θ v \theta_{k}\mathrm{~and~}\theta_{v} θk and θv,初始状态分别为 k i ( t i ) a n d v i ( t i ) \mathbf{k}_i(t_i)\mathrm{and}\mathbf{v}_i(t_i) ki(ti)andvi(ti),函数 f ( ⋅ ) ∈ R d ˉ + 1 → R d f\left(\cdot\right)\in\mathbb{R}^{\bar{d}+1}\rightarrow\mathbb{R}^{d} f(⋅)∈Rdˉ+1→Rd控制动力学的变化。

图 1:ContiFormer 层的架构。 ContiFormer 将不规则时间序列及其对应的采样时间点作为输入。 查询、键和值以连续时间形式获取。 注意力机制(CT-MHA)以连续时间的方式执行缩放内积,以捕获观察之间不断变化的关系,从而形成复杂的连续动态系统。 采用前馈和层归一化,类似于Transformer。 最后,采用采样技巧使 ContiFormer 可堆叠。 请注意,紫色突出显示的轨迹表示参与输出计算的函数部分。

查询功能虽然键和值与注意机制的输入和输出相关联,但查询指定从输入中提取什么信息。 为了对动态系统进行建模,可以将查询建模为时间函数,该时间函数表示在特定时间点 t 动态系统输入的总体变化,即 q(t)。 具体来说,我们采用一个常见的假设,即不规则时间序列是底层连续时间过程的离散化。 因此,与[30]类似,我们定义了一个封闭形式的连续时间插值函数(例如,自然三次样条),其结点为 t 1 , … , t N t_1,\ldots,t_N t1,…,tN使得 q ( t i ) = Q i \mathbf{q}(t_i)=Q_i q(ti)=Qi作为基础过程的近似值。

Scaled Dot Product 自注意力机制是 Transformer 架构中的关键组件。 自注意力的核心涉及计算查询和键之间的相关性。 这是通过两个离散形式矩阵的内积来实现的,即 Q ⋅ K ⊤ {Q}\cdot K^{\top} Q⋅K⊤。 将离散内积扩展到连续时间域,给定两个实函数 f(x) 和 g(x),我们将闭区间 [a, b] 中两个函数的内积定义为

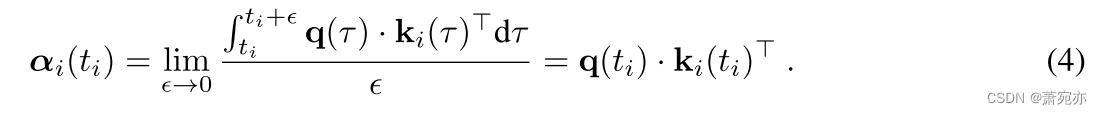

直观上,它可以被认为是量化两个函数在时间间隔内彼此“对齐”程度的一种方法。 受连续时间域内积公式的启发,我们将第 i 个样本与动态系统在时间点 t 的演化关系建模为闭区间 [ti, t 中 q 和 ki 的内积 ], IE。,

由于序列数据的性质,经常会遇到异常点,例如时间差异显着较大的事件。 为了避免训练期间数值不稳定,我们将积分解除以时间差。 因此,等式。 (3) 在

α

i

(

t

i

)

\alpha_i(t_i)

αi(ti) 处表现出不连续性。 为了保证函数

α

i

(

.

)

\alpha_i(.)

αi(.)的连续性,我们将

α

i

(

t

i

)

\alpha_i(t_i)

αi(ti)定义为

期望值 给定查询时间

t

∈

[

t

1

,

t

N

]

t\in[t_{1},t_{N}]

t∈[t1,tN],时间点 t 处的观测值定义为从

t

i

t_i

ti 到 t 的期望值。 不失一般性,它认为在时间

t

i

t_i

ti 采样的观测值的期望值为

v

i

(

t

i

)

o

r

V

i

\mathbf{v}_i(t_i)\mathrm{~or~}V_i

vi(ti) or Vi。 正式地,期望值定义为

多头注意力连续时间注意力机制是机器学习中使用的强大工具,可以对键、查询和值之间复杂的、随时间变化的关系进行建模。 与在离散时间步长上运行的传统注意力机制不同,连续时间注意力通过将输入建模为时间的连续函数,可以对数据进行更细粒度的分析。 具体来说,给定连续时间空间中前额定义的查询、键和值,给定查询时间 t 的连续时间注意力可以正式定义为

多头注意力是注意力机制的扩展[51],允许同时关注不同的输入方面。 它通过减少注意力权重方差来稳定训练。 我们扩展方程。 (6) 通过合并多组注意力权重,即

其中

W

O

,

W

(

h

)

Q

,

W

(

h

)

K

a

n

d

W

(

h

)

V

W^O,W_{(\mathrm{h})}^Q,W_{(\mathrm{h})}^K\mathrm{~and~}W_{(\mathrm{h})}^V

WO,W(h)Q,W(h)K and W(h)V 是参数矩阵,h ∈ [1, H],H 是头数

3.2 Continuous-Time Transformer

尽管 Transformers [51] 在各个研究领域得到广泛采用,但它们对连续时间动态系统建模的扩展尚未得到充分探索。 我们提出 ContiFormer,它直接构建在 vanilla Transformer 的原始实现之上,同时将其扩展到连续时间域。 具体来说,我们在多头自注意力(MHA)和前馈块(FFN)之后应用层归一化(LN)。 我们在下面正式描述 ContiFormer 层的特征

其中

z

l

(

t

)

\mathbf{z}^l(t)

zl(t)是第 l 个 ContiFormer 层在时间点 t 的输出。 此外,我们采用残差连接来避免潜在的梯度消失[23]。 为了将残差连接与连续时间输出结合起来,我们使用基于闭合形式连续时间插值函数的连续函数

x

l

(

t

)

\mathbf{x}^l(t)

xl(t)来近似离散输入

X

l

X^{l}

Xl 的基本过程。

采样过程 如前所述,每个 ContiFormer 层都会导出一个连续函数 z l ( t ) \mathbf{z}^{l}(t) zl(t) w.r.t。 时间作为输出,同时接收离散序列 X l X^{l} Xl作为输入。 然而, z l ( t ) \mathbf{z}^{l}(t) zl(t) 不能直接合并到期望以固定维度向量和序列形式输入的神经网络架构中[48],这在堆叠 ContiFormer 层时设置了障碍。 为了解决这个问题,我们为每层的输出建立参考时间点。 这些点用于离散化层输出,并且可以对应于输入时间点(即 ω)或特定于任务的时间点。 具体来说,假设第l层的参考点为 ω l = [ t 1 l , t 2 l , . . . , t β l l ] , \boldsymbol{\omega}^{l}=[t_{1}^{l},t_{2}^{l},...,{t}_{\beta_{l}}^{l}], ωl=[t1l,t2l,...,tβll],,则下一层Xl+1的输入可以采样为 { z l ( t j l ) ∣ j ∈ [ 1 , β l ] } . \{\mathbf{z}^{l}(t_{j}^{l})|j\in[1,\beta_{l}]\}. {zl(tjl)∣j∈[1,βl]}.。

3.3 Complexity Analysis

我们考虑一个自回归任务,其中特定分类或回归任务需要每个观察的输出。 因此,每层的参考点定义为 ω l = ω \boldsymbol{\omega}^{l}=\omega ωl=ω。

为了保持 Transformer 架构的并行性,同时实现式(1)中的连续时间注意力机制。 (6),我们首先采用时间变量 ODE [8] 将 ODE 重新参数化为单个区间 [−1, 1],然后采用数值逼近方法来逼近积分,即

表 1:每层复杂度 (Comp. per Layer)、最小顺序操作数 (Seq. Op.) 和最大路径长度 (Max. Path Len.)。 N 是序列长度,d 是表示维度,T 是 ODE 求解器在从 t1 到 tN 的单次正向传递中的函数评估 (NFE) 数量,S 表示从 -1 到 1 的 NFE。

其中 P 表示近似积分的中间步骤数, ξ p \xi_{p} ξp ∈ [−1, 1] 且 γ p γ_p γp ≥ 0, k ~ i , j ( s ) = k i ( ( s ( t j − t i ) + t i + t j ) / 2 ) , a n d q ~ i , j ( s ) = q i ( ( s ( t j − t i ) + t i + t j ) / 2 ) \tilde{\mathbf{k}}_{i,j}(s)=\mathbf{k}_{i}\left((s(t_{j}-t_{i})+t_{i}+t_{j})/2\right),\mathrm{and}\tilde{\mathbf{q}}_{i,j}(s)=\mathbf{q}_{i}\left((s(t_{j}-t_{i})+t_{i}+t_{j})/2\right) k~i,j(s)=ki((s(tj−ti)+ti+tj)/2),andq~i,j(s)=qi((s(tj−ti)+ti+tj)/2)。 最后, α i ( t j ) \alpha_{i}(t_{j}) αi(tj)可以通过一次包含 N2 系统的 ODESolver 调用来求解,即

其中 p ∈ [1, …, P] 并且我们进一步定义 Σ0 = −1。 此外,可以通过对闭式连续时间查询函数进行插值来获得

q

~

i

,

j

(

ξ

p

)

\tilde{\mathbf{q}}_{i,j}(\xi_p)

q~i,j(ξp)。 采用类似的方法求解式(1)中的

v

^

i

(

t

j

)

\widehat{\mathbf{v}}_i(t_j)

v

i(tj)。 (5)。 具体实现请参见附录A。

我们考虑三个标准来分析不同模型的复杂性,即每层复杂性、最小顺序操作数和最大路径长度[51]。 每层的复杂性是指在神经网络的单层内进行处理所需的计算资源。 顺序操作是指以迭代或顺序方式处理的操作的执行。 最大路径长度衡量信息建立关系必须遍历的最长距离,反映模型学习远程依赖关系的能力。

如表 1 所示,由于并行注意力机制,vanilla Transformer 是一种有效的序列学习模型,具有 O(1) 顺序操作和 O(1) 路径长度,而 RNN 和神经 ODE 的循环性质依赖于自回归特性和 遭受大量的顺序操作。 利用方程。 (9) 并利用 Transformer 架构中固有的并行性,我们的模型 ContiFormer 实现了 O(S) 顺序操作和 O(1) 路径长度,同时还具有捕获复杂连续时间动态系统的优势。 我们有 S < T,并且在实验中通常设置 S < N。

3.4 Representation Power of ContiFormer

在前面的小节中,我们介绍了一种用于动态系统建模的新颖框架。 那么一个自然的问题是:ContiFormer 有多强大? 我们观察到,通过选择适当的权重,ContiFormer 可以成为普通 Transformer [51] 的扩展。 此外,许多针对不规则时间序列定制的 Transformer 变体,包括时间嵌入方法 [48, 54] 和核化注意力方法 [34, 38],都可以是我们模型的特例。 我们概述了下面的主要定理,并将证明推迟到附录 B。

定理 1(通用注意力近似定理)。 给定查询 (Q) 和密钥 (K) 矩阵,使得 ∥ Q i ∥ 2 < ∞ , ∥ Q i ∥ 0 = d f o r i ∈ [ 1 , . . . , N ] \|Q_{i}\|_{2}<\infty,\|Q_{i}\|_{0}=dfori\in[1,...,N] ∥Qi∥2<∞,∥Qi∥0=dfori∈[1,...,N]。 对于某些注意力矩阵,即 A t t n ( Q , K ) ∈ R N × N \mathrm{Attn}(Q,K)\in\mathbb{R}^{N\times N} Attn(Q,K)∈RN×N(更多信息参见附录 B.1),总是存在一系列连续可微的向量函数 k 1 ( ⋅ ) , k 2 ( ⋅ ) , … , k N ( ⋅ ) \mathbf{k}_{1}(\cdot),\mathbf{k}_{2}(\cdot),\ldots,\mathbf{k}_{N}(\cdot) k1(⋅),k2(⋅),…,kN(⋅),使得连续时间注意力公式的离散定义,即方程中的 [ α 1 ( ⋅ ) , α 2 ( ⋅ ) , . . . , α N ( ⋅ ) ] [\boldsymbol{\alpha}_{1}(\cdot),\boldsymbol{\alpha}_{2}(\cdot),...,\boldsymbol{\alpha}_{N}(\cdot)] [α1(⋅),α2(⋅),...,αN(⋅)]。 (4),由下式给出

如图 2 所示:通过 Transformer、神经 ODE 和我们的模型对具有不规则采样时间点的螺旋进行插值和外推。

四、 Experiments

在本节中,我们在不规则时间序列数据上的三类任务上评估 ContiFormer,即插值和外推、分类、事件预测和预测。 此外,我们还对钟摆回归任务进行了实验[19, 45],结果列于附录C.5。

实现细节 默认情况下,我们使用自然三次样条来构造连续时间查询函数。 ODE 中的向量场定义为 f ( t , x ) = Actfn ( LN ( Linear d , d ( Linear d , d ( x ) + f(t,\mathbf{x})=\text{Actfn}(\text{LN}(\text{Linear}^{d,d}(\text{Linear}^{d,d}(\mathbf{x})+ f(t,x)=Actfn(LN(Lineard,d(Lineard,d(x)+ L i n e a r 1 , d ( t ) ) ) ) \mathrm{Linear}^{1,d}(t)))) Linear1,d(t)))),其中 Actfn(·) 为 tanh 或 sigmoid 激活函数,Lineara,b(·): R a → R b \mathbb{R}^a\to\mathbb{R}^b Ra→Rb是从a维到b维的线性变换,LN表示层归一化。 我们采用高斯-勒让德求积近似来实现等式: (9)。 在实验中,我们选择Runge-Kutta-4 [44](RK4)算法来求解ODE,固定步长为四阶,步长为0.1。 因此,从-1到1(即表1中的S)积分的前向传递次数为80。所有实验均在单个16GB NVIDIA Tesla V100 GPU上进行。

4.1 Modeling Continuous-Time Function

第一个实验研究了不同类别的不同模型在连续时间函数逼近上的有效性。 我们生成了包含 300 个二维螺旋的数据集,在 150 个等距时间点采样。 为了生成不规则的时间点,我们从每个子采样轨迹中随机采样 50 个点,无需放回。 我们可视化不同模型的不规则时间序列的插值和外推结果,即潜在 ODE(带 RNN 编码器)[9]、Transformer [51] 和我们提出的 ContiFormer。 此外,我们在表 2 中列出了使用均方根误差 (RMSE) 和平均绝对误差 (MAE) 指标的插值和外推结果。 更多可视化结果和实验设置可以在附录 C.1 中找到。 如图 2 所示,Latent ODE 和 ContiFormer 都可以输出平滑且连续的函数近似值,而 Transformer 无法在给定噪声观测值的情况下对其进行插值 (1⃝)。 从表 2 中,我们可以观察到我们的模型大幅优于 Transformer 和 Latent ODE。 改进之处在于两个方面。 首先,与 Transformer 相比,我们的 ContiFormer 可以产生几乎 3 个连续时间的输出,使其更适合对连续时间函数进行建模。 其次,与潜在 ODE 相比,我们的 ContiFormer 擅长保留长期信息 (2⃝),从而在推断未见时间序列时降低预测误差。 相反,Latent ODE 容易出现累积误差 (3⃝),导致外推任务的性能较差。 因此,我们得出结论,ContiFormer 是一种更适合对不规则时间序列上的连续时间函数进行建模的方法。

表2:不同模型在二维螺旋上的插值和外推结果。 ↓表示越低越好。

表3:不规则时间序列分类的实验结果。 平均。 ACC。 代表 20 个数据集的平均准确度和 Avg。 Rank 代表 20 个数据集的平均排名。 ↑(↓)表示越高(越低)越好。

4.2 Irregularly-Sampled Time Series Classification

第二个实验根据现实世界的不规则时间序列数据评估我们的模型。 为此,我们首先检查不同模型对不规则时间序列分类的有效性。 我们从 UEA 时间序列分类档案 [3] 中选择了 20 个数据集,这些数据集在时间序列样本的数量、维度和长度方面具有不同的特征。 更详细的信息和实验结果可以在附录C.2中找到。 为了生成不规则的时间序列数据,我们按照[30]的设置随机删除 30%、50% 或 70% 的观测值。

我们将 ContiFormer 与基于 RNN 的方法(GRU-Δt [30]、GRU-D [6])、基于神经 ODE 的方法(ODE-RNN [43]、CADN [10]、神经 CDE [30] ])、基于 SSM 的模型(S5 [49])和基于注意力的方法(TST [57]、mTAN [48])。

表3列出了不同丢弃率下的平均准确率和排名数。 ContiFormer 在所有三种设置上均优于所有基线。 完整的结果见附录C.2.3。 此外,基于注意力的方法比基于 RNN 的方法和基于 ODE 的方法表现得更好,强调了有效建模观测值相互关系的重要性。 此外,我们发现我们的方法比其他模型更稳健。 ContiFormer 的性能差距最小,介于 30% 和 50% 之间。

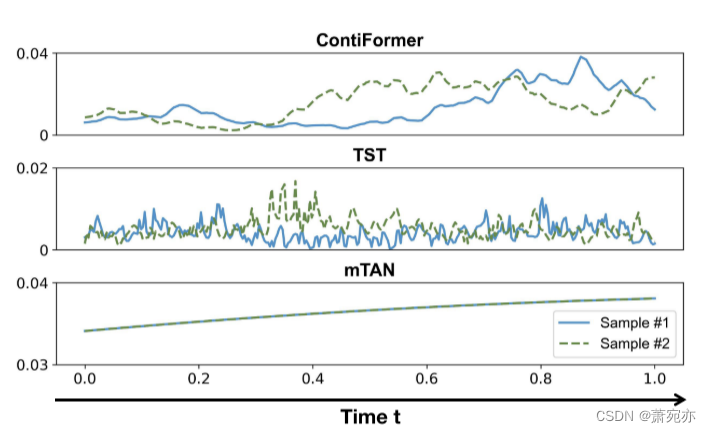

此外,我们还用不同的模型研究了学习到的注意力模式。 注意力通过测量不同时间点不同观察之间的相关性来捕获先前观察对系统未来状态的影响。 因此,预计有效捕获潜在动态的模式将表现出连续、平滑且依赖于输入的中间结果。 如图 3 所示,ContiFormer 和 TST 都能够有效地捕获依赖于输入的模式,而 mTAN 由于其注意力机制仅依赖于时间信息而陷入困境。 此外,与 TST 相比,ContiFormer 擅长捕获复杂且平滑的模式,展示了其有效建模随时间演变的相关性的能力,并且对噪声数据可能更稳健。 因此,我们相信 ContiFormer 更好地捕捉了不规则时间序列的本质。

图 3:UWaveGestureLibrary 数据集上注意力分数的可视化。 颜色表示时间 t = 0 时不同实例的注意力分数。观察时间 t = 0 时的观察并将时间间隔归一化为 [0, 1]。

表 4:事件预测比较模型的预测结果。 LL 表示对数似然,ACC 表示准确性。 ↑(↓)表示越高(越低)越好。 (粗体值表示最佳性能,+表示优于最佳基线至少 3 个标准差。)

4.3 Predicting Irregular Event Sequences

接下来,我们评估不同的模型来预测具有不规则事件序列的下一个事件的类型和发生时间 [7,21,46,47],又名标记时间点过程(MTPP)任务。 为此,我们使用一个合成数据集和五个真实数据集进行评估,即 Synthetic、Neonate [50]、Traffic [32]、MIMIC [16]、BookOrder [16] 和 StackOverflow [33]。 我们对[17]之后的合成、新生儿和交通数据集使用4折交叉验证方案,对[39, 64]之后的其他三个数据集使用5折交叉验证方案。 我们重复实验 3 次,并在表 4 中报告平均值和标准差。有关任务描述、数据集信息和训练算法的更多信息可以在附录 C.3 中找到。 我们首先将 ContiFormer 与不规则时间序列上的 3 个模型进行比较,即 GRU-Δt、ODE-RNN 和 mTAN,它们分别属于基于 RNN、基于 ODE 和基于注意力的方法。 此外,我们还将 ContiFormer 与专门为 MTPP 任务设计的基线进行比较。 这些模型包括参数方法(HP [22])、基于RNN的方法(RMTPP [16]、NeuralHP [39])和基于注意力的方法(SAHP [59]、THP [64]、NSTKA [38])。

实验结果如表 4 所示,证明了 ContiFormer 相对于基线的总体统计优势。 值得注意的是,使用特定的核函数(例如 NSTKA 和 mTAN)会导致某些数据集的性能低于标准,这凸显了它们在现实场景中对复杂数据模式进行建模的局限性。 此外,像 HP 这样的参数方法在大多数数据集上表现不佳,这表明它们在捕捉现实生活复杂性方面存在缺陷。

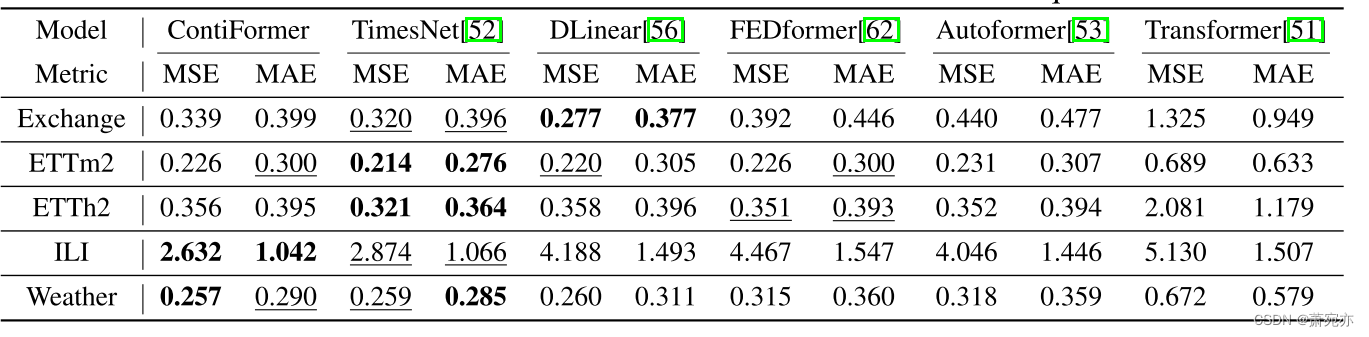

表 5:常规时间序列预测的结果。 ILI 的输入长度为 36,其他输入长度为 96。 ETTm2 和 ETTh2 的预测长度为 {24, 48, 168, 336},Exchange 和 Weather 的预测长度为 {96, 192, 336, 540},ILI 的预测长度为 {24, 36, 48, 60}。 结果是四个预测长度的平均值。 粗体/下划线值表示最佳/次佳。 MSE 代表均方误差。

4.4 Regular Time Series Forecasting

最后,我们在常规时间序列建模的背景下评估 ContiFormer 的性能。 为此,我们按照[53]的实验设置进行了广泛的实验。 我们使用 ETT、Exchange、Weather 和 ILI 数据集来执行时间序列预测任务。 我们将 ContiFormer 与最近最先进的模型(TimesNet [52])、基于 Transformer 的模型(FEDformer[62]、Autoformer[53])和基于 MLP 的模型(DLinear [56])进行比较。 表 5 总结了实验结果。 Contiformer 在 ILI 数据集上取得了最佳性能。 具体来说,它使 MSE 降低了 10% (2.874 → 2.632)。 此外,Contiformer 在 Exchange、ETTm2 和 Weather 数据集上的性能优于 Autoformer 和 FEDformer。 因此,它表明 Contiformer 在常规时间序列预测方面与最先进的模型具有竞争力。 有关结果的更全面的探索,请参阅附录 C.4。

5 Efficiency Analysis

在 ContiFormer 中采用连续时间建模通常会导致大量时间和 GPU 内存开销。 因此,我们将 ContiFormer 的实际时间成本与基于 Transformer 的模型(TST)、基于 ODE 的模型(ODE-RNN、Neural CDE)和基于 SSM 的模型(S5)进行比较分析。 表6显示TST和S5都是有效模型。 此外,ContiFormer 利用并行机制实现更快的推理,与 ODE-RNN 和 Neural CDE 相比,推理速度更快。 此外,即使步长较大,ContiFormer 也表现出有竞争力的性能,如附录 D.3 中详述。 因此,ContiFormer 对步长的稳健性使其能够在时间成本和性能之间实现卓越的平衡。 详情请参阅附录 E。

表 6:在 UEA 数据集的 RacketSports 数据集(下降 0%)上训练不同模型时的实际时间成本。 我们对 ODERNN、Neural CDE 和 ContiFormer 采用 RK4 求解器。 步长是指 RK4 求解器的时间增量量。 ↑(↓)表示越高(越低)越好。

六、 Conclusion

我们提出了 ContiFormer,一种新颖的连续时间 Transformer,用于对不规则时间序列数据的动态系统进行建模。 与现有方法相比,ContiFormer 更加灵活,因为它放弃了底层动力学的显式封闭式假设,从而在各种情况下具有更好的泛化能力。 此外,与神经常微分方程类似,ContiFormer 可以产生连续且平滑的结果。 利用自注意力机制,ContiFormer还可以捕获不规则观测序列中的长期依赖性,在各种不规则时间序列建模任务上取得优异的性能。

50

50

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?