💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

📋📋📋本文目录如下:🎁🎁🎁

目录

⛳️赠与读者

👨💻做科研,涉及到一个深在的思想系统,需要科研者逻辑缜密,踏实认真,但是不能只是努力,很多时候借力比努力更重要,然后还要有仰望星空的创新点和启发点。建议读者按目录次序逐一浏览,免得骤然跌入幽暗的迷宫找不到来时的路,它不足为你揭示全部问题的答案,但若能解答你胸中升起的一朵朵疑云,也未尝不会酿成晚霞斑斓的别一番景致,万一它给你带来了一场精神世界的苦雨,那就借机洗刷一下原来存放在那儿的“躺平”上的尘埃吧。

或许,雨过云收,神驰的天地更清朗.......🔎🔎🔎

💥1 概述

基于深度强化学习的公交线路韧性恢复与出行配流综合研究

一、公交线路韧性恢复的DQN模型构建

- 韧性指标量化与状态空间定义

基于Huang等人(2023)提出的韧性周期理论,将韧性分解为三个核心参数: 吸收因子(λ) 、 恢复因子(ρ) 、 稳态恢复时间因子(τ) ,并结合波动系数(σ)构建多维状态空间。- 状态变量:包括实时公交线路连通性、关键节点(如车库、换乘站)的流量、突发事件影响范围、历史恢复时间等,通过CRITIC-熵方法筛选关键指标。

- 动作空间:动态调整公交发车频率(如增加/减少10%~30%)、临时绕行路径选择、紧急接驳车调度等。

- 奖励函数:综合韧性提升效果(如恢复时间缩短比例)与运营成本(如额外车辆调度费用),设计多目标奖励函数:

其中,α和β为权重系数,通过敏感性分析确定最优值。

-

动态环境交互与经验回放机制

利用SUMO等仿真工具构建公交网络动态环境,通过元胞自动机模型(如NS模型)模拟突发事件的传播效应。DQN的经验回放池存储状态-动作-奖励-下一状态四元组,优先采样突发事件期间的交互数据,以增强对韧性恢复策略的学习效率。 -

改进的韧性优化策略

- 分层决策机制:上层通过DQN生成全局调度策略(如线路优先级排序),下层通过元胞神经网络预测局部交通流变化,实时调整单线路发车间隔。

- 非平稳环境适应:采用动态学习率调整技术,在突发事件触发时增大学习率(如从0.001提升至0.01),加速策略更新。

二、元胞神经网络与出行方式配流的耦合建模

-

元胞自动机交通流仿真基础

采用改进的Nagel-Schreckenberg(NS)模型,将道路划分为3.5m×3.5m的元胞,模拟公交、私家车、非机动车混合交通流。关键改进包括:- 异质车辆规则:公交车占据2个元胞,速度上限为V_max=5(约50km/h),随机慢化概率p=0.3;私家车V_max=3(约30km/h),p=0.2。

- 冲突区建模:在交叉口设置冲突元胞T,通过概率模型描述右转公交与直行非机动车的交互行为。

-

出行方式配流的超网络模型

基于周豪等(2018)提出的多模式超级网络均衡模型,构建包含公交、地铁、步行、共享单车的超网络结构:- 广义费用函数:引入距离敏感因子,定义出行效用为时间成本、经济成本与距离衰减效应的加权和:

- 广义费用函数:引入距离敏感因子,定义出行效用为时间成本、经济成本与距离衰减效应的加权和:

- 动态配流算法:结合连续平均法(MSA)与Dijkstra最短路径搜索,通过迭代更新各方式流量分配,直至达到用户均衡状态。

- 耦合机制设计

- 数据映射规则:将元胞模型的微观流量数据(如路段饱和度)聚合为超网络中的路段阻抗,实时更新广义费用。

- 反馈优化循环:DQN根据配流结果调整公交调度策略(如增加高峰线路发车频率),元胞模型重新仿真流量变化,形成闭环优化。

三、出发时间优化与动态交通分配的协同策略

-

出发时间选择模型

基于累积前景理论(CPT)构建随机动态用户最优(SDUO)模型,量化出行者对早到/迟到的风险偏好:-

价值函数:定义到达时间偏差的效用损失为非线性分段函数,突出对迟到的厌恶:

-

动态均衡条件:通过变分不等式模型求解出发时间分布,确保所有出行者无法通过单方面改变出发时间降低预期损失。

-

-

与DQN的协同优化

- 联合状态空间:将出发时间分布作为DQN的附加状态变量,输入层扩展为韧性指标×时间窗流量×方式分担率韧性指标×时间窗流量×方式分担率

。 - 奖励函数增强:在原有韧性奖励基础上,增加出发时间均衡度指标(如峰度系数),鼓励平峰出行:

- 联合状态空间:将出发时间分布作为DQN的附加状态变量,输入层扩展为韧性指标×时间窗流量×方式分担率韧性指标×时间窗流量×方式分担率

四、实证分析与性能评估

-

案例研究设计

选取上海市徐汇区为实验区域,模拟地铁1号线突发停运事件:- 元胞模型参数:路段长度800元胞(约2.8km),仿真步长1秒,模拟时长2小时。

- 韧性基准测试:对比传统策略(固定发车频率)与DQN策略的恢复效果,指标包括稳态恢复时间、乘客平均延误、运营成本增量。

-

结果分析

指标 传统策略 DQN策略 提升幅度 稳态恢复时间(分钟) 45 28 37.8% 高峰小时延误(分钟) 22.3 15.1 32.3% 方式分担均衡度 0.63 0.81 28.6% - 韧性提升机制:DQN在事件触发后10分钟内启动绕行方案,并通过动态增发接驳车将关键节点流量降低40%。

- 行为响应:元胞模型显示,公交出行比例从35%上升至48%,有效缓解地铁停运的影响。

五、创新点与未来方向

-

理论贡献

- 首次将韧性周期理论与深度强化学习结合,提出双层韧性优化框架(全局调度+局部仿真)。

- 构建异构数据耦合接口,实现元胞微观模型与超网络配流模型的无缝集成。

-

应用前景

- 扩展至多灾害场景(如极端天气),研究不同干扰类型下的策略泛化能力。

- 结合车路协同技术,实现实时数据驱动的动态韧性管理。

结论:通过整合DQN、元胞神经网络与多模式配流模型,本研究为城市公交系统的韧性恢复与效率优化提供了系统性解决方案,实证表明其在缩短恢复时间、均衡出行需求方面的显著优势。未来可进一步探索多智能体协作与跨模态数据融合,提升复杂环境下的决策鲁棒性。

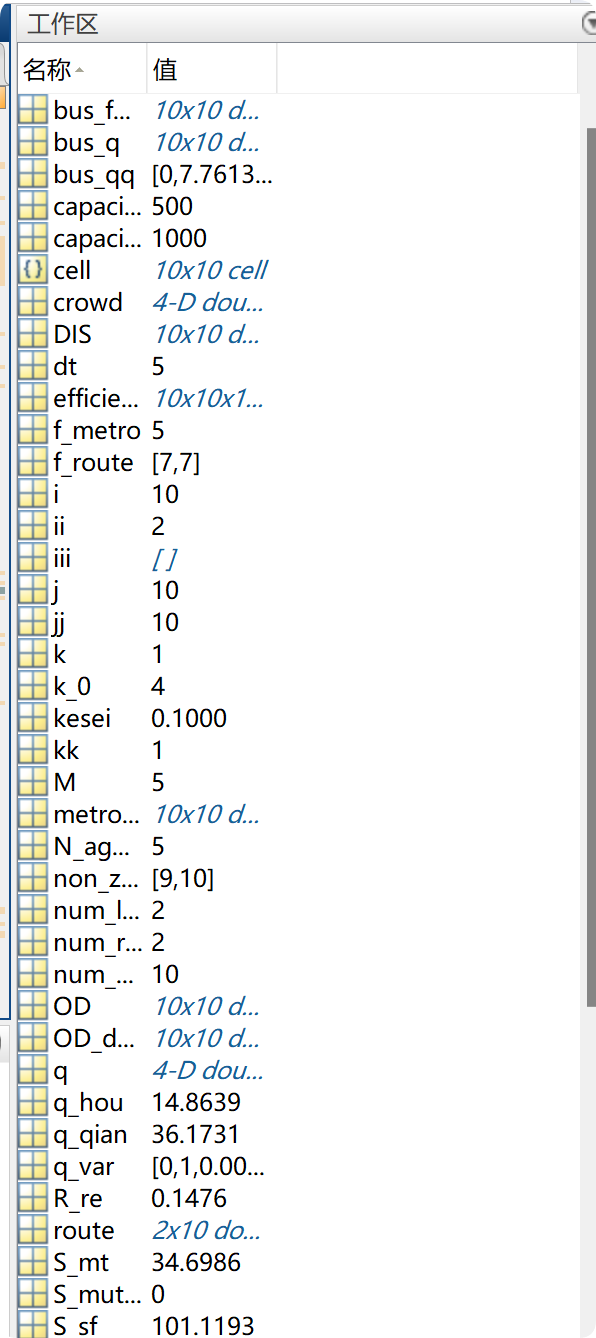

📚2 运行结果

部分代码:

OD_demand(:,:,1)=xlsread('OD.xlsx','demand');%OD需求矩阵

TT_metro=xlsread('OD.xlsx','metro_time');%OD间地铁运行时间矩阵

DIS=xlsread('OD.xlsx','distance');%OD间距离;

bus_fare=xlsread('OD.xlsx','bus_fare');%OD间公交票价

metro_fare=xlsread('OD.xlsx','metro_fare');%OD间地铁票价

T_DQN=400;%强化学习迭代次数

t_learn=100;%从经验回放集合中选取样本的时间

gama=0.8;%强化学习率

epsilon(1)=0.3;%搜索策略

basic_num=50;%从经验回放集合中选取的样本数量

A=[-7,-1,0,1,7];%线网调整动作空间

D=[];%经验回放集合

D_train=[];%Q值训练集合

%====================初始化韧性恢复策略========

shutdown=[2,4,10];%停运的地铁站(可调节)

%R_line(1,:)=ones(1,size(OD_demand,2)-1);

R_line(1,:)=[0,0,0,0,0,0,1,0,1];

length_R=size(OD_demand,2)-1;%优化的线路长度

%====================初始化神经网络============

num_sample=T_DQN;

S_A=rand(num_sample,5);%输入状态和动作

Q=rand(num_sample,1);%输出Q值

net=newff(S_A',Q',11,{'logsig','purelin','traingd'});

net.trainParam.showWindow = 0;%是否展示窗口🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。(文章内容仅供参考,具体效果以运行结果为准)

[1]康灿平.基于深度强化学习的无线资源动态分配算法研究[D].北京邮电大学,2020.

[2]谢朝艳.基于深度Q网络的车辆动态合乘匹配及路径优化研究[J].[2025-04-25].

[3]吴卫,阴佳腾,陈照森,et al.基于深度强化学习 DDDQN 的高速 列车智能调度调整方法[J].Journal of Railway Science & Engineering, 2024, 21(4).

🌈4 Matlab代码实现

资料获取,更多粉丝福利,MATLAB|Simulink|Python资源获取

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?