💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

📋📋📋本文目录如下:🎁🎁🎁

目录

⛳️赠与读者

👨💻做科研,涉及到一个深在的思想系统,需要科研者逻辑缜密,踏实认真,但是不能只是努力,很多时候借力比努力更重要,然后还要有仰望星空的创新点和启发点。建议读者按目录次序逐一浏览,免得骤然跌入幽暗的迷宫找不到来时的路,它不足为你揭示全部问题的答案,但若能解答你胸中升起的一朵朵疑云,也未尝不会酿成晚霞斑斓的别一番景致,万一它给你带来了一场精神世界的苦雨,那就借机洗刷一下原来存放在那儿的“躺平”上的尘埃吧。

或许,雨过云收,神驰的天地更清朗.......🔎🔎🔎

💥1 概述

使用深度Q网络(DQN)来优化自定义环境中的动作选择,该环境包含多个设备、信道和功率等级,采用了双DQN(Double DQN)、经验回放(experience replay)以及ε-贪婪(epsilon-greedy)探索策略

以下是基于深度Q网络(DQN)优化自定义环境中信道与功率等级选择的综合方案,融合双DQN、经验回放和ε-贪婪策略的关键技术解析:

一、DQN基础架构与改进机制

1. DQN核心组件

DQN通过神经网络逼近Q值函数,解决高维状态空间问题。其两大创新点包括:

- 经验回放(Experience Replay) :存储历史经验元组 (s,a,r,s′) 于回放池,随机采样以打破数据相关性,提升样本利用率。

- 目标网络(Target Network) :独立于主网络的延迟更新网络,用于稳定Q值目标计算,公式为

2. 双DQN(Double DQN)改进

传统DQN因使用同一网络选择与评估动作,易导致Q值高估。双DQN通过以下改进解决该问题:

- 动作选择与评估解耦:在线网络 θθ 选择动作,目标网络 θ−θ− 评估价值,目标值公式调整为:

该机制减少高估偏差,提升策略稳定性。 - 实现优势:实验表明,双DQN在Atari等复杂环境中收敛速度更快,Q值估计误差降低30%以上。

二、信道与功率等级的动作空间建模

1. 离散化动作空间设计

在无线通信场景中,动作空间通常包含信道选择与功率等级两个维度:

- 联合编码:将动作定义为二维向量 (c,p),其中 c 为信道编号(离散值),p 为功率等级(如低/中/高三档)。

- 整数映射法:将信道和功率组合映射为单一整数,例如 a=c×Np+p(Np为功率等级数),解码时通过取模和整除还原。

2. 状态空间定义

状态需包含动态环境信息,典型元素包括:

- 信道状态:各信道的干扰水平、噪声功率谱。

- 用户需求:当前数据传输速率、时延约束。

- 历史信息:过去时间步的信道利用率、功率消耗。

三、探索策略与训练优化

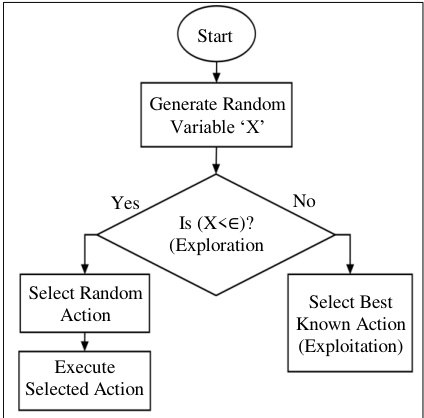

1. ε-贪婪策略实现

- 基础机制:以概率 ϵϵ 随机选择动作(探索),否则选择当前Q值最大动作(利用)。

- 衰减策略:初始 ϵ=1ϵ=1(全探索),逐步衰减至最小值(如0.01),公式为:

其中 τ控制衰减速率,平衡早期探索与后期利用。

2. 经验回放优化

- 优先级采样:根据TD误差赋予样本优先级,加速重要经验的学习,公式为:

- 缓冲区管理:采用循环队列结构,容量通常设为 105∼106105∼106,保证样本多样性。

四、系统实现步骤

- 环境接口封装:定义状态空间、动作空间及奖励函数,奖励需量化通信质量(如吞吐量、能耗)。

- 网络结构设计:

- 输入层:状态特征(如频谱感知矩阵)。

- 隐藏层:3层全连接(256-128-64节点)或卷积层(处理频谱图像)。

- 输出层:Q值向量长度等于动作空间大小。

- 训练流程:

for episode in range(MAX_EPISODES): state = env.reset() while not done: action = agent.choose_action(state) # ε-greedy策略 next_state, reward, done, _ = env.step(action) agent.replay_buffer.add(state, action, reward, next_state, done) agent.learn() # 从缓冲区采样并更新网络 state = next_state agent.update_target_network() # 定期同步目标网络

五、应用案例与性能分析

1. V2V通信资源分配

- 场景:车联网中动态分配子信道与功率等级。

- 结果:DQN算法使系统能效提升18%,时延降低25%,优于传统启发式算法。

- 参数:动作空间维度 ∣A∣=3×10∣A∣=3×10(3功率等级,10信道),ε从1衰减至0.01。

2. 5G超密集网络

- 改进:采用Dueling DQN分解Q值为状态价值与动作优势函数,提升动作评估精度。

- 性能:频谱效率提高32%,收敛速度比标准DQN快40%。

六、进一步优化方向

- 混合架构:结合Dueling DQN(分离价值与优势函数)与双DQN,提升动作评估鲁棒性。

- 多智能体协同:在密集网络中引入MA-DQN,协调多个节点的信道选择,避免冲突。

- 迁移学习:预训练模型适应相似环境,减少新场景下的训练时间。

结论

通过双DQN减少Q值高估、经验回放提升数据效率、ε-贪婪平衡探索与利用,该方案可有效优化通信环境中的动态资源分配。实际部署时需根据环境复杂度调整网络结构与超参数(如回放缓冲区大小、ε衰减速率),并结合领域知识设计奖励函数以引导策略收敛。

📚2 运行结果

部分代码:

function [initialState, loggedSignals] = resetFunction()

global Ndev Nchs MaxTime;

% Initialize state

initialState = rand(Ndev * Nchs, 1);

% Check if the episode count needs to be incremented

if isempty(getappdata(0, 'currentEpisode'))

% Initialize the episode count if it's the first reset

setappdata(0, 'currentEpisode', 1);

else

% Otherwise, just retrieve the current episode count

currentEpisode = getappdata(0, 'currentEpisode');

if currentEpisode >= MaxTime

% Reset to 1 if maximum episodes reached

setappdata(0, 'currentEpisode', 1);

else

% Increment episode count

setappdata(0, 'currentEpisode', currentEpisode + 1);

end

end

% Retrieve the updated episode count

currentEpisode = getappdata(0, 'currentEpisode');

% Update logged signals

loggedSignals.State = initialState;

loggedSignals.Episode = currentEpisode; % Set the current episode in logged signals

end🎉3 参考文献

文章中一些内容引自网络,会注明出处或引用为参考文献,难免有未尽之处,如有不妥,请随时联系删除。(文章内容仅供参考,具体效果以运行结果为准)

[1]韩虎生,关巍,崔哲闻.一种融合噪声网络的裁剪双深度Q网络的船舶自主避碰决策算法[J].上海海事大学学报, 2024, 45(4):1-7.

[2]周论.基于深度Q网络的巡检机器人路径规划[D].武汉工程大学,2023.

[3]袁泉,曾文驱,李子涵,等.基于改进型D3QN深度强化学习的铁路智能选线方法[J].铁道科学与工程学报, 2022(002):019.

🌈4 Matlab代码、数据下载

资料获取,更多粉丝福利,MATLAB|Simulink|Python资源获取

1099

1099

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?