来源:3DCV

添加小助理:cv3d008,备注:方向+学校/公司+昵称,拉你入群。文末附3D视觉行业细分群。

「3D视觉从入门到精通」知识星球,星球内凝聚了众多3D视觉实战问题,以及各个模块的学习资料:近20门独家秘制视频课程、最新顶会论文、计算机视觉书籍、优质3D视觉算法源码等。想要入门3D视觉、做项目、搞科研,欢迎加入!

0. 这篇文章干了啥?

自主探索和场景理解是推动机器人系统发展的关键能力。传统上,探索依赖于几何地图来辅助导航和避障。然而,要增强机器人的自主性,就必须全面理解环境的语义信息。度量语义同时定位与地图构建(SLAM)作为一种关键解决方案应运而生,它提供了几何和语义环境感知的双重视角。这对于从室内服务机器人到大规模户外探索的广泛应用来说是无价的。然而,当前的方法在SLAM过程中往往采用被动机器人运动控制,限制了动态探索的潜力。

在以往的机器人探索文献中,基于信息论的方法是有前景的解决方案,展示了促进快速探索和最小化地图不确定性的能力。然而,这些方法通常将主动建图问题与定位问题分开处理,即假设定位误差已经解决。这一假设在实际场景中可能会引入限制,如由于SLAM误差导致的路径规划受损和语义地图中对象标签错误,导致机器人抓取错误的对象。

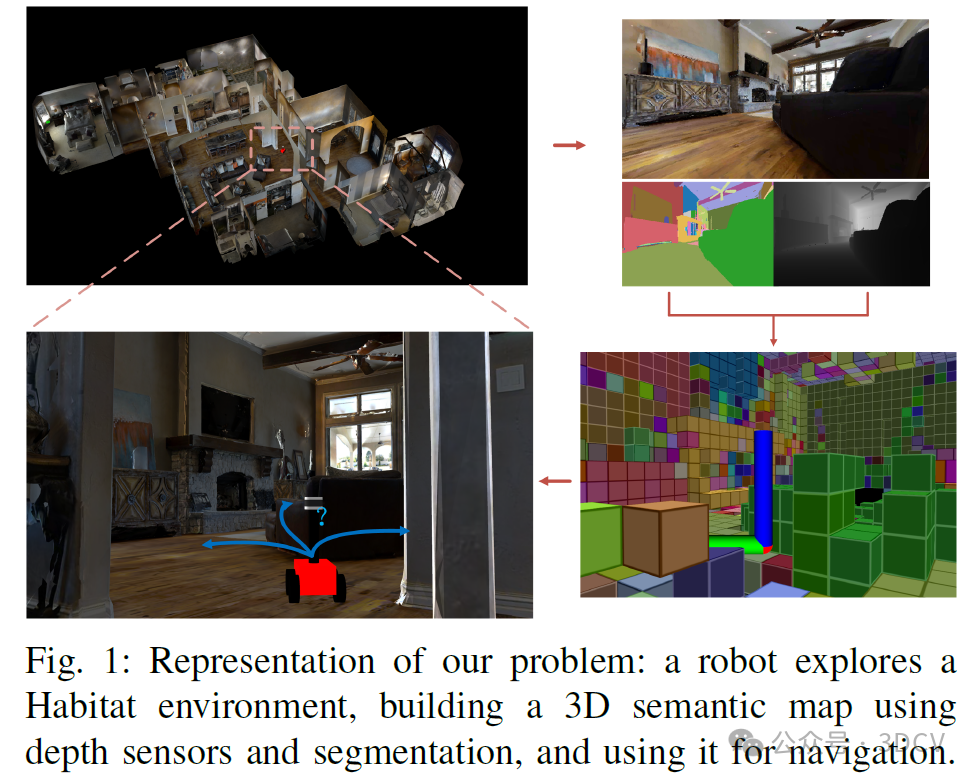

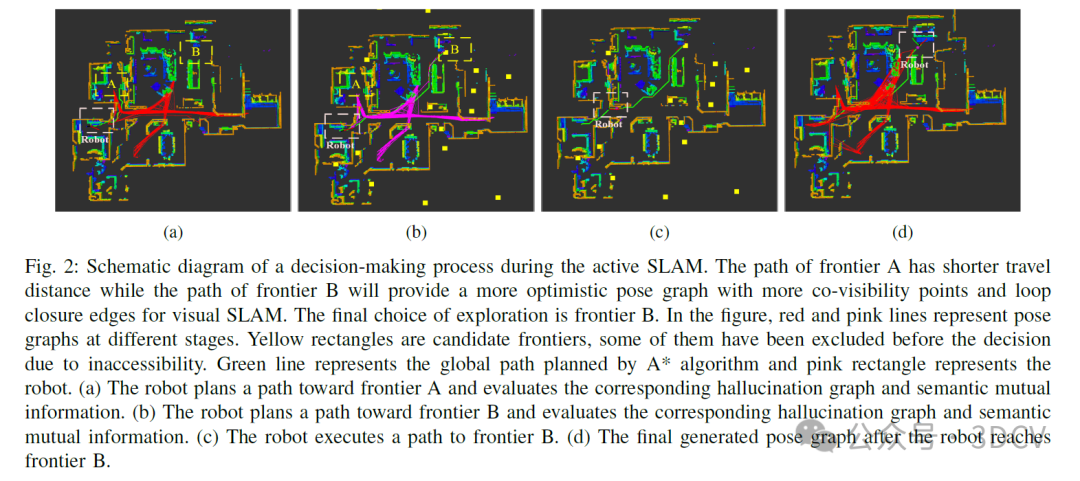

鉴于这些不足,本文重点研究主动度量语义SLAM。我们的方法通过将定位不确定性纳入探索过程,扩展了现有的基于信息论的二进制或多类主动建图方法。我们维护了一个姿态图,并利用了一种受近期谱图论进展启发的姿态图不确定性新型定量度量。通过分析语义互信息和底层姿态图拓扑结构,我们能够评估不同潜在轨迹的最大增益,从而在保持高效探索的同时,实现更高质量的定位和语义建图(如图1所示)。

下面一起来阅读一下这项工作~

1. 论文信息

标题:Active Semantic Mapping and Pose Graph Spectral Analysis for Robot Exploration

作者:Rongge Zhang, Haechan Mark Bong, Giovanni Beltrame

机构:Polytechnique Montr´eal

原文链接:https://arxiv.org/abs/2408.14726

代码链接:https://github.com/BohemianRhapsodyz/semantic_exploration

2. 摘要

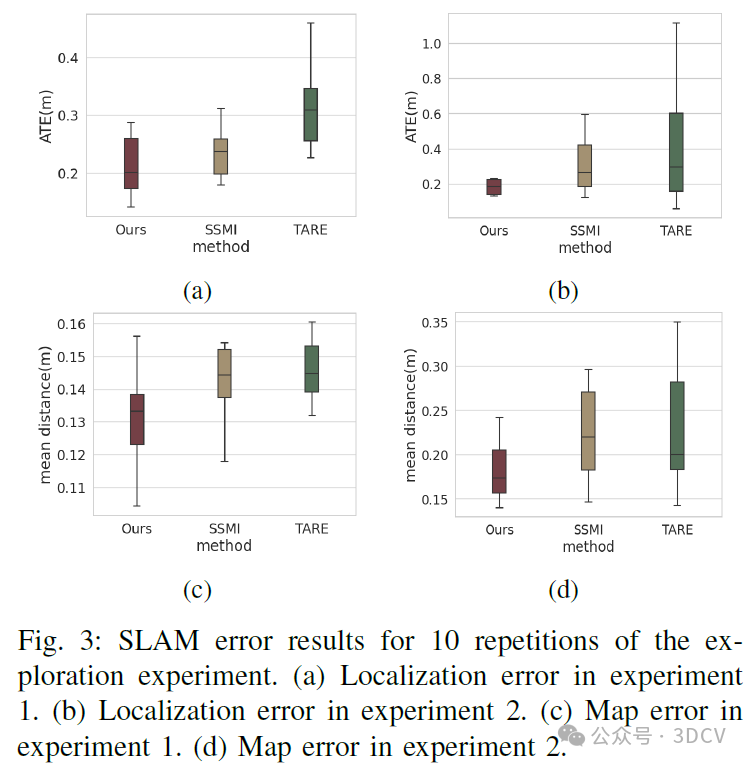

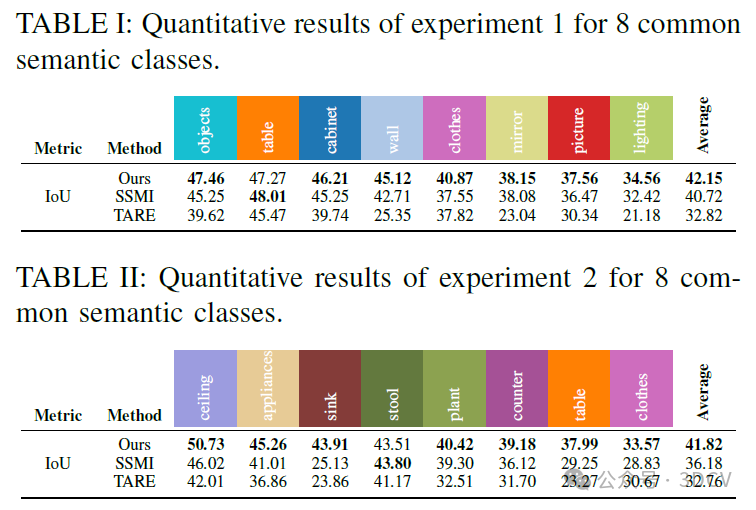

未知和非结构化环境中的探索是机器人应用的关键要求。机器人的探索行为会受到其同时定位和地图绘制(SLAM)子系统性能的内在影响,尽管SLAM和探索通常是分开研究的。在本文中,我们将探索表述为一个主动映射问题,并用语义信息对其进行扩展。我们介绍了一种新的主动度量-语义SLAM方法,利用信息论和谱图理论的最新研究进展:我们结合语义互信息和SLAM子系统底层姿态图的连通性度量。我们使用由此产生的效用函数来评估不同的轨迹,以在探索过程中选择最有利的策略。实验中分析了探索和SLAM度量。在栖息地数据集上运行我们的算法,我们表明,在保持接近最先进的探索方法的效率的同时,我们的方法有效地提高了度量语义SLAM的性能,平均地图误差减少了21%,平均语义分类精度提高了9%。

3. 效果展示

4. 主要贡献

综上所述,本文的主要贡献包括:

一种用于自主机器人探索的在线决策主动SLAM新方法;

一种用于主动机器人感知和场景理解的实时度量语义建图系统;

一种结合语义互信息增益和定位不确定性的混合表示,以指导机器人的行动策略;推荐课程:室内、室外激光SLAM关键算法、代码和实战剖析

我们通过在逼真的环境中进行大量实验来展示我们方法的性能,我们的实现已公开在:https://github.com/BohemianRhapsodyz/semantic_exploration。

5. 实验结果

6. 总结 & 未来工作

在本文中,我们提出了一种实时主动度量语义SLAM方法,以实现高效准确的机器人探索。我们的方法不仅评估了三维空间中语义信息增益最大的路径,还集成了机器人状态不确定性的影响。通过将大型密集型FIM(Fisher Information Matrix)的计算转化为对底层姿态图拓扑结构的分析,实现了在线规划。Shannon-Rényi形式的熵避免了不同量级的不确定性,从而在探索和利用之间实现了自主平衡。与包括SSMI和TARE在内的先进探索方法相比,验证了我们的实现性能。对语义不确定性的研究对于计算机视觉任务也具有重要意义,例如减轻数据和场景变化引起的领域偏移影响。我们的实现还可以用于具有三维路径规划器的空中机器人探索。未来的工作将集中在频谱图稀疏化以加速探索上。我们也对推广到多机器人探索和进行实地实验感兴趣。

对更多实验结果和文章细节感兴趣的读者,可以阅读一下论文原文~

本文仅做学术分享,如有侵权,请联系删文。

7、35个顶会论文的课题如下

1、基于环境信息的定位,重建与场景理解

2、轻是级高保真Gaussian Splatting

3、基于大模型与GS的 6D pose estimation

4、在挑战性遮挡环境下的GS-SLAM系统研究

5、基于零知识先验的实时语义地图构建SLAM系统

6、基于3DGS的实时语义地图构建

7、基于文字特征的城市环境SLAM

8、面向挑战性环境的SLAM系统研究

9、特殊激光传感器融合视觉的稠密SLAM系统

10、基于鲁棒描述子与特征匹配的特征点法SLAM

11、基于yolo-world的语义SL系统

12、基于自监督分割的挑战性环境高斯SLAM系统

13、面向动态场景的视觉SLAM系统研究

14、面向动态场景的GS-SLAM系统研究

15、集成物体级地图的GS-SLAM系统

16、挑战场景下2D-2D,2D-3D或3D-3D配准问题

17、未知物体同时重建与位姿估计问题类别级或开放词汇位姿估计问题

18、位姿估计中的域差距问题

19、可形变对象(软体)的实时三维重建与非刚性配准

20、机器人操作可形变对象建模与仿真

21、基于图像或点云3D目标检测、语义分割、轨迹预测.

22、医疗图像分割任务的模型结构设计

23、多帧融合的单目深度估计系统研究

24、复杂天气条件下的单目深度估计系统研究高精度的单目深度估计系统研究

25、基于大模型的单目深度估计系统研究

26、高精度的光流估计系统多传感器融合的单目深度估计系统研究

27、基于扩散模型的跨域鲁棒自动驾驶场景理解

28、水下图像复原/增强

30、Real-World图像去雾(无监督/物理驱动)

31、LDR图像/视频转HDR图像/视频

32、光场图像增强/复原/超分辨率

33、压缩后图像/视频的增强/复原

34、图像色彩增强(image retouching)

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?