文章汇总

流程解读

作者提出两个方法,方法思路很好,容易插入到自己的baseline,可惜代码没开源。

Part Discovery Network

将给定图像

x

x

x随机裁剪成

n

n

n个patches

{

x

i

p

}

i

=

1

n

\{x_i^p\}^n_{i=1}

{xip}i=1n,但是里面有些patch是与图像不相关的,比如说背景,所以作者想剔除这些patch,换句话说作者想保留最能代表该图片的那些patches。

思路如下:挑选一些不相关的负样本,这些有代表性的patches应该能够将原始图像与其他图像区分开来,因此它与其他图像的距离应该非常大。

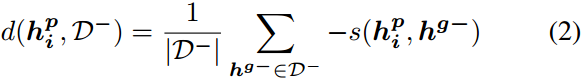

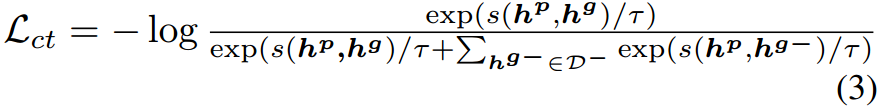

距离计算公式如下:

其中

∣

D

−

∣

|D^-|

∣D−∣是这个集合中负样本的个数,

s

s

s是余弦相似度。

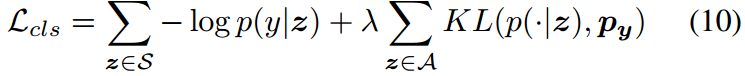

Part Augmentation Network

从损失函数看,涉及到支持集

S

S

S和增广集

A

A

A。

∑

z

∈

S

−

l

o

g

p

(

y

∣

z

)

\sum_{z\in S}{-log\ p(y|z)}

∑z∈S−log p(y∣z)是正常的分类损失。

∑

z

∈

A

K

L

(

p

(

⋅

∣

z

)

,

p

y

)

\sum_{z\in A}{KL(p(\cdot|z),p_y)}

∑z∈AKL(p(⋅∣z),py)是额外利用增广集

A

A

A添加的损失。

作者在

D

b

a

s

e

D^{base}

Dbase的第

k

k

k类图像中,通过Part Discovery Network的GAP模块,选择分类概率最高的

N

a

N_a

Na张图像,最终组成增广集。作者认为这些图像更有可能包含相关的部分。接着让这些部分经过

C

2

A

M

C^2AM

C2AM得到

A

k

=

{

z

i

k

}

i

=

1

N

a

A_k=\{z^k_i\}^{N_a}_{i=1}

Ak={zik}i=1Na。

对增广集的标签做如下变化

我们将一个one-hot标签

y

y

y转换为一个平滑的概率分布

p

y

p_y

py:

摘要

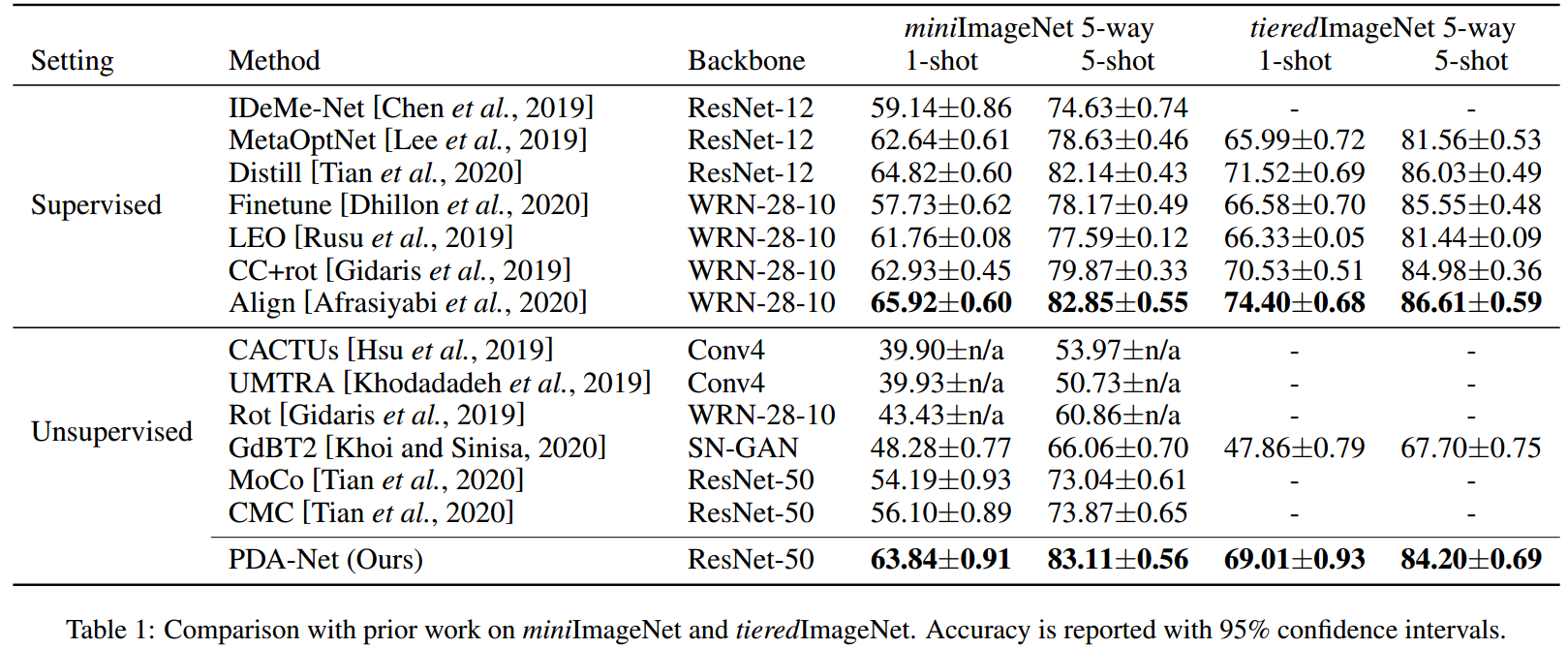

少样本学习是一项具有挑战性的任务,因为只有很少的实例可以用来识别未见过的类。缓解这个问题的一种方法是通过类似任务的元学习获得强归纳偏见。在本文中,我们证明了这种归纳偏差可以从未标记图像的平面集合中学习,并实例化为可见类和未见类之间的可转移表示。具体来说,我们提出了一种新的基于部分的自监督表征学习方案,通过最大化图像与其判别部分的相似性来学习可转移表征。为了缓解由于数据稀缺性导致的少样本分类中的过拟合问题,我们进一步提出了一种从基础数据集中检索额外图像的部分增强策略。我们对miniImageNet和tieredImageNet基准进行了系统的研究。值得注意的是,我们的方法产生了令人印象深刻的结果,在5-way 1-shot和5-way 5-shot设置下,我们的方法比之前最好的无监督方法分别高出7.74%和9.24%,这与最先进的监督方法相当。

1 介绍

最近,深度学习在计算机视觉领域取得了很大的进展,而深度学习通常需要大量的训练数据。不幸的是,在许多实际应用中,收集数据是非常困难的。为了用很少的例子来学习一个新概念,最近提出了“少样本学习”方法,并引起了广泛的关注。[Doersch等,2020;少样本学习的一个可能解决方案是元学习[Finn等人,2017;Vinyals et al, 2016;Ravi and Larochelle, 2017;Snell等,2017;Peng et al ., 2019]。它首先从许多相似的任务中提取共享的先验知识。之后,这些知识将被适应到目标的少样本学习任务中,以限制假设空间,这使得用很少的例子学习一个新的概念成为可能。利用神经网络,先验知识可以被参数化为嵌入函数,也可以被参数化为的一组一个网络初始参数,通常需要一个额外的标记基础数据集进行训练。另一项工作是基于迁移学习[Tian et al ., 2020;Dhillon等人,2020],它提取先验知识作为预训练的特征提取器。通常,使用标准的交叉熵损失来预训练特征提取器,这也需要一个标记的基础数据集。然而,收集大型标记数据集是费时费力的。此外,在执行目标少少样本学习任务时,这些标签会被丢弃,因为它们属于不同的类空间。受最近无监督学习进展的启发,人们自然会提出一个问题:我们能否仅从未标记的图像中学习先验知识?如果是,对于有许多未标记图像可用但目标任务数据稀缺的场景,这将是一种很有前途的方法。

一些杰出的工作已经为此做出了努力,例如,无监督元学习[Hsu等人,2019;Khodadadeh等人,2019]。然而,与有监督的方法相比,这些无监督的方法受到从图像中学习有效的类相关表示的阻碍。这是因为许多不相关或干扰信息,例如背景杂乱,可能会对无标签无监督设置下的表示学习产生不利影响。在表示学习过程中,选择有区别的图像区域或目标部分是减少这种干扰的有效方法,其动机与传统的基于部分的模型是一致的[Felzenszwalb等,2009]。

在本文中,我们提出了一个基于部分的自监督学习模型,即部分发现网络(PDN),以从未标记的图像中学习更有效的表示。该模型的关键是从图像中挖掘可识别的目标部位。由于缺乏部分标签,首先通过随机裁剪提取多个图像区域,这些区域不可避免地包含干扰背景或信息较少的区域。为了消除这些区域,我们选择图像区域作为最具判别性的目标部分,它与其他图像(负样本)保持最大的平均距离。这种选择的基本原理是判别部分应该能够将原始图像与其他图像区分开来[Singh et al ., 2012],因此它与其他图像的平均距离应该足够大。对于选择的判别部分,我们以类似于[He et al ., 2020]的方式最大化其与原始图像的相似度。

在少样本场景中的另一个挑战是由于支持训练样本的稀缺性,目标分类器容易出现过拟合。防止过拟合的有效方法是数据增强,这已经在少数几个学习文献中进行了探讨[Schwartz等人,2018;Wang et al ., 2018]。然而,这些方法中的大多数都假设可见类的方差可以直接转移到不可见类,这在大多数情况下过于严格。在本文中,基于相似对象通常具有一些共同部分的事实,我们采用从基础数据集中检索额外的图像并提取其部分特征来增强支持集。该方法的核心是在支持集中选择与图像特征匹配较好的部分特征。具体来说,我们提出了一种新的类竞争注意图(Class-Competitive Attention Map, c2am)来指导从检索到的图像中选择相关的部分,然后用这些选择的部分来改进目标分类器。我们的方法也被称为部分增强网络(PAN),图1说明了PAN的主要思想。

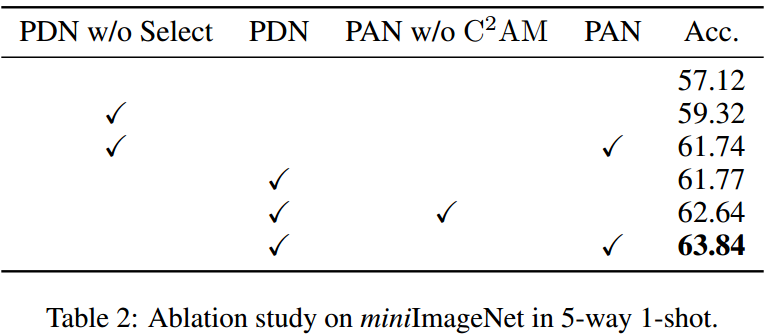

我们的由PDN和PAN组成的局部发现和增强网络(PDANet)在很大程度上优于目前最先进的无监督少镜头学习方法,并且与大多数有监督学习方法取得了相当的结果。本工作的贡献可以总结为:

•我们提出了一种新颖的自监督部分发现网络,它可以从未标记的图像中学习更有效的表示,进行少量学习。

•我们提出了一个部分增强网络,以增强具有相关部分特征的少数支持示例,从而减轻了过拟合并导致更准确的分类边界。

•我们的方法在两个标准的少样本学习基准上优于以前的无监督方法。值得注意的是,我们的无监督PDA-Net也可以与有监督的方法相媲美。

2 相关工作

短期学习

少样本学习的目的是从很少的例子中学习一个新的概念。一个可能的解决方案是元学习,它从许多类似的任务(情节)中提取先验知识。例如,MAML [Finn等人,2017]学习网络的最优初始参数,可以通过梯度下降快速适应新任务。匹配网络[Vinyals等人,2016]根据学习嵌入空间中最近的标记邻居对实例进行分类。与元学习不同的是,[Dhillon等人,2020]证明了强大的迁移学习基线可以实现竞争性绩效。为了训练模型,上述所有方法都需要一个大的标记基础数据集。

无监督元学习方法通过从未标记的图像构建训练集来摆脱这种约束。[Hsu等人,2019]提出通过在无监督特征空间中聚类来获取伪标签。[Khodadadeh等人,2019]使用随机抽样和增强来创建合成剧集。我们的方法旨在从未标记的图像中学习更有效的表示,并通过数据增强来增加对无监督少镜头学习的支持集。

Self-Supervised学习

自监督学习旨在利用未标记的图像来学习下游任务的良好表示。以前的工作主要集中在从未标记数据中挖掘监管信号[Gidaris等人,2018;Doersch等,2015;张等,2016]。最近,对比学习显示出优异的性能提升,它最大化了同一图像的两个不同视图在全局层面上的相似性[Chen et al ., 2020]或局部层面上的相似性[Ouali et al ., 2020],或强制两个视图之间的聚类分配一致性[Caron et al ., 2020]。在本文中,我们明确地挖掘判别部分进行对比学习,从未标记的图像中学习更有效的表征。

少样本学习的数据增强

处理数据不足的一个直接方法是合成更多的数据。[Schwartz等人,2018]提出从基类中提取类内方差(delta),并用它们合成新类的样本。[Wang et al ., 2018]在一个幻觉器中编码类内方差,该幻觉器可以以参考特征和噪声向量作为输入合成新的特征。为了利用基类样本,[Chen等人,2019]提出通过融合探针图像和图库图像来生成变形图像。我们的方法通过从基础数据集中检索额外的图像并提取与支持样本匹配的部分特征来增强支持集。

3 符号

4 方法

我们的方法遵循一种迁移学习协议,该协议包括两个阶段,即表征学习阶段和少样本学习阶段。在第一阶段,我们的目标是从数据库中学习一个特征提取器。在第二阶段,将学习到的特征提取器f转移到目标少样本学习任务中,然后使用支持集

S

S

S训练一个线性分类器,学习到的分类器预测查询集

Q

Q

Q的最终分类结果。从上面的描述中我们可以看出,关键是要从基本数据集

D

b

a

s

e

D_{base}

Dbase中学习一个好的特征提取器,同时在支持集

S

S

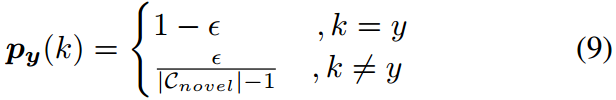

S中使用有限的数据获得一个鲁棒的分类器。为此,我们提出了零件发现和增强网络(PDA-Net),它由一个Part Discovery Network (PDN)学习有效的表示,Part Augmentation Network (PAN)用相关的零件特征来增强少量的支持示例。整个框架如图2所示。

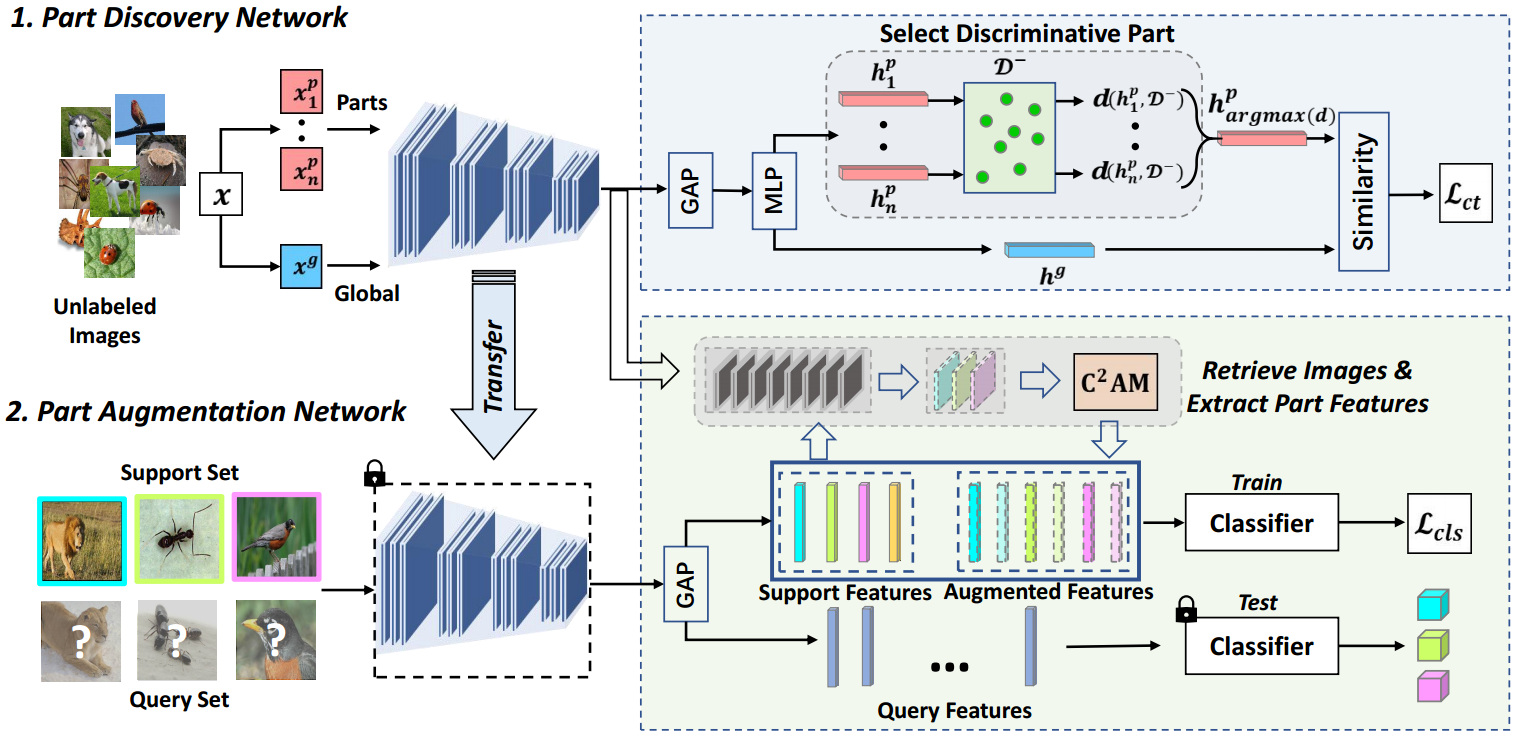

图2:提出的零件发现和增强网络的框架。在局部发现网络(PDN)中,我们首先从图像中提取多个部分,然后选择最具判别性的部分。通过最大化图像全局视图与所选判别部分的相似性,我们从未标记的图像中学习有效的表示。在部分增强网络(PAN)中,我们从未标记的图像中检索相关图像到支持集,然后创建一个类竞争注意图(

C

2

A

m

C^2Am

C2Am)来选择相关的部分作为增强特征。最后,基于支持特征和增强特征训练分类器。注意,PAN中的特征提取器是从PDN传输过来的。

4.1 Part Discovery Network

我们的Part Discovery Network(PDN)是一种基于部分的自监督学习模型,它最大限度地提高了图像全局视图的表示与其判别部分之间的相似性。我们将详细介绍选择判别部分如下。

提取多个部分

在没有part的标签的情况下,我们通过将给定图像 x x x随机裁剪成 n n n个patches { x i p } i = 1 n \{x_i^p\}^n_{i=1} {xip}i=1n来生成parts。同时,获得更大的裁剪 x g x^g xg作为全局上下文。进一步应用随机变换来增加数据的多样性。为了得到潜在部分表示 { h i p } i = 1 n \{h^p_i\}^n_{i=1} {hip}i=1n和全局表示 h g h^g hg,首先采用卷积神经网络 f f f,然后采用全局平均池化和MLP投影头。

选择判别部分

由于我们使用随机裁剪来生成多个部分,因此不可避免地会有一些裁剪属于背景。直接将这些裁剪与全局视图相匹配将产生对背景的偏见,并损害学习表征的泛化。为了解决这一问题,我们制定了一个有效的策略来选择最具判别性的部分。给定一组与输入图像

x

x

x不相关的负样本

D

−

=

{

h

i

g

−

}

i

=

1

N

−

D^-=\{h_i^{g^-}\}^{N^-}_{i=1}

D−={hig−}i=1N−,我们定义一个样本集距离度量

d

(

h

i

p

,

D

−

)

d(h_i^p,D^-)

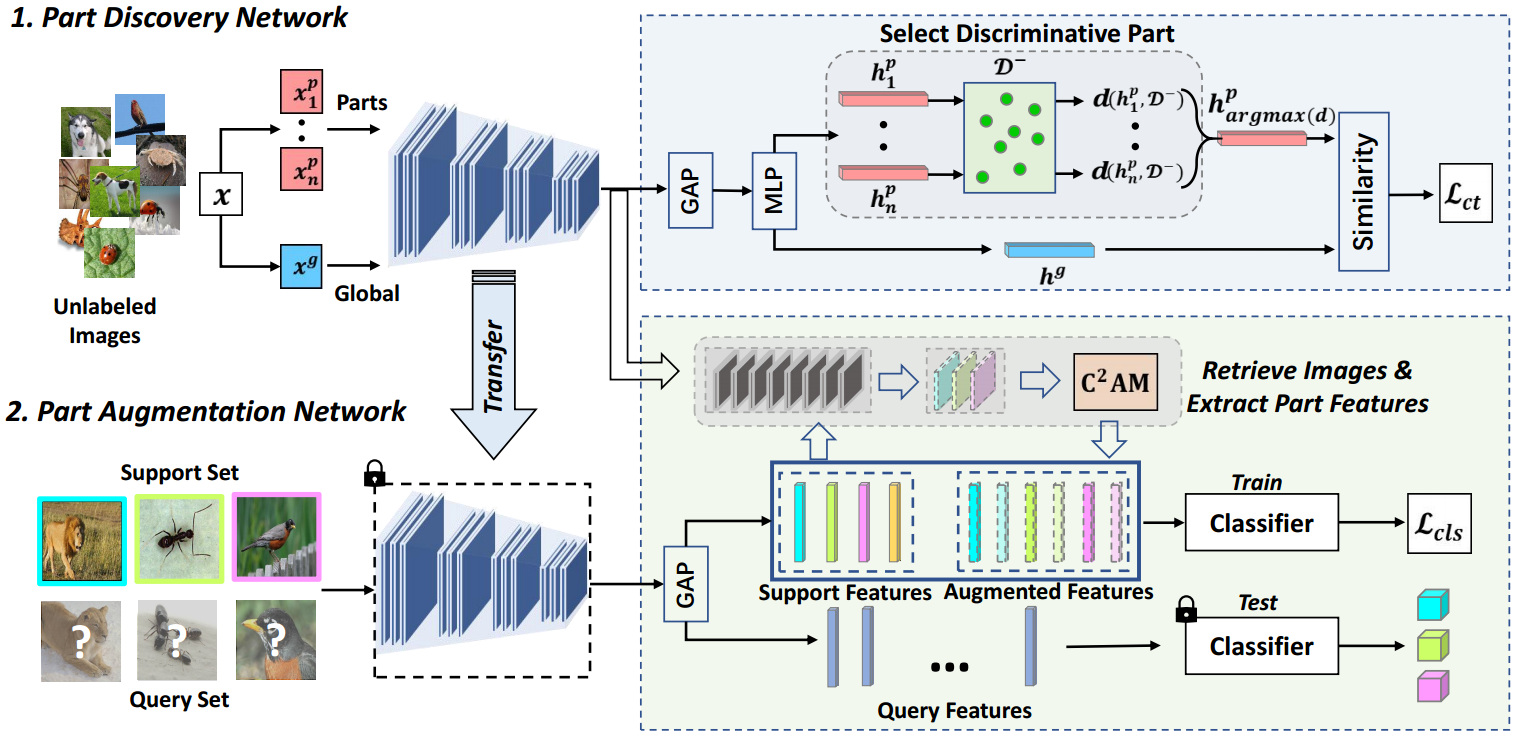

d(hip,D−),表示某部分与所有负样本之间的距离。我们选择距离最大的部分作为最具判别性的部分(me:最有代表性的应该离负样本的距离越远),从而排除背景作物和信息较少的裁剪。该方法被制定为

其中

h

p

h^p

hp为选定部分。这种策略的基本原理是,判别部分应该能够将原始图像与其他图像区分开来,因此它与其他图像的距离应该非常大。

h

i

p

h^p_i

hip和

D

−

D^-

D−之间的距离可以用许多形式来定义。我们可以用

h

i

p

h^p_i

hip和

D

−

D^-

D−中所有样本之间的最小距离。然而,

D

−

D^-

D−中可能存在一些相似的图像,因此最小距离受到这些相似图像的严重影响,大多数负样本不能反映真实距离。这里我们选择平均距离来计算

d

(

h

i

p

,

D

−

)

d(h_i^p,D^-)

d(hip,D−),它更多地考虑其他类的样本。

d

(

h

i

p

,

D

−

)

d(h_i^p,D^-)

d(hip,D−)计算为:

其中

∣

D

−

∣

|D^-|

∣D−∣是这个集合中负样本的个数,

s

s

s是余弦相似度。

训练

对于选择的判别部分,我们训练具有对比损失的PDN,其公式为

其中

τ

\tau

τ表示温度超参数。

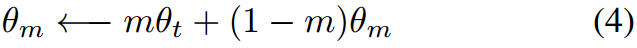

为了得到一个大的负集,我们遵循[He et al, 2020]将

D

−

D^-

D−组织为一个队列,并使用动量编码器来获得一致的负表示。动量编码器是特征提取器和MLP头的指数移动平均版本。其参数

θ

m

\theta_m

θm更新为

式中

m

m

m为动量超参数,

θ

t

\theta_t

θt为特征提取器和MLP头在训练步骤

t

t

t时的参数。

4.2 Part Augmentation Network

我们的部件增强网络(PAN)旨在利用基础数据集中的相关部件特征来增强支持集。为此,我们首先从基础数据集中检索额外的图像,然后创建一个类竞争注意图(Class-Competitive Attention Map, C 2 A M C^2AM C2AM)来指导从检索到的图像中选择相关的部分,最后使用这些被选中的部分来改进目标分类器。

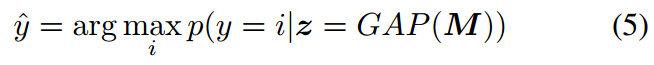

检索额外的图像

由于数据库的大小非常大,我们提出了一个简单而有效的策略,即从

D

b

a

s

e

D^{base}

Dbase中选择少量非常相似的图像,这些图像更有可能包含相关的部分。具体来说,我们首先训练一个线性分类器

p

(

y

∣

z

;

W

,

b

)

p(y|z;W,b)

p(y∣z;W,b)在支持集

S

S

S上,其中

z

z

z为特征向量,

W

W

W和

b

b

b分别为权矩阵和偏置。然后,我们使用该分类器对

D

b

a

s

e

D^{base}

Dbase中的每张图像进行分类:

其中GAP是一个全局平均池化算子,

M

M

M表示第4.1节中学习的特征提取器

f

f

f提取的特征映射。

在

D

b

a

s

e

D^{base}

Dbase的

k

k

k类图像中,我们保留分类概率最高的

N

a

N_a

Na张图像作为检索结果。这些

N

a

N_a

Na图像的特征映射记为

A

k

=

{

M

i

k

}

i

=

1

N

a

A_k=\{M_i^k\}^{N_a}_{i=1}

Ak={Mik}i=1Na。

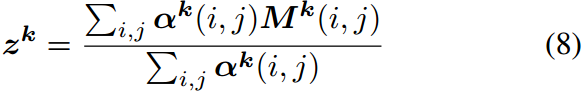

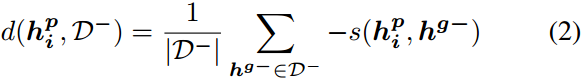

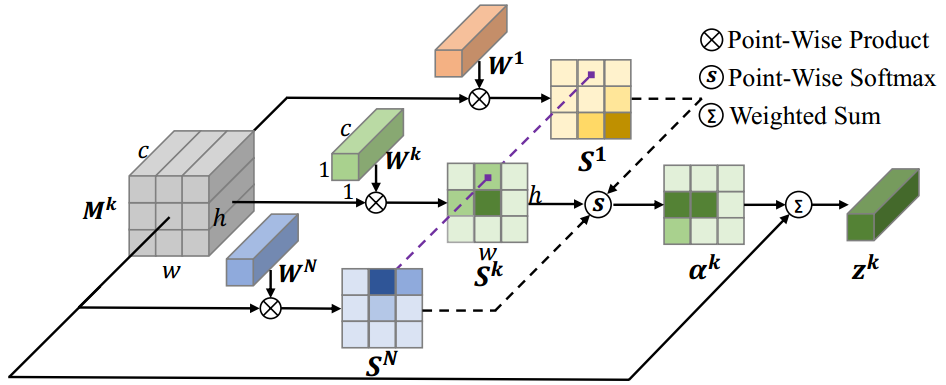

Class-Competitive Attention Map

图3:

C

2

A

M

C^2AM

C2AM的说明。为简单起见,我们省略了偏见项。

为了进一步从检索到的特征图

A

k

A_k

Ak中提取相关部分,我们提出了一种新的基于CAM的注意机制[Zhou et al ., 2016],类竞争注意图(Class-Competitive attention Map,

c

2

a

m

c^2am

c2am),如图3所示。给定一个特征图

M

k

∈

A

k

M^k \in A_k

Mk∈Ak,我们得到一个类注意图

S

k

S^k

Sk,表示它在每个空间位置与类

k

k

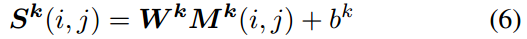

k的相关性:

其中

S

k

(

i

,

j

)

S^k(i,j)

Sk(i,j)和

M

k

(

i

,

j

)

M^k(i,j)

Mk(i,j)分别为类

k

k

k的分类分数和位置

(

i

,

j

)

(i,j)

(i,j)。

W

k

,

b

k

W^k,b^k

Wk,bk是分类器权重向量和

k

k

k类的偏置,它们已经在

p

(

y

∣

z

;

W

,

b

)

p(y|z;W,b)

p(y∣z;W,b)学习过。

尽管类注意图

S

k

S^k

Sk对于定位特定于类的图像区域或对象部分非常有用,但它仍然包含一些对所有类都具有高分类分数的部分。这些部分提供的分类信息较少,应进一步加以限制。我们对分类分数向量

S

(

i

,

j

)

S(i,j)

S(i,j),提供了一种类别竞争机制,突出显示只有

k

k

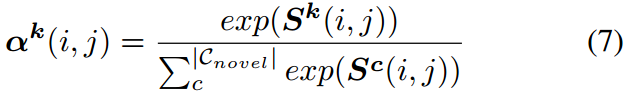

k类得分较高的部分,

k

k

k类的类别竞争注意图

α

k

\alpha^k

αk为:

通过修正后的注意图

α

k

\alpha^k

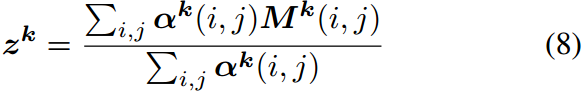

αk,我们可以提取更多相关的部分特征

z

k

z^k

zk来扩充类

k

k

k,通过特征图

M

k

M^k

Mk的加权和计算得到:

检索到的类

k

k

k的特征集现在更新为

A

k

=

{

z

i

k

}

i

=

1

N

a

A_k=\{z^k_i\}^{N_a}_{i=1}

Ak={zik}i=1Na。我们将

A

=

∪

k

A

k

A=\cup_kA_k

A=∪kAk表示为所有类的增广部分特征的集合。

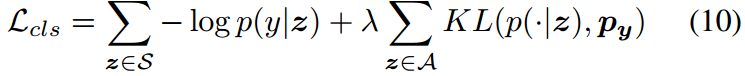

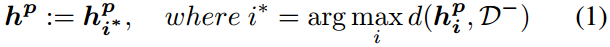

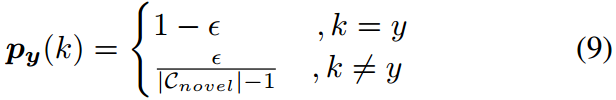

改进目标分类器

有了增广部分特征,我们现在可以用支持集

S

S

S和增广集

A

A

A来改进初始分类器,以获得更健壮的分类器。由于增广特征并非来自与支持样本完全相同的类别,因此我们采用标签平滑技术[Szegedy等人,2016]来防止增广特征的过拟合。具体来说,我们将一个one-hot标签

y

y

y转换为一个平滑的概率分布

p

y

p_y

py:

其中

p

y

(

k

)

p_y(k)

py(k)是类

k

k

k的概率,

ϵ

\epsilon

ϵ是范围为

(

0

,

1

)

(0,1)

(0,1).最后,精炼分类器的总损失为:

其中第一项为支持集

S

S

S中样本的交叉熵损失,第二项为增广特征的预测概率分布

p

(

⋅

∣

z

)

p(\cdot|z)

p(⋅∣z)与平滑地真实分布

p

y

p_y

py之间的K-L散度。

5 实验

6 结论

在本文中,我们提出了一个局部发现网络,该网络可以从扁平的未标记图像集合中提取有效的先验知识进行少样本学习。在此基础上,提出了一种局部增强网络,用相关的局部来增强支持样例,从而减少了过拟合,得到了更好的分类边界。实验结果表明,我们的方法显著优于以前的无监督元学习方法,并达到与最先进的监督方法相当的准确性。

1267

1267

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?