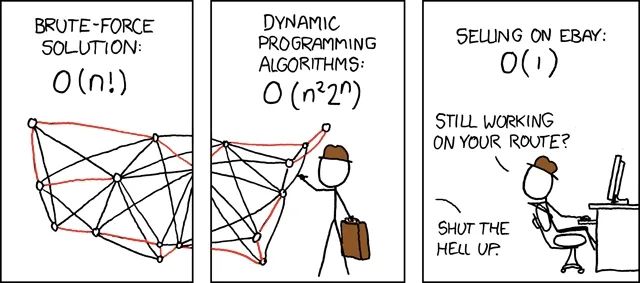

封面图来源:https://xkcd.com/399/

推文作者:丁建辉,陈泰劼,张云天

本文针对旅行商问题(Travelling salesman problem, TSP)和车辆路径规划问题(Vehicle routing problem, VRP)这一类经典而重要的运筹学问题,归纳与探讨基于机器学习技术的新求解方法。本文从“分而治之”、“持续局部优化”、“调整模型结构”和“调整学习范式”四个角度归纳新方法,并欢迎读者评论、讨论与推荐某一角度中的好文章、新文章。

概述:机器学习 + 大规模TSP/VRP求解

TSP/VRP是交通物流行业的经典问题,目前广泛应用于快递、外卖配送等业务场景。对于中小规模TSP/VRP,主流的启发式算法已经解决得比较好,即能在可接受的时间内求得较好的可行解。然而,当问题的规模变得特别大时,现有的启发式算法通常需要比较长的时间才能获得满意的可行解。此外,类似业务所衍生出来的TSP/VRP在目标、约束、数据分布上会比较接近,其可行解也大概率存在相关性。然而,启发式算法无法利用问题间的相关性以及历史求解信息加速问题的求解,即每遇到1个新问题,启发式算法都得从头开始。

考虑到机器学习模型能从大规模数据中挖掘出潜在的规律且在数据分布类似的场景上具有较好的泛化性,不少专家学者尝试将机器学习以及启发式算法结合到一起,并以此加快大规模TSP/VRP问题的求解。从模型整体的优化目标看,目前的ml4tsp方案主要分为2类:端到端的Construction以及局部迭代优化的Improvement。前者通常直接使用机器学习模型构建问题的解,具有速度快、在小规模问题上求解效果好等优点,其缺点是在中大规模问题上的求解效果跟最优解的gap还比较大以及跨数据分布的泛化能力还不尽人如意。后者通常结合了机器学习以及启发式算法,例如将邻域搜索算子选择转化成数据驱动的分类问题。局部迭代优化方案的优点是融合了机器学习和启发式算法的长处,能较好地求解不同规模的优化问题,其缺点是在大规模问题上的求解效率还有待提升。

另外,从模型结构看,现有的ml4tsp方案主要有2种:基于图神经网络以及基于transformer,前者通常将tsp问题转化成图的边分类任务(非自回归),而后者则将tsp问题转化成序列建模任务(自回归)。对于这2种方案,若直接在大规模tsp问题(例如节点数量大于5k)上训练,均会存在效率&资源上的问题。对于图神经网络方案,若以模仿学习的范式进行学习,则需要提前给大规模tsp问题构建较好的可行解(例如使用LKH提前求解),这个阶段会非常耗时。此外,当节点数量等于5k时,tsp问题形成的图包含了1kw+条边,在这种规模的图上进行边分类任务,存在学习难度大且解码环节耗资源的问题。另外,对于基于transformer的序列求解方案,其核心的self-attention的时间复杂度是O(tsp问题节点数量的平方),当tsp规模特别大时,transformer类方案在训练阶段也存在特别耗时的问题。

从前面的分析可知,使用机器学习模型求解大规模问题很有价值(效率提升)但也存在很大的挑战(泛化性)。为了攻克这个难题,研究人员主要从以下几个角度提出了新的优化方案:

-

分而治之:先将大问题分解成小问题,然后优化求解;

-

持续局部优化:先选出值得优化的局部区域,然后继续优化求解;

-

调整模型结构:泛化性分析、优化编码-解码框架、改进attention;

-

调整学习范式:降低数据成本;

1. 分而治之:先分解,后求解

[AAAI 2021] Generalize a Small Pre-trained Model to Arbitrarily Large TSP Instances

Fu, Z. H., Qiu, K. B., & Zha, H. (2021, May). Generalize a small pre-trained model to arbitrarily large tsp instances. In Proceedings of the AAAI conference on artificial intelligence (Vol. 35, No. 8, pp. 7474-7482).</

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2892

2892

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?