源自B站 刘二大人 ,传送门PyTorch 深度学习实践 梯度下降法

一、计算图(Computation Graph)

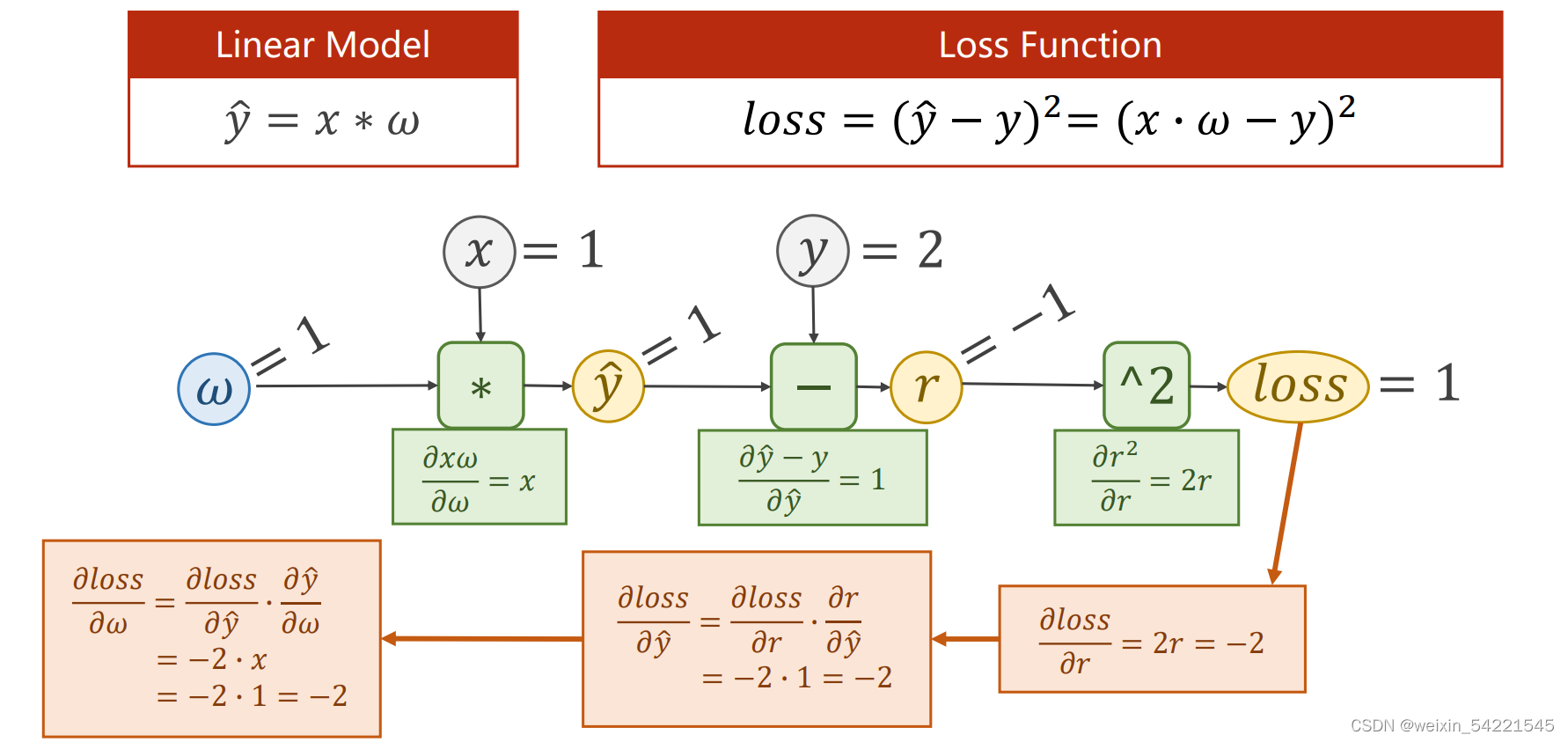

计算图是一种用于描述数学计算的图形模型,常用于神经网络的前向传播和反向传播算法中

在计算图中,节点代表数学运算,边代表运算结果之间的依赖关系,形成了一张有向无环图。这个图可以通过一系列的节点之间的计算和数据传递来完成整个计算过程。

计算图的前向传播即从输入数据开始,按照节点之间的依赖关系,通过一步步的计算最终得到输出结果的过程。反向传播则是根据损失函数对输出结果的偏导数,反向逐层计算对输入变量的偏导数,用于优化模型参数。

二、Tensor(张量)

w(权重)是Tensor类型,其中包含data和grad,data用于储存权重本身的值,grad用于储存损失函数对权重的倒数(即梯度)。

张量之间的计算都是建立计算图的过程,如果需要对w进行梯度计算,那么在建立的计算图中,所有与w相关的都要进行梯度计算

import torch

a = torch.tensor([1.0])

a.requires_grad = True

print(a)

print(a.data)

print(a.type())

print(a.data.type())

print(a.grad)

print(type(a.grad))

从结果可以看出,在初始状态下,data的类型为Tensor,而grad的类型为None。在后续反向传播代码中,调用l.backward()函数后,grad的类型会由None更新为Tensor,同时w.grad.data可以用于后续w.data的更新计算。

二、反向传播

本算法中反向传播主要体现在,l.backward()。该函数会把计算图中所有需要梯度(grad)的地方进行计算,然后把梯度都存在对应的待求的参数中,最终计算图被释放。

import torch

x_data = [1.0, 2.0, 3.0]

y_data = [2.0, 4.0, 6.0]

#赋予tensor中的data

w = torch.Tensor([1.0])

#设定需要计算梯度grad

w.requires_grad = True

#模型y=x*w 建立计算图

def forward(x):

'''

w为Tensor类型

x强制转换为Tensor类型

通过这样的方式建立计算图

'''

return x * w

def loss(x, y):

y_pred = forward(x)

return (y_pred - y) ** 2

print ("predict (before training)", 4, forward(4).item())

for epoch in range(100):

for x,y in zip(x_data,y_data):

#创建新的计算图

l = loss(x,y)

#进行反馈计算,此时才开始求梯度,此后计算图进行释放

l.backward()

#grad.item()取grad中的值变成标量

print('\tgrad:',x, y, w.grad.item())

#单纯的数值计算要利用data,而不能用张量,否则会在内部创建新的计算图

w.data = w.data - 0.01 * w.grad.data

#把权重梯度里的数据清零

w.grad.data.zero_()

print("progress:",epoch, l.item())

print("predict (after training)", 4, forward(4).item())

1629

1629

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?