一、OLLAMA安装并下载Deepseek模型

官网下载OLLAMA:https://ollama.com/

1.1 检查ollama安装是否成功

ollama --version

能输出版本号(如ollama version is 0.5.7)说明安装成功。

1.2 获取模型文件

ollama pull deepseek-r1:1.5b # 如果要获取其他参数的模型则更改1.5b即可

1.3 管理模型

ollama list

1.4 运行模型

ollama run deepseek-r1:1.5b

退出可输入:/bye

二、Chatbox AI

2.1 下载Chatbox

2.2 编辑环境变量

注意!!关闭OLLAMA程序,在开始栏搜索“编辑系统环境变量”。

新建2个系统变量:

变量名:OLLAMA_HOST ——> 变量值:0.0.0.0

变量名:OLLAMA_ORIGINS ——> 变量值:*

2.3 回到chatbox选择模型

2.4 开始对话

三、OpenWeb UI

建议使用 Docker 部署,不需要配置环境,避免环境冲突的影响。

3.1 安装Docker

官网下载:https://www.docker.com/

Docker Desktop for Windows 需要 WSL 2支持。如果出现以下报错,说明没有启动WSL,需要以管理员身份打开 PowerShell,执行以下命令安装WSL2内核。

参考:https://blog.csdn.net/coder_copy/article/details/141425540

win11执行以下命令,将把 WSL 2 设置为默认版本。如果您的系统中没有安装 WSL 2 内核,则会自动下载并安装(win10同样)。

wsl --set-default-version 2

如果 WSL 2 内核更新失败,可以尝试手动更新。

wsl --update

3.2 修改代理

参考:https://blog.csdn.net/qq_53795212/article/details/139690567

3.2.1 添加代理(本地找不到的容器会自动到网上去找)

添加后点 Apply。

3.2.2 添加镜像(加快下载速度)

添加后点 Apply。

{

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false,

"features": {

"buildkit": true

},

"registry-mirrors": [

"https://1nj0zren.mirror.aliyuncs.com",

"https://docker.mirrors.ustc.edu.cn",

"http://f1361db2.m.daocloud.io",

"https://registry.docker-cn.com"

]

}

3.3 通过 docker 下载 Open WebUI

(已安装OLLAMA的情况下)

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

此时Docker Desktop也显示容器已运行。

如果要修改Docker镜像保存的位置:

可改为

安装后,可以通过http://localhost:3000访问 Open WebUI 。

创建账户后,选择模型,即完成。

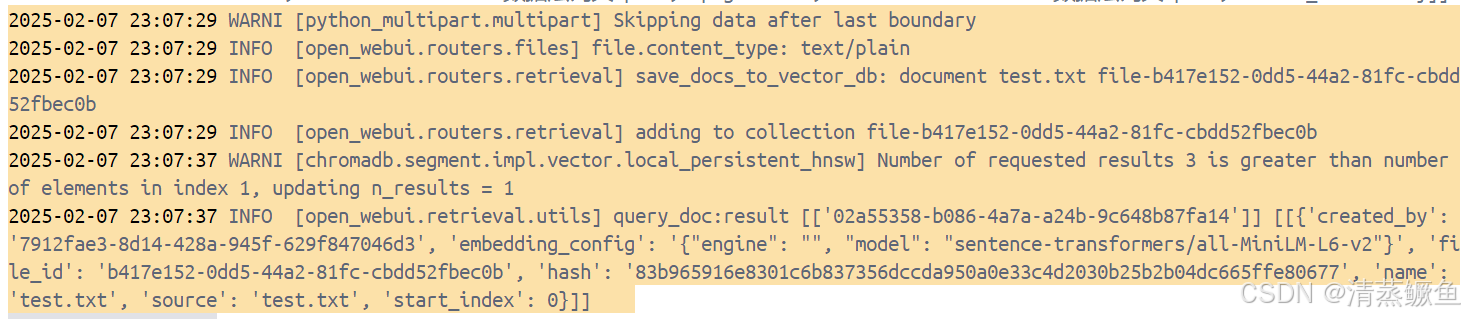

3.4 可能存在的问题

File upload hangs, unable to upload files.

不同情形的报错解决方式有所区别:

参考1:https://github.com/open-webui/open-webui/discussions/7898

参考2:https://linux.do/t/topic/237176

参考3:https://docs.openwebui.com/

👆Docker的此种日志,似乎可以忽略:The message “Collection …does not exist” seems to be normal. An older instance, where the upload still worked, gives the same error.

硅基流动测试"Pro/deepseek-ai/Deepseek-R1"模型提示余额不足,其它模型正常

这个模型仅支持充值余额支付,免费送的不能用。

需要修改openwebui的版本

docker rm -f open-webui

#假设要安装v0.5.18版本(如果是最新版,那就是main)

docker pull ghcr.io/open-webui/open-webui:v0.5.18

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v D:\Programs\DockerData\open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:v0.5.18

需要下载ollama其他模型

参考:https://blog.csdn.net/AAI666666/article/details/145469781

(1)Ollama模型下载路径相关设置

变量名:OLLAMA_MODELS

变量值:(你想要存放大语言模型的路径,举例说明:我想把模型存放在E盘Github code文件夹下的OLLAMAMODEL这个文件夹中,那么变量值就输入如下)E:\Github code\OLLAMAMODEL

(2)进入Ollama的模型图书馆找找模型:https://ollama.com/library

四、其他设备访问电脑本地部署的模型(2种方法)

4.1 同一个局域网下访问 + OpenWeb UI设立创建用户权限(可选)

原理:在同一个WiFi下,将自己的电脑变成服务器,他人可以通过手机或电脑来访问localhost下的web项目。

“同一局域网”参考:https://blog.csdn.net/weixin_41897680/article/details/107846205

“开放工作区”参考: https://blog.csdn.net/kangweijian/article/details/145423603

4.1.1 关闭防火墙

4.1.2 查询本地IP

4.1.3 创建用户账号

4.1.4 设置账号权限

4.1.5 添加模型到工作区

4.1.6 开放给他人使用

将url前缀由localhost改为部署本地模型的主机IP地址,如:192.168.x.x:3000/

4.2 创建隧道访问

“内网穿透实现公网访问本地大语言模型”参考: https://blog.csdn.net/qq_28413709/article/details/138210544

4.2.1 下载cpolar

注册登录并下载:https://www.cpolar.com

4.2.2 创建隧道

- 安装成功后在浏览器访问

http://localhost:9200,使用已经注册好的账号登录

- 创建一个公网http地址隧道

隧道名称:ollama1(自定义命名,注意不要与已有的隧道名称重复)

协议:http

本地地址:3000 (本地访问的地址)

域名类型:免费选择随机域名 地区:选择China Top

- 创建好后可以选择在线隧道列表,复制

公网网址即可实现公网访问本地模型。

606

606

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?