Ollama

本地部署借助一个工具叫做ollama。

Ollama是一个开源框架,专门设计用于在本地机器上快速部署和运行大型语言模型(LLM),它通过提供一个简单易用的命令行界面和服务器,使用户能够轻松下载、运行和管理各种开源大型语言模型。

它具有开源免费、简单易用、模型丰富以及资源占用低的特点,支持Llama 3、Mistral、Qwen2等众多热门开源LLM,并提供一键下载和切换功能。

官网:Ollama

点击官网进行下载。

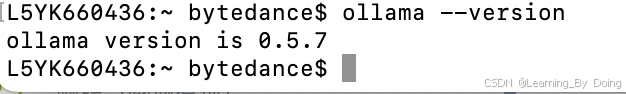

下载完成以后在终端运行下面命令测试是否安装成功:

ollama --version输出版本说明安装成功了

终端部署

打开计算机终端,部署什么样的模型就运行哪个命令。首次运行需要安装部署,如果已经部署,执行对应命令即可激活LLM。

1.5B Qwen DeepSeek R1

ollama run deepseek-r1:1.5b7B Qwen DeepSeek R1

ollama run deepseek-r1:7b8B Llama DeepSeek R1

ollama run deepseek-r1:8b14B Qwen DeepSeek R1

ollama run deepseek-r1:14b

32B Qwen DeepSeek R1

ollama run deepseek-r1:32b70B Llama DeepSeek R1

ollama run deepseek-r1:70bCase

b代表的是参数单位billion,参数越多模型运行需要的配置越高,普通电脑是无法带动32b大模型的,可以先安装1.5b上手测试。

安装好大模型后再次运行run命令即可激活大模型:

session测试:

可以使用下面命令查看已经安装的模型。

ollama list

Web UI 控制端

上面的运行和测试都在终端实现,如果想在web上使用大模型,可以使用一个插件:

Page Assist - A Web UI for Local AI Models

测试:

ollama和模型的部署默认都是在系统盘,如果是windows系统的同学部署大模型,又不想安装到系统盘可以看:windows系统本地部署deepseek更改目录

1366

1366

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?