整体方案设计与规划

我们要做的项目是基于InternLM的考研政治题库系统,

项目灵感来源于我们组内成员都有考研需求,我们希望在面对没有答案解析的题目时能够有一个软件基于现有的知识进行分析给出一个合理的解释,于是我们决定做一款基于大模型的知识题库系统,旨在为考研提供方便。

文科题目“内容多,变化少”的特性,能够完美利用大模型能够处理大量数据、并进行简单思考的优势。于是我们决定以考研政治为主题,以市面上主流的语言大模型为基础,对其进行训练微调,进行独有的知识题库的构建,并应用所学知识搭建页面,使整个系统更加便捷、美观。

项目目标:能够正确回答单选题,多选题,并给出合理的答案解析。

对于材料分析大题能够给出合理的答案

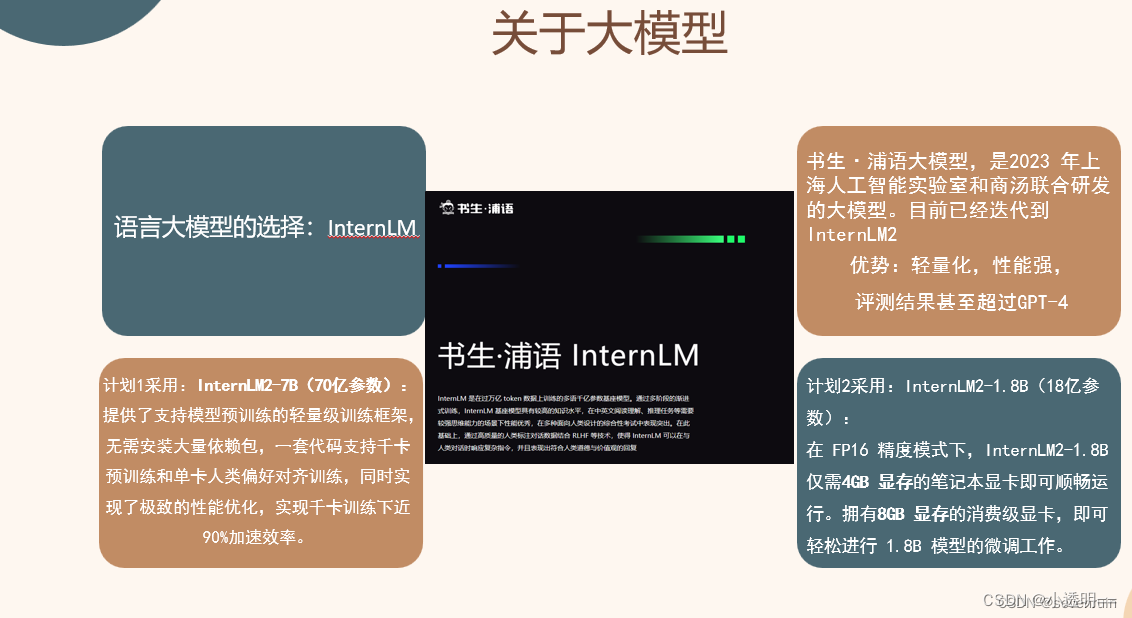

本篇文章是我对轻量化大模型internLM相关知识进行学习之后的一些总结:旨在记录创新项目实训过程中对大模型的学习,方便为后续开发工作打下基础。

InternLM

一、开发过程

2023.06.07 InternLM 千亿参数大模型首次发布

2023.07.06 InernLM 千亿参数大模型全面升级:支持 8k 上下文、26 种语言;全面开源支持商用;同时发布 InternLM-7B 模型

2023.08.14 书生·万卷 1.0 多模态预训练语料库开源发布

2023.08.21 发布对话版模型 InternLM-Chat-7B v1.1 发布,开源智能体框架 Lagent

2023.08.28 InternLM 千亿参数模型参数量升级至 123B

2023.09.20 增强版 InternLM-20B 开源,开源工具链 xtuner 全面升级

二、系列模型

轻

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?