9月19日,阿里云在云栖大会上发布了通义千问新一代开源模型Qwen2.5。旗舰模型Qwen2.5-72B的性能超越了Llama 3-405B,再次登上全球开源大模型的王座。Qwen系列刷新了多项世界纪录,堪称中国AI技术的崛起之作。

国产第一,开源之王

Qwen2.5在多个国际权威榜单上表现出色,证明了它作为国产第一开源大模型的技术领先性。真的是遥遥领先!

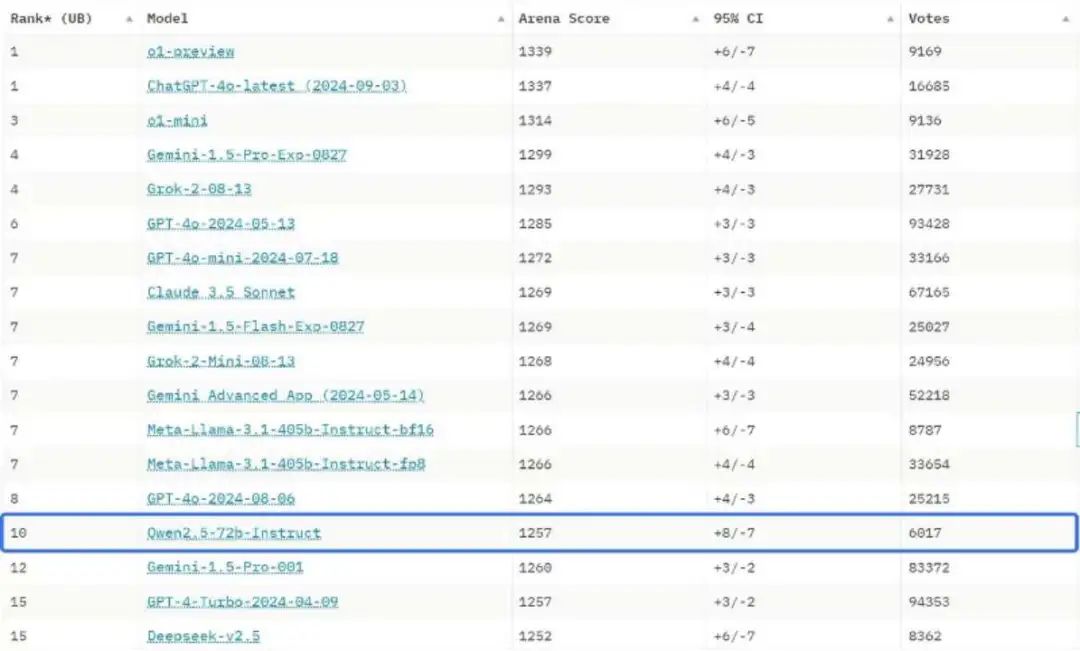

9月29日基准测试平台Chatbot Arena日前公布最新大模型盲测榜单,这是海外最具公信力的大模型榜单之一。Qwen2.5再次闯入全球十强,其大语言模型Qwen2.5-72B-Instruct闯入了全球LLM前十,面对谷歌、Anthropic、Meta等强大竞争对手,成为唯一上榜的中国大模型,也是前十中唯一的开源模型。

在ZeroEval榜单上,Qwen2.5-72B-Instruct击败Llama的405B模型,成为得分最高的开源大模型。ZeroEval是个评估语言模型的统一框架,以零样本的方式提示 LM,并指示它们结构化格式输出推理步骤和最终答案。主要涵盖几类任务:用于知识推理的 MMLU-Redux、用于数学推理的 GSM 和 MATH(5 级)、用于逻辑推理的 ZebraLogic 以及用于代码推理的 CRUX。

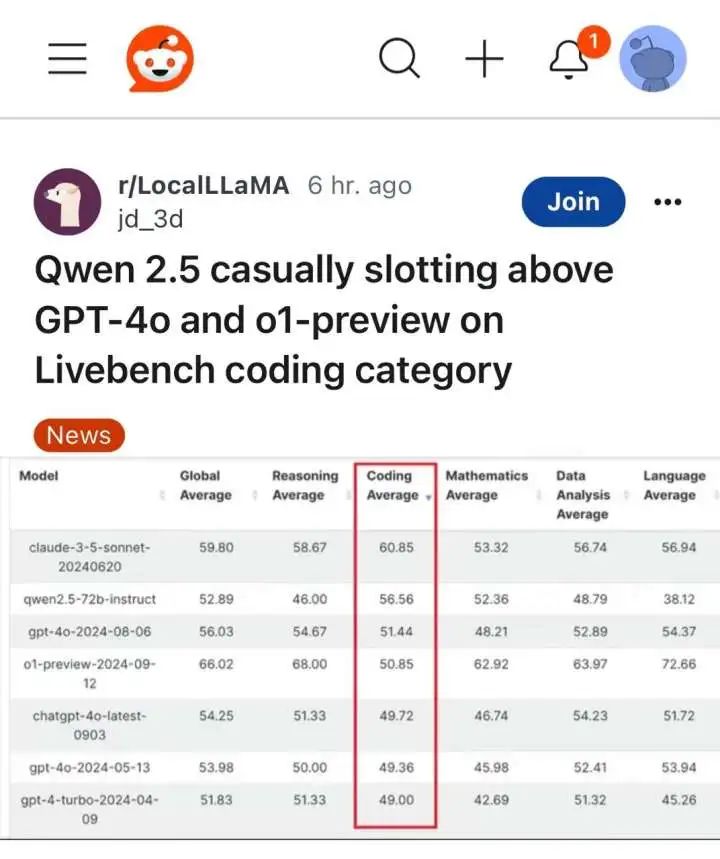

在LiveBench基准的最新榜单上,Qwen2.5-72B-Instruct的代码能力得分超过了o1。

Qwen系列在ZeroEval榜单、LiveBench基准的榜单、中文大模型测评基准SuperCLUE、HuggingFace社区开源大模型榜单、斯坦福大学的大模型测评榜单HELM MMLU等各种知名榜单中都有一席之地。Qwen2.5作为国产第一开源大模型,不仅在国内领先,在国际上也备受关注。

权威认证,实力超群

Qwen系列自问世以来,无论是Qwen、Qwen2.0还是最新的Qwen2.5,都受到了海内外权威机构的高度关注。

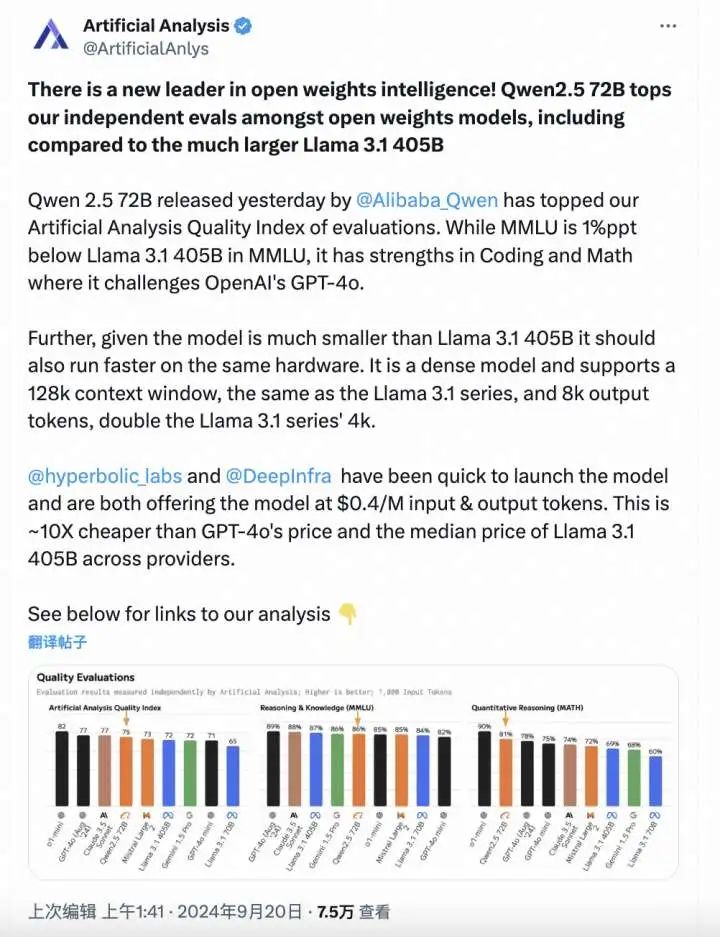

专注于AI模型和API独立分析的Artificial Analysis 表示,Qwen2.5-72B在他们的测评基准Artificial Analysis Quality Index of evaluations上表现优异,整体超越Llama 3.1 -405B,是得分最高的开源大模型,而且Qwen2.5-72B的代码和数学能力足以挑战GPT-4o。

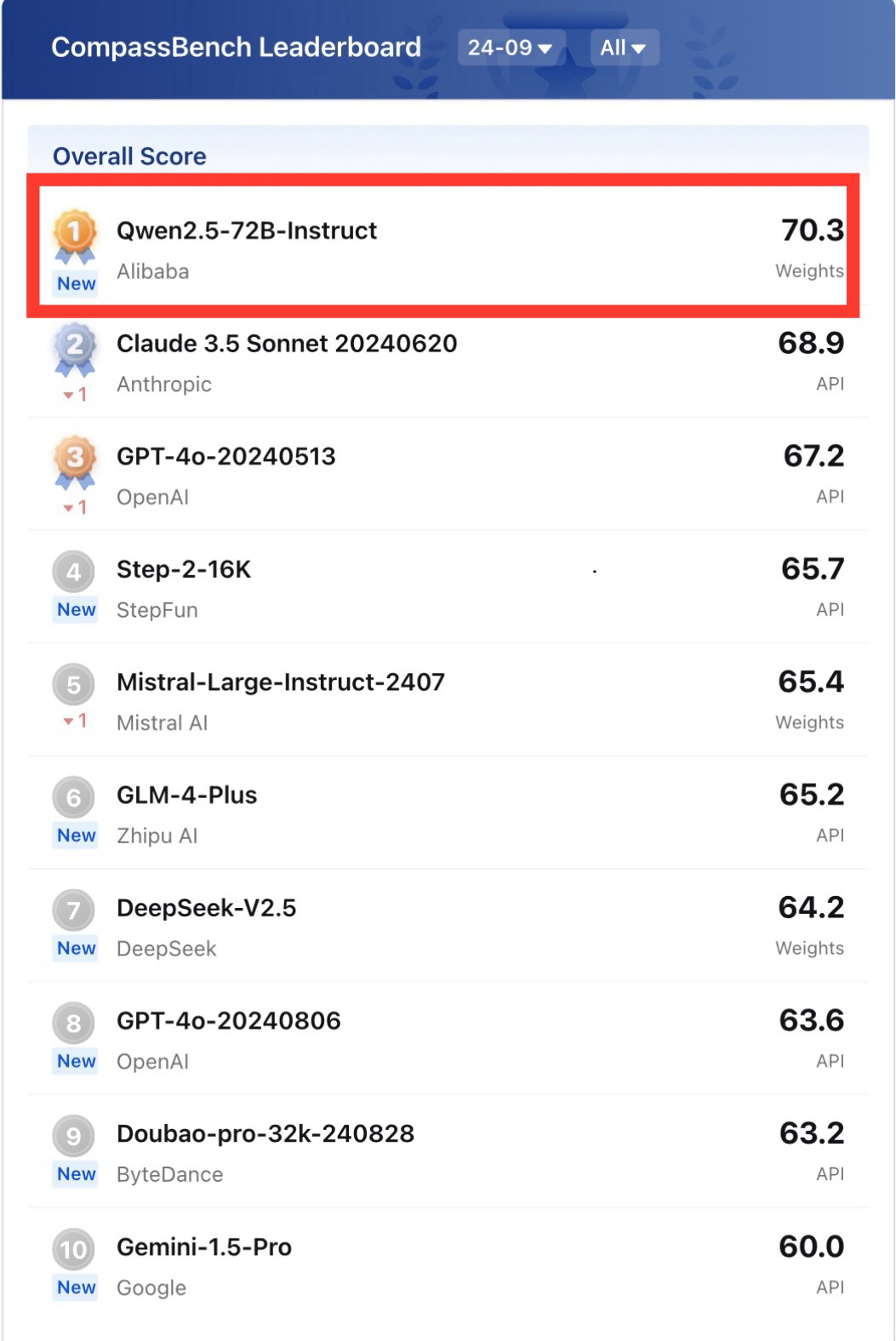

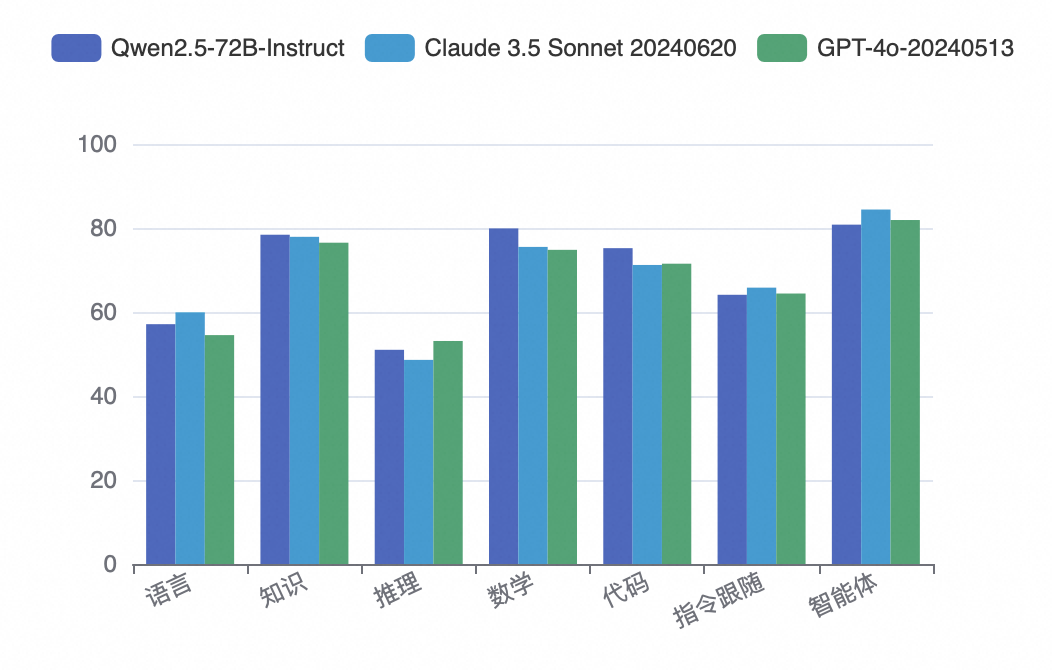

司南 OpenCompass 大语言模型评测榜 9 月榜单公布,阿里通义千问开源模型 Qwen2.5-72B-Instruct击败 Claude 3.5、GPT-4o 等闭源模型,成为该评测榜首个开源模型冠军。

司南 OpenCompass 是由上海人工智能实验室研发的大模型评测体系平台。OpenAI、阿里巴巴、智谱 AI、Meta、零一万物等百余个最主流的大模型均已加入评测,是最具国际影响力的中国权威第三方评测榜单。

Qwen2.5-72B-Instruct 在此次榜单的多项能力测评中均名列前茅。

Qwen2.5-72B-Instruct 在此次榜单的多项能力测评中均名列前茅。

司南 OpenCompass 评价称,Qwen2.5 的登顶,标志着开源社区在模型领域取得快速进展,以 Qwen 2.5 等为代表的国产主流厂商模型,在经历最新一轮技术迭代后,其性能有了显著提升,与国际顶尖模型之间的差距正在快速缩小,展现了国产模型的强大竞争力。

口碑爆棚,震惊中外

作为国产第一开源大模型,Qwen2.5得到了许许多多全球开发者的广泛认可和好评。

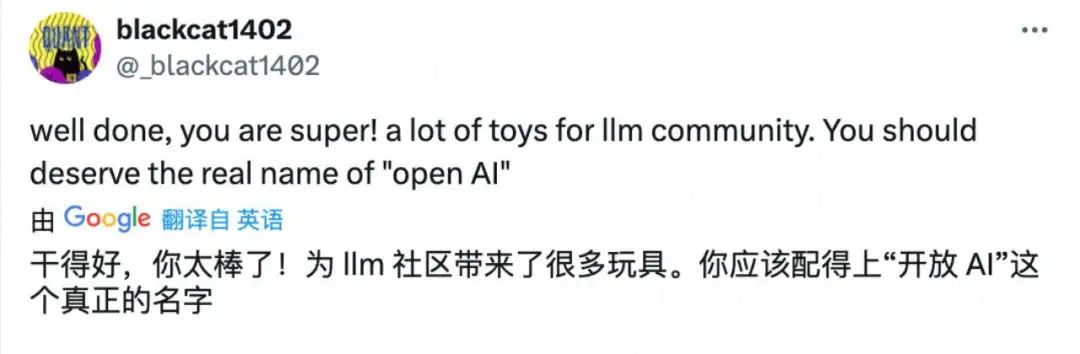

Qwen2.5的发布在海内外开源社区引发一场狂欢,这套开源模型涵盖多个尺寸的大语言模型、多模态模型、数学模型和代码模型,几乎所有尺寸的模型都实现了同等规模业界最佳性能,有国外开发者称赞通义千问称得上是真正的“开放AI”.

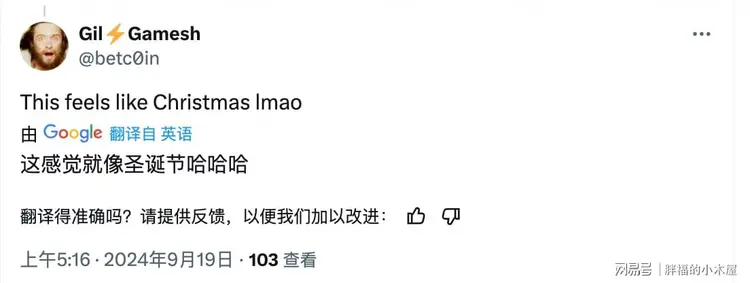

这次云栖大会,通义这份“开源大礼包”的质量和数量都做到了极致,一位叫Gamesh的老外兴奋地表示:“这感觉就像圣诞节,哈哈哈“。看到中国的Qwen2.5如此优秀,反而让有些老外坐不住了,催促美国厂商推出能与Qwen2.5抗衡的大模型。有的老外还批评美国别只顾着做聊天机器人,要学中国大模型百花齐放!

朱啸虎、周鸿祎等国内科技大佬也在多个场合为Qwen2.5点赞。

性能卓越,全面领先

Qwen2.5全系列涵盖多个尺寸的大语言模型、多模态模型、数学模型和代码模型,每个尺寸都有基础版本、指令跟随版本、量化版本,总计上架100多个模型,刷新业界纪录。

Qwen2.5全系列模型都在18T tokens数据上进行预训练,相比Qwen2,整体性能提升18%以上,支持高达128K的上下文长度,可生成最多8K内容,多流畅支持29种语言,大大超越了其他开源模型。

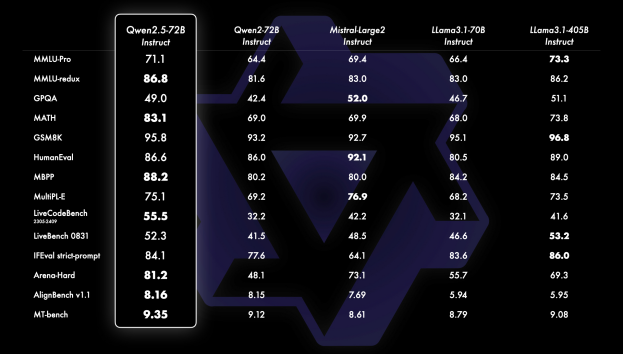

同时Qwen2.5-72B模型在MMLU-rudex基准(考察通用知识)、MBPP 基准(考察代码能力)和MATH基准(考察数学能力)的得分高达86.8、88.2、83.1。

备受期待的视觉语言模型Qwen2-VL-72B也正式开源了。Qwen2-VL能识别不同分辨率和长宽比的图片,理解20分钟以上的视频,具备自主操作手机和机器人的视觉智能体能力。

近日,权威测评LMSYS Chatbot Arena Leaderboard发布了最新一期的视觉模型性能测评结果,Qwen2-VL-72B成为全球得分最高的开源模型。

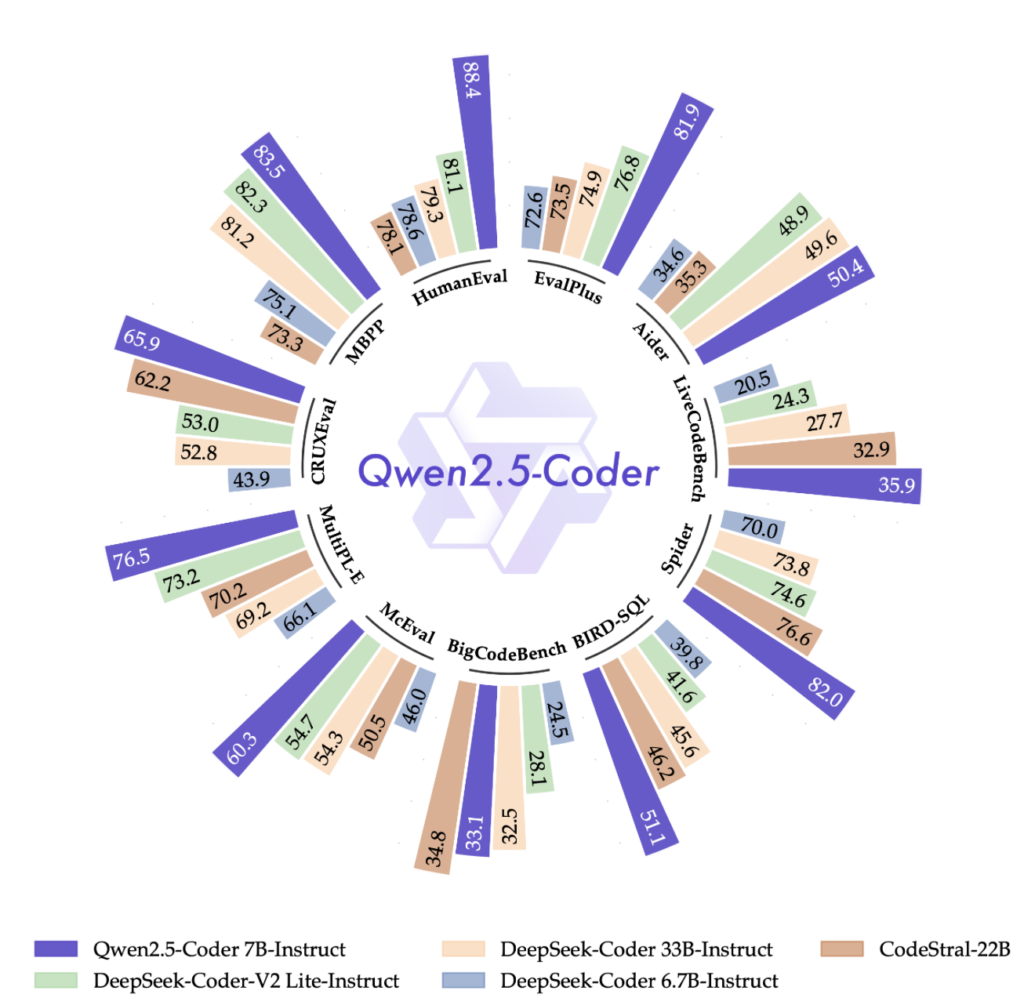

专项模型方面,用于编程的 Qwen2.5-Coder 和用于数学的Qwen2.5-Math都比前代有了实质性进步。Qwen2.5-Coder 在多达5.5T tokens的编程相关数据上作了训练,当天开源1.5B和7B版本,未来还将开源32B版本。

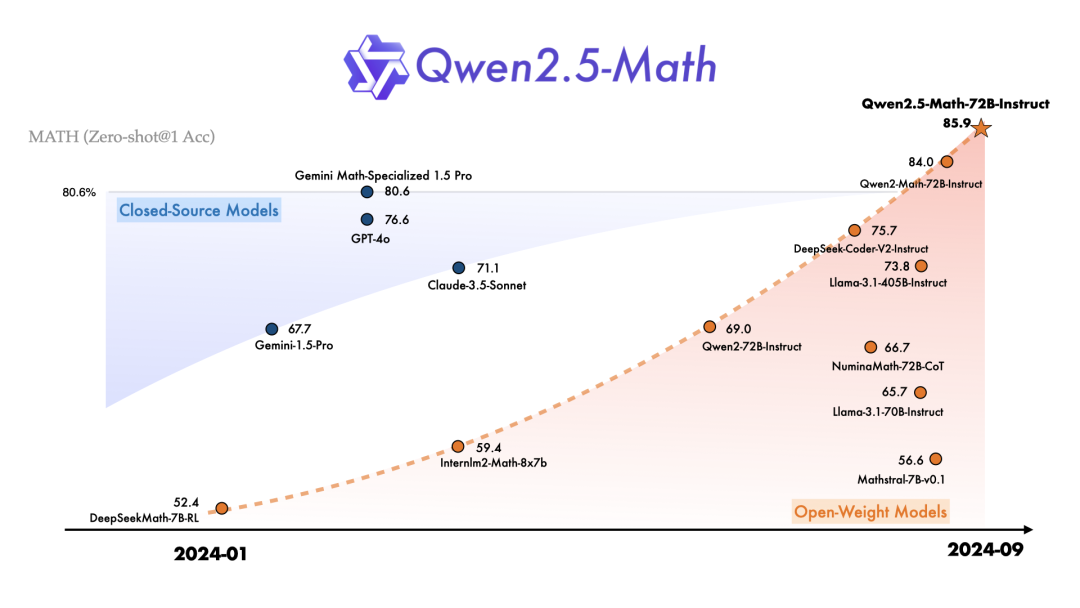

Qwen2.5-Math支持使用思维链和工具集成推理(TIR) 解决中英双语的数学题,是迄今为止最先进的开源数学模型系列,本次开源了1.5B、7B、72B三个尺寸和一款数学奖励模型Qwen2.5-Math-RM。

引领开源,开疆拓土

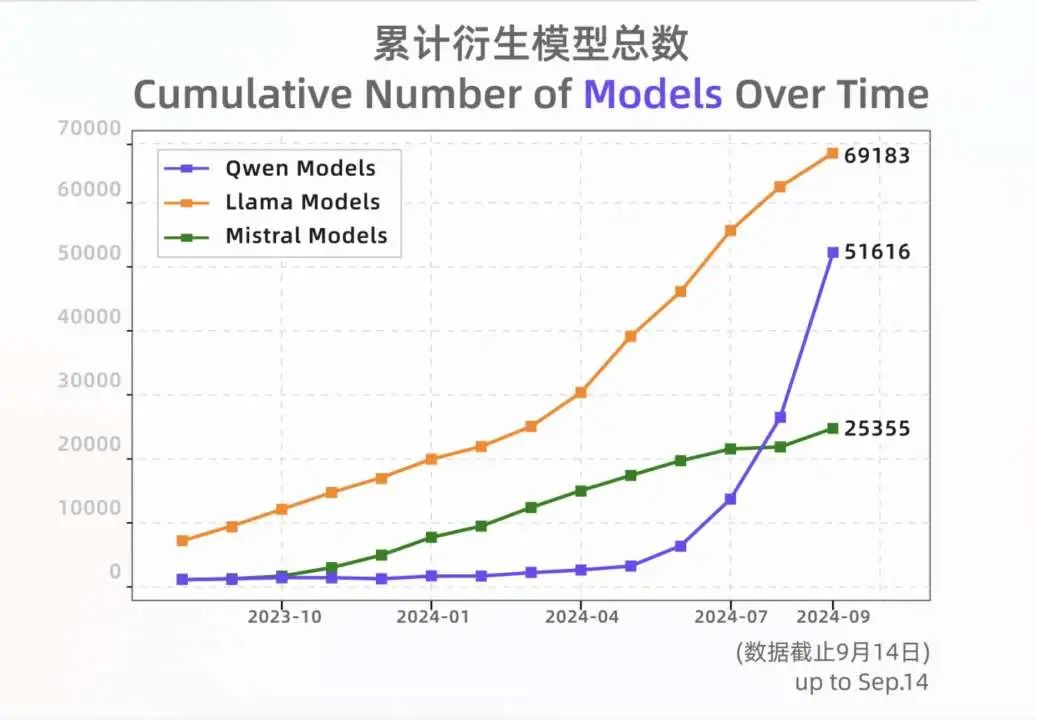

自从2023年8月开源以来,通义在全球开源大模型领域后来居上,成为开发者尤其是中国开发者的首选模型。性能上,通义大模型日拱一卒,逐步赶超美国最强开源模型Llama,多次登顶Hugging Face全球大模型榜单。

通义从零起步、开疆拓土,与海内外的开源社区、生态伙伴、开发者共建生态网络,截至2024年9月中旬,通义千问开源模型下载量突破4000万,Qwen系列衍生模型总数超过7.43万个,Qwen成长为世界最大的生成式语言模型族群。

在全球范围内已有超30万企业客户接入,覆盖金融、医疗、教育等多个领域。众多高校和企业基于Qwen开发专属模型,如浙江大学的教育模型、浙江有鹿的机器人应用、以及一汽、联想、微博、携程、喜马拉雅、三得利(中国)等。

我们可以清楚地看到,Qwen2.5作为国产第一开源大模型,在性能、生态和口碑等各个方面都展现出了绝对的领先优势。它不仅代表了中国AI技术的最高水平,更在国际舞台上占据了重要地位。阿里云希望通过开源,让海量中小企业和AI开发者更早、更快地用上通义千问,推动大模型技术的普惠和应用的落地,促进中国大模型生态建设。相信在未来,这个国产第一开源大模型将继续引领行业发展,为中国乃至全球的AI技术进步做出更大贡献!

那么,如何系统的去学习大模型LLM?

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

作为一名热心肠的互联网老兵,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。

但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

所有资料 ⚡️ ,朋友们如果有需要全套 《LLM大模型入门+进阶学习资源包》,扫码获取~

篇幅有限,部分资料如下:

👉LLM大模型学习指南+路线汇总👈

💥大模型入门要点,扫盲必看!

💥既然要系统的学习大模型,那么学习路线是必不可少的,这份路线能帮助你快速梳理知识,形成自己的体系。

路线图很大就不一一展示了 (文末领取)

👉大模型入门实战训练👈

💥光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉国内企业大模型落地应用案例👈

💥两本《中国大模型落地应用案例集》 收录了近两年151个优秀的大模型落地应用案例,这些案例覆盖了金融、医疗、教育、交通、制造等众多领域,无论是对于大模型技术的研究者,还是对于希望了解大模型技术在实际业务中如何应用的业内人士,都具有很高的参考价值。 (文末领取)

👉GitHub海量高星开源项目👈

💥收集整理了海量的开源项目,地址、代码、文档等等全都下载共享给大家一起学习!

👉LLM大模型学习视频👈

💥观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。 (文末领取)

👉640份大模型行业报告(持续更新)👈

💥包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

👉获取方式:

这份完整版的大模型 LLM 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

😝有需要的小伙伴,可以Vx扫描下方二维码免费领取🆓

272

272

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?