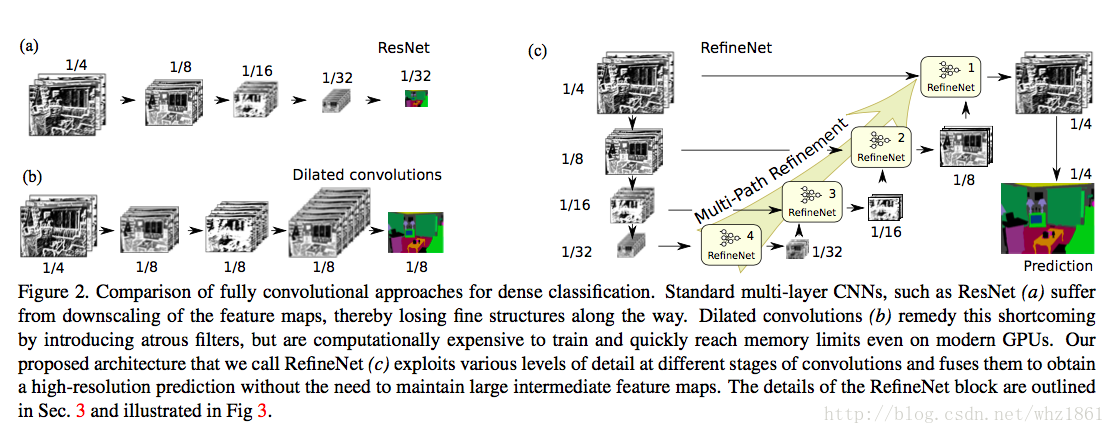

Repeated subsampling operations like pooling or convolution striding in deep CNNs lead to a significant decrease in the initial image resolution.

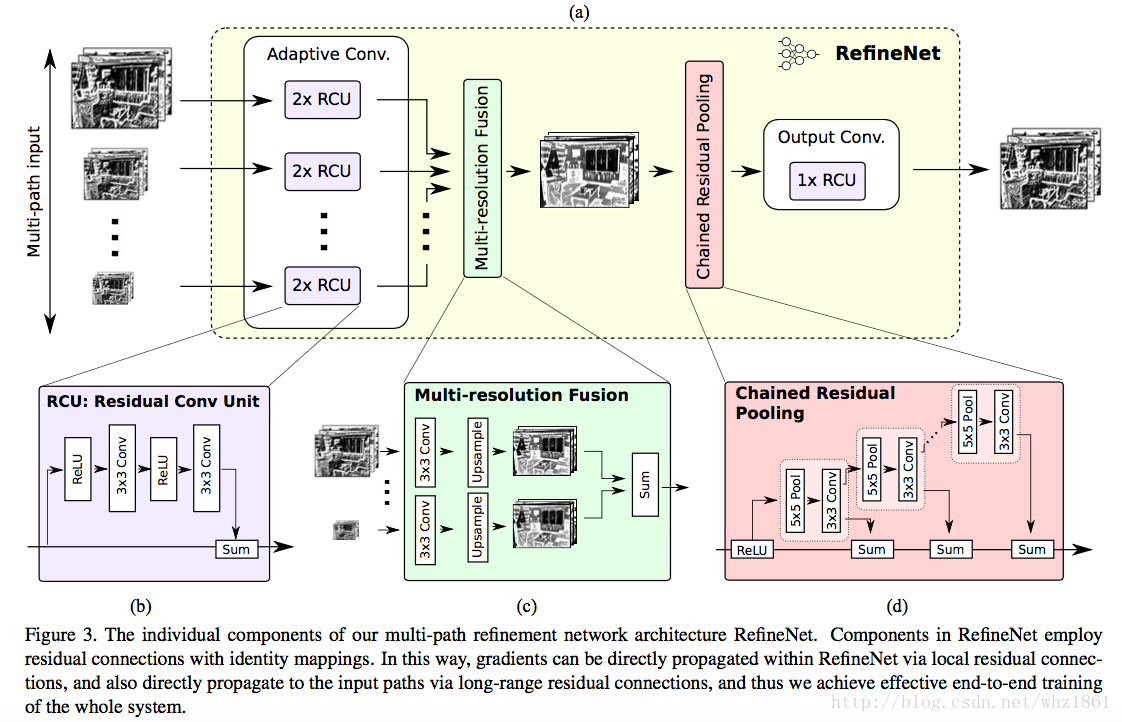

We present RefineNet, a generic multi-path refinement network that explicitly exploit all the information available alone the down-sampling process to enable high-resolution prediction using long-range residual connections.

模型

- 说明

- 图a)代表的是标准的CNN结构

- 图b)代表的是带孔卷积dilated convolutions

- 图c)代表的是RefineNet的思路

- 每一个小模块是一个RefineNet

- 融合了不同尺度下的RefineNet结果

- 最终upsample到原图的1/4大小

- 每一个RefineNet是多个残差模块作为输入

- RefineNet-4的filter个数为512

- 其他残差模块的filter个数为256

- 每一个基础模型中的输出,进行两次残差计算RCU模块

- 每一个RCU输出结果,都经过Multi-resolution Fusion模块

- 3x3conv+upsample,上采样到该层最大的分辨率

- 将不同的输入进行求和

- 上一层融合的结果进行CRP模块【默认采用2个pool层】

- 经过一次ReLU非线性激活

- 证明该操作对于后面的pool操作非常有用

- 使得模型对于学习率变的没有那么敏感了

- 该操作没有是的网络的梯度传递变的效率低

- 经过3次pool+conv然后sum融合操作

- 每一次pool为上一层pool+conv的结果

- pool操作的步长为1

注:CRP模块的作用:能够捕获背景纹理

- 经过一次ReLU非线性激活

- 最后接一个RCU模块【残差模块】作为输出

- RefineNet-1中在softmax之前,采用了2个RCU模块作为输出

- 每一个RefineNet是多个残差模块作为输入

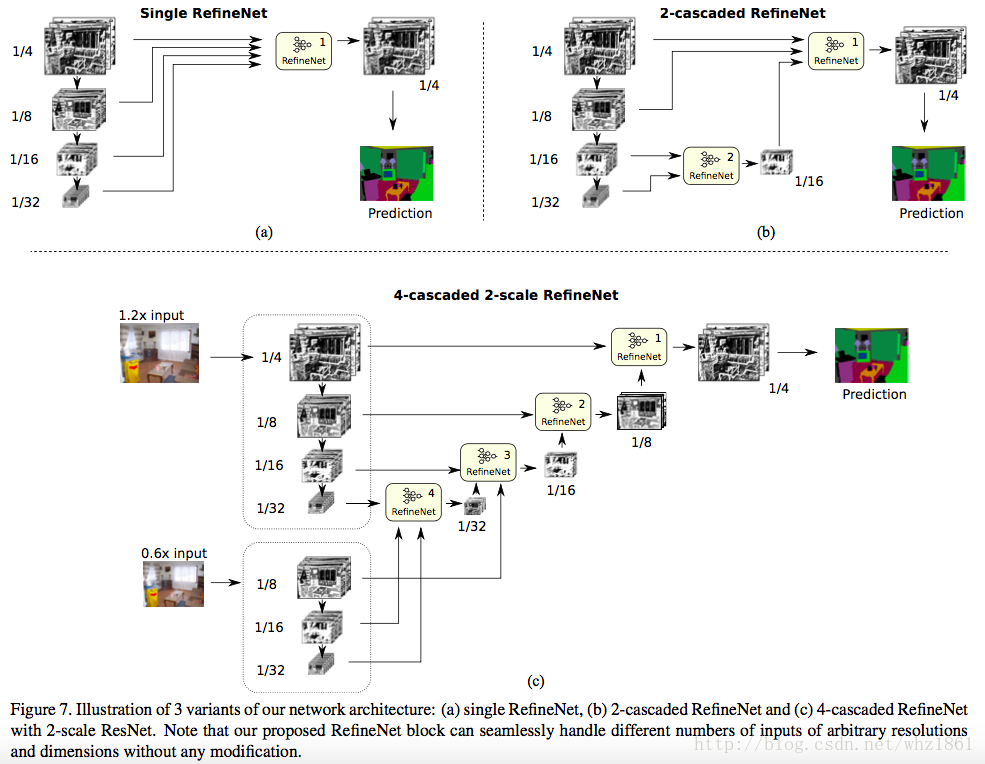

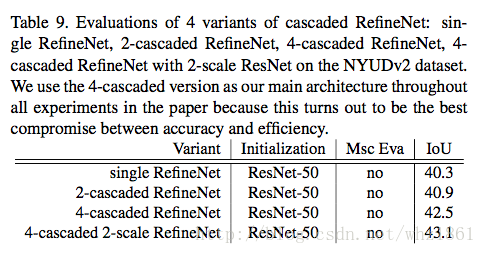

不同的网络结构

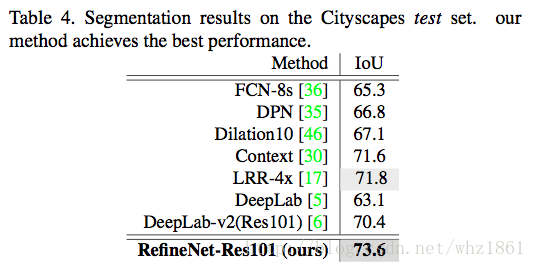

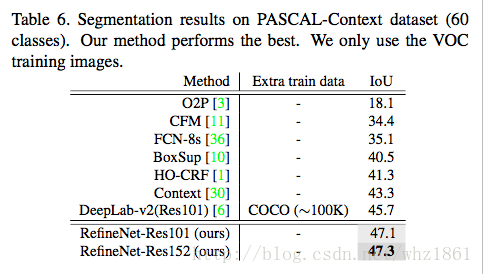

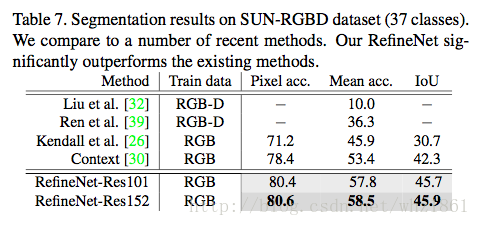

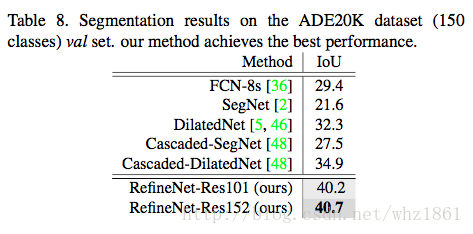

效果

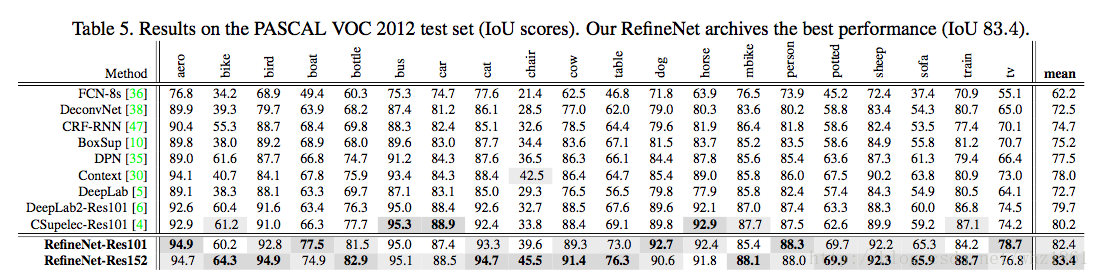

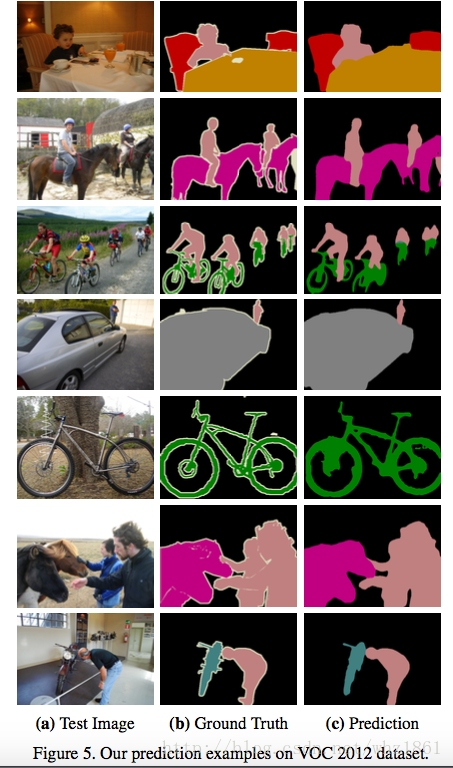

VOC数据集上的效果

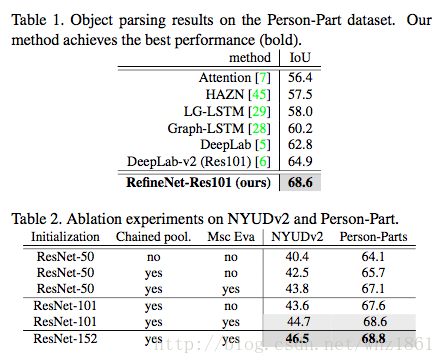

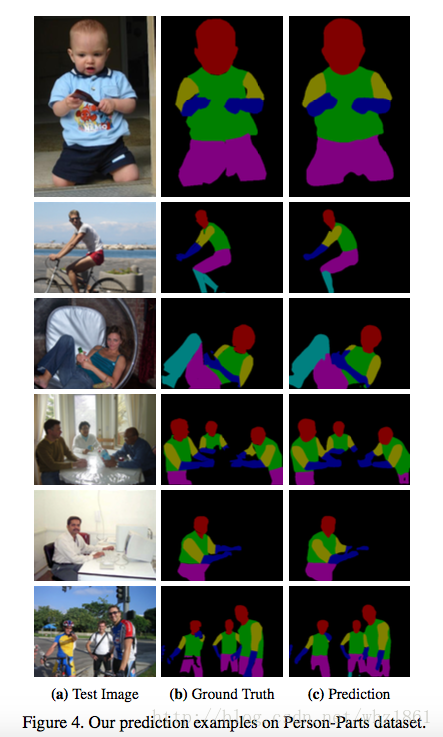

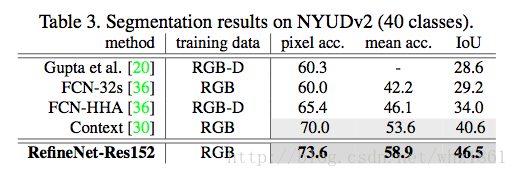

其他数据集效果

总结

本文提出了一种multi-path refinement的网络结构,通过long-range和short-range的残差模型的多层连接,能够将high-level semantics和low-level features有效的融合映射到原图高分辨的分割信息上。

8653

8653

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?