rnn不能并行的原因:不同时间步的隐藏层之间有关联。

rnn中batch的含义

如何理解RNN中的Batch_size?_batch rnn_Forizon的博客-CSDN博客

rnn解决的问题

- 不定长输入

- 带有顺序的序列输入

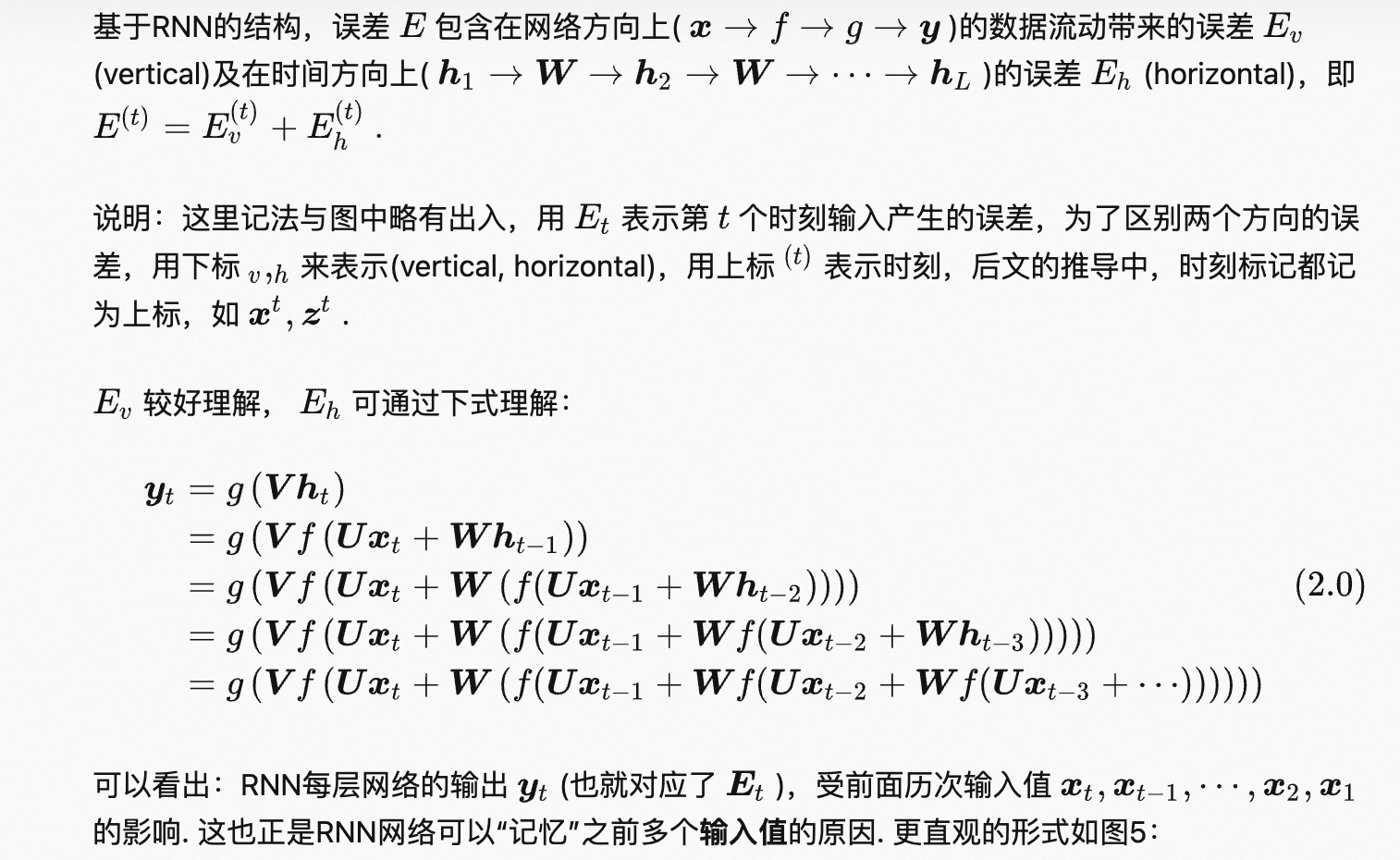

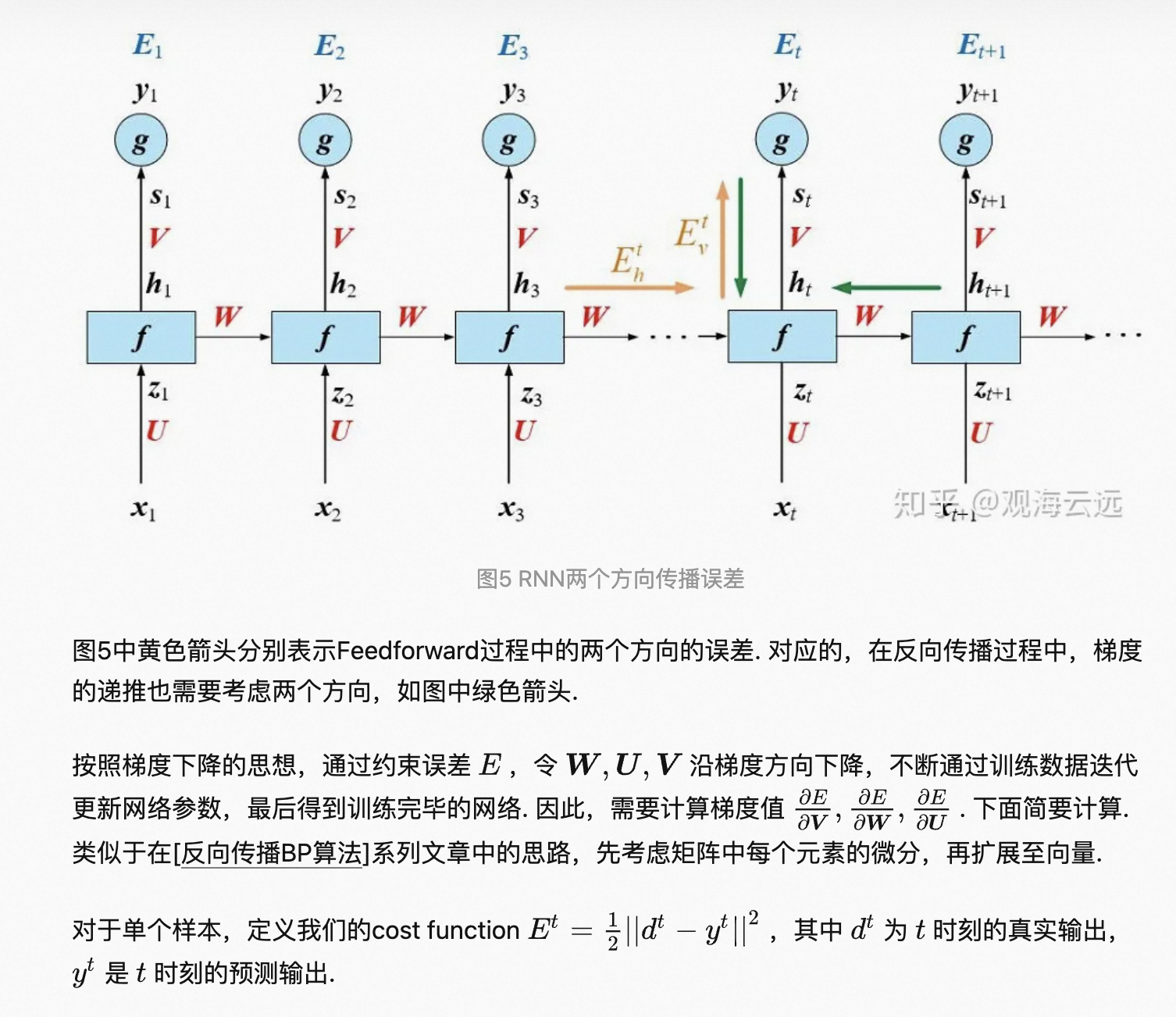

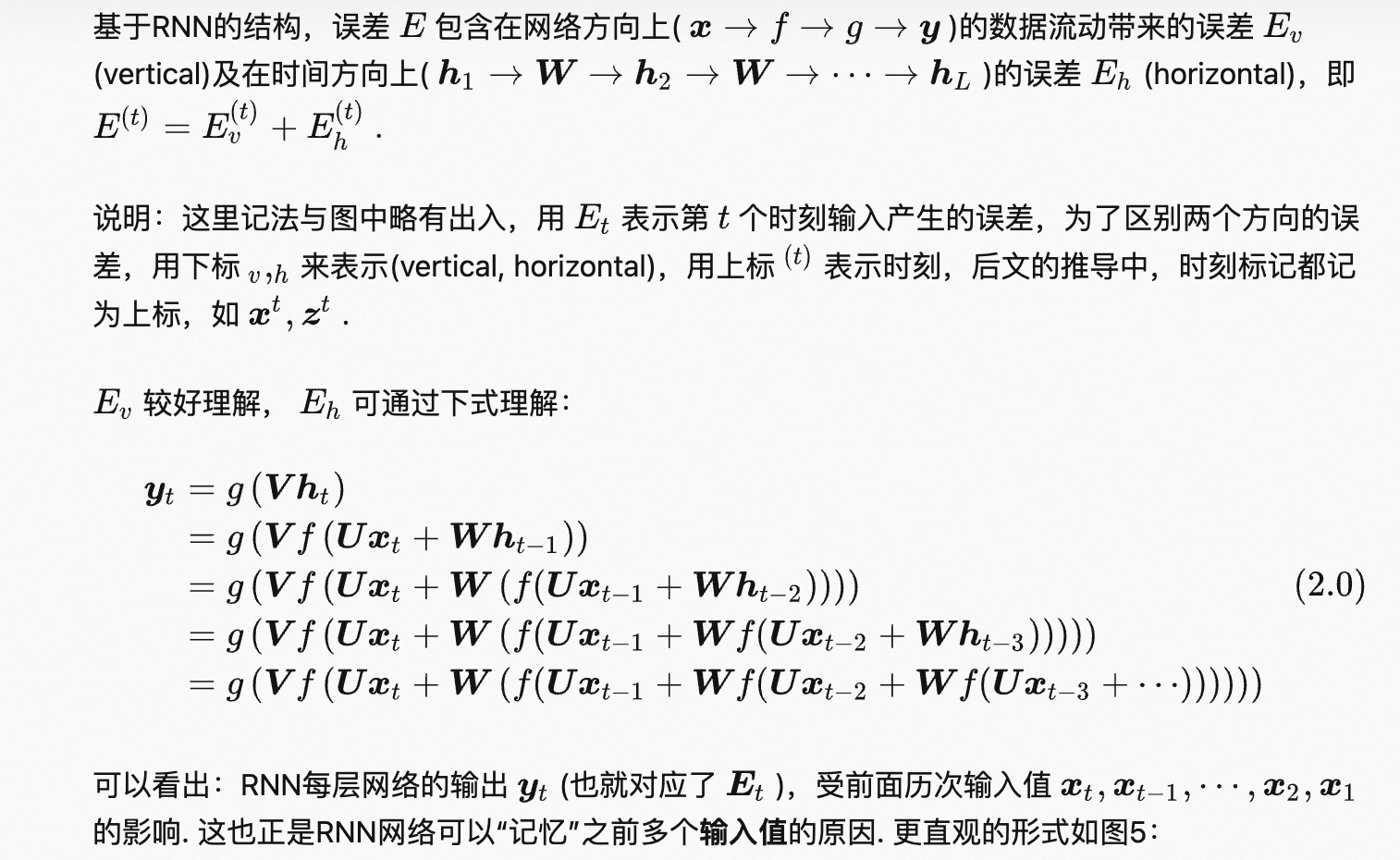

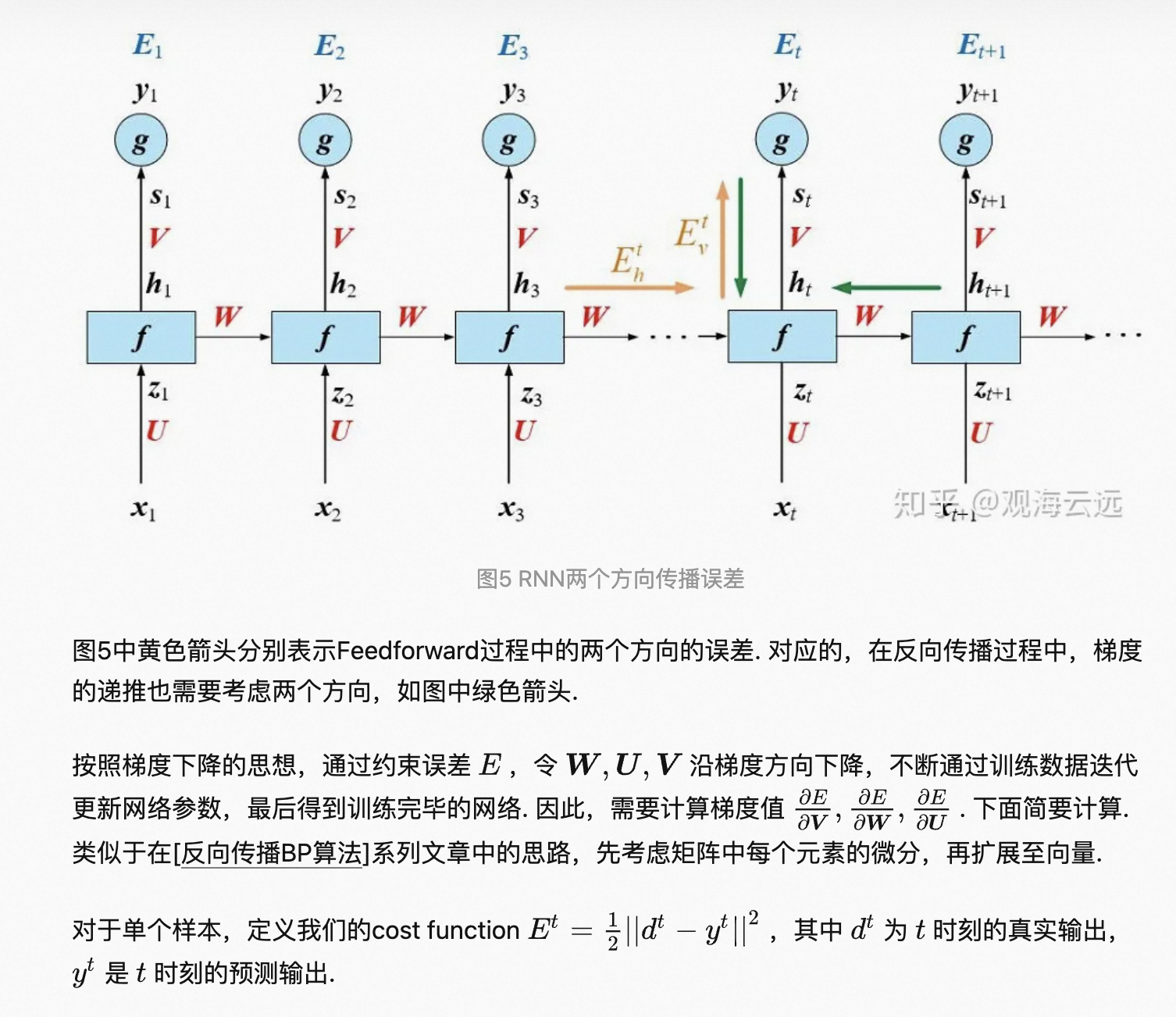

1 rnn前向传播

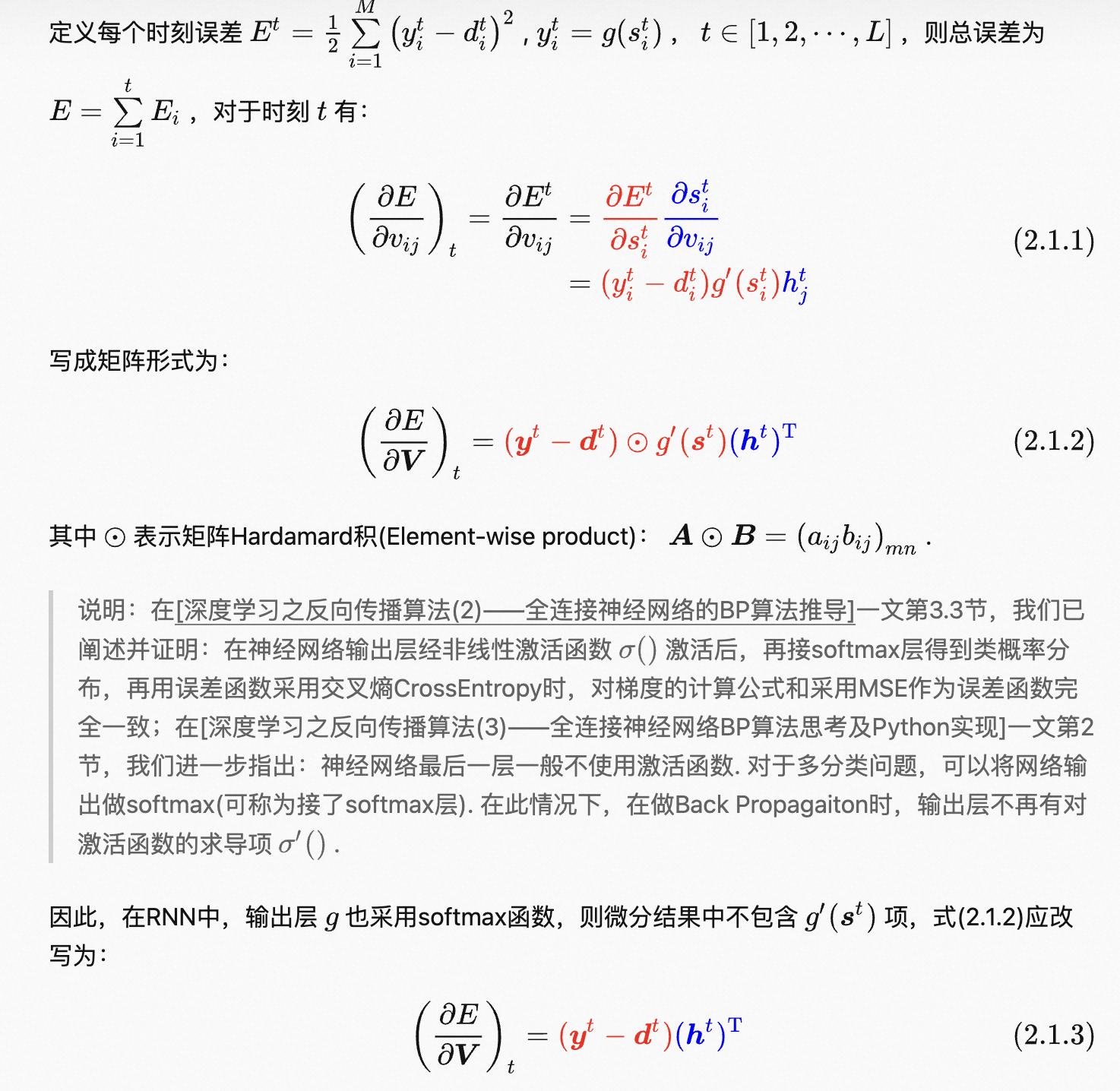

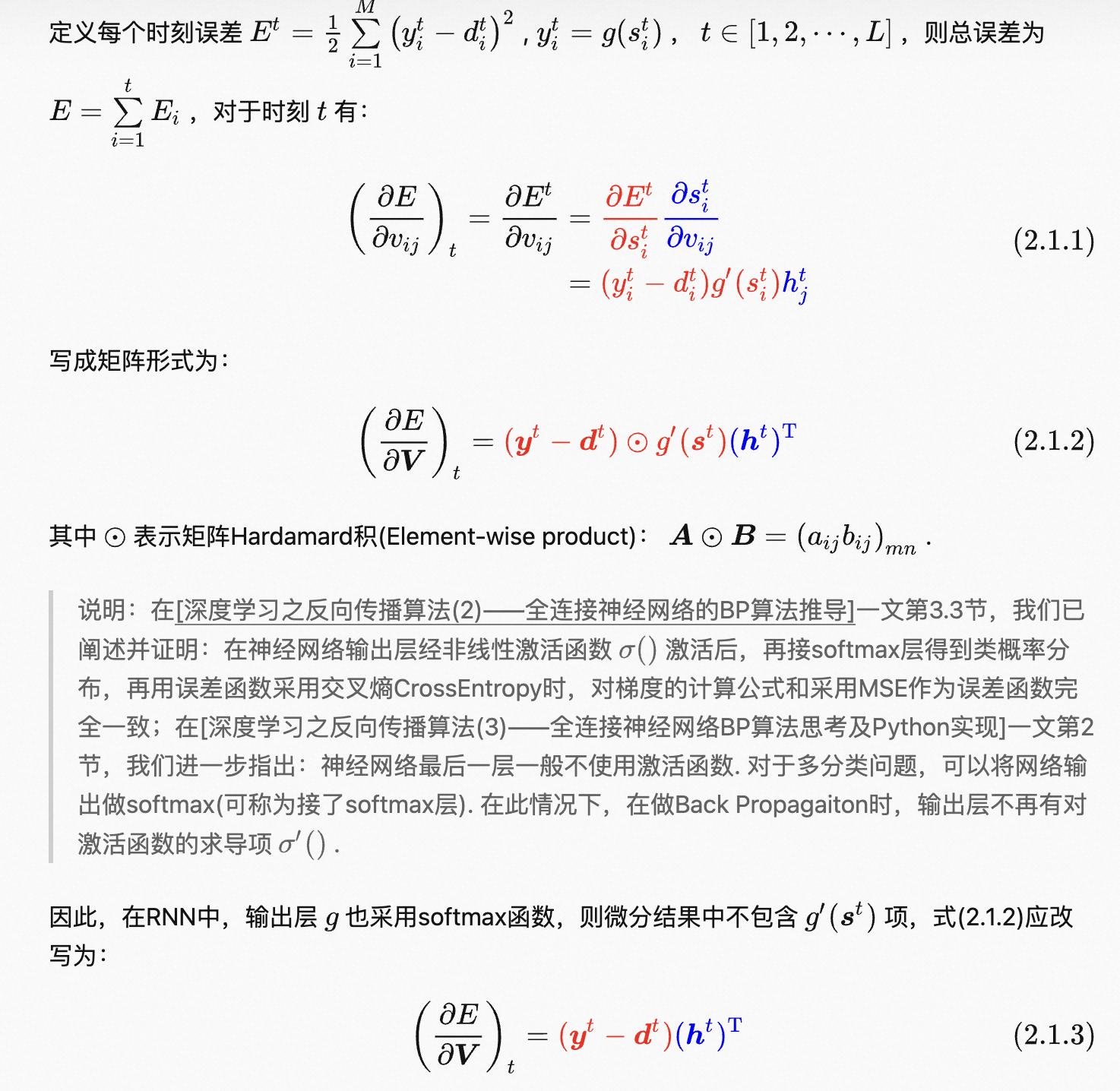

2 rnn中的反向传播

还有loss对其他参数的求导,较为复杂。

rnn不能并行的原因:不同时间步的隐藏层之间有关联。

rnn中batch的含义

如何理解RNN中的Batch_size?_batch rnn_Forizon的博客-CSDN博客

rnn解决的问题

1 rnn前向传播

2 rnn中的反向传播

还有loss对其他参数的求导,较为复杂。

3645

3645

1739

1739

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?