论文标题: Scalable diffusion models with transformers

论文链接:https://openaccess.thecvf.com/content/ICCV2023/html/Peebles_Scalable_Diffusion_Models_with_Transformers_ICCV_2023_paper.html

代码:https://github.com/facebookresearch/DiT/blob/main/README.md

引用:Peebles W, Xie S. Scalable diffusion models with transformers[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. 2023: 4195-4205.

导读

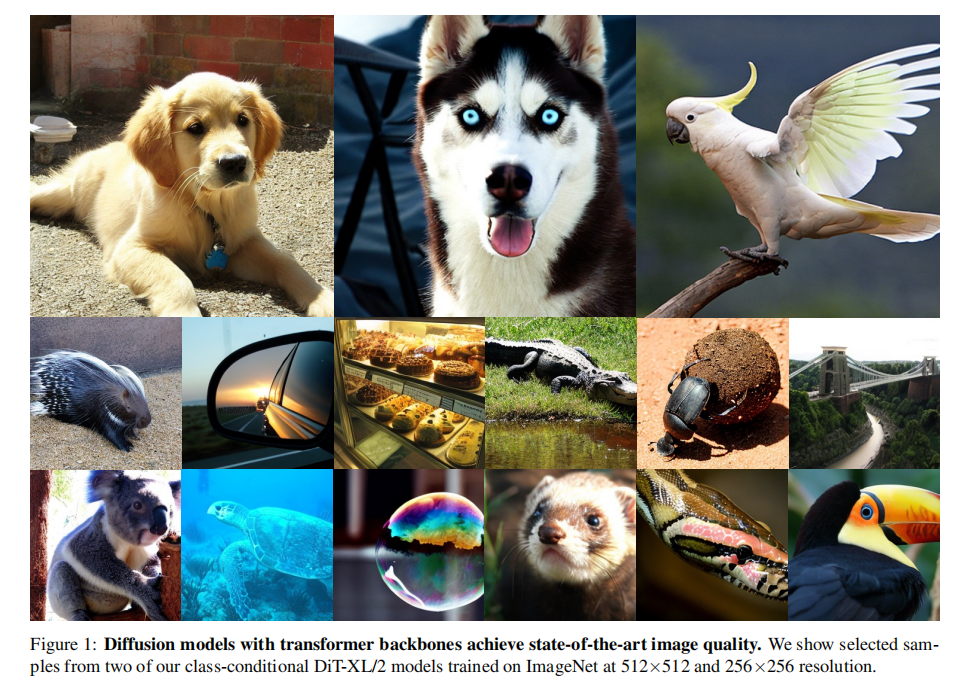

本文探索了一种基于 transformer 体系结构的新型扩散模型。作者使用Transformer来训练图像的潜在扩散模型,取代了通常使用的U-Net骨干网络,这个Transformer操作在潜在图像块上。研究还分析了这种新模型的可伸缩性,通过Gflops(每秒十亿次浮点运算)来衡量前向传播复杂性。研究发现,具有更高Gflops的Diffusion Transformers(DiTs)——通过增加Transformer的深度/宽度或增加输入标记的数量——通常具有更低的FID(Frechet Inception Distance)。此外,研究中最大的DiT-XL/2模型在类别条件的ImageNet 512x512和256x256基准上表现出色,取得了后者的最先进 FID 成绩为2.27。

本文贡献

提出了一种新的扩散模型架构,称之为Diffusion Transformers(DiTs)。这一架构基于Transformers,用于图像生成任务。

研究表明,传统的扩散模型架构中常用的U-Net骨干并不是性能的关键因素。他们成功地将U-Net替换为标准的Transformer架构,这意味着扩散模型可以采用更通用的设计,如Transformers,而不受限于特定的架构。

通过使用DiTs架构,研究者在 ImageNet 生成基准上实现了显著的性能提升,将FID(Frechet Inception Distance)降低到2.27,达到了最新的最先进水平。

预备知识

扩散模型的基本理论

高斯扩散模型假设了一个前向噪声过程,并逐渐将噪声应用于真实数据:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2406

2406

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?