近日,真正的“OpenAI”——Meta公司,对“Close AI”进行了有力回应,推出了其开源大模型系列的最新力作——Llama 3。自Llama 1起,这个系列便以其卓越性能在开源大模型领域独占鳌头。在相同规模的参数量下,它无疑是最出色的选手之一。而Llama 3更是青出于蓝,不仅在技术层面实现了对Llama 2的重大突破,还在各种评估测试中展现出令人瞩目的表现。这标志着AI技术又迈出了坚实的一步。

目前,推出了两个版本,分别是8B和70B。

目前,推出了两个版本,分别是8B和70B。

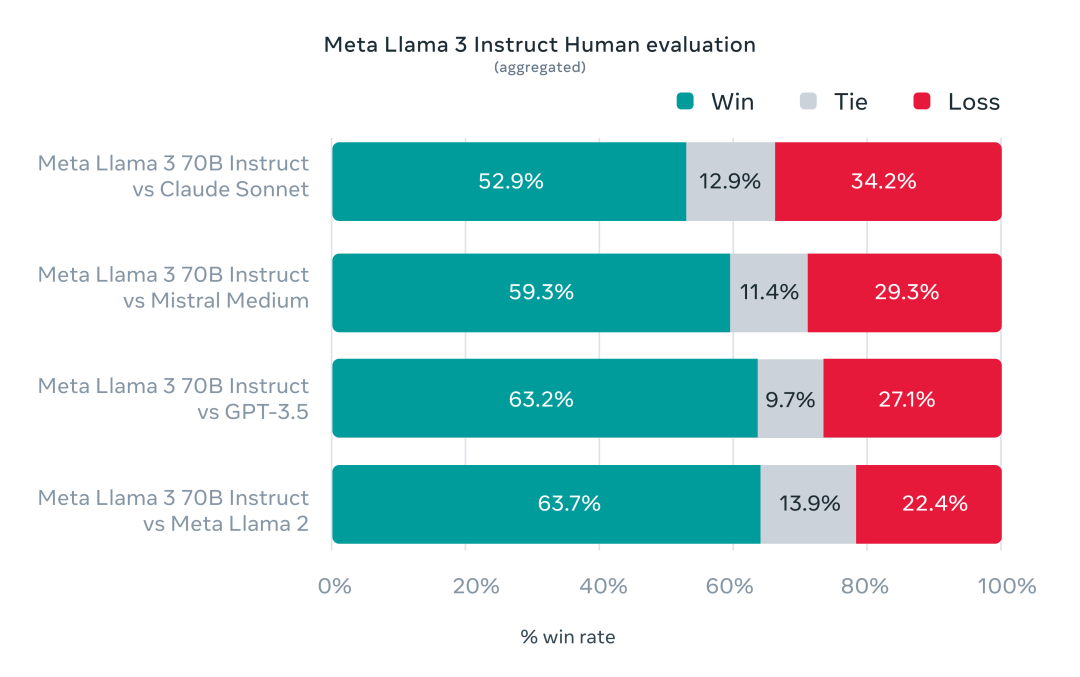

在与同等级别的Gemma和Mistral开源模型较量中,8B版本展现出了显著的优势。

至于70B版本,它在与Gemini Pro 1.5及Claude的Sonnet模型的比拼中,表现得旗鼓相当,难分伯仲。

值得注意的是,70B版本在实际应用中的效能测评已清晰地超出了GPT 3.5的水平。

如今,有机会在个人计算机上本地安装并运行一个相当于GPT-3.5级别的人工智能模型,这标志着技术的一大进步。

如今,有机会在个人计算机上本地安装并运行一个相当于GPT-3.5级别的人工智能模型,这标志着技术的一大进步。

此次升级不仅显著提升了模型的运行效率,还引入了一项创新特性——文本生成图像功能。

用户现在可以访问Meta AI的官方网站,尝试这个功能的测试版本,亲身体验这一技术创新带来的惊喜。

在自己的电脑上部署GPT4All

轻松运行大型语言模型 由于Meta AI的限制,目前非美国用户很难在线体验特定服务。

不过不用担心,本文将指导你如何在个人电脑上部署并运行类似服务。

我们将使用GPT4All,一个强大的开源工具,让你无需复杂设置就能在普通设备上训练和运行大规模语言模型。

什么是GPT4All?

GPT4All是一个创新的软件生态系统,它的魅力在于,只需占用3GB至8GB的磁盘空间,你就能在笔记本或台式机上运行拥有数亿参数的大型语言模型,这在过去是难以想象的。

安装GPT4All客户端

要开始这个安装,首先访问GPT4All的官方网站。

网站提供了适用于不同操作系统的客户端安装包。

只需选择与你的电脑系统匹配的版本,下载并进行安装。

简单几步,你就能拥有自己的本地语言模型运行环境。

首先,访问官方网站:https://gpt4all.io

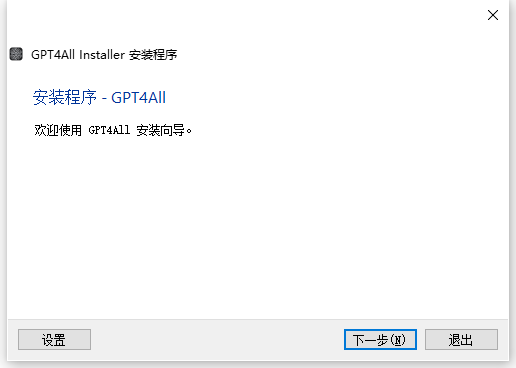

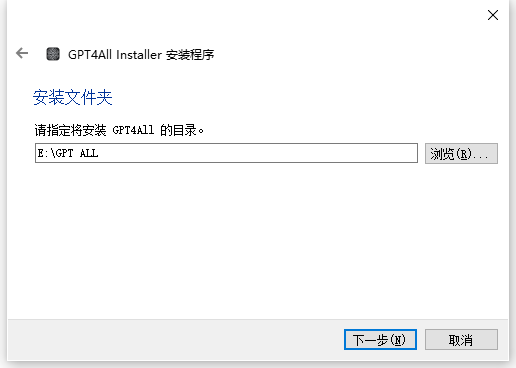

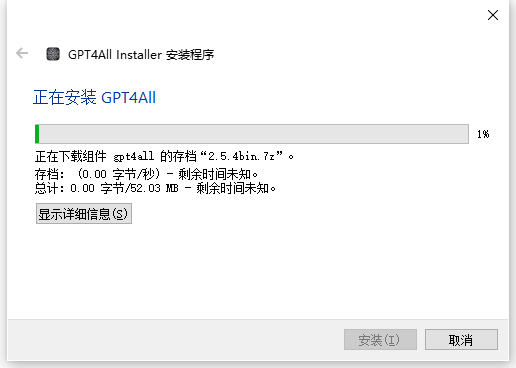

完成资源的下载。随后,我们将逐步进行安装流程,确保每个步骤都清晰无误:

该应用程序的内存占用约为200MB,算是较为轻量级的,因此用户可依据自身需求灵活选择将其安装在C盘或任何其他磁盘。不过,推荐避免将安装位置设在含有中文名称的文件夹路径下,以确保软件的正常运行。

按照指示,不断地选择“下一步”,直到整个安装过程顺利完成

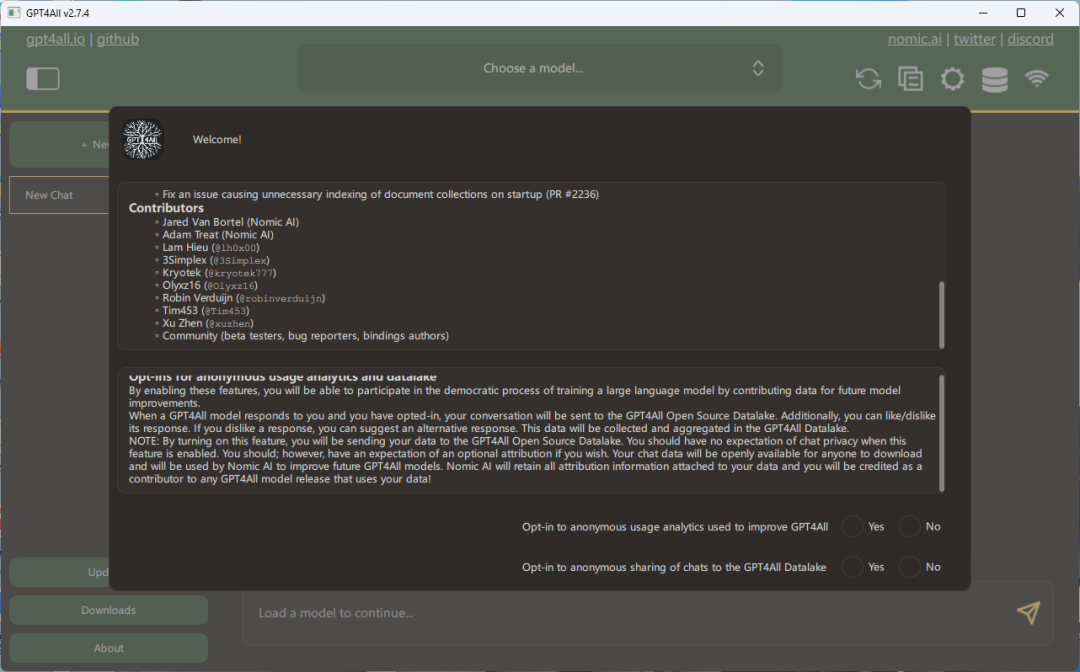

在初次安装并运行程序时,用户将会遇到一个特定的界面提示:

该规定旨在通过收集您的对话记录,以便对GPT4All系统进行优化升级。如您重视个人隐私,完全可以毫不犹豫地统一选择“不同意”。如此一来,网页将随即显示三个核心模型的下载选项界面。

该规定旨在通过收集您的对话记录,以便对GPT4All系统进行优化升级。如您重视个人隐私,完全可以毫不犹豫地统一选择“不同意”。如此一来,网页将随即显示三个核心模型的下载选项界面。

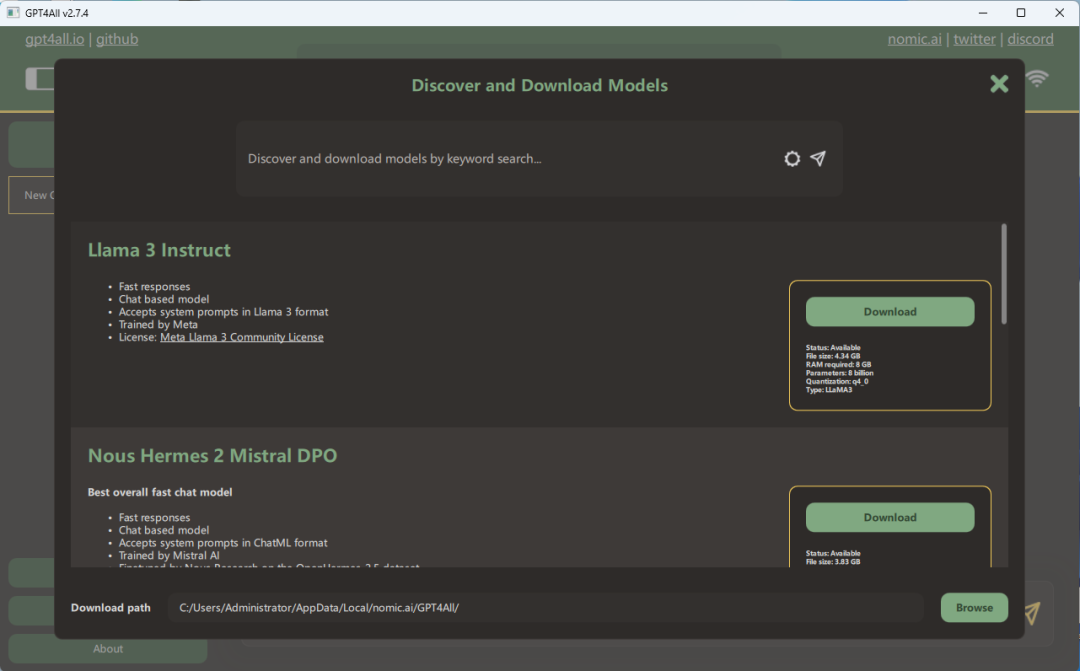

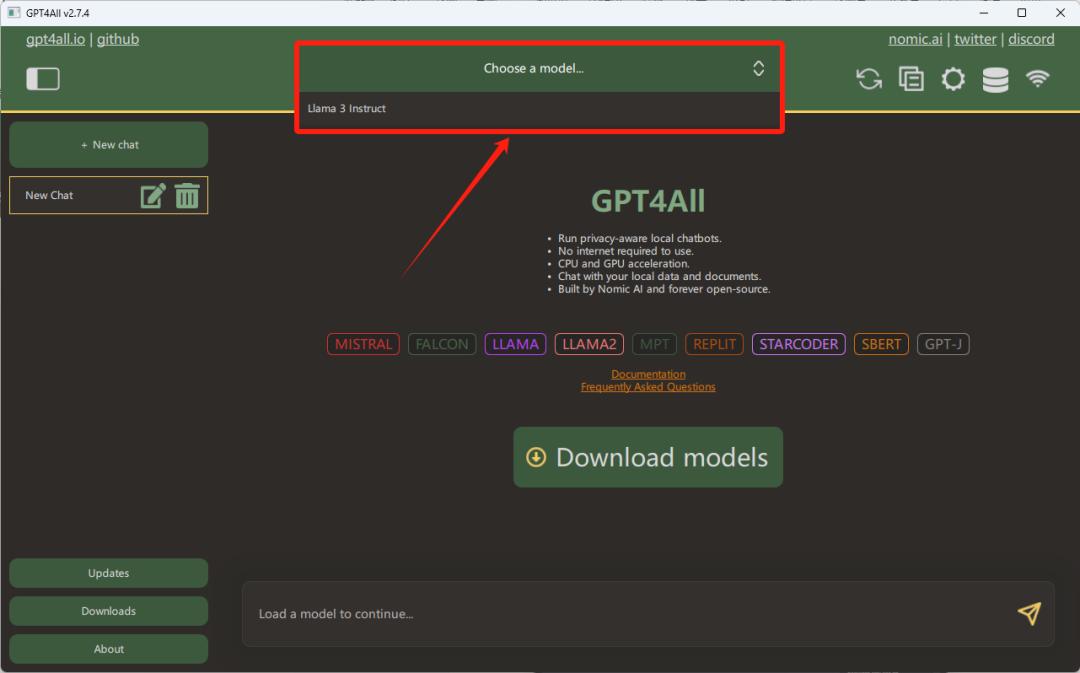

只需轻点“Download”按钮,即可启动下载过程。我们选择的是3系列的8B模型版本,对于70B的庞大模型,硬件要求相对苛刻一些。如果你的设备性能强劲,不妨尝试下载体验。不过,在此提醒,尽管8B版的参数规模不算过于庞大,但为了获得更佳的运行效果,建议至少拥有8GB显存的电脑环境。完成下载后,你会在主界面顶部看到3模型的选择选项

只需轻点“Download”按钮,即可启动下载过程。我们选择的是3系列的8B模型版本,对于70B的庞大模型,硬件要求相对苛刻一些。如果你的设备性能强劲,不妨尝试下载体验。不过,在此提醒,尽管8B版的参数规模不算过于庞大,但为了获得更佳的运行效果,建议至少拥有8GB显存的电脑环境。完成下载后,你会在主界面顶部看到3模型的选择选项

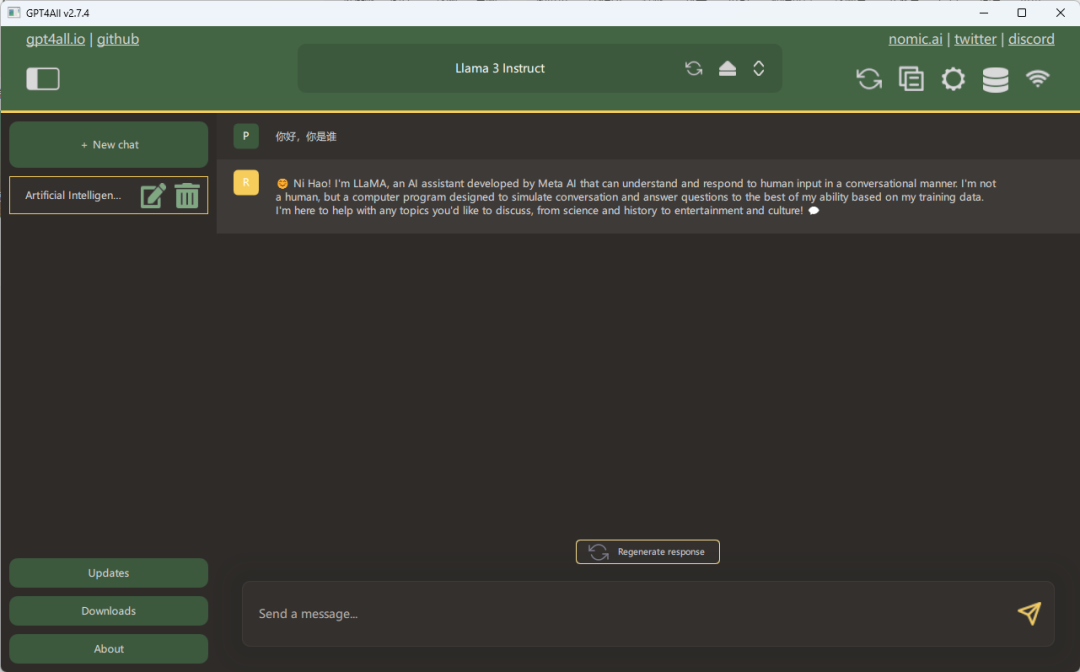

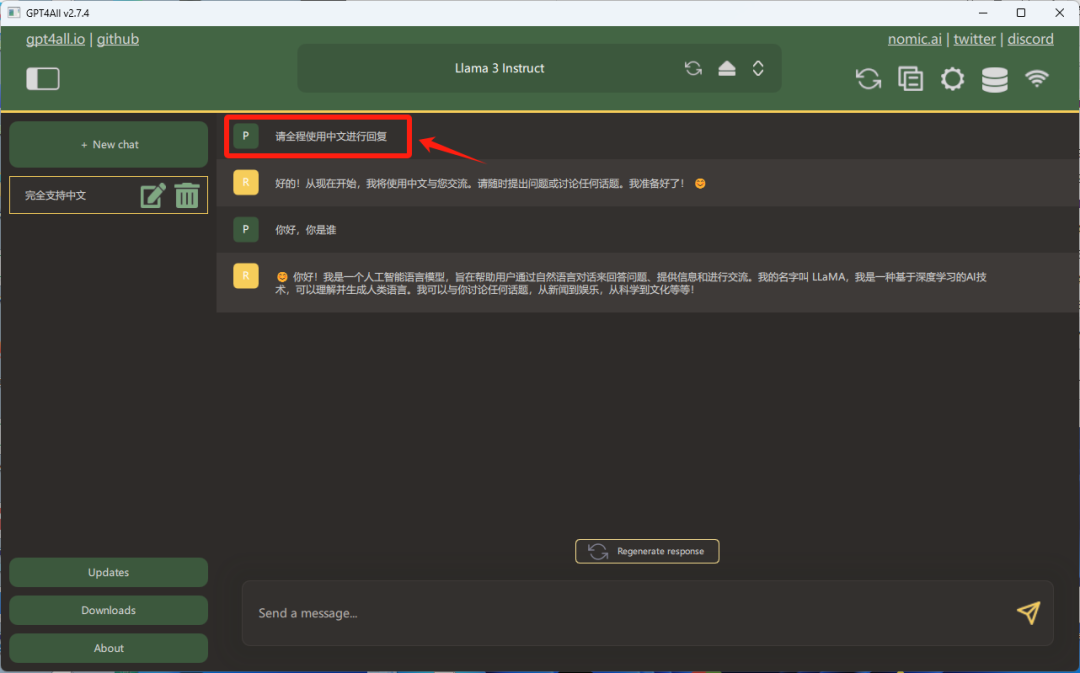

一旦GPT4All的大规模模型完成加载,我们便可以着手启动并充分利用其功能了:

一旦GPT4All的大规模模型完成加载,我们便可以着手启动并充分利用其功能了:

在新版布局中,您可以选择在右上角的设置选项中预先进行配置,这样一来,系统将会适时提供贴心的提示信息。这个功能旨在提升用户体验,确保您在操作过程中得到及时的指引,而不会错过任何重要步骤。请注意,个性化设置应当兼顾易用性和实用性,以满足不同用户的需求。在调整设置时,保留原有的直观性和便捷性是非常关键的,同时也要保证提示信息的清晰度,使之既符合常规操作习惯,又不失为一种独特的交互体验。

在新版布局中,您可以选择在右上角的设置选项中预先进行配置,这样一来,系统将会适时提供贴心的提示信息。这个功能旨在提升用户体验,确保您在操作过程中得到及时的指引,而不会错过任何重要步骤。请注意,个性化设置应当兼顾易用性和实用性,以满足不同用户的需求。在调整设置时,保留原有的直观性和便捷性是非常关键的,同时也要保证提示信息的清晰度,使之既符合常规操作习惯,又不失为一种独特的交互体验。

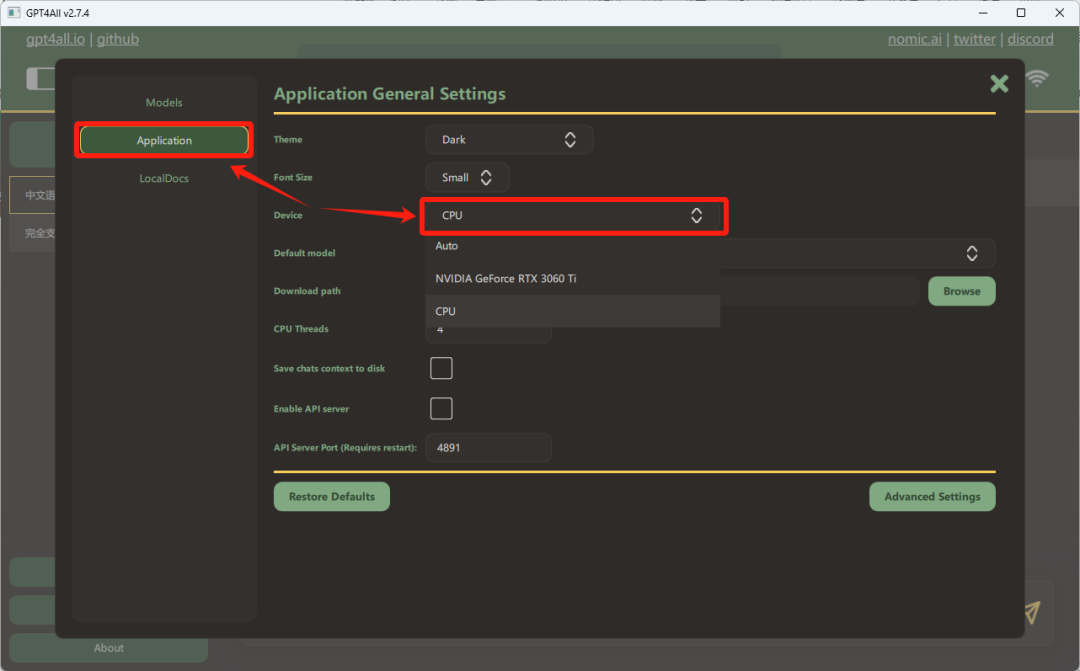

即使没有配备GPU,您也可以通过调整应用程序的设置,选择利用CPU来进行运算。请在相关选项中选择使用中央处理器(CPU),这样系统将自动适应并以CPU运行程序。虽然GPU通常能提供更快的计算速度,特别是在处理图形密集型任务时,但CPU仍然是一个可靠的替代方案,尽管其效率可能相对较低。确保在切换设置后,程序仍能稳定运行,不会影响整体性能。

即使没有配备GPU,您也可以通过调整应用程序的设置,选择利用CPU来进行运算。请在相关选项中选择使用中央处理器(CPU),这样系统将自动适应并以CPU运行程序。虽然GPU通常能提供更快的计算速度,特别是在处理图形密集型任务时,但CPU仍然是一个可靠的替代方案,尽管其效率可能相对较低。确保在切换设置后,程序仍能稳定运行,不会影响整体性能。

然而,这样的操作可能会导致速度有所下降:

然而,这样的操作可能会导致速度有所下降:

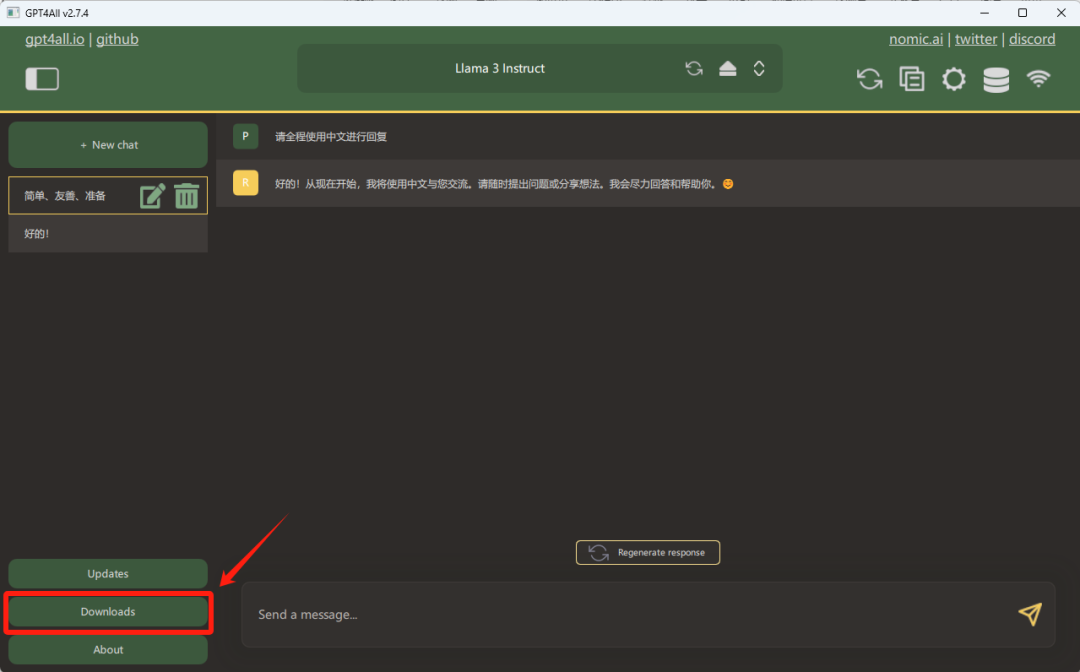

在当前的本地安装版本中,Llama 3 的一个显著局限是缺少文生图能力。然而,启用这一特性可能对计算机硬件配置提出更高的要求,这使得直接采用SD方案显得更为经济实惠。若你有兴趣尝试更多高级模型,只需在对话窗口的左侧面板点击“Download”,你就能访问模型下载页面,轻松探索各种强大的模型选择。

在当前的本地安装版本中,Llama 3 的一个显著局限是缺少文生图能力。然而,启用这一特性可能对计算机硬件配置提出更高的要求,这使得直接采用SD方案显得更为经济实惠。若你有兴趣尝试更多高级模型,只需在对话窗口的左侧面板点击“Download”,你就能访问模型下载页面,轻松探索各种强大的模型选择。

一系列大型语言模型可供下载,其文件尺寸从几十兆字节到8GB不等,相应的参数数量在4千万至惊人的130亿之间。值得注意的是,模型的参数越多,对计算机硬件配置的需求也随之增加。例如,一个拥有130亿参数的模型可能需要至少16GB的显存支持,这无疑设置了一道技术门槛,可能会让许多用户望而却步。然而,对于那些寻求妥协方案的用户,70亿参数量的模型是个不错的选择,它仅需4GB至8GB的显存,性价比显得尤为出色。每个模型都配有详细的介绍,用户可以根据自身需求选择最适合的模型进行下载。

一系列大型语言模型可供下载,其文件尺寸从几十兆字节到8GB不等,相应的参数数量在4千万至惊人的130亿之间。值得注意的是,模型的参数越多,对计算机硬件配置的需求也随之增加。例如,一个拥有130亿参数的模型可能需要至少16GB的显存支持,这无疑设置了一道技术门槛,可能会让许多用户望而却步。然而,对于那些寻求妥协方案的用户,70亿参数量的模型是个不错的选择,它仅需4GB至8GB的显存,性价比显得尤为出色。每个模型都配有详细的介绍,用户可以根据自身需求选择最适合的模型进行下载。

官方网站提供了更为详尽的模型测评,对每个模型都有深入的介绍和分析,可以满足你对更多细节的探索需求。

官方网站提供了更为详尽的模型测评,对每个模型都有深入的介绍和分析,可以满足你对更多细节的探索需求。

高性能的大模型通常与更高的分数直接相关,分数越出色,模型的效能表现越显著。为了便于用户获取这些优秀模型,官方提供了一个如同客户端般便捷的下载选项,只需轻轻一点,即可轻松完成下载过程。

高性能的大模型通常与更高的分数直接相关,分数越出色,模型的效能表现越显著。为了便于用户获取这些优秀模型,官方提供了一个如同客户端般便捷的下载选项,只需轻轻一点,即可轻松完成下载过程。

考虑到一些模型的体积可观,推荐将这些大型模型的存储位置设置在C盘以外的硬盘分区。这么做能有效防止在运行模型时过度占用C盘空间,避免出现系统运行缓慢或崩溃的情况。

考虑到一些模型的体积可观,推荐将这些大型模型的存储位置设置在C盘以外的硬盘分区。这么做能有效防止在运行模型时过度占用C盘空间,避免出现系统运行缓慢或崩溃的情况。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?