AI计算模式

AI技术发展至今,主流的模型是深度神经网络模型。近20年来,神经网络模型经过多样化的发展,模型总体变得越来越复杂和庞大,对硬件设备的计算速度、存储能力、通信速度的要求越来越高。尽管学者已经提出了许多方法优化模型结构,降低模型的参数量,但是伴随着人们对AI能力的要求越来越高,模型变得更大是不可避免的。

原先单CPU可进行模型的训练与推理,如今需要使用GPU、TPU等设备,并通过分布式并行的方式完成计算。因此,如何高效地训练和部署深度神经网络模型已经成为研究热点。本文对当前主流AI模型——神经网络模型的计算模式进行探讨,下面从神经网络模型的发展、轻量化模型和模型压缩、大模型分布式并行三个主题进行展开。

AI计算模式的探讨对于推动人工智能技术的发展至关重要。随着深度神经网络模型的不断演进,其复杂性和规模都在持续增长,这对计算设备提出了更高的要求。针对这一问题,需要从多个层面进行优化和创新。

首先,针对参数量更大、深度更深的神经网络模型,我们必须充分利用多GPU或者优化硬件通信的方式,确保大模型能够在有限的硬件资源下高效地进行存储和计算。同时,由于大矩阵乘法在神经网络计算中占据重要地位,我们需要对此进行专门的优化,以提高计算效率。

其次,为了支持多样化的计算操作和神经网络结构,我们需要从基本操作层面进行优化,确保神经网络模型中常用的操作都能得到高效的支持。此外,对于不同结构的神经网络,我们也需要考虑其特定的计算方式,并对其进行优化。这样不仅能提高计算效率,还能更好地满足各种应用场景的需求。

对于压缩后的模型,我们需要为其提供合适的存储方式和计算方式。量化模型和稀疏化模型是两种常见的模型压缩方法,它们能够显著减少模型的存储需求。因此,我们需要支持不同精度表示的量化模型的存储和计算,并考虑稀疏化模型中重复0值的存储和计算优化。这不仅可以减少存储空间的占用,还能避免不必要的计算开销。

轻量化模型设计是另一个重要的研究方向。通过简化模型结构、优化连接方式等方法,我们可以在保持一定性能的同时降低模型的复杂度。这不仅可以减少计算量和存储需求,还能提高模型的推理速度。因此,我们需要从神经元、网络层、网络模块、模型等不同层面进行考虑,以设计出更加高效和轻量化的模型。

最后,大模型的分布式并行计算是解决大模型训练和推理的有效手段。我们需要设计良好的并行计算策略,以充分利用多个硬件设备的计算能力。同时,通信是分布式并行计算中的瓶颈之一,我们需要从通信算法上进行优化,以减少通信开销并提高计算效率。流水线并行是一种有效的并行方式,它可以充分利用所有硬件设备的运算时间,避免设备间的等待现象。

AI计算模式的优化需要从多个方面综合考虑。通过充分利用硬件资源、优化计算操作和结构、设计轻量化模型以及实现高效的分布式并行计算,我们可以更好地应对深度神经网络模型带来的挑战,推动人工智能技术的进一步发展。

神经网络模型设计与演进

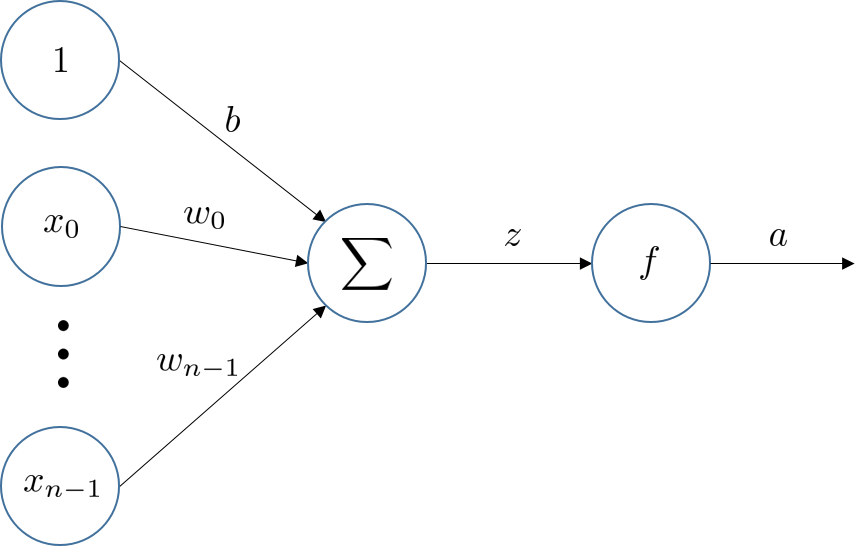

神经网络模型的基本组成单位是神经元。神经元一般有多个输入,每个输入通道都有一个权重值,这个权重值是可变的,神经网络通过不断调整权重值最后可以输出想要的结果。对于输入 x 0 , x 1 , . . . , x n − 1 x_0,x_1,...,x_{n-1} x0,x1,...,xn−1,每个输入通道都有一个权重,分别是 w 0 , w 1 , . . . , w n − 1 w_0,w_1,...,w_{n-1} w0,w1,...,wn−1,附加一个偏置 b b b,于是神经元的输入的加权和为 z = ∑ i = 0 n w i x i + b z=\sum_{i=0}^{n} w_ix_i + b z=∑i=0nwixi+b,将加权和输入到非线性激活函数 f f f中,得到该神经元的激活值, a = f ( z ) a=f(z) a=f(z)。

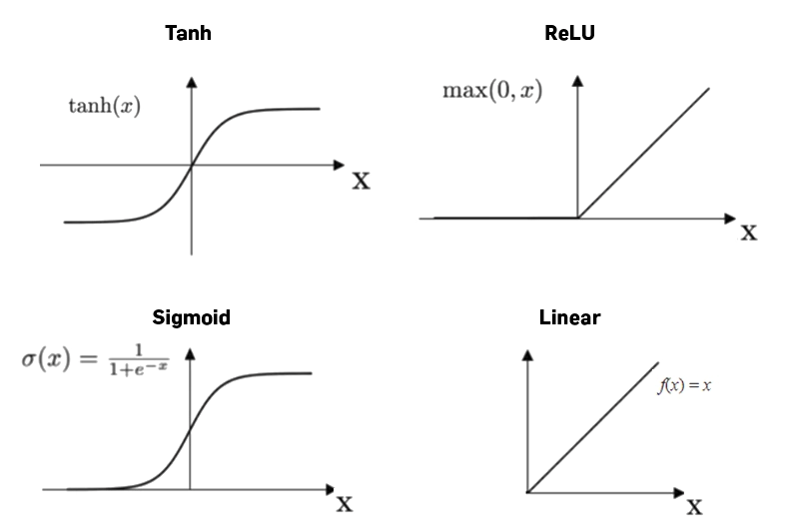

在现代神经网络中,激活函数都是连续可导的。常见的激活函数有Tanh,ReLU,Sigmoid,Linear等。

Tanh和Sigmoid函数是S型函数,左右两端的导数逐渐逼近于0。采用ReLU函数的神经元只需要进行加、乘、比较操作,计算量更小。然而,ReLU函数输出的分布是非零中心化的,输出分布有偏置,会影响梯度下降效率,且第一层的ReLU神经元有可能在一次不恰当的参数更新后在所有训练数据上都不能被激活,那么这个神经元自身参数的梯度永远都是0。为了避免上述情况,有几种ReLU函数的变种被引入,比如PReLU、LeakyReLU函数。

除了以上几种常见的激活函数,还有一类自门控激活函数,包括Swish函数和GELU函数。门控机制通过Sigmoid函数实现,输入较大时门“打开”,激活值近似于输入;输入较小时门“关闭”,激活值接近0。

神经网络中的结构

神经元通过一定的连接形式组成神经网络,目前常用的两种连接方式是前馈网络和记忆网络。前馈网络中神经元将其输出输入到下一个神经元中,网络具有层级结构,一层神经元的输出作为下一层神经元的输入。记忆网络则是神经元的输出可以作为下一时刻神经元的输入。

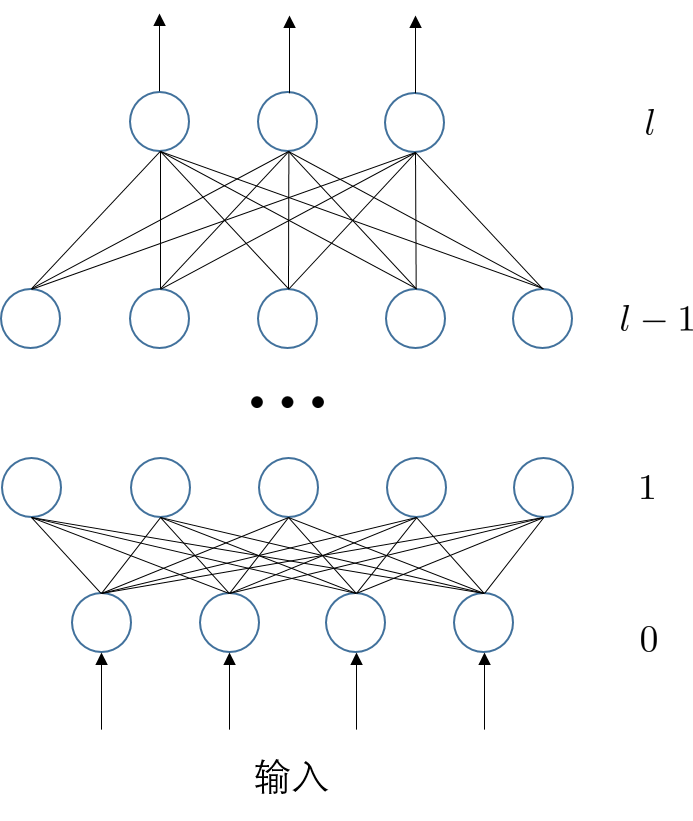

全连接网络

将输入的表示简化为向量 x \mathbf{x} x,每个神经元的所有通道权重是 w \mathbf{w} w,那么一个神经元的输出则是 σ ( w T x + b ) \sigma(\mathbf{w}^T\mathbf{x}+b) σ(wTx+b),当输入同时给多个神经元时,这些神经元输出组成的向量可以表示为

σ ( [ w 0 T w 1 T . . . w n − 1 T ] x + [ b 0 b 1 . . . b n − 1 ] ) \sigma(\Big[{ {\mathbf{w}^T_0 \atop \mathbf{w}^T_1} \atop {... \atop \mathbf{w}^T_{n-1}}}\Big]\mathbf{x}+\Big[{ {b_0 \atop b_1} \atop {... \atop b_{n-1}}}\Big]) σ([wn−1T...w1Tw0T]x+[bn−1...b1b0])

其中 [ w 0 T w 1 T . . . w n − 1 T ] \Big[{ {\mathbf{w}^T_0 \atop \mathbf{w}^T_1} \atop {... \atop \mathbf{w}^T_{n-1}}}\Big] [wn−1T...w1Tw0T]可以用矩阵 W \mathbf{W} W表示。

一个全连接层中有若干神经元,相邻全连接层的神经元之间都两两相连,因此对于第 l l l层全连接层,进行下面两种运算

z ( l ) = W ( l ) a ( l − 1 ) + b ( l ) , a ( l ) = σ ( z ( l ) ) \mathbf{z}^{(l)}=\mathbf{W}^{(l)} \mathbf{a}^{(l-1)}+\mathbf{b}^{(l)},\\ \mathbf{a}^{(l)}=\sigma( \mathbf{z}^{(l)} ) z(l)=W(l)a(l−1)+b(l),a(l)=σ(z(l))

第一种是仿射变换,第二种是非线性变换。 W ( l ) \mathbf{W}^{(l)} W(l)和 b ( l ) \mathbf{b}^{(l)} b(l)是第 l l l层的参数,第 l l l层的激活 a ( l ) \mathbf{a}^{(l)} a(l)是由第 l − 1 l-1 l−1层的激活值决定。

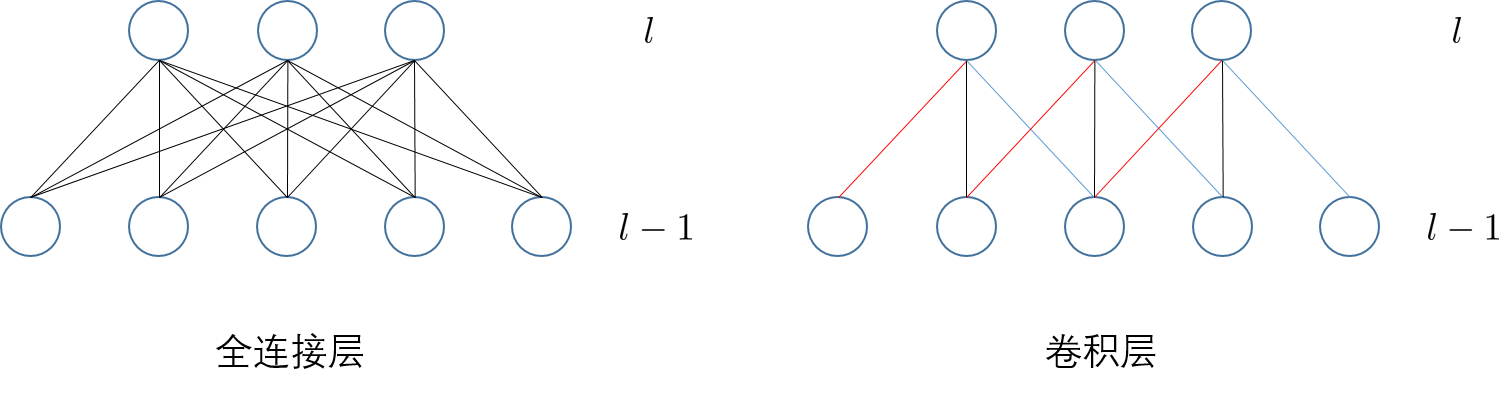

卷积神经网络

卷积层是卷积神经网络中的核心,而卷积神经网络常用于图像识别。在全连接层中,如果相邻层神经元两两连接,那么参数量会非常大,而采用卷积操作,将会大大减少可学习的参数量。卷积层有两个主要特点:1)局部连接:卷积层的每一个神经元都只和上一层的局部窗口内的神经元相连,权重参数量由原来的 M l × M l − 1 M_l \times M_{l-1} Ml×Ml−1变成 M l × K M_l \times K Ml×K, K K K是卷积核大小;2)权重共享,所有神经元共享相同的卷积核参数。

不同于全连接层的神经元采用一维的组织形式描述,为了更直观理解卷积层,常用二维或者三维形式组织卷积层的神经元。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

572

572

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?