这项工作提出了一种新颖且高效的 T2I 模型SnapGen,SnapGen 是第一个可以在1.4秒内在移动设备上合成高分辨率图像(1024x1024 ) 的图像生成模型(379M ) ,并在 GenEval 指标上 达到0.66。该模型全面超越了许多现有的数十亿参数模型,例如 SDXL、Lumina-Next 和 Playgroundv2。

相关链接

-

论文链接:https://arxiv.org/abs/2412.09619

-

项目主页:https://snap-research.github.io/snapgen/

论文介绍

介绍

现有的文本到图像 (T2I) 传播模型面临一些限制,包括模型尺寸大、运行时间慢以及移动设备上的低质量生成。本文旨在通过开发一种极小且快速的 T2I 模型来解决所有这些挑战,该模型可在移动平台上生成高分辨率和高质量的图像。我们提出了几种实现这一目标的技术。首先,我们系统地检查网络架构的设计选择,以减少模型参数和延迟,同时确保高质量的生成。其次,为了进一步提高生成质量,我们从更大的模型中采用跨架构知识提炼,使用多层次方法从头开始指导我们的模型训练。第三,我们通过将对抗性指导与知识提炼相结合来实现几步生成。我们的模型 SnapGen 首次展示了在移动设备上大约 1.4 秒内生成 10242 像素图像。在 ImageNet-1K 上,我们的模型只有 372M 个参数,在 2562 像素生成中实现了 2.06 的 FID。在 T2I 基准测试(即 GenEval 和 DPG-Bench)上,我们的模型仅有 379M 个参数,但尺寸却明显较小(例如,比 SDXL 小 7 倍,比 IF-XL 小 14 倍),超越了具有数十亿个参数的大型模型。

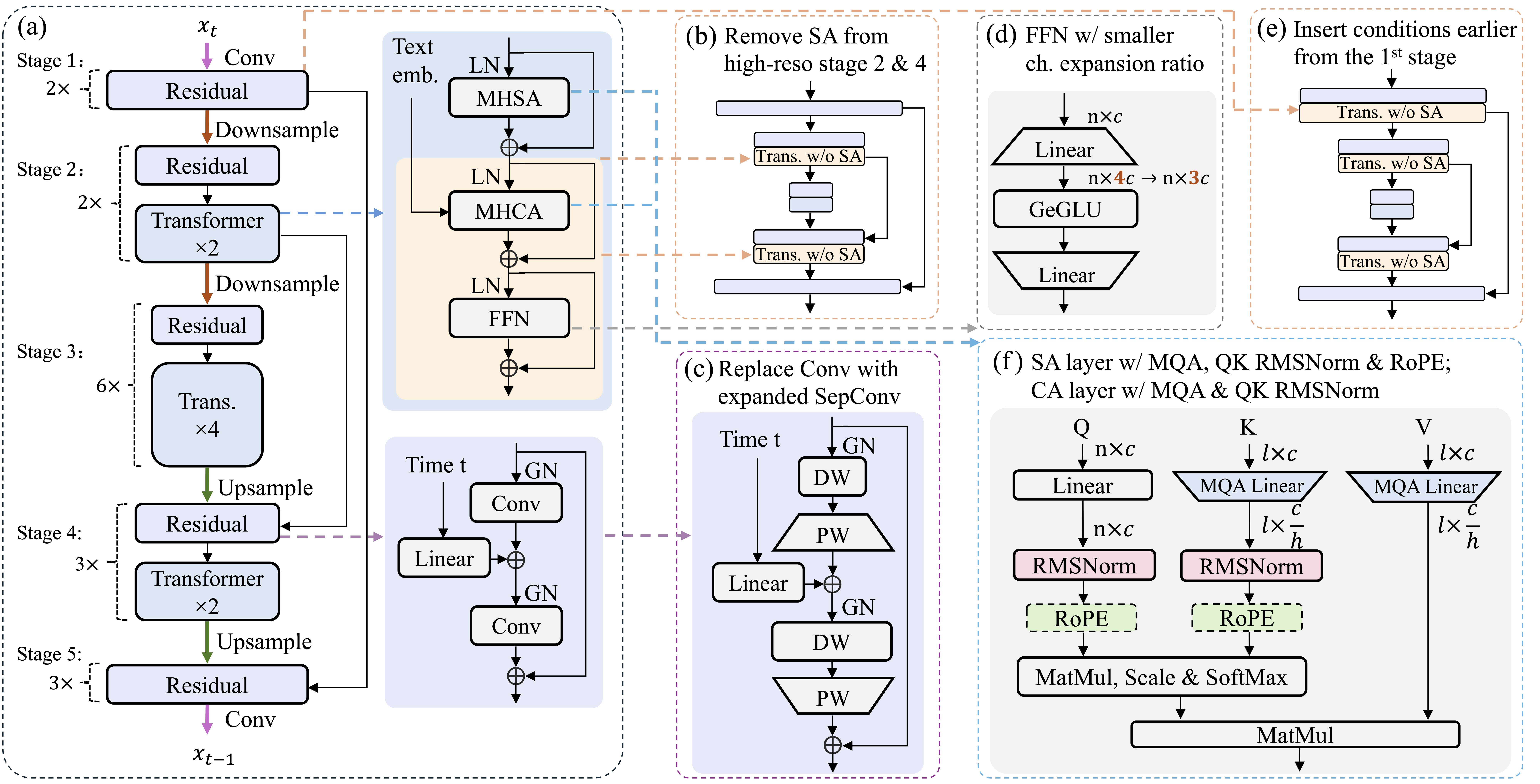

高效的架构

我们对网络架构进行了深入研究,包括去噪 UNet 和自动编码器 (AE),以在延迟和性能之间取得最佳平衡。与之前优化和压缩预训练扩散模型的工作不同,我们直接关注宏观和微观层面的设计选择,以实现一种新颖的架构,大大减少模型大小和计算复杂度,同时保持高质量的生成。

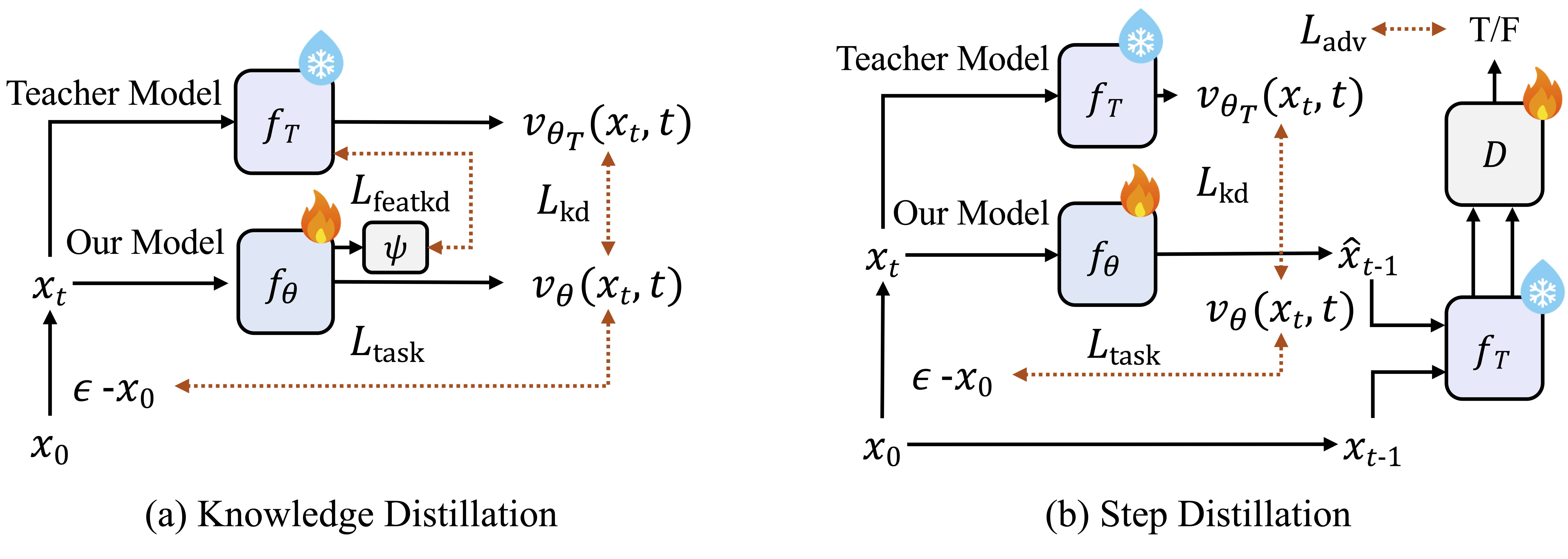

高效训练

我们引入了多项改进,从头开始训练紧凑型 T2I 模型。我们提出了一种多级知识蒸馏方法,该方法结合了时间步长感知缩放,结合了多个训练目标。我们结合对抗性训练和使用少步教师模型的知识蒸馏方法,对我们的模型进行分步蒸馏。

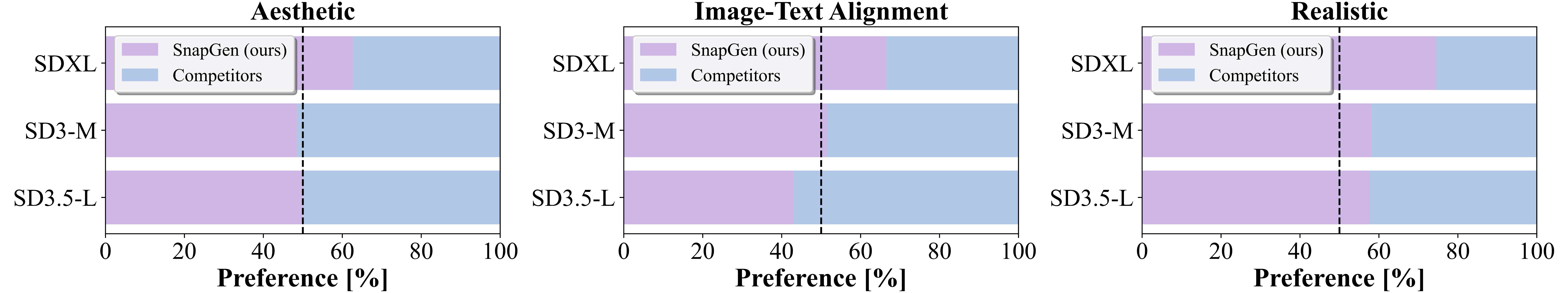

定量比较

人工评估与 SDXL、SD3-Medium 和 SD3.5-Large 的对比:

与各种基准中的现有 T2I 模型的比较:

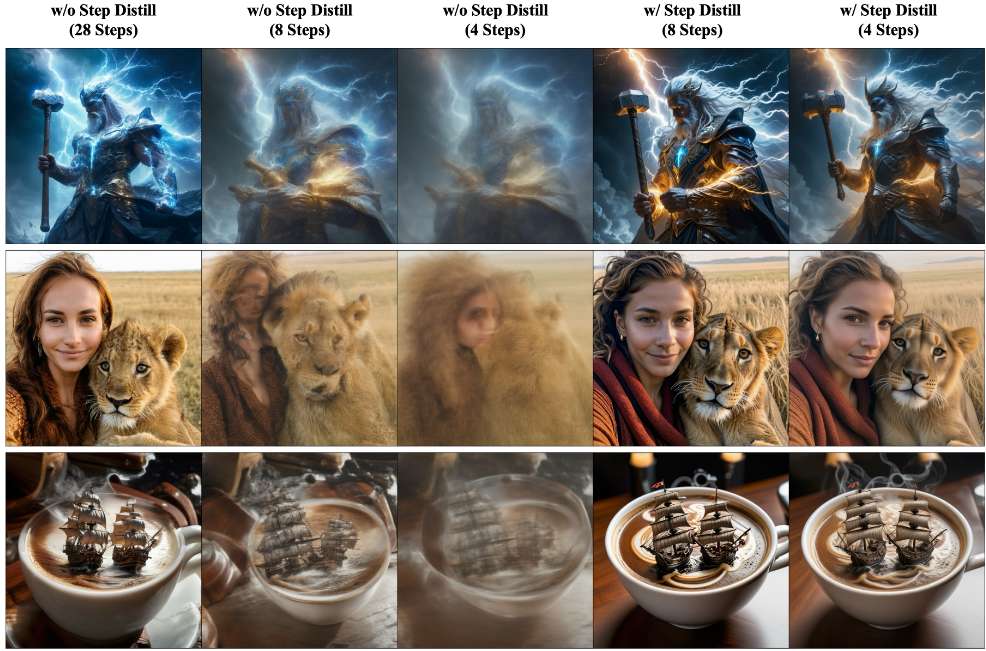

定性结果

几步可视化

总结

这项工作提出了一种新颖且高效的 T2I 模型,用于在手机上生成高分辨率图像。论文系统地详细介绍了获得微小的 379M 参数 UNet 架构以及高效潜在解码器的过程。设计了一种新颖的训练方法,包括多阶段预训练,然后从大型教师那里进行知识提炼和对抗性步骤提炼。借助这些论文实现了一个极其高效的 T2I 模型,该模型全面超越了许多现有的数十亿参数模型,例如 SDXL、Lumina-Next 和 Playgroundv2。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?