22年8月来自深圳追一科技公司的论文“RoFormer: Enhanced Transformer With Rotary Position Embedding“。注:该位置编码技术已经在LlaMA采用。

位置编码最近在Transformer架构中显示出了有效性。在序列中不同位置元素之间的依赖关系建模,它提供有价值的监督。本文首先研究将位置信息集成到基于Transformer语言模型的学习过程。然后,作者提出一种新的方法,称为旋转位置嵌入(RoPE),可有效地利用位置信息。具体而言,所提出的RoPE用旋转矩阵对绝对位置进行编码,同时在自注意公式中引入显式的相对位置依赖性。值得注意的是,RoPE实现了有价值的特性,如序列长度的灵活性、随相对距离增加而衰减的token间依赖性,以及为线性自注意配备相对位置编码。最后,在各种长文本分类基准数据集上评估了这个旋转位置嵌入的增强Transformer,也称为RoFormer。RoFormer已集成到开源的Huggingface代码库中。

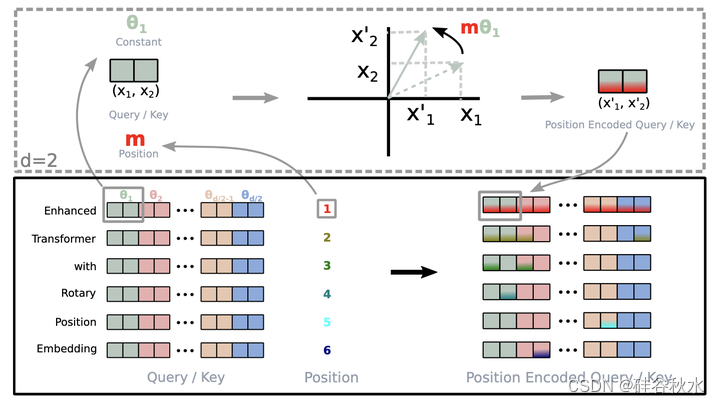

如图是RoPE的实现示意图:

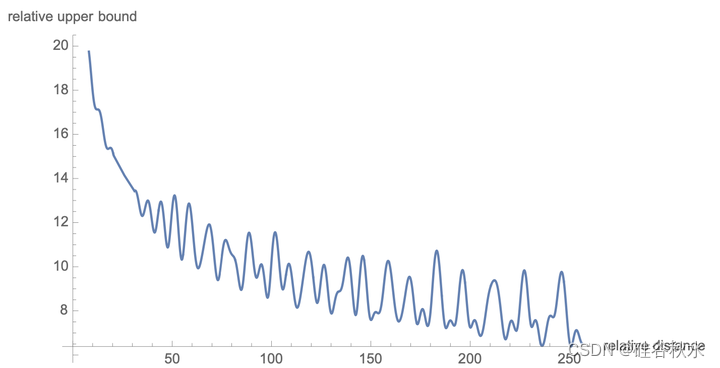

下图显示RoPE的长时衰减特性:

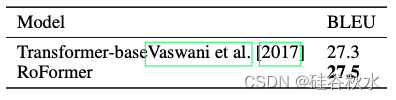

实验中,对基线模型 Vaswani [2017] 的自注意层进行一些修改,以使 RoPE 能够进行学习。复制基于联合源和目标字节对编码 (BPE) Sennrich [2015) 的词汇量为 37k 的英语-到-德语翻译的设置。在评估过程中,对最后 5 个检查点取平均值来获得单个模型。结果是用波束大小为 4 且长度衰减因子为 0.6 的波束搜索。在 fairseq 工具包 (MIT 许可证) Ott [2019] 中的 PyTorch 实现实验。模型用 Adam 优化器进行优化,使用 β1 = 0.9、β2 = 0.98,学习率从 1e − 7 线性增加到 5e − 4,然后与步数的平方根倒数成比例衰减。还采用了 0.1 的标签平滑。将 BLEUPapineni [2002] 在测试集上的得分报告为最终指标。

如表是RoPE和基线模型的BLEU(”Bleu: a method for automatic evaluation of machine translation“,2002)机器翻译得分比较:

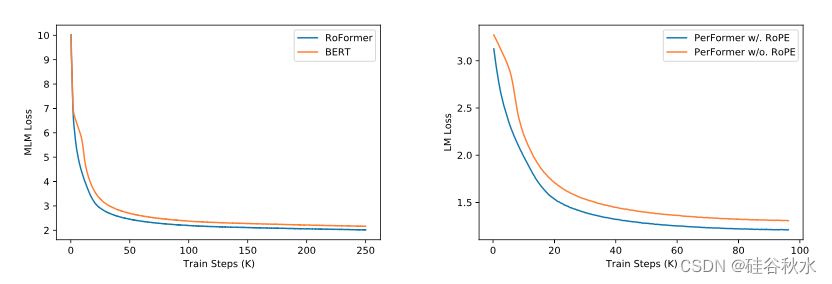

如图是RoPE 在语言建模预训练中的评估。左:BERT(”Bert: Pre-training of deep bidirectional transformers for language understanding“,2019) 和 RoFormer 的训练损失。右:有和没有 RoPE 的 PerFormer(“Rethinking attention with performers”,2020)训练损失。

205

205

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?