【AI实战】基于 bert-base-chinese 预训练模型的多标签文本分类模型,BCEWithLogLoss解决样本不均衡问题

多标签文本多分类

-

文本分类

文本分类用电脑对文本集(或其他实体或物件)按照一定的分类体系或标准进行自动分类标记。 它根据一个已经被标注的训练文档集合, 找到文档特征和文档类别之间的关系模型, 然后利用这种学习得到的关系模型对 新的文档进行类别判断 。 -

其应用场景众多,包括:

情感分析(Sentiment Analyse)

主题分类(Topic Labeling)

问答任务(Question Answering)

意图识别(Dialog Act Classification)

自然语言推理(Natural Language Inference) -

多标签分类

多标签分类是样本可以同时属于多个类别(或者标签)、类别间可以相互重叠的模式识别问题,其特殊性主要体现在样本到标签的一对多映射关系和标签间的相关性。如文本可能同时涉及任何宗教,政治,金融或教育,也可能不属于任何一种。

bert-base-chinese 预训练模型

bert-base-chinese

This model has been pre-trained for Chinese, training and random input masking has been applied independently to word pieces (as in the original BERT paper).

- Developed by: HuggingFace team

- Model Type: Fill-Mask

- Language(s): Chinese

- License: [More Information needed]

- Parent Model: See the BERT base uncased model for more information about the BERT base model.

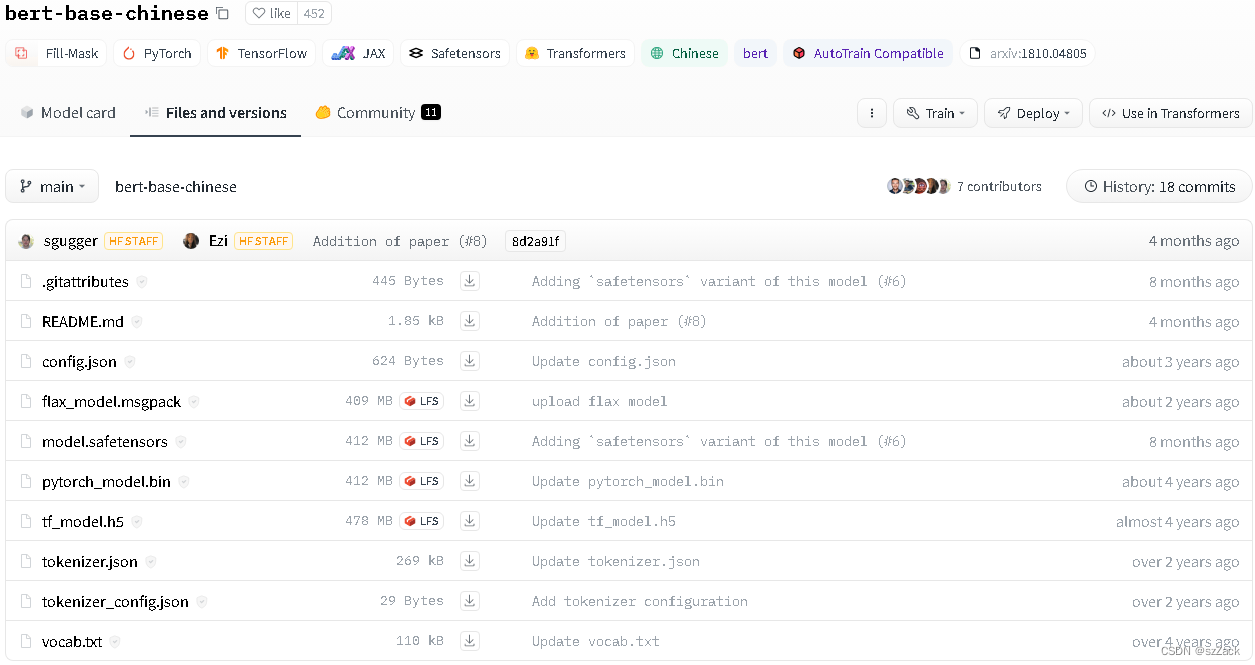

模型地址

https://huggingface.co/bert-base-chinese

模型拉取

git clone https://huggingface.co/bert-base-chinese

样本不均衡问题

解决样本不均衡问题方法

- 1.数据过采样、欠采样

对样本数量特别少的类别进行过采样;

对样本数量特别多的类别进行欠采样;

对样本数量较少的类别借助其他文本生成模型进行数据生成; - 2.修改loss函数

使用 focus loss 代替 交叉熵损失函数 Cross entropy loss

使用 GHM 代替 交叉熵损失函数 Cross entropy loss

多标签分类时,使用 BCE Loss 代替 交叉熵损失函数 Cross entropy loss; - 3.数据过采样 + loss修改

结合方法1 和方法2

BCEWithLogLoss解决样本不均衡问题

1.对样本数量特别少的类别进行过采样

比如我对样本数量少的

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

999

999

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?