目录

3 Knowledge Graph Embedding Extrapolation

3.1 Extrapolate with Semantic Evidences

4.1 Modeling SEs with Neighbor Pattern

这篇文章很巧妙,相比于其它KGE文章:(1)本文探讨为什么模型可以外推到没有见过的三元组;(2)假设是外推能力是因为学习到三个层次的语义证据,这些语义证据是只依赖于数据的,和模型无关。作者对多个KGE模型进行实验,发现对于语义证据强的数据,所有模型的效果都好,证明了假设。(3)因此作者发现其它KGE模型外推是因为也隐式学到了语义证据,作者显式明确地建模语义证据,实验发现效果好。

1 背景

KGE模型在外推场景上面取得了巨大的成功,给定一个数据集里没有出现过的三元组(h,r,t)一个经过训练的模型可以从(h,r,?)正确预测t,具有外推能力。但是,现在大多数KGE工作都集中在设计精细的triple建模函数,着重于衡量预测的triple的合理性,但对为什么这些方法可以外推到未发现的数据以及帮助KGE外推的重要因素提供了有限的解释。

2 贡献

作者研究KGE两个外推问题:(1)KGE如何推断出看不见的数据?(2)设计具有更好外推能力的模型。

贡献总结:

(1)第一个从数据相关和模型无关的角度探讨KGE外推问题的人,并进一步引入了三个层次的语义证据来理解KGE的外推能力。对各种典型KGE模型进行广泛实验验证假设;

(2)提出了一种新的基于GNN的KGE方法,称为SE-GNN,将语义证据明确而充分地建模到知识嵌入中,它有助于学习的知识表示实现更高的外推性能;

(3)通过在知识图完成任务的FB15k-237和WN18RR数据集上的大量实验,证明了引入的语义证据概念和SE-GNN方法的有效性。

3 Knowledge Graph Embedding Extrapolation

3.1 Extrapolate with Semantic Evidences

对于一个好的外推匹配查询(h,r)→ t,query(h,r)和t在训练过程中一定获得了一些语义相关性。相关性可能来自三个层次:具有t的个体r部分(关系层次)、具有t的单个h部分(实体层次)和具有t的组合查询(h,r)部分(triple层次)。

-

Relation level relatedness between r and t:如果训练集中r和t频繁共现,即有很多事实三元组满足query(hi,t)→t,那么r包含一些用于预测t的信息。这可以被视为实体类型的信息,例如对于查询(hi,出生于),无论具体的hi是什么,预测地点F lorida的概率都应该高于预测电影Iron Man的概率。

-

Entity level relatedness between h and t: 训练集中,如果从h到t有观察到的query或间接query,它们的语义相关性相近,会为h和t间的其他查询提供证据。query(h,is_mother)→ e1和query(e1,is_father)→ t将为预测query带来confidence(h,is_grandmother)→ t。在图形视图下,这可以被视为从h到t的路径。

-

Triple level relatedness between query(h, r) and t:对于query(h,r),它可能在训练集中存在其他ground truth实体t’。如果模型已经针对query(h,r)进行了训练→ t’,同时t和t’有很大的相似性,模型自然会外推到查询(h,r)→ t。

上述相关性都来自训练集,因此对于KGE模型,尽管它没有对未见过的query(h,r)→ t进行训练,但它已经从观测到的三元组中获得了足够的信息来进行预测。将这种相关性命名为语义证据(SE),以表明它们为推断提供的支持语义信息。

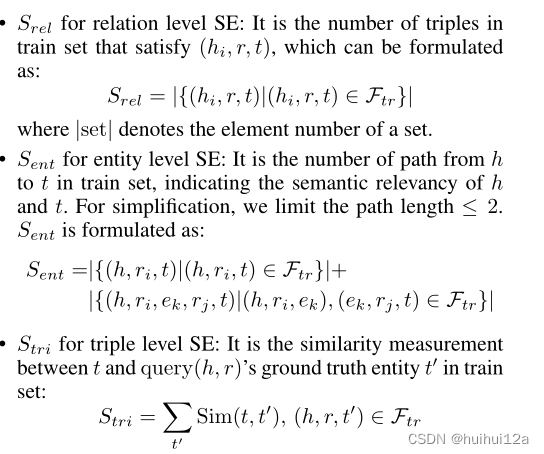

作者在多种KGE模型上进行实验,将数据根据SE划分为不同的层次,三种层次的S值定义如下:

对于所有模型,随着证据强度的增加,都存在一致的更好的预测结果,证明了提出SE假设的正确性。

4 SE-GNN模型

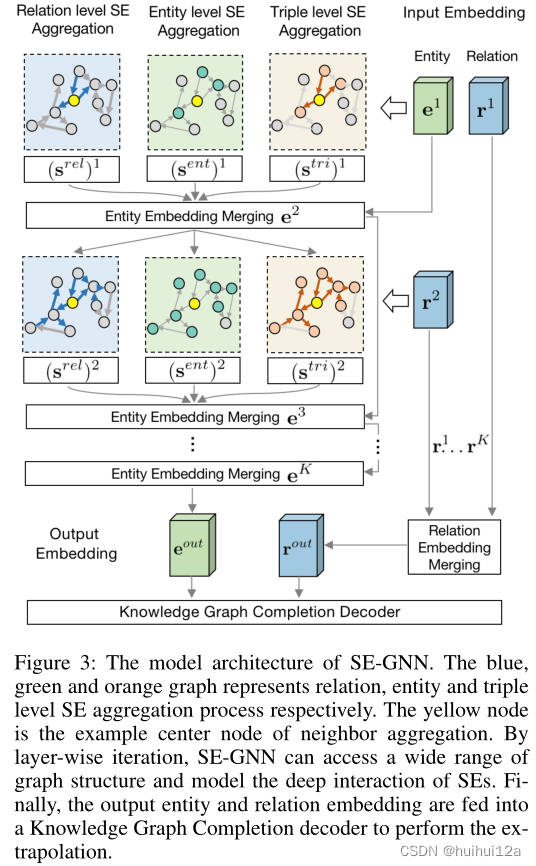

以前KGE模型对SE没有充分认知,是一种隐含的和不充分的方式来获取SE信息。为了更好地利用语义证据信息进行更多的外推知识表示,作者提出了SE-GNN,该模型旨在对三个级别的SE进行显式和充分的建模。

4.1 Modeling SEs with Neighbor Pattern

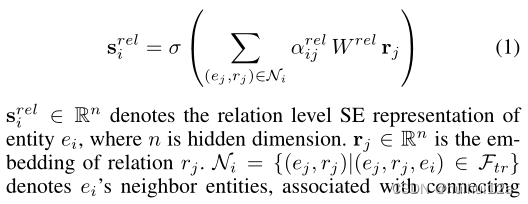

通过实体的邻居关系模式来捕捉。通过聚合所有连接的关系:

对于实体级SE,它描述了实体之间的路径连接信息,并且可以从邻居实体模式中捕获。通过一次聚合相邻实体,可以捕获所有长度为1的路径,并且可以通过迭代多层聚合访问更长的路径,只介绍长度为1的:

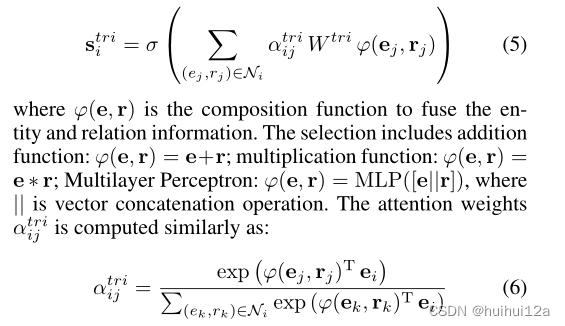

对于triple SE,它从邻居结构的角度描述了triple相似性特征,其中应该考虑邻居实体和关系。将聚合函数设计为:

4.2 Model Architecture

通过引入了邻居聚合方法来对每个SE进行建模,并获得,

,

的相应表示。这三个嵌入为模型的外推提供了重要的证据。将它们与原始知识嵌入合并为:

![]()

这只是一层的合并,为了获取多跳邻居信息并对SE组件的深层交互进行建模,引入了一个用于SE聚合的多层版本,作为下一层的输入,并迭代聚合为:

l层的SE都和4.1节中计算的一样,不过是计算时把关系嵌入节点嵌入换成了l层。

将作为输出实体嵌入。对于关系嵌入,为每一层初始化不同的rl,考虑到关系在不同层中可能扮演不同的角色。对于输出关系嵌入,将所有使用的rl连接起来,并通过一个转换矩阵得到最终的结果:

最后,利用输出嵌入执行(h,r,?),使用ConvE作为解码器,使用2D卷积神经网络来匹配query(h,r)和答案t。

最后使用二进制交叉熵衡量query q和t之间的匹配。

699

699

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?