堂堂开源之王Llama 3,原版上下文窗口居然只有……8k,让到嘴边的一句“真香”又咽回去了。

在32k起步,100k寻常的今天,这是故意要给开源社区留做贡献的空间吗?

开源社区当然不会放过这个机会:

现在只需58行代码,任何Llama 3 70b的微调版本都能自动扩展到1048k(一百万)上下文。

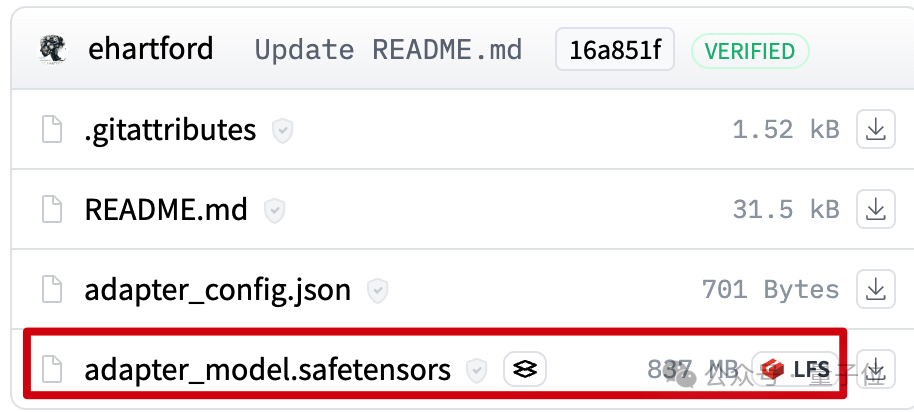

背后是一个LoRA,从扩展好上下文的Llama 3 70B Instruct微调版本中提取出来,文件只有800mb。

接下来使用Mergekit,就可以与其他同架构模型一起运行或直接合并到模型中。

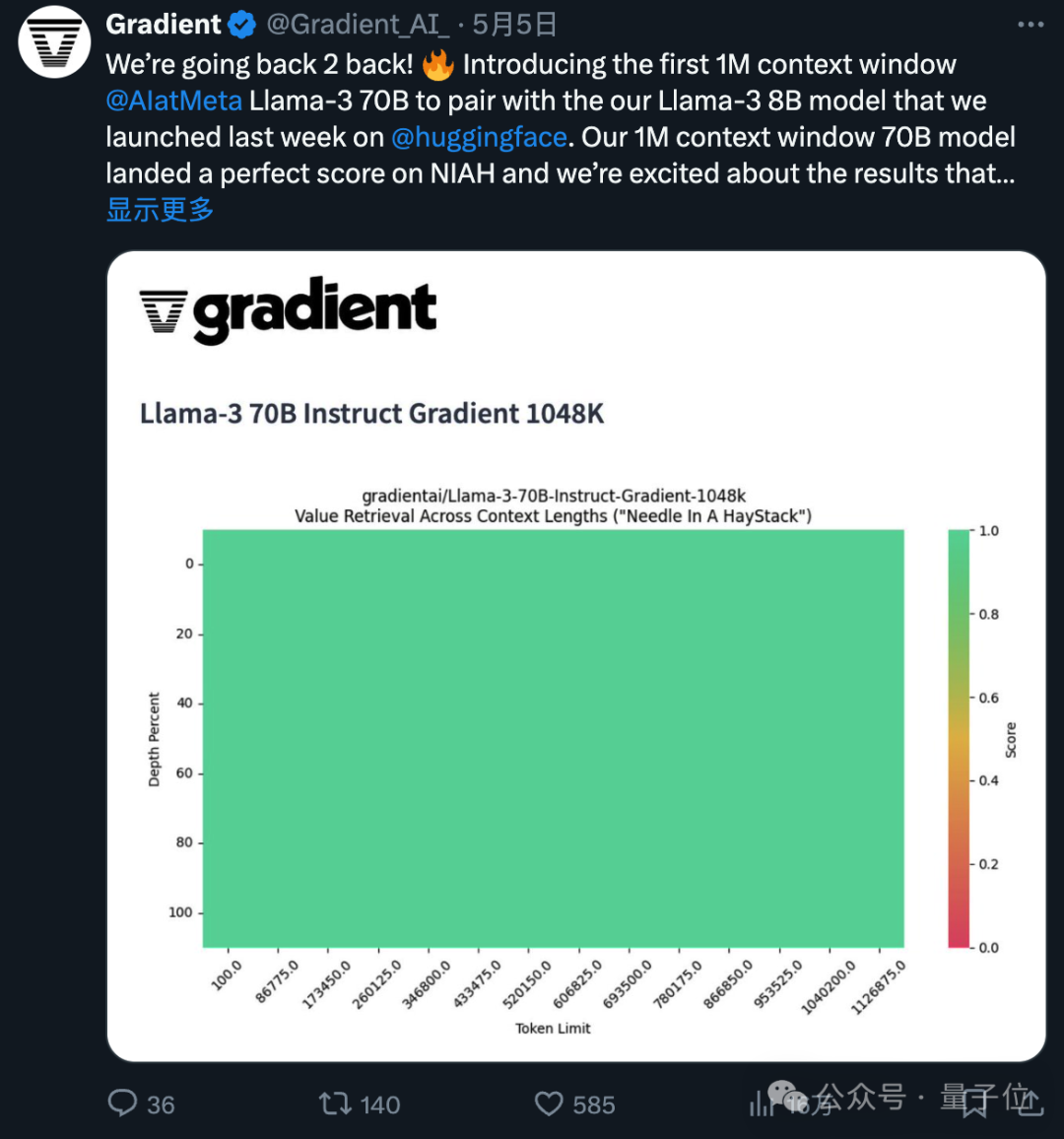

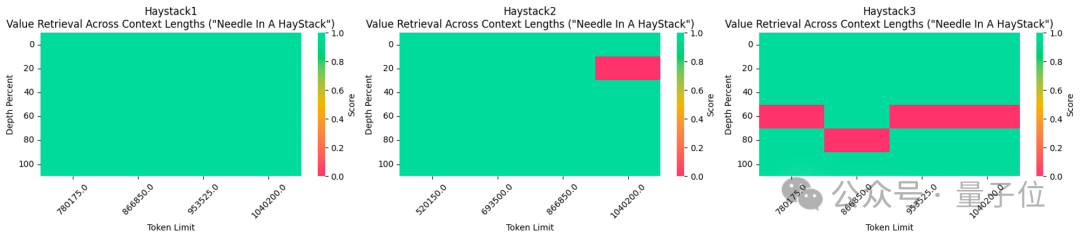

所使用的1048k上下文微调版本,刚刚在流行的大海捞针测试中达到全绿(100%准确率)的成绩。

不得不说,开源的进步速度是指数级的。

1048k上下文LoRA怎么炼成的

首先1048k上下文版Llama 3微调模型来自Gradient AI,一个企业AI解决方案初创公司。

而对应的LoRA来自开发者Eric Hartford,通过比较微调模型与原版的差异,提取出参数的变化。

他先制作了524k上下文版,随后又更新了1048k版本。

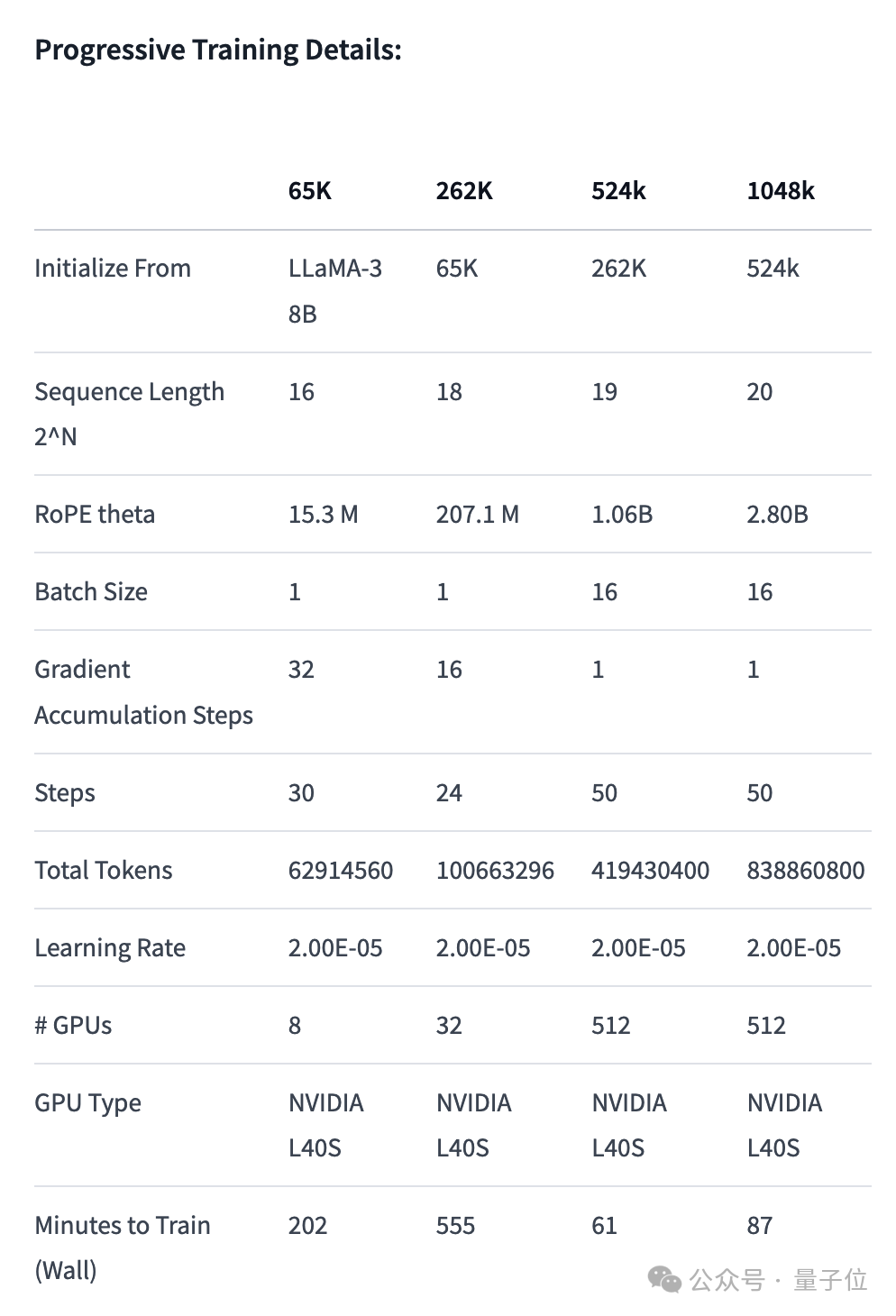

首先,Gradient团队先在原版Llama 3 70B Instruct的基础上继续训练,得到Llama-3-70B-Instruct-Gradient-1048k。

具体方法如下:

- **调整位置编码:**用NTK-aware插值初始化RoPE theta的最佳调度,进行优化,防止扩展长度后丢失高频信息

- **渐进式训练:**使用UC伯克利Pieter Abbeel团队提出的Blockwise RingAttention方法扩展模型的上下文长度

值得注意的是,团队通过自定义网络拓扑在Ring Attention之上分层并行化,更好地利用大型GPU集群来应对设备之间传递许多KV blocks带来的网络瓶颈。

最终使模型的训练速度提高了33倍。

长文本检索性能评估中,只在最难的版本中,当“针”藏在文本中间部分时容易出错。

有了扩展好上下文的微调模型之后,使用开源工具Mergekit比较微调模型和基础模型,提取参数的差异成为LoRA。

同样使用Mergekit,就可以把提取好的LoRA合并到其他同架构模型中了。

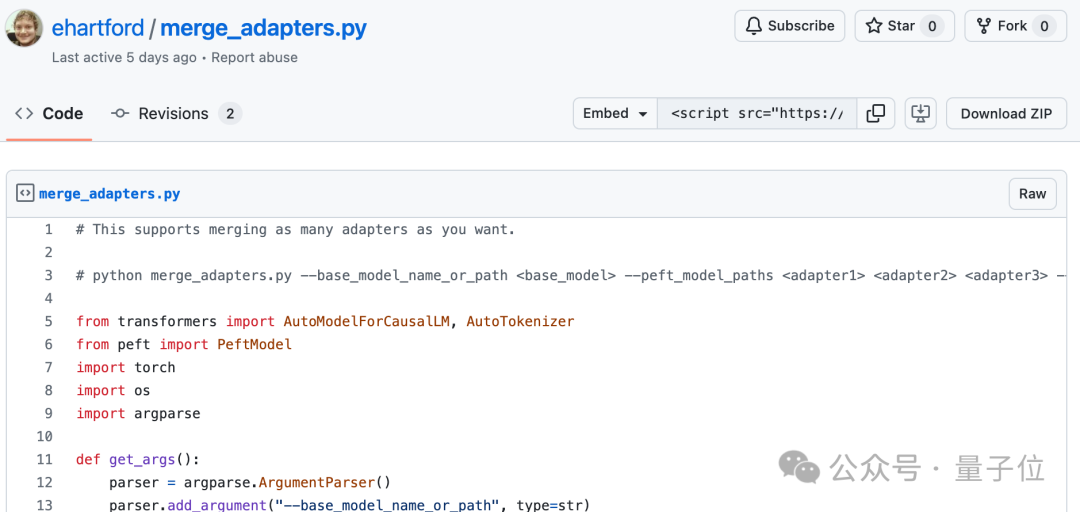

合并代码也由Eric Hartford开源在GitHub上,只有58行。

目前尚不清楚这种LoRA合并是否适用于在中文上微调的Llama 3。

不过可以看到,中文开发者社区已经关注到了这一进展。

524k版本LoRA:

https://huggingface.co/cognitivecomputations/Llama-3-70B-Gradient-524k-adapter

1048k版本LoRA:

https://huggingface.co/cognitivecomputations/Llama-3-70B-Gradient-1048k-adapter

合并代码:

https://gist.github.com/ehartford/731e3f7079db234fa1b79a01e09859ac

参考链接:

[1]https://twitter.com/erhartford/status/1786887884211138784

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

150

150

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?