Federated Graph Semantic and Structural Learning

收录于:2023 IJCAI

级别:CCF-A

开源:否

这篇论文首先认为本地客户端的失真(distortion)是由节点级语义和图级别结构共同带来的

对于节点级语义,对比不同类别的节点有利于提供良好的区分能力,我们把本地节点推向相同类的全局节点,而推离不同类的全局节点

此外,文章假设一个图神经网络是结构良好的话,那么他们的邻接关系应该拥有对邻居的相似性属性

由于潜在的类别不一致,将节点与他们的邻居节点对齐会妨碍分类。作者把邻接关系转换成相似度分布,并利用全局模型来蒸馏关系知识到本地的模型中,这将保护结构信息和本地模型的区分能力。

引言

显存的方法主要为典型的数据异质所设计,没有对图结构的偏差(bias)进行考虑。有工作已经表明了利用结构知识的重要性。

在这篇文章中,作者首先研究了图异质的独特特性,发现在FGL环境下存在节点语义和图结构的偏差。

进一步,给定不同客户端的模型对,作者利用CKA测量节点表征的相似度。对于结构异质性,作者利用AWE生成图的表征,并且利用JS距离测量两个图的差异。

通过以上方法测量节点表征的相似度和图表征的相似度,作者发现严重的差异同时存在于节点级别的语义和图级别的语义。故对于FGL来说一个重要的问题就是:如何校准(calibrate)节点级语义和图级结构偏差。

对于节点级别的语义校准,作者认为具有良好区分能力的图神经网络可以对比不同类别的节点,以提供清晰的决策边界(clear decisional boundary)

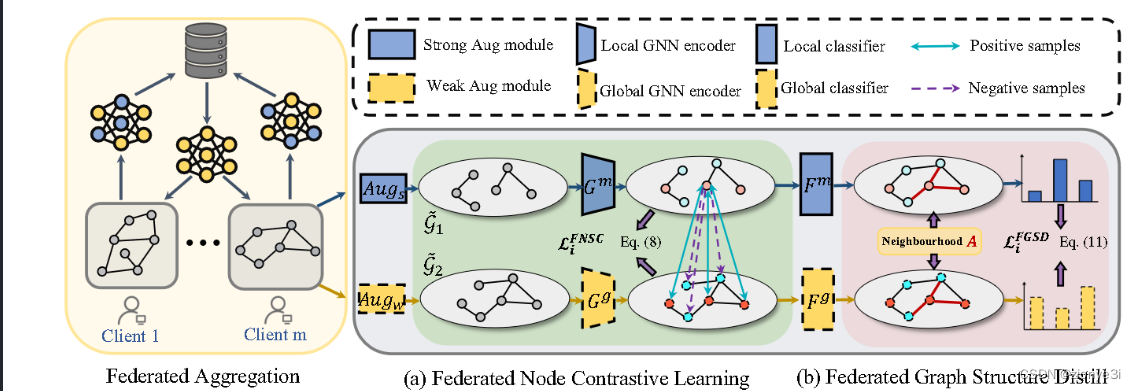

受监督对比学习启发,我们自然想在本地模型的不同类之间的进行拉-推(pull-push)操作,研究节点语义知识并在本地训练过程中对齐进行校准。提出了联邦节点语义对比(Federated Node Semantic Contrast, FNSC),使得本地节点表征跟相同类的全局节点表征接近,并远离不同类的全局节点表征。

对于图结构级别的语义校准,本地客户端通常拥有不完整的图并且偏向于描述图结构

文章在局部训练期间通过给定的全局模型将刚性图结构重建转换为结构关系维护。引入联邦图结构蒸馏(Federated Graph Structure Distillation, FGSD),就是基于这个邻接矩阵,利用全局模型计算每个节点与他们邻居的相似度。然后本地模型模仿全局模型,计算邻接节点的相似度,这利用全局模型来提供有用的结构信息。

提出的联邦图语义和结构学习方法(Federated Graph Semantic and Structural Learning method, FGSSL),贡献有三:

- 首次在FGL中把数据异质性解耦成节点语义级和图结构级的偏差,并通过校准局部训练偏离(drift)来改善性能。

- 提出了FGSSL,FNSC和FGSD

- 模型表现优越

Methodology

动机

在异构联邦学习中,客户端模型向不同的方向优化,影响了全局GNN模型的性能。如图这不同体现在节点级语义和图级结构两方面(?)。

客户端间的语义和结构相似度,越深的颜色代表越高的相似度(这热力图画得真辣眼睛)

提出的方法

联邦节点语义对比(Federated Node Semantic Contrast, FNSC)

受监督对比学习启发,自然地想将不同的节点类别进行对比。对于本地模型,将节点特征向量向正样本推进,向负样本推离,对于客户端 m m m的节点 v i v_i vi:

P i P_i

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?