Triformer: Triangular, Variable-Specific Attentions for Long Sequence Multivariate Time Series Fo...

现实世界的各种应用都依赖于遥远未来的信息来进行决策,因此需要高效、准确的长序列多元时间序列预测。虽然最近的基于注意力的预测模型显示出在捕获长期相关性方面的强大能力,但它们仍然受到两个关键限制。首先,规范自我注意的复杂度为输入时间序列长度的二次多项式,效率不高;第二,不同变量的时间序列往往具有不同的时间动态,这是现有研究未能捕捉到的,因为他们使用相同的。

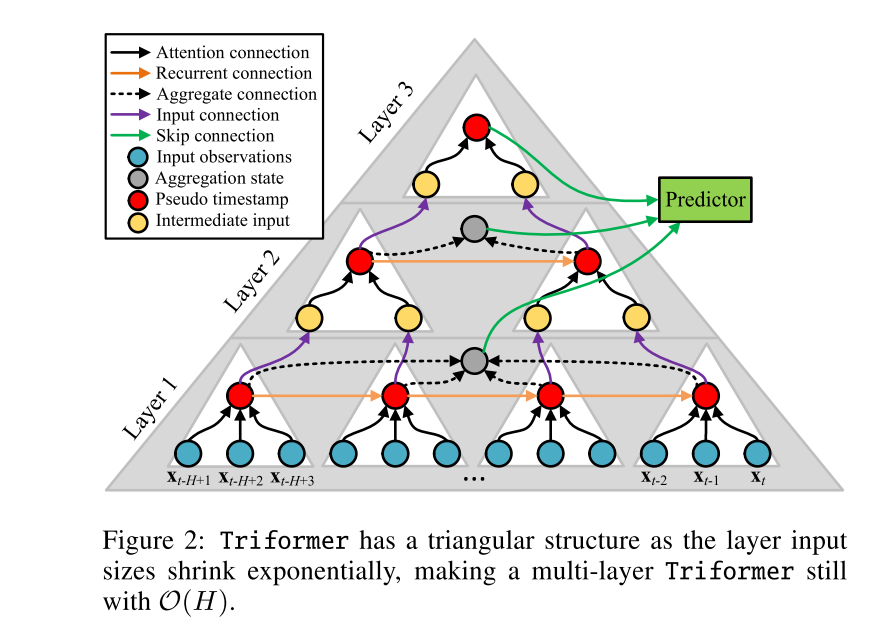

为了确保高效率和准确性,我们提出了Triformer,一个三角形的,可变的具体注意。(i)线性复杂度:我们引入了一种新的具有线性复杂度的patch attention。在将patch attention多层叠加时,提出了一种三角形结构,使层大小呈指数收缩,从而保持线性复杂度。(ii)特定于变量的参数:我们提出了一种轻量级方法,使不同变量时间序列的不同模型参数集能够提高准确性,而不影响效率和内存使用。来自多个领域的四个数据集的强有力的经验证据证明我们的设计选择是正确的,它表明,Triformer优于最先进的方法在准确性和效率。

背景:

1)High complexity 我们提出了线性复杂度为O(H)的Triformer

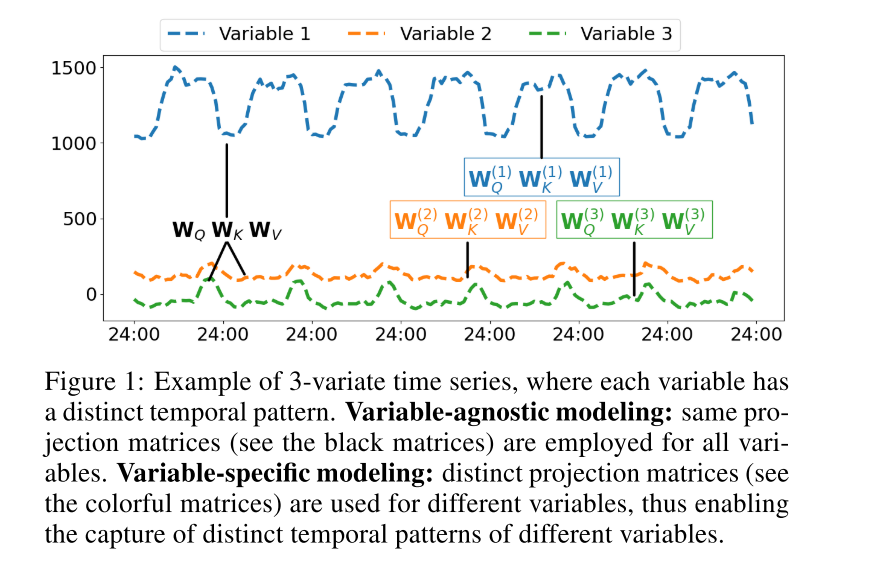

2)Variable-agnostic parameters 现有的预测模型通常使用不确定变量的参数,尽管不同的变量可能表现出不同的时间模式

问题定义:

时间序列预测学习一个函数F,它将作为历史H时间戳中的观测值,并预测未来F时间戳

Triformer

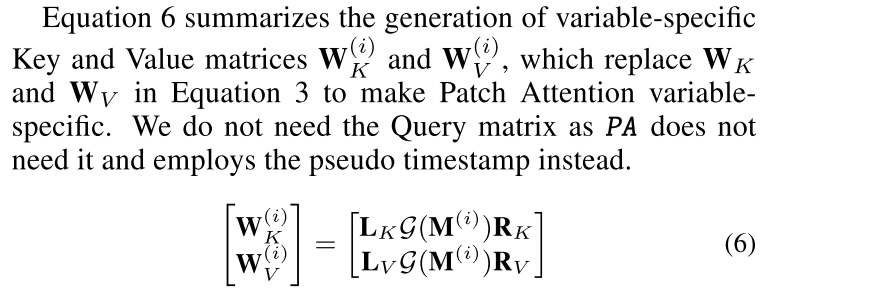

我们提出Triformer用于学习多元时间序列中的长期和多尺度依赖关系。Triformer的设计选择有三个方面。首先,我们提出了一种高效的Patch Attention,它具有线性复杂度。其次,我们提出了一个三角形结构,当叠加多层斑块注意时,使层大小以指数方式收缩。这保证了多层patch关注点的线性复杂性,也使提取多尺度特征成为可能。第三,我们提出了一种轻量级的方法来实现特定变量的建模,从而能够从不同的变量捕获不同的时间模式,而不影响效率

1)Linear Patch Attention

我们提出了一种线性复杂度的高效Patch Attention算法,以保证竞争的整体效率。我们将长度为H的输入时间序列在时间维度上分解为P = H/S的patch,其中S为patch的大小

将复杂性降低到线性,对于每个patch p,我们引入了一个可学习的伪时间戳. pseudo时间戳充当数据占位符,patch中的所有时间戳都可以写入有用的信息,然后将这些信息传递给下一层。在Triformer中,我们选择使用注意机制来更新伪时间戳,其中伪时间戳作为自我注意中的查询工作。伪时间戳查询补丁中所有的真实时间戳,因此对每个真实时间戳只计算一个关注分数,线性复杂度高

Triangular Stacking

在使用PAs时,我们只将patch中的伪时间戳提供给下一层,这将以指数方式缩小层大小。

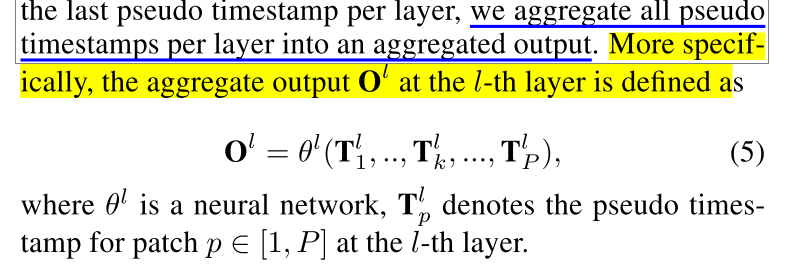

我们将每一层的所有伪时间戳聚合成一个聚合的输出。

最后,所有层的聚合输出连接到预测器。这比仅仅使用最后一层的总输出有两个好处。首先,聚合的输出代表不同时间尺度的特征,形成不同的时间视图。其次,它提供了多个梯度反馈短路径,从而简化了学习过程。

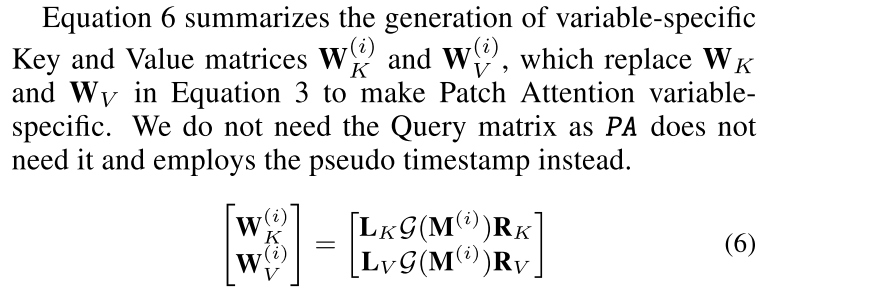

Variable-Specific Modeling

针对变量的建模可以通过简单的方式,对每个变量引入不同的投影矩阵来实现,这导致参数空间非常大。这可能会导致过拟合,导致内存占用过高,并且不能很好地扩展变量的数量N。

Experiments

Baselines: We select six recent and strong baselines from different categories shown in Table 1, including StemGNN [Cao et al., 2020], AGCRN [Bai et al., 2020], Informer [Zhou et al., 2021], Reformer [Kitaev et al., 2020], LogTrans [Li et al., 2019], and Autoformer [Wu et al., 2021].

Experiments for Longer Sequences

Ablation Study

Hyper-Parameter-Sensitivity Analysis

1)效率:

Conclusion and Outlook

我们提出了Triformer,一种采用新颖的patch attention的三角形结构,确保了线性复杂性。此外,我们提出了一种轻量级的方法来生成特定于变量的投影矩阵,该投影矩阵是量身定制的,以捕捉每个变量的时间序列的不同时间模式。在四个数据集上的大量实验表明,我们的建议优于其他先进的长序列多元时间序列预测方法。在未来的工作中,我们有兴趣探索支持动态输入长度的不同方式,并利用课程学习加强模型培训[Yang等人,2021;Yang等,2022]。

801

801

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?