1.减少预测的准确率:得到更多的训练样本;使用小一点的特征;得到一些额外的特征;增加多项式特征的方法;

2.将数据分为测试集和训练集(比例一般是7:3)

3.机器学习算法问题:高偏差—拟合的多项式的次数太小,训练误差和验证误差都会非常大;高方差—拟合的多项式的次数太大,训练误差会很小,但是验证误差会很大

4.调试一个学习算法:使用更多的训练样例(解决高方差的问题);使用更小的特征集合(解决高方差的问题);添加额外的特征(解决高偏差的问题);添加额外的多项式特征(解决高偏差的问题);增大

λ

(解决高方差的问题);减小

λ

(解决高偏差的问题)

5.较小规模的神经网络:更少的参数、更小的计算量、更容易欠拟合

6.较大规模的神经网络:更多的参数、更大的计算量、更容易过拟合

7.偏斜类:正例和负例的比例值是一个非常极端的情况

8.查准率 =

真阳性预测为阳性的总数

或

TPTP+FP

召回率=

真阳性真实情况为阳性的总数

或

TPTP+FN

9.F1(评价值)=

2∗PRP+R

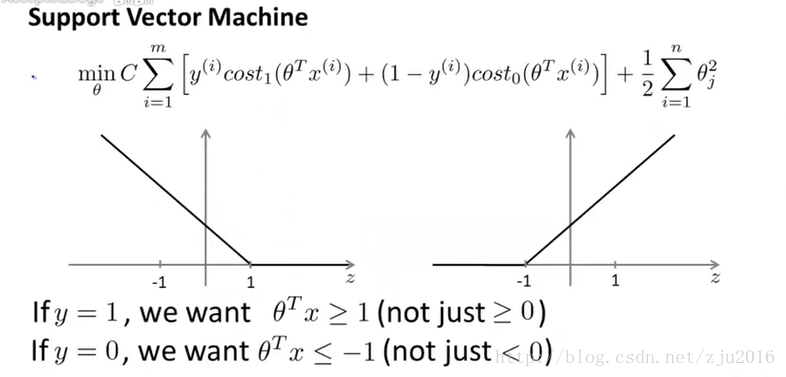

10.支持向量机模型:

11.K-means算法

12.数据降维

13.主成分分析(PCA):不是线性回归,虽然二者有一定的相似性以及关联性,不要使用PCA来避免 过拟合,这样效果不好

14.异常监测算法:正例的数量一般比较少,负例的数量一般比较多,存在很多不同种类的异常,对任何算法而言,都很难从正例中学习到异常的特征,仅仅从当前已知的异常很难直接推断出未来可能出现的异常

15.监督学习算法:正例和负例的数量都足够多;对于算法而言,这些足够的正例可以让算法学习到它们的特征,未来的正例和当前训练集中的正例存在着很大的相似性。

16.异常监测算法的应用:欺诈监测、生产问题(飞机引擎)、监视数据中心的机器……

17.监督学习算法的应用:垃圾邮件的分类、天气预报……

18.原始的模型(连乘的形式):创立一些特性来捕捉异常、计算代价更小、训练集的规模可以比较小

19.多元高斯模型:可以自动地捕捉到特征和特征之间的联系、计算代价太大、要避免公式中的

Σ

不可逆的情况

20.均值归一化:算出均值、减去均值

21.随机梯度下降算法:在某个最靠近最小值的全局区域内徘徊

22.批量梯度下降算法:在每一次的迭代过程当中都使用所有的样例;随机梯度下降算法:在每一次的迭代过程当中使用1个样例;小型批量梯度下降算法:在每一次的迭代过程当中使用b个样例

机器学习笔记2(吴恩达)

最新推荐文章于 2024-03-23 13:15:03 发布

258

258

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?