T-MGCN时间多图卷积网络用于交通流预测

1.文章信息

《Temporal Multi-Graph Convolutional Network for Traffic Flow Prediction》

这是发表在IEEE Transaction on Intelligent Transpotation System上的一篇文章。

2.摘要

由于复杂的空间和时间相关性,交通流预测一直是一项具有挑战性的任务。现有的工作试图通过开发各种时空模型来解决这一问题。然而,我们观察到遥远道路之间的语义关联性对于交通流预测也是至关重要的。为了将路网中的空间、时间、语义关联与各种全局特征联合建模,本文提出了T-MGCN (Temporal Multi-Graph Convolutional network)交通流预测深度学习框架。首先,识别了几种不同类型的语义关联,并将道路间的非欧氏空间关联和异构语义关联编码到多个图中,通过多图卷积网络对关联性进行建模。然后利用循环神经网络学习交通流的动态模式,以捕获时间相关性。最后利用全连接神经网络融合时空相关性和全局特征。

3.动机

预测交通流的难点主要体现在:(1)空间相关性。城市交通流受路网拓扑结构的影响(一条道路的交通流会对其邻近道路的交通流产生很大的影响),并且空间关联具有方向性,例如下游流量比上游流量对未来的交通状况影响更大。(2) 时间相关性。交通状况随时间动态变化,时间相关性表现为亲近性和周期性:亲近性是指最近时段的交通状况比旧时段的交通状况更相关;周期性是指交通状况在一定的时间间隔内呈现出周期性的变化模式。(3) 语义相关性。由于一些潜在的语义关联,遥远的道路之间也可能存在一定的相关性。例如,具有相似功能的城市道路(如住宅区和商业区)通常具有相似的交通模式。

近年来,许多研究应用CNN(卷积神经网络)对空间进行建模。然而,CNN最初是为欧几里得空间结构设计的(如二维图像和规则网格),所以它不能完全适应路网复杂的拓扑结构。针对这一问题,人们开始研究用于路网空间建模的图卷积网络(Graph Convolutional Network, GCN)。然而,这些方法在构建图时只考虑了道路之间的拓扑关系,而忽略了所有其他可以衡量道路之间相关性的语义因素(如交通行为和局部功能)。因此本文提出了一个深度学习框架:T-MGCN,它将空间、时间和语义关联与各种全局特征结合在一起,用于路网中的交通流预测。主要贡献如下:

(1)识别了道路之间的两种语义相关性(历史交通模式相关性和局部区域功能相似性),并使用多个图对空间和语义关联性进行编码。然后提出了一个多图卷积网络来建模和融合这些图。

(2)识别了各种全局特征(即时间特征、周期性特征和事件特征),并设计了一个深度神经网络来联合建模空间、语义、时间相关性和全局特征。具体来说,我们堆叠了基于多图卷积网络的卷积层、基于GRU (Gated recurrent Unit)的循环层和基于全连接神经网络的输出层。

(3)在两个真实的交通数据集上进行了的实验。结果表明,与最佳基准模型相比,T-MGCN降低了约3% - 6%的预测误差。

4.方法

4.1 问题定义

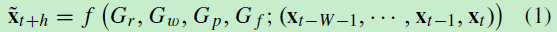

将路网表示为一个加权图G = (V,E,W),其中每个节点v表示一条道路,边e表示节点间的相关性,边缘权值表示相关性强度,权重越大,两条路的相关性越高。本文从道路网络拓扑结构(Gr、Gw)、交通模式相关性(Gp)、局部区域功能相似性(Gf)三个方面构建图。将t时刻路网上的交通信息 (如速度、流量等)表示为一个N维向量,其中N为道路数量。交通流预测问题定义为:在Gr、Gw、Gp、Gf的基础上,学习大量的历史交通信息样本来获得反映未来交通信息的函数f:

图1为TMGCN的结构:

4.2 输入层

给定一个交通条件样本St,其输入部分可视为一个N*W的矩阵,其中N为道路数,W为历史交通条件信号数。我们使用窗口大小为w,步长为d的滑动窗口来处理输入,得到一个由K个片段组成的序列。使用这种处理策略的原因如下:首先,每个路段应包含多个交通条件信号,这是由于时间序列数据具有紧密性特征(即相邻时段内的数据具有较强的局部交互作用),这些相邻时段内的局部交互作用由卷积层分别对每个分段进行捕捉,如果w = 1,局部相互作用将被忽略。其次,将交通状况样本的输入部分划分为多个段,便于循环层捕捉时间动态。如果w = W,则时间动态被忽略。

4.3 卷积层

1)图的构建: 图的构建是GCNs的关键步骤。如果生成的图不能很好地编码节点之间的相关性,这将无助于模型学习,甚至可能降低预测性能。一般来说,我们会在不同方面对道路相关性较强的边缘赋予较大的权重。我们构建了四种道路图(即Gr、Gw、Gp、Gf),具体如下:

a)拓扑图Gr:路网的拓扑结构可以用有向图表示Gr =(V, E, Wr ), 边的权重 wr (i, j ) 是从路vi到路vj之间链路数量的倒数(图2),因此,在路网中越近的道路,其权重就越高。邻接矩阵Xr表示为:

b)加权拓扑图Gw:链接的长度也会影响相关性。因此,我们定义加权拓扑图Gw = (V, E, Ww),边的权重如式3所示,其中len计算路径的长度,邻接矩阵Xw表示为式4:

c)交通模式图Gp :

交通模式相似的道路在空间上不一定很近。利用每条道路的历史交通状况数据,通过直接度量每条道路对历史交通状况模式的相似性来挖掘道路间的相关性。具体来说,流量模式图表示为Gp = (V, E, Wp)。边的权重为两条道路历史模式的相似度,计算如下: 首先,给定一条路,我们使用历史平均每周交通状况作为它的交通模式,。其次,给定两条道路,我们使用DTW (Dynamic Time Warping)计算两条路的距离,记为dtw(i , j ),根据公式5将距离度量转换为相似度量。式中,用α来控制距离的衰减率,衰减率应根据所涉及的交通状况的范围来设定。邻接矩阵Xp表示为式6:

d)区域功能图

功能相似的城市区域中的道路通常有相似的交通模式,例如,工业区可能在工作日的高峰时间有拥堵的交通流,市中心地区可能在周末有拥堵的交通流。已有研究证明POI (Point Of Interest) 分布可以衡量城市区域的功能性。我们根据以下八类计算POIs的密度:住宅、工作(公司、办公大楼等)、商业(如商场、商店等)、餐馆、学校、交通(例如,火车站、地铁站等)、娱乐(如剧院、酒吧等)和风景(如公园、湖泊等)形成特征向量,pvi [ j ] 表示vi道路周边的j类POI密度,计算方法如式7所示。该方程参考自然语言处理领域的TF-IDF设计,对总体数量较少的POI类别赋予更高的权重。其次,我们使用余弦相似度来度量两条道路pvi和pvj之间的相似度,将其作为权重。则邻接矩阵可表示为式8。

2)多图卷积网络

我们利用[30]中的GCN进行卷积操作,捕捉节点之间的关联。每个道路图都被输入到一个单独的GCN。GCN的传播规律如式9所示:

接下来,我们基于参数矩阵融合方法合并四个特征矩阵(10和11),Wr, Ww, Wp,和Wf是可学习参数,来调节特征矩阵的权重。采用softmax运算对参数矩阵进行归一化处理:

4.4 循环层

循环层被用来捕获由特征矩阵序列表示的片段序列中的时间相关性,我们选择了两层堆叠的GRU结构,这是提高模型容量的有效途径。在GRU层之间应用dropout进行正则化。如图3,将上一步处理后的特征矩阵按时间顺序输入到循环层中,取最后一个隐藏状态的输出特征矩阵作为循环层的输出。

4.5 输出层

现在已经对路网拓扑结构的空间关联、道路间语义关联和时间关联的紧密性进行了编码,还有其他全局特征可以影响交通状况。因此,在输出最终的特征矩阵之前,我们还提取了以下全局特征:

1)时间特征:给定一个交通状况样本St,我们考虑一天中的时间,一周中的哪一天和节假日事件作为时间特征。我们提取未来时间t+h的时间特征,以此来预测交通状况。我们将St的路网时间特征矩阵表示为TZt。

2)周期特征:城市交通流具有很强的周期性,然而,由于W(即交通状况样本输入部分的长度)不能太长,因此循环层只能捕捉短期的周期性。这是因为一个太长的RNN难以训练,而且太长的序列的梯度消失性也会削弱周期性的作用。因此,给定一个交通状况样本St,我们将最后一天同一时间和最后一周同一时间的交通状况作为长期周期性特征。此外,我们考虑一个时间窗口的交通条件信号,而不是使用单一的信号。原因是交通状况通常不是严格的周期(虽然几乎所有工作日都有早高峰时间,但交通高峰可能在每天早上的不同时段出现)。我们将St的路网周期性特征矩阵表示为PZt。

3)事件特征:在某些情况下,一个事件(例如交通事故和节日聚会)会导致目标区域周围的交通情况在几个小时内发生急剧变化。然而,这种情况的存在是非常罕见的,仅考虑交通状况数据几乎不可能捕捉规律性。为了解决这一问题,我们利用一些事件发布网站(如基于位置的社交网络和公共设施的官方网站)共享的带有位置和时间属性的文本信息,基于深度神经网络识别事件,并捕捉其对未来交通模式的影响。具体来说,给定一个交通状况样本St,我们将每条道路vi附近在输入Int期间发布的文本片段进行聚合,形成文件D(t, i),然后利用TextCNN,通过预先训练的词嵌入层、卷积层、最大超时池化层和全连通层,从D(t, i)中提取特征向量。然后将提取的所有特征向量进行组合,形成St的路网事件特征矩阵,记为EZt。

第二,融合RZt, TZt, PZt和EZt为一个长特征矩阵:

然后叠加两层完全连接层,第一层可以被视为一个嵌入层,第二层是用来确保输出矩阵Z具有相同的形式,请注意,全局特性是可选的,我们可以根据数据可用性选择其中任何一个来形成最终的Zt。最后,我们用sigmoid作为激活函数,输出t+h时刻的预测路况信号,记为xt+h。训练模型到预测交通状况信号和真实的交通状况信号之间的RMSE(均方根误差) 最小化。

5.实验

我们基于两个真实的交通数据集:HZJTD和PEMSD10来评估我们的模型。

HZJTD是由杭州综合交通研究中心收集的。该数据通过loop检测器从杭州市主要城区的202条道路上采集,时间为2013年10月16日至2014年10月3日。HZJTD包含交通状况,交通速度和交通拥堵指数。将交通速度作为要预测的交通状况,我们每15分钟计算一次道路上的交通速度。最后,HZJTD包含每条道路的30353条记录。构建杭州市路网拓扑结构(如图4(a)所示),图中的双向道路被视为两条不同的道路。基于百度地图API采集杭州市POIs数据。

PEMSD10是由加州运输部收集的。在加州所有主要大城市的高速公路系统中,总共部署了39000个传感器。我们随机选取加州10区608个传感器作为数据源(如图4(b)所示),时间为2018年1月1日至2018年3月31日。以15分钟为间隔收集数据集,并以交通速度作为预测的交通状况。最后,每个传感器包含8640条记录。基于谷歌Map API收集加州的POIs。有两件事需要注意。首先,传感器和道路不是一对一对应的(例如,可能会有多个传感器部署在同一段路),所以我们通过使用一个阈值高斯内核建立加权拓扑图,eg.通过式12计算传感器之间的权重,dist(vi , v j )表示传感器vi 、 v j 之间的距离, σ是距离的标准差, κ是距离阈值。其次,PEMSD10还从“交通事故信息”页收集事故报告,包含事故的日期、时间、地点和文字描述等信息。

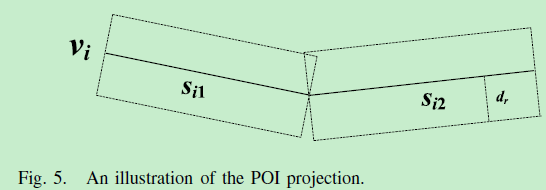

POI的收集:首先,百度Map API和谷歌Map API都不允许一次性查询区域内所有的POIs,它们只接受关键字和中心位置作为输入,并返回在中心位置周围满足关键字的预定义数量的POIs。因此,我们基于移动和扫描策略收集POIs,即通过提供不同的POIs类别作为关键字,在中心位置周围多次查询POIs,然后将中心位置移动到下一个附近位置,并重复查询步骤。其次,将POIs投影到道路上,如图5所示:

预处理: 首先,利用线性插值法对交通速度数据的缺失值进行填充。其次,在输入模型之前,我们使用Min-Max归一化方法将交通速度值缩放到[0,1]范围内。在评估中,我们将预测的交通速度值重新缩放到正常,以与地面真值进行比较。第三,由于时间特征都是类别变量,我们使用one-hot编码为它们形成二元特征向量。

参数设置: 参数默认值设置如下。HZJTD道路数N = 202条,PEMSD10道路数N = 608条。我们设一个交通状况样本的输入部分长度为W = 96(i.e.24小时),DTW距离的衰减率α = 0.1,形成POIs的正交距离dr = 1,交通条件信号小窗口的周期性特征wp = 4 (i.e.一个小时),κ = 2 km。对于TextCNN,嵌入词的维数为100,输出的特征向量维数为50。在实验中,我们采用了5-fold交叉验证策略。即交通状况样本按时间顺序分为5个集合,每个集合作为一次测试集 (其他4个集合作为训练集),并报告平均性能。利用亚当优化器训练深度神经网络。我们设定学习率为0.001,batch size为32,training epoch为2000。

评价指标: 我们基于RMSE和MAPE (Mean Absolute Percentage Error)对预测方法的性能进行度量,如式13和式14:

实验部分:

实验一:调参。在本实验中,研究了参数w(用于分割输入的滑动窗口的大小)的影响。如图6所示,当w增大时,RMSE和MAPE都是先减小后增大。一方面,滑动窗口获得的每个片段都由一个单独的GCN处理。因此,如果w太小,GCNs很难捕捉到相邻时段的局部相互作用。另一方面,当w太大时,片段的数量会明显减少,因此RNN很难捕捉片段之间的时间相关性。最后,在接下来的实验中,我们设w = 8。

实验二:组件的影响。我们尝试评估T-MGCN的关键成分,即四个道路图的有效性。我们比较了以下几种T-MGCN变体的性能:T-RGCN:只用拓扑图Gr进行图卷积运算。T-WGCB:只用加权拓扑图Gw进行图卷积运算。T-PGCN:仅用流量模式图Gp进行图卷积运算。T-FGCN:仅用功能图Gf进行图卷积运算。结果如表一所示:T-MGCN优于其他变体,这意味着所有这四个道路图都对最终结果有贡献。其次,除T-MGCN外,T-PGCN的整体性能最好。这表明历史交通格局对未来交通状况具有很强的指示作用。第三,T-FGCN整体表现最差。一个潜在的原因是百度Map API或谷歌Map API收集的POIs被等价地表示为点。实际上,不同规模的POIs对交通状况的影响程度可能不同(例如,大型购物中心对交通状况的影响通常比小型商店的影响更大)。

然后评估了全局特征的有效性,即时间特征、周期性特征和事件特征。我们比较了以下几种T-MGCN变体的性能:T-MGCN-Time:只考虑输出层的时间特征;T-MGCN-Periodicity:只考虑输出层的周期性特征;T-MGCN-Event:只考虑输出层的事件特征;T-MGCN-None:输出层不考虑所有全局特征。实验结果见表二:(1)T-MGCN整体性能最好,T-MGCN- none整体性能最差。验证了全局特征的有效性。(2)T-MGCN-periodic优于T-MGCN-time,性能几乎与T-MGCN相同。结果表明,在所有的全局特征中,周期性特征是最有效的。这一结果与已有的许多研究成果一致,认为城市交通流通常具有较强的周期性。(3)T-MGCN-Event相对于T-MGCN-None只有微不足道的优势。通过对实验数据的分析,我们发现事件(如交通事故)对PEMSD10中未来交通流的影响非常有限。这可能是因为加州的汽车密度相对较低,所以一个事件不太可能造成严重的交通拥堵。

实验三:不同条件下的评估。我们尝试研究T-MGCN在不同条件下(如不同时间跨度,不同道路类型)的性能。我们在七种情况下评估了T-MGCN,预测范围设置为5小时:T-MGCN-rh: T-MGCN在高峰时段(7:00-9:00和16:30-18:30)的性能;T-MGCN-np: T-MGCN在非高峰时段的性能;T-MGCN-wd: T-MGCN在工作日的表现;T-MGCN-hd:指T-MGCN在节假日的表现;T-MGCN-er: T-MGCN在城市高速公路上的性能;T-MGCN-ar: T-MGCN在主干道上的性能;T-MGCN- sr: T-MGCN在景区道路上的性能。实验结果如图7所示。注意,PEMSD10只涉及高速公路,所以T-MGCN-ER、TMGCN-AR、T-MGCN-SR仅在HZJTD上进行评估。可以看出,两个数据集上的实验结果是一致的。在正常情况下(如非高峰时段、工作日、城市高速公路和主干道)性能更好。这是因为交通流模式在异常情况下(如高峰时段、节假日、景区道路)更不稳定。

实验四:与基准模型的比较:结果表明,与CNNs相比,图能更好地模拟路网的空间关联和语义关联。所有方法在PEMSD10上的性能都优于在HZJTD上的性能。原因可能是PEMSD10采集自高速公路,HZJTD采集自各类城市道路(城市高速公路、干线公路、风景名胜区道路)。因此,由于各种各样的城市事件(如交通拥堵、红绿灯等)的影响,华中交大区的交通状况格局将变得更加复杂。最后,T-MGCN在两个数据集中都有最好的性能,与最佳基准模型相比,它减少了约3%到6%的预测误差。所以,在T-MGCN中,将各种关联(即空间、时间和语义关联)和全局特征(即时间、周期性和事件特征)结合在一起可以获得更好的性能。

实验五:案例研究。在本节中,我们通过案例研究直观地展示了T-MGCN的性能。选取HZJTD数据集中相邻的三条道路,用几种方法绘制交通流预测结果,对未来5小时的交通流量进行预测,如图8所示。可以看出,T-MGCN比其他三种方法更准确地捕捉到了交通速度的时间趋势,与输出平滑预测曲线的FNN和CLTFP相比,T-MGCN和T-GCN能够很好地适应交通速度的急剧变化。此外,T-MGCN的预测曲线总体上能较好地与地面真值曲线对齐。结果表明,T-MGCN能够更好地捕捉道路网络的空间相关性和语义相关性,从而做出更准确的预测。

6.展望

今后,我们将从以下几个方面展开工作。首先,大多数交通流预测模型倾向于学习一般的交通模式。然而交通状况可能会在几个小时内发生剧烈变化,这通常是由异常事件(如交通事故、音乐会等)造成的,我们将扩展我们的方法来学习异常事件和交通状况之间的相关性,以及扩展到多步连续交通流预测中。

Attention

如果你和我一样是轨道交通、道路交通、城市规划相关领域的,可以加微信:Dr_JinleiZhang,备注“进群”,加入交通大数据交流群!希望我们共同进步!

385

385

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?